在用Python做图像识别的时候,需要借助TensorFlow库,但Numpy库和TensorFlow库版本不兼容就会出现问题。同时Numpy库得适应Python版本。_tensorflow和numpy不兼容...

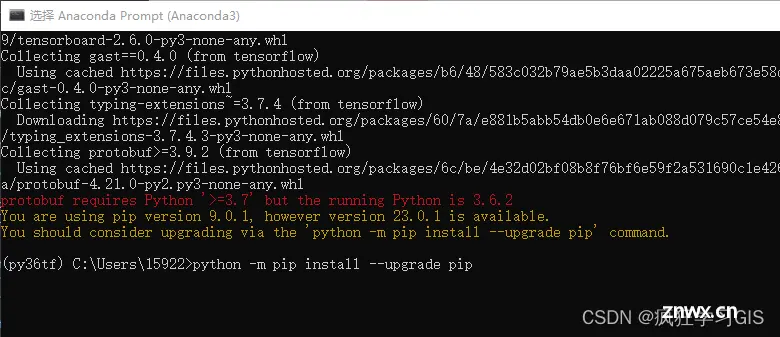

本文介绍在Anaconda环境中,下载并配置Python中机器学习、深度学习常用的新版tensorflow库的方法~...

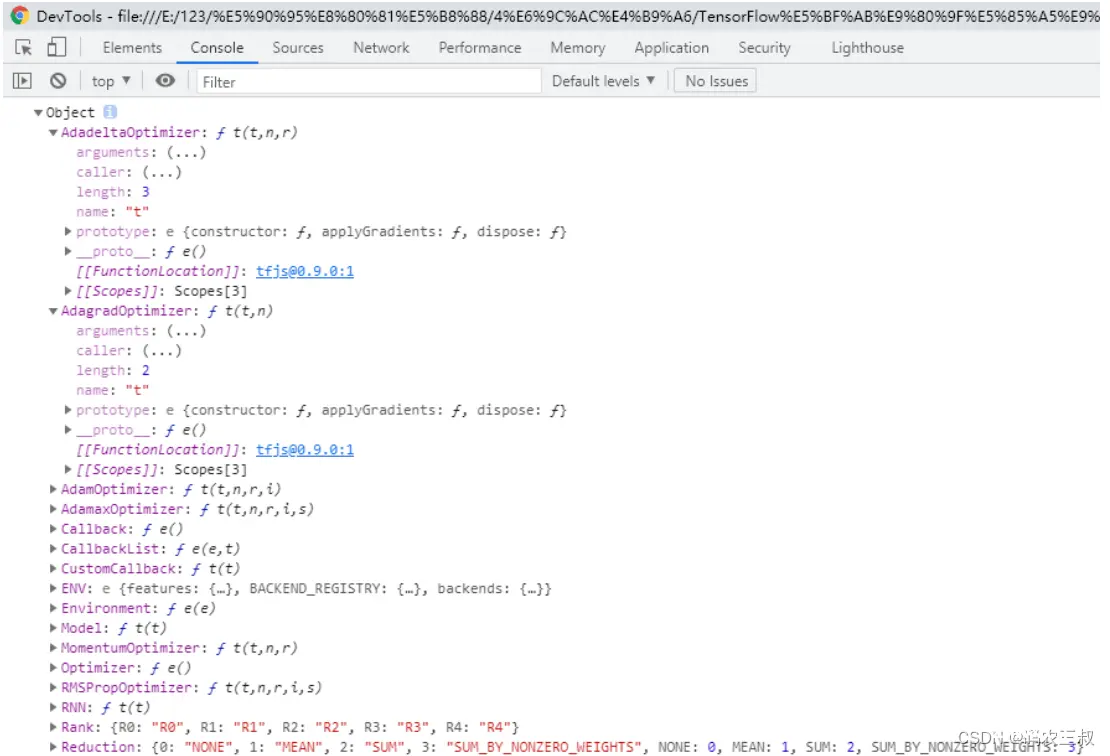

TensorFlow.js是一个开源的基于硬件加速的JavaScript库,用于训练和部署机器学习模型。_tensorflow.js...

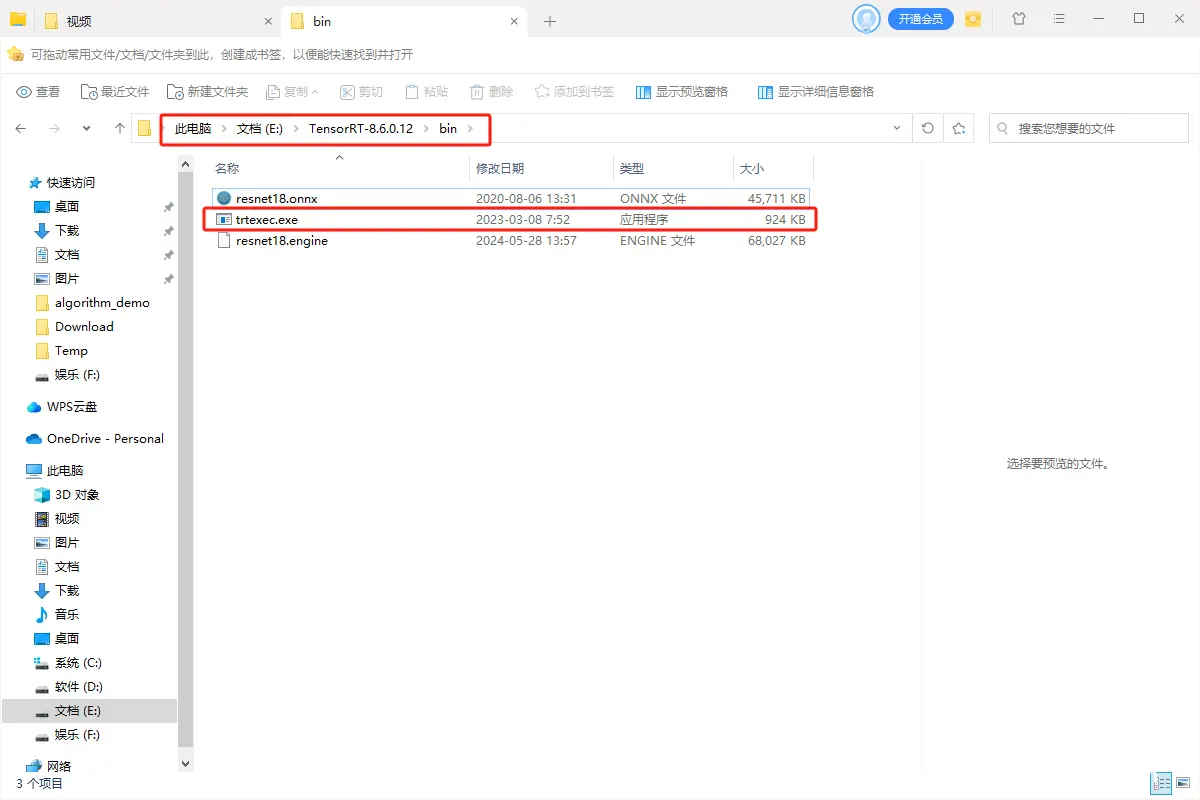

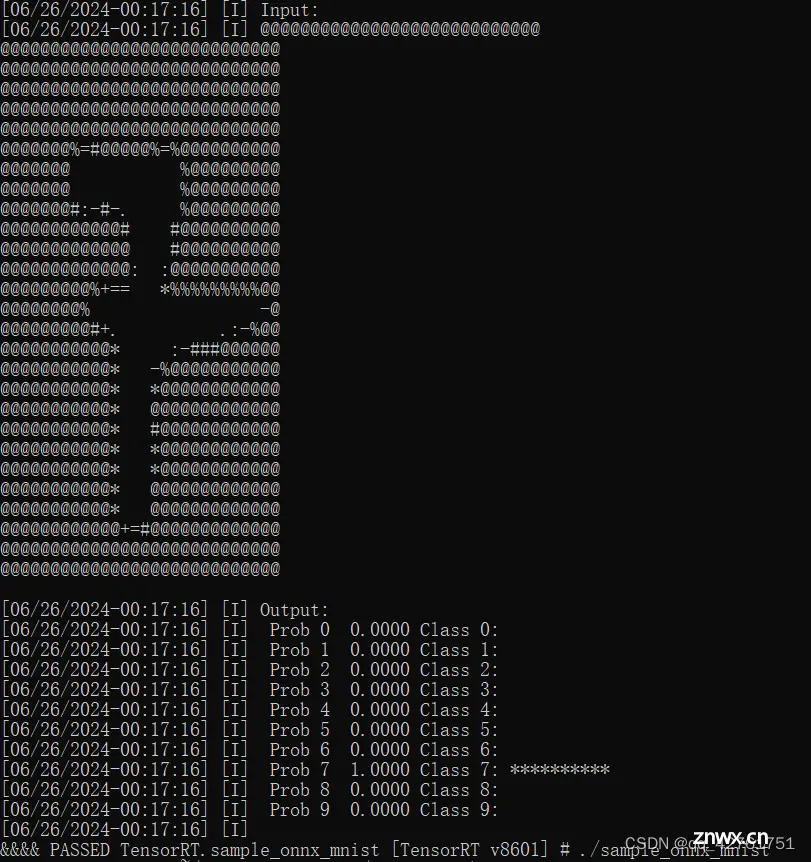

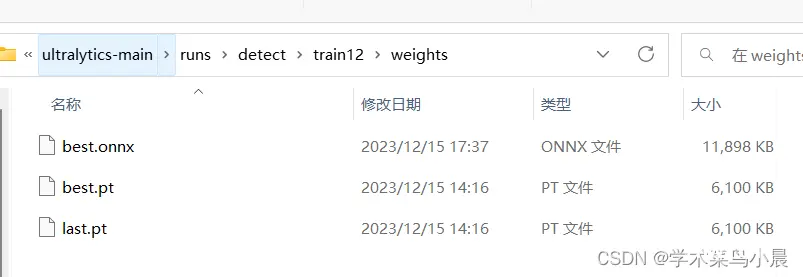

经典的一个TensorRT部署模型步骤为:onnx模型转engine、读取本地模型、创建推理引擎、创建推理上下文、创建GPU显存缓冲区、配置输入数据、模型推理以及处理推理结果(后处理)。_tensorrtc++...

是一个常用选项,用于自动确认所有提示。这意味着在运行命令时,不会提示用户进行确认操作,系统会自动回答“是”并继续执行。中科大:https://pypi.mirrors.ustc.edu.cn/simple/...

基于TensorFlow.js和COCO-SsD模型的实时目标检测网络应用程序_coco-ssd模型...

本文详细介绍了TensorFlow,一个强大的开源机器学习库。通过构建一个简单的神经网络示例,我们展示了TensorFlow的基本使用方法。此外,我们探讨了TensorFlow的主要模块、高级功能和未来展望。Te...

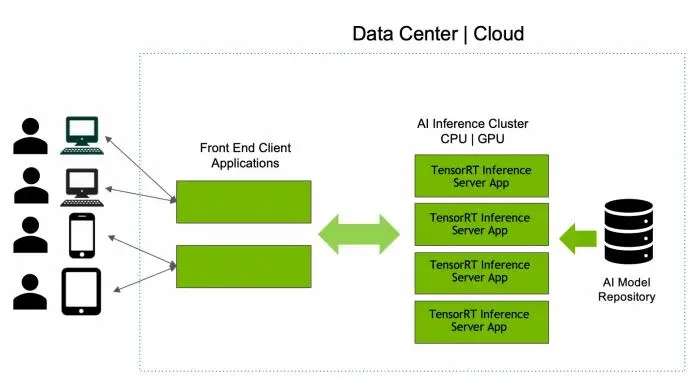

模型库中的每个模型都必须包含⼀个模型配置,该配置提供有关模型的必需和可选信息。)配置,使⽤当前最新的NVIDIA官⽅提供的镜像tritonserver:23.12-trtllm-python-py3,此版本镜像部...

在进行深度学习时,程序报错tensorflow.python.framework.errors_impl.FailedPreconditionError:XXXisnotadirectory。XXX是文件...

TensorRT是一种,可以为深度学习应用提供的部署推理。TensorRT可用于对超大规模数据中心、嵌入式平台或自动驾驶平台进行推理加速。TensorRT现已能支持TensorFlow、Caffe、Mxnet、Py...