2024-08-01 14:05:02

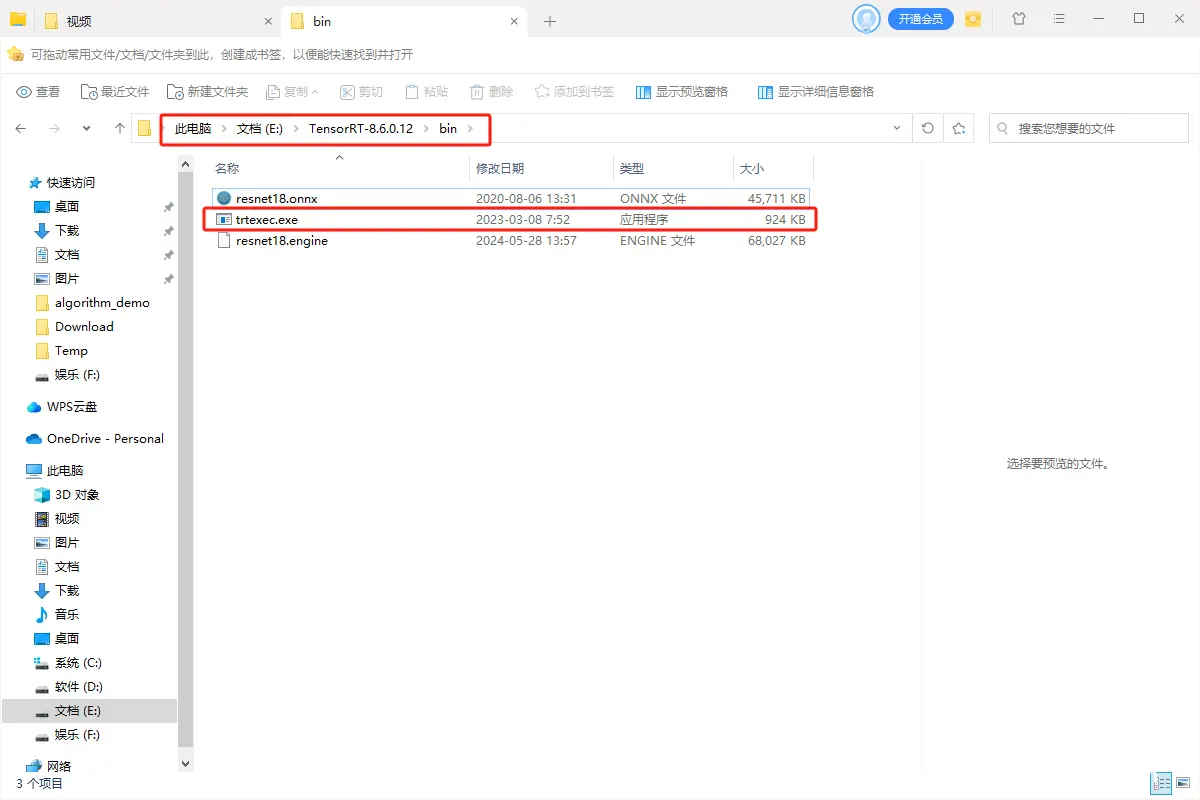

经典的一个TensorRT部署模型步骤为:onnx模型转engine、读取本地模型、创建推理引擎、创建推理上下文、创建GPU显存缓冲区、配置输入数据、模型推理以及处理推理结果(后处理)。_tensorrtc++...

浏览 96 次 标签: TensorRT部署模型基本步骤(C++)

阅读排行

- 温书仪段淮川全文阅读 可爱小桃罐小说全本无弹窗

- 小说李寒松温雪曼在线阅读 局部宇宙小说精彩章节在线阅读

- 【抖音】《罗俏俏卫衡》佚名免费试读 新书《罗俏俏卫衡》小说全集阅读

- 【抖音】《陈源李明猫》猫鱼书免费试读 (猫鱼书)小说全集免费在线阅读

- 季思言乔心茹(乔心茹季思言)全文免费阅读无弹窗大结局_(季思言乔心茹)乔心茹季思言最新章节列表_笔趣阁

- 安安的出院倒计时写的小说《林乔傅嘉年傅礼安安》佚名全文阅读 佚名小说精彩章节在线阅读

- 霍衍白薇薇连清全本章节阅读 霍衍白薇薇连清小说全文在线阅读

- (番外)+(全文)季思言乔心茹:结局+番外+完结小说免费阅读下载阅读_(乔心茹季思言)季思言乔心茹:结局+番外+完结小说免费阅读最新章节列表_笔趣阁(乔心茹季思言)

- 往昔爱意成灰小说(裴司誉简云初)全文免费阅读无弹窗大结局_往昔爱意成灰全文免费完结版阅读(裴司誉简云初)

热门文章

名师推荐

- (精品)谢清梨江应森小说 2 土豆猫小说精彩章节在线阅读

- 我的心在他胸腔跳动:结局+番外(江宴修夏南絮:结局+番外小说)全文免费阅读无弹窗大结局_ 我的心在他胸腔跳动:结局+番外全文免费阅读小说江宴修夏南絮:结局+番外全文免费阅读最新章节列表_笔趣阁(我的心在他胸腔跳动:结局+番外小说)

- 兮宁 第4章 新书《陈南星陈南汐》小说全集阅读

- 罗俏俏卫衡by罗俏俏卫衡竹马第五章 小说全集免费在线阅读(佚名)

- 一拳一个小红帽 第一章 孟凡臣叶倾城小说全文免费阅读

- 闪婚后,祁先生他天天被钓成翘嘴写的小说《宁染祁薄寒》甜甜疯了全文阅读 甜甜疯了小说精彩章节在线阅读

- 完结文乔心茹季思言季思言乔心茹最新章节列表_完结文乔心茹季思言全文免费阅读(季思言乔心茹)

- 此恨绵绵无绝期(钟婉清时亦寒)全文免费阅读无弹窗大结局_(钟婉清时亦寒)此恨绵绵无绝期最新章节列表_笔趣阁

- 【抖音】热书孟凡臣叶倾城全本章节阅读 孟凡臣叶倾城小说全文免费阅读