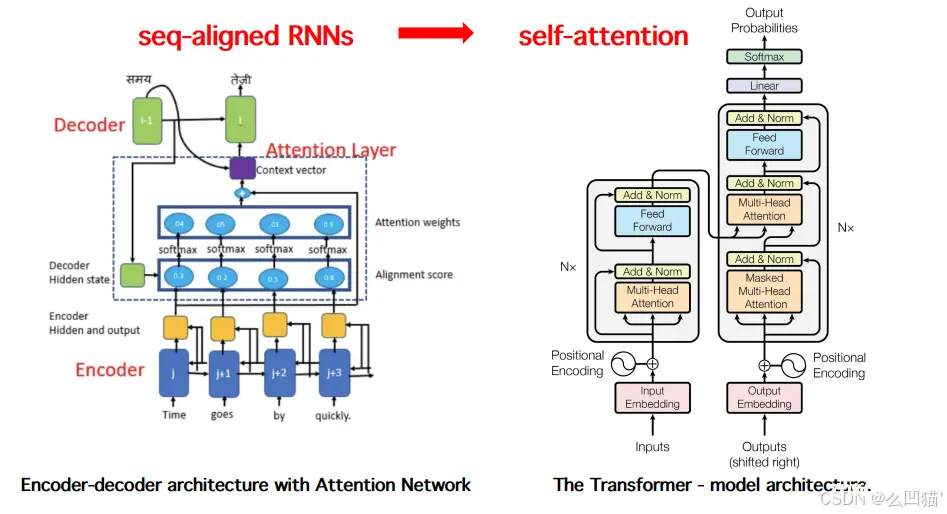

在AI技术的迅猛发展中,注意力机制成为了关键驱动力,赋予机器高效处理复杂信息的能力。本文深入探索注意力机制及其核心应用——Transformer架构,解析其如何通过自注意力机制革新自然语言处理。同时,对比分析GP...

BiFormer(Bi-levelRoutingAttention)是一种新颖的注意力机制,它通过双层路由机制来捕捉局部和全局特征,从而提高模型的检测性能。其主要思想是在特征提取过程中,分别对局部特征和全局特征...

YOLOv8的网络结构大致分为四个部分:Backbone、Neck、Head和输出层。Backbone用于提取图像特征,Neck用于特征融合和增强,Head用于目标分类和定位。...

DAttention(DAT)是一种最新的注意力机制,它通过引入动态自适应的注意力权重计算,能够更好地捕捉特征之间的关系,从而提升模型的表示能力。DAT在各种视觉任务中表现出色,尤其是在目标检测中,可以显著提高小目标...

本系列主要介绍计算机视觉领域的注意力机制方法,分为注意力机制概述、通道注意力,空间注意力,混合域注意力和时域注意力、注意力机制总结等不同分类展开介绍,后续系列会对上述各种注意力机制方法进行重点讲解,重点论文会...

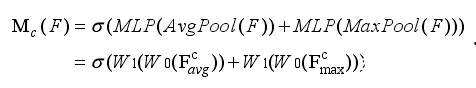

本文介绍注意力机制的概念和基本原理,并站在计算机视觉CV角度,进一步介绍通道注意力、空间注意力、混合注意力、自注意力等。_通道注意力...

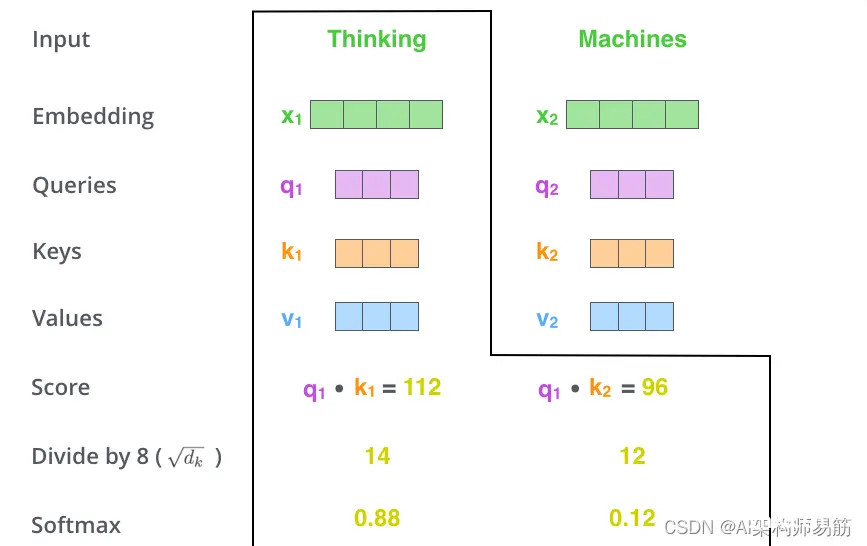

自注意力机制_自注意力机制...

它们是用于计算和思考注意力的抽象概念。一旦你继续阅读下面的注意力是如何计算的,你就会知道几乎所有你需要知道的关于每个向量所扮演的角色。计算self-attention的第二步是计算一个分数。假设我们正在计算本...

到此本文的正式分享内容就结束了,在这里给大家推荐我的YOLOv8改进有效涨点专栏,本专栏目前为新开的平均质量分98分,后期我会根据各种最新的前沿顶会进行论文复现,也会对一些老的改进机制进行补充,如果大家觉得本文帮...

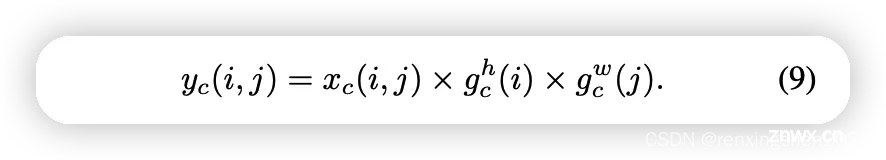

CA(Coordinateattentionforefficientmobilenetworkdesign)发表在CVPR2021,帮助轻量级网络涨点、即插即用。CA不仅考虑到空间和通道之间的关系,...