DeformableAttention(可变形注意力)首先在2020年10月初商汤研究院的《DeformableDETR:DeformableTransformersforEnd-to-EndOb...

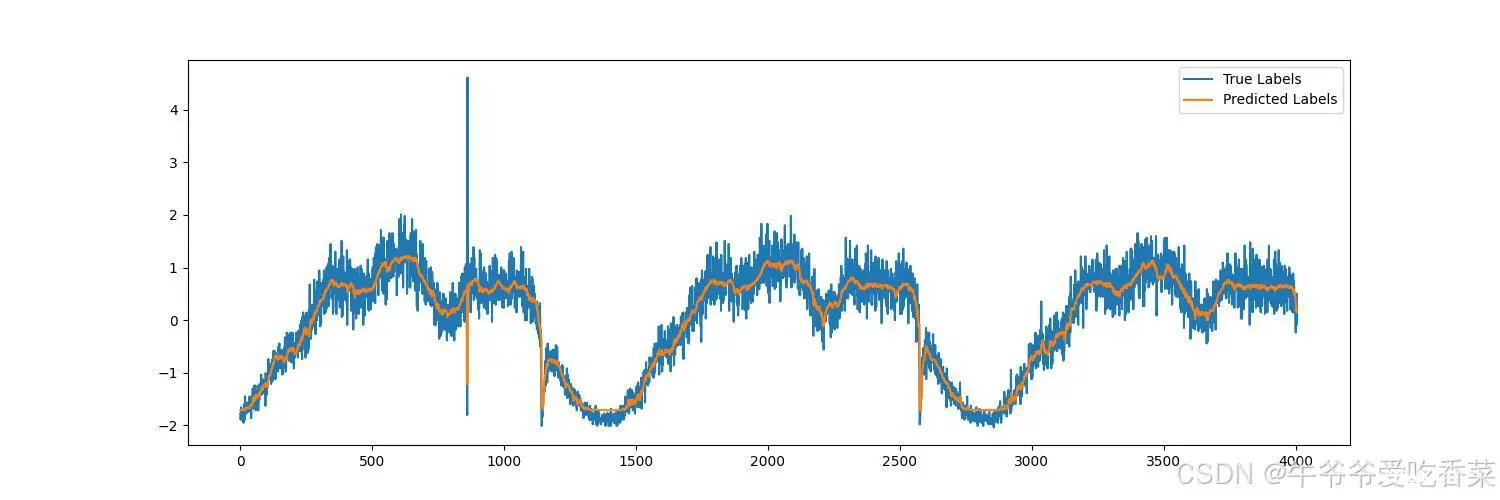

自此,不管是学术界,还是工业界均掀起了基于Transformer的预训练模型研究和应用的热潮,并且逐渐从NLP领域延伸到CV、语音等多项领域。Transformer模型是一个具有里程碑意义的模型,它的提出催生了众...

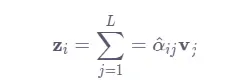

本文讲述了注意力机制在出租车客流预测方面的作用,详细介绍了模型代码结构以及模型的调参过程,可以很好的理解模型结构。_cnn+lstm实例...

LSKAttention是一种基于大核卷积的注意力机制,通过引入不同尺寸的卷积核来捕获图像中的多尺度特征信息。多尺度信息捕捉:通过大核卷积的感受野,能够有效捕捉目标物体的多尺度特征信息。增强全局特征:相比于小卷积核,大卷积核能够更好地捕...

在AI技术的迅猛发展中,注意力机制成为了关键驱动力,赋予机器高效处理复杂信息的能力。本文深入探索注意力机制及其核心应用——Transformer架构,解析其如何通过自注意力机制革新自然语言处理。同时,对比分析GP...

通过将RCS-OSA(减少通道的空间对象注意力机制)引入到YOLOv8中,并替换原有的C2f模块,我们显著提升了模型在多项指标上的性能,尤其是在小物体检测和复杂场景中的表现。实验结果显示,改进后的模型在COCO和PASC...

本文详细介绍了如何通过引入RFAConv改进YOLOv8的检测性能。通过在C2f模块中集成RFAConv,模型不仅在复杂场景下表现出色,还在小目标检测任务中有显著提升。RFAConv的引入为未来的目标检测研究提供了新的思路,未来的工作可以探...

BiFormer(Bi-levelRoutingAttention)是一种新颖的注意力机制,它通过双层路由机制来捕捉局部和全局特征,从而提高模型的检测性能。其主要思想是在特征提取过程中,分别对局部特征和全局特征...

YOLOv8的网络结构大致分为四个部分:Backbone、Neck、Head和输出层。Backbone用于提取图像特征,Neck用于特征融合和增强,Head用于目标分类和定位。...

DAttention(DAT)是一种最新的注意力机制,它通过引入动态自适应的注意力权重计算,能够更好地捕捉特征之间的关系,从而提升模型的表示能力。DAT在各种视觉任务中表现出色,尤其是在目标检测中,可以显著提高小目标...