事件包含的信息量大小(事件发生的难度有多大)。小概率事件,它发生的难度比较大,所以有较大的信息量大概率事件,它发生的难度比较小,所以有较小的信息量概率和信息量是负相关的。_yolov8的正负匹配...

准备在在Windows下运行的朋友我是劝退的,因为ChatTTS里用的pynini中的一个组件直接称它在Windows下没有测试过,还是建议用Ubuntu,我用的是Windows下的WSL,非常非常好用。百度网盘链...

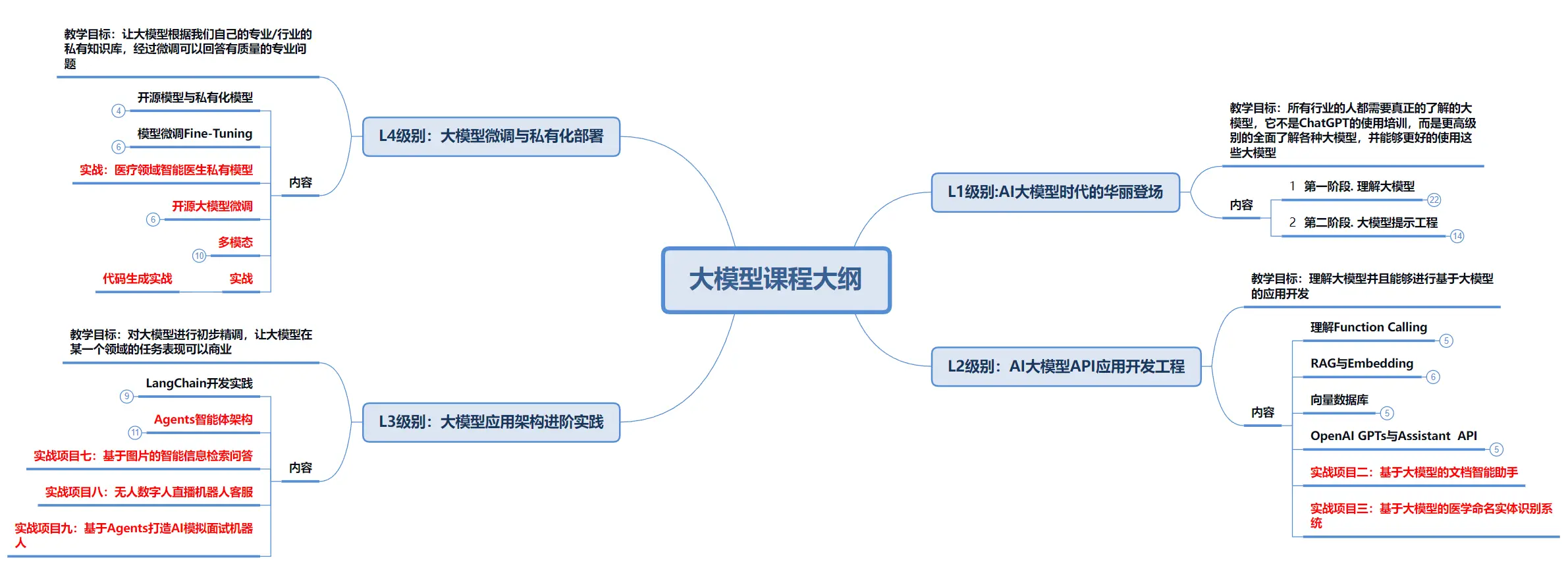

通用人工智能是人类历史上第一次关于智能本身的革命,是一种元革命,是历次某个技术革命难以比拟的。大模型的诞生宣告了整个人工智能进入全新的重工业时代。反观国内大模型产业,从表象上看是热闹非凡、模型林立,但是剥开外壳,从...

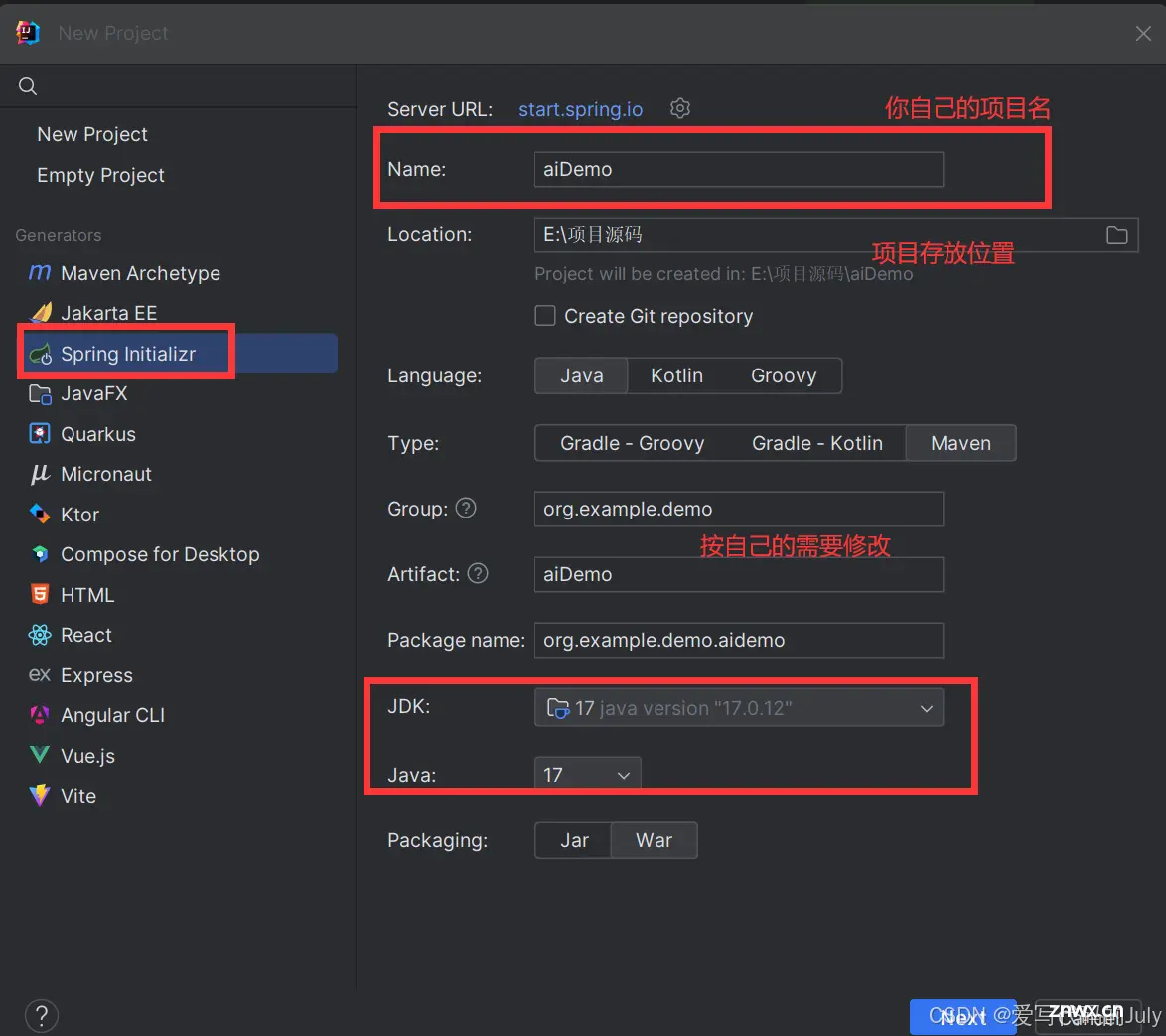

随着chatGPT的兴起,越来越多的应用接入了AI大模型,那么我们要怎么在自己的项目中接入AI大模型呢?本节我们就做一个简单的demo来尝试一下。_springboot接入ai...

MiniCPM-V模型是一个强大的端侧多模态大语言模型,专为高效的终端部署而设计。目前该模型有MiniCPM-V1.0、MiniCPM-V2.0和MiniCPM-Llama3-V2.5版本。_minicpm-...

2022年下半年,国内安全圈内开始完chatGPT,当时在安全圈内小火了一把。大家纷纷注册去体验一把,希望chatGPT能帮助解决日常安服渗透问题。当时以为仅此而已,谁知年后大火,随后以chatGPT为代表的大语言模...

收集了各路知识点,总结而出的两万字OSI七层网络模型详解!_七层网络模型...

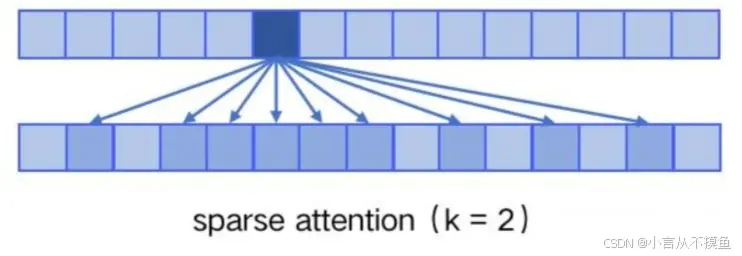

2020年5月,OpenAI发布了GPT-3,同时发表了论文“LanguageModelsareFew-ShotLearner”《小样本学习者的语言模型》.通过论文题目可以看出:GPT-3不再去追求...

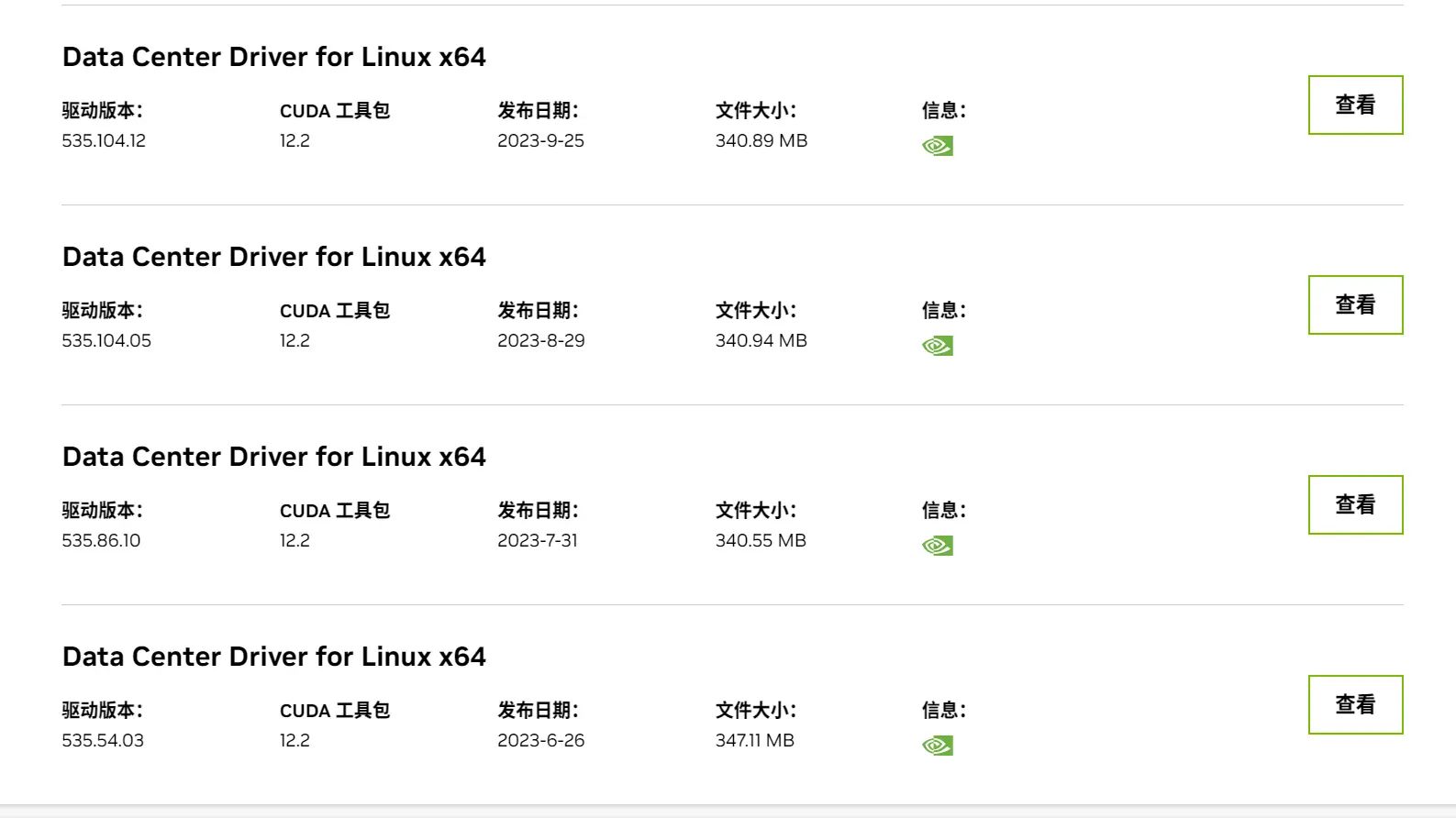

已经是2024年了,但貌似AI大模型的热度依旧未减,各种如ChatGPT般的生成式的AI大模型层出不穷,由此而来的还有各种网站、小程序都可以支持AI大模型对话,那么你有没有想过能拥有一个自己的AI大模型?今天我就...

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。_大模型和小模型的区别...