医疗大模型是近年来随着人工智能技术的发展而兴起的一种新型工具,它们利用大数据和先进的机器学习算法来改善医疗服务和医疗决策。下面将介绍几种代表性的医疗大模型,并探讨其未来的发展趋势。医疗大模型概述医疗大模型通常指的是...

HuggingFace的库支持自动模型(AutoModel)的模型实例化方法,来自动载入并使用GPT、ChatGLM等模型。在方法中的device_map参数,可实现单机多卡推理。_transformer多卡推理...

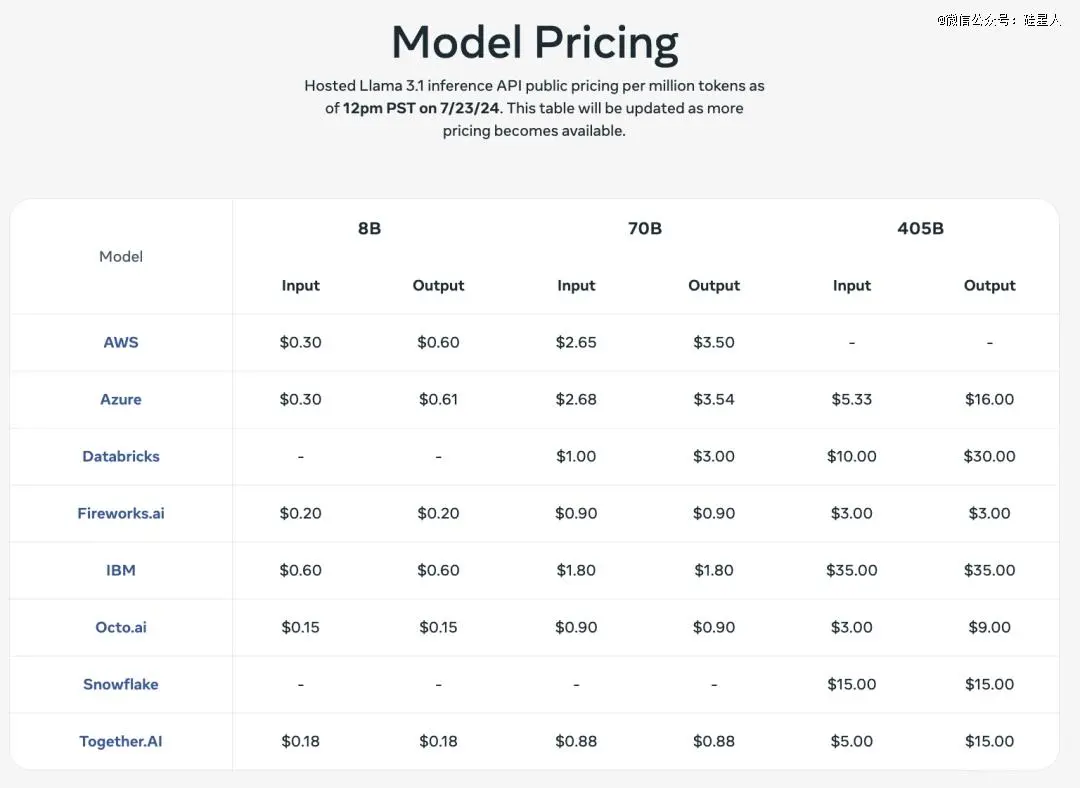

相信大家翘首企盼的都是同一个主角,Meta藏到现在的王牌、最被社区看好能直接叫板GPT-4o的新一代开源大模型—Llama3.1系列,终于正式发布了。鉴于4月公开的两个Llama3小参数模型8B和70B表现不俗...

国内外大模型汇总:OpenAI大模型、Google大模型、Microsoft大模型、文心一言大模型、通义千问大模型、字节豆包大模型、智普清言大模型_大模型具备哪些能力...

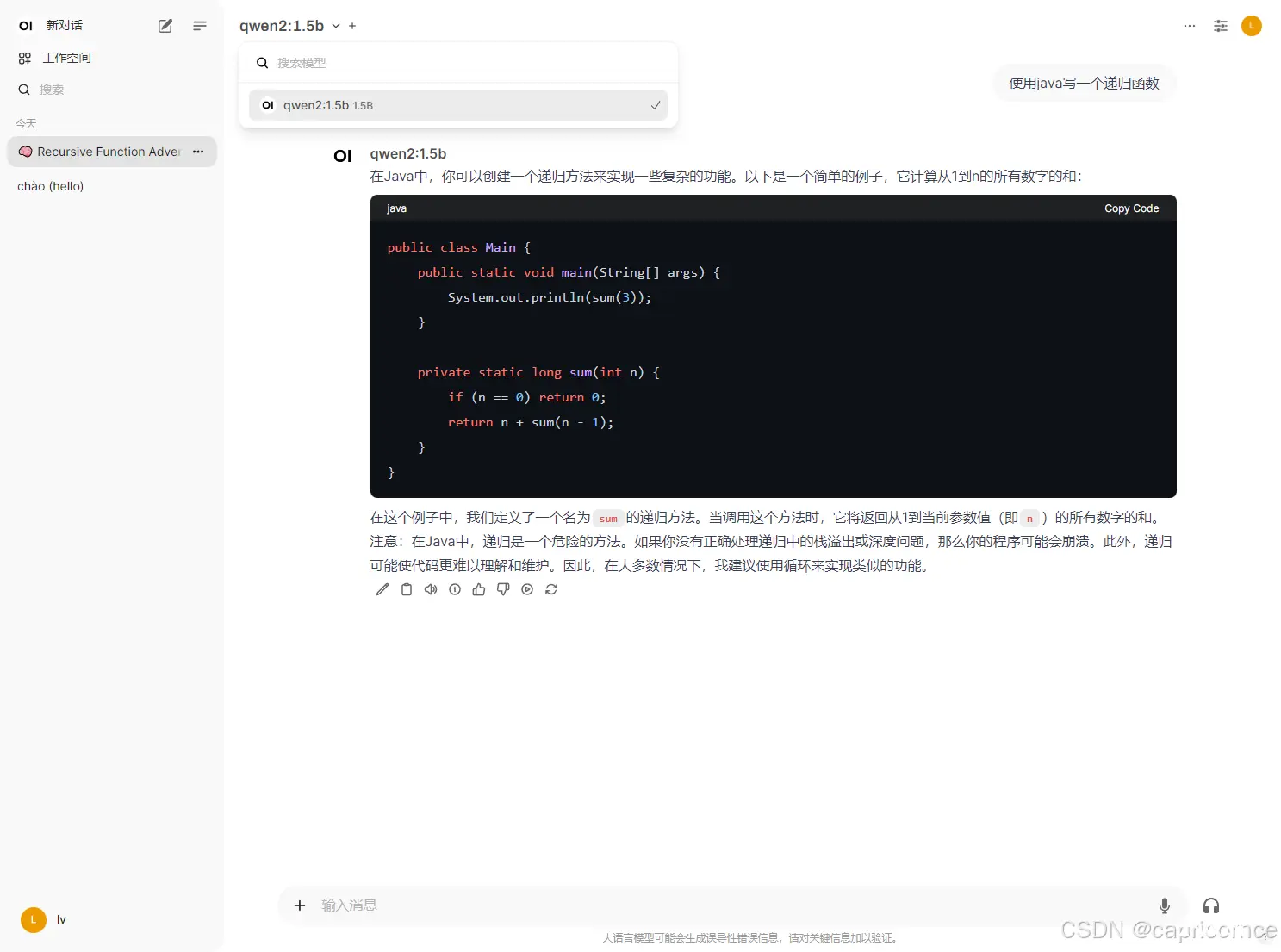

使用Ollama+OpenWebUI本地部署阿里通义千问Qwen2AI大模型_openwebui阿里云镜像...

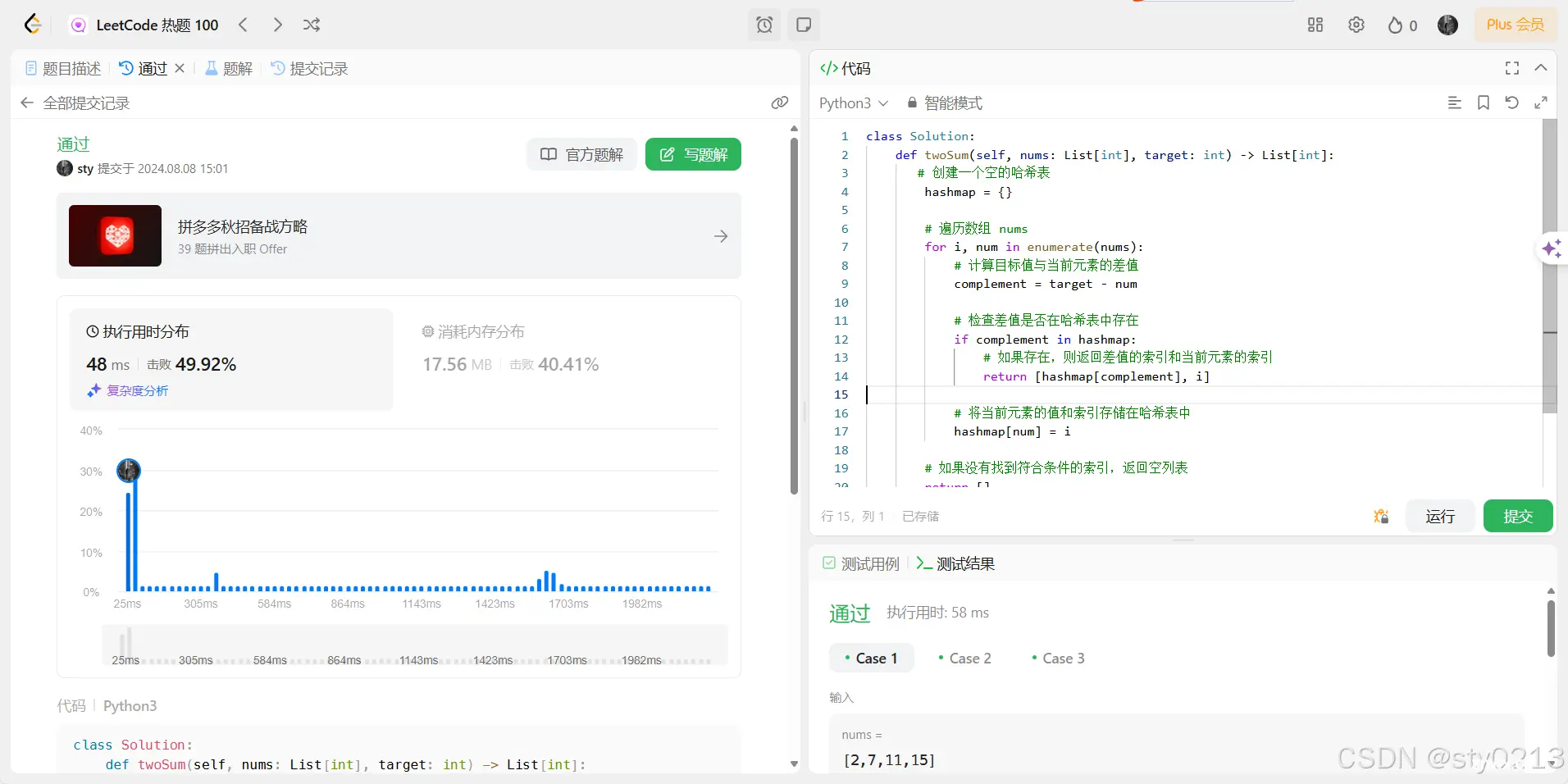

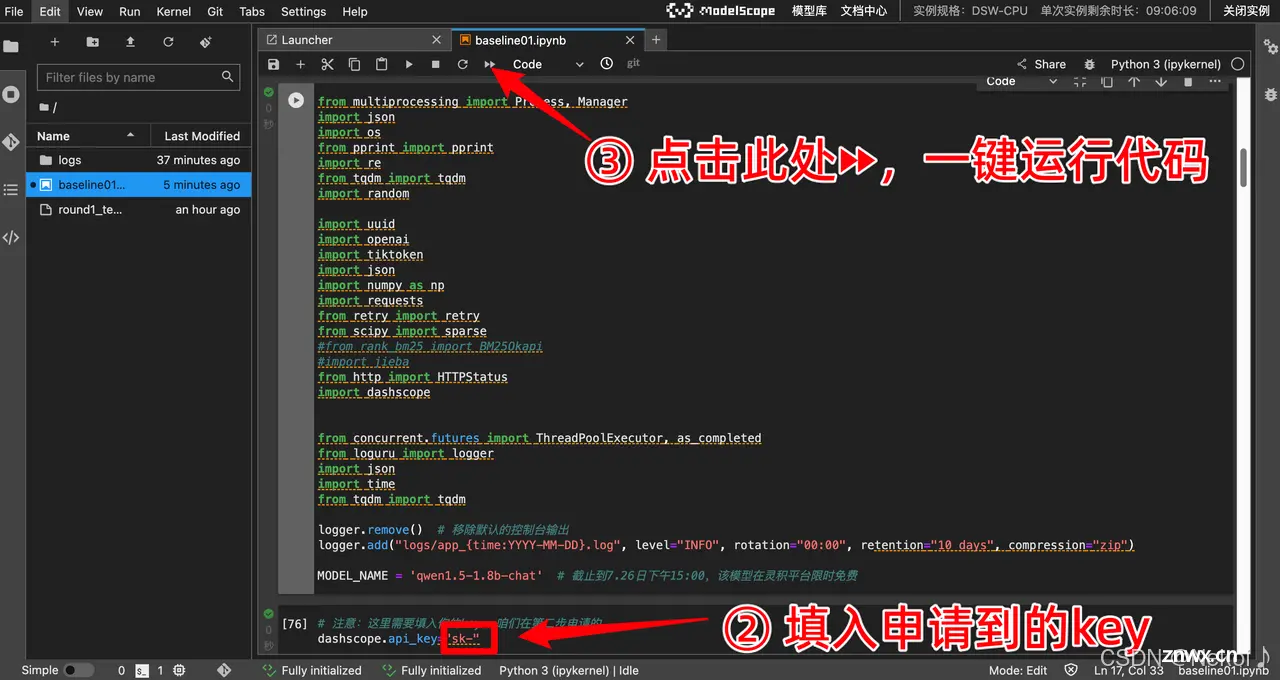

速览:这边笔记将会带大家快速跑一遍baseline,再带大家精读一下baseline。...

介绍如何通过Ollama+Docker在本地部署大模型_ollamadocker...

AI+逻辑推理比赛是由上海科学智能研究院、复旦大学联合阿里云在上智院·天池平台发布“第二届世界科学智能大赛”的逻辑推理赛道:复杂推理能力评估,该比赛聚焦于通过解决复杂的逻辑推理题,测试大型语言模型的逻辑推理能力。选手...

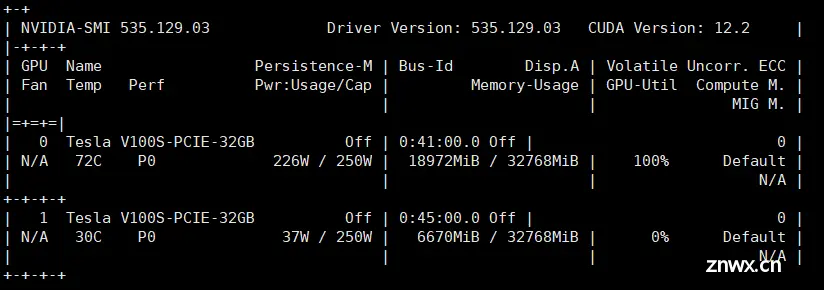

如果你使用商用大模型,或者使用开源大模型本地化部署,除了生成的质量之外,另外一个关键的指标就是生成token的速度。而且并不是简单的每秒生成多少个token,而是拆成了两个阶段:1.prefill:预填充,...

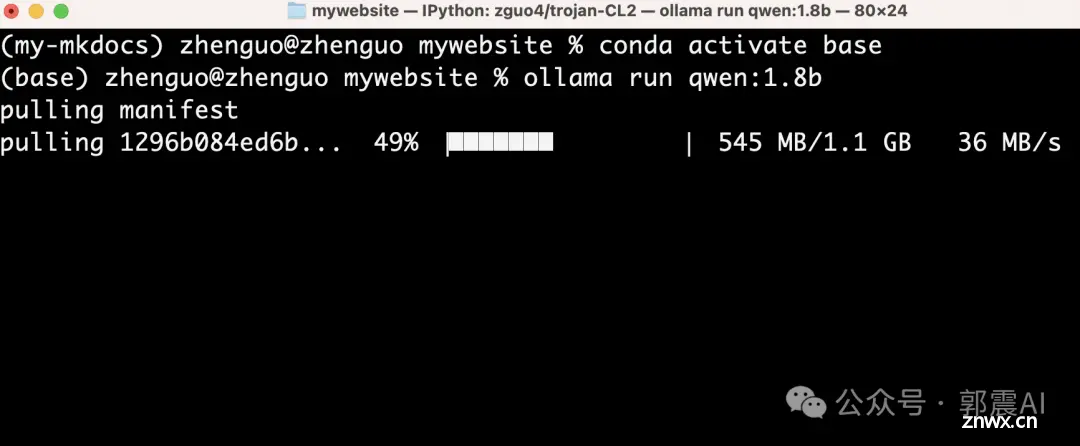

你好,我是郭震这篇教程主要解决:1).有些读者朋友,电脑配置不高,比如电脑没有配置GPU显卡,还想在本地使用AI;2).Llama3回答中文问题欠佳,想安装一个回答中文问题更强的AI大模型。3).想成为AI开...