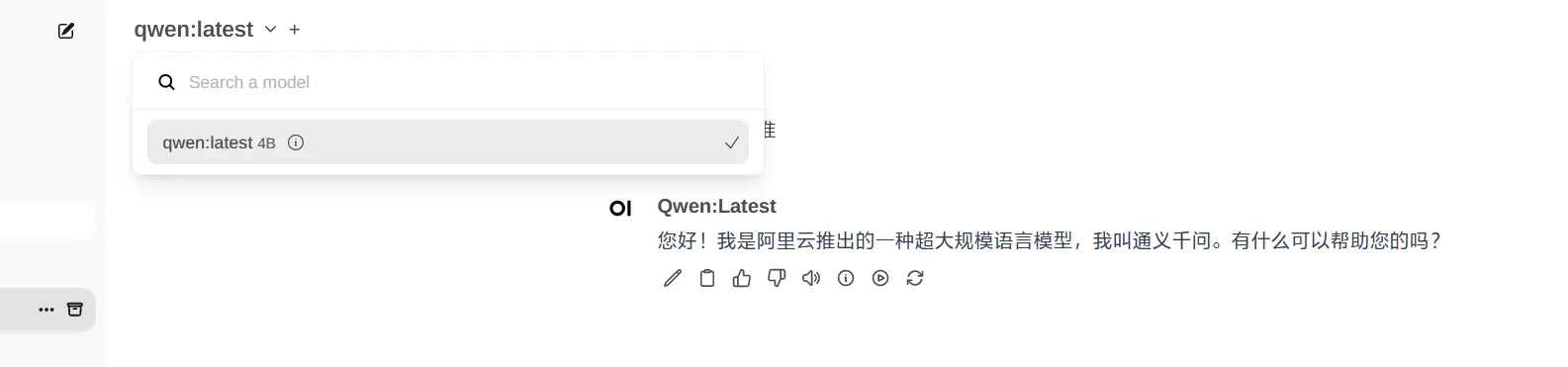

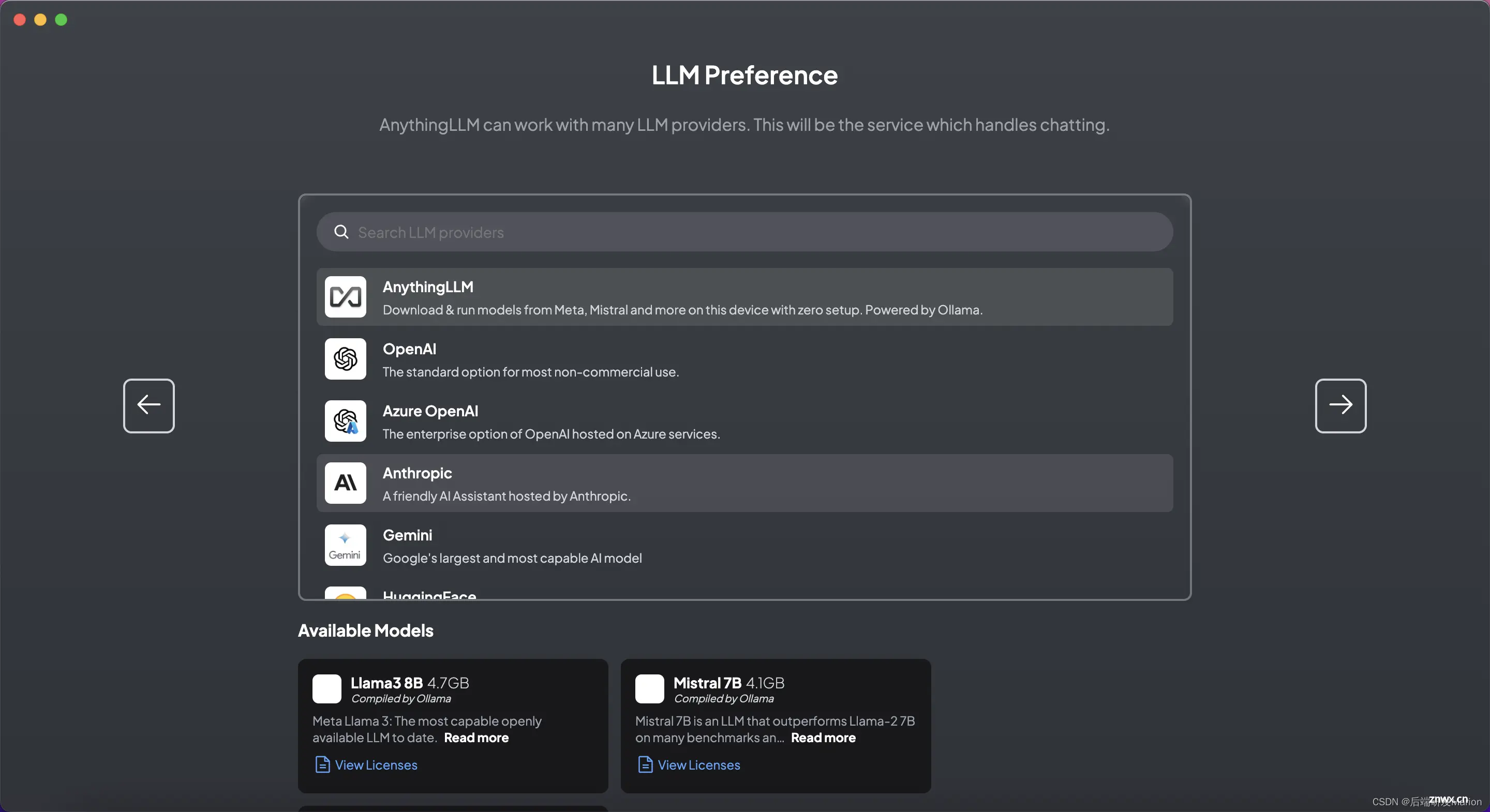

本文介绍了LLM在落地应用中的不足,并引入了RAG框架和原理,以及RAG在私有知识库建设中的重要作用。并以Ollama和AnythingLLM为实现手段,构建了并测试了本地知识库,测试结果表明,有了RAG的加持,...

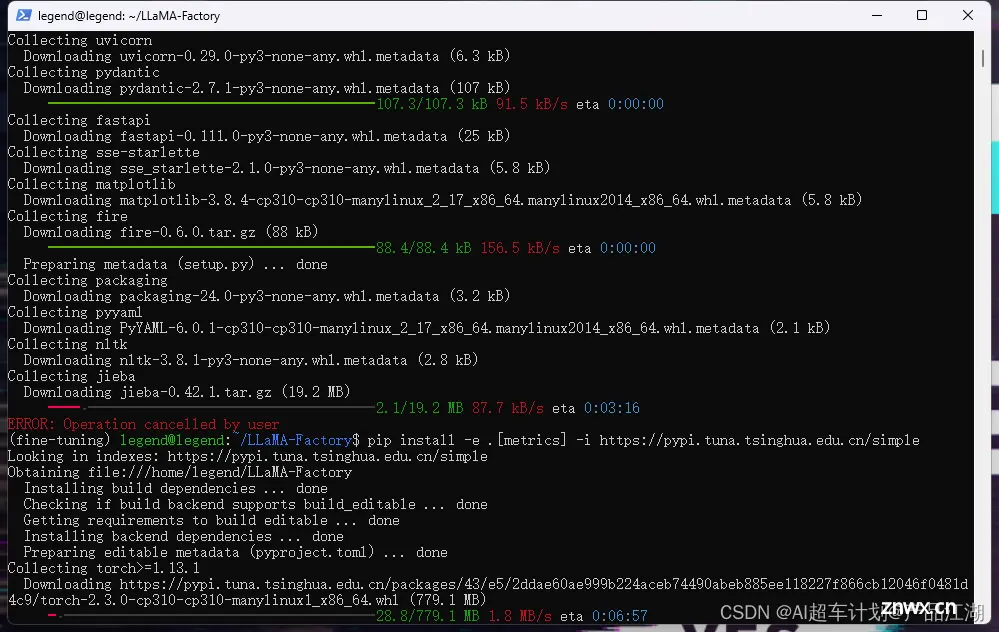

一开始排查是以为transformers的版本不对,先确定了transformers的版本,transformers的版本应该大于4.35.0。把transformers升级为4.35.0后仍然报错。最后发现是c...

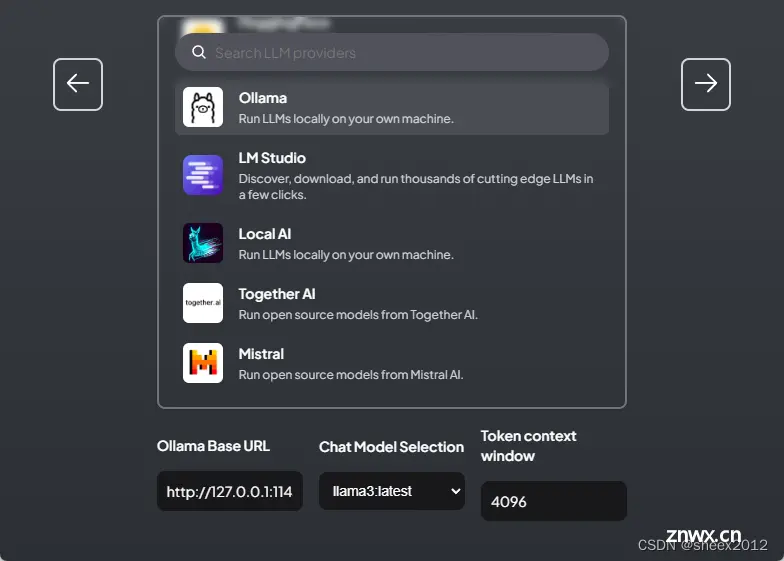

现在开源大模型一个接一个的,而且各个都说自己的性能非常厉害,但是对于我们这些使用者,用起来就比较尴尬了。因为一个模型一个调用的方式,先得下载模型,下完模型,写加载代码,麻烦得很。对于程序的规范来说,只要东西一多,...

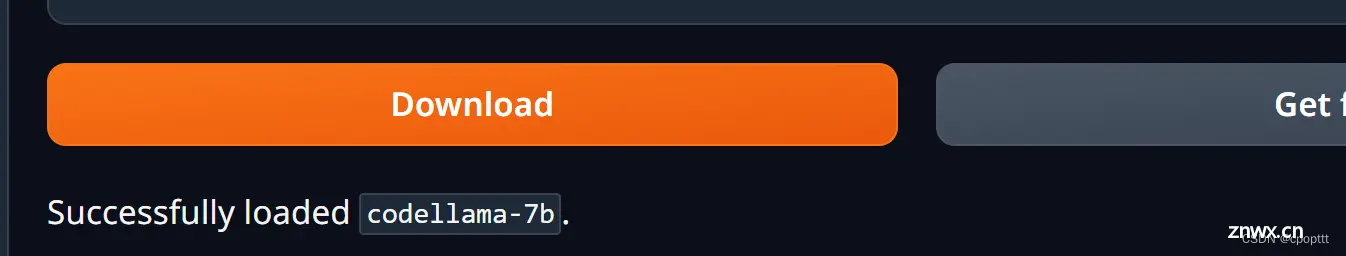

Ollama支持在Modelfile中导入GGUF模型:创建一个名为Modelfile的文件,使用带有要导入的模型的本地文件路径的“FROM”指令。在Ollama里创建模型运行模型从Ollama库下载的大模型...

【ollama】linux、window系统更改模型存放位置,全网首发2024!_ollama设置模型位置...

内存:32G硬盘:512GSSD显卡:NVIDIAGeForceGTX10606GB内网IP:192.168.1.21。_ubuntu安装ollama...

LLaMA-Factory是github上的一个开源项目,可以通过web界面,可视化地轻松微调大模型。支持微调上几百大模型:LLaMA、LLaVA、Mistral、Mixtral-MoE、Qwen、Yi、Gemm...

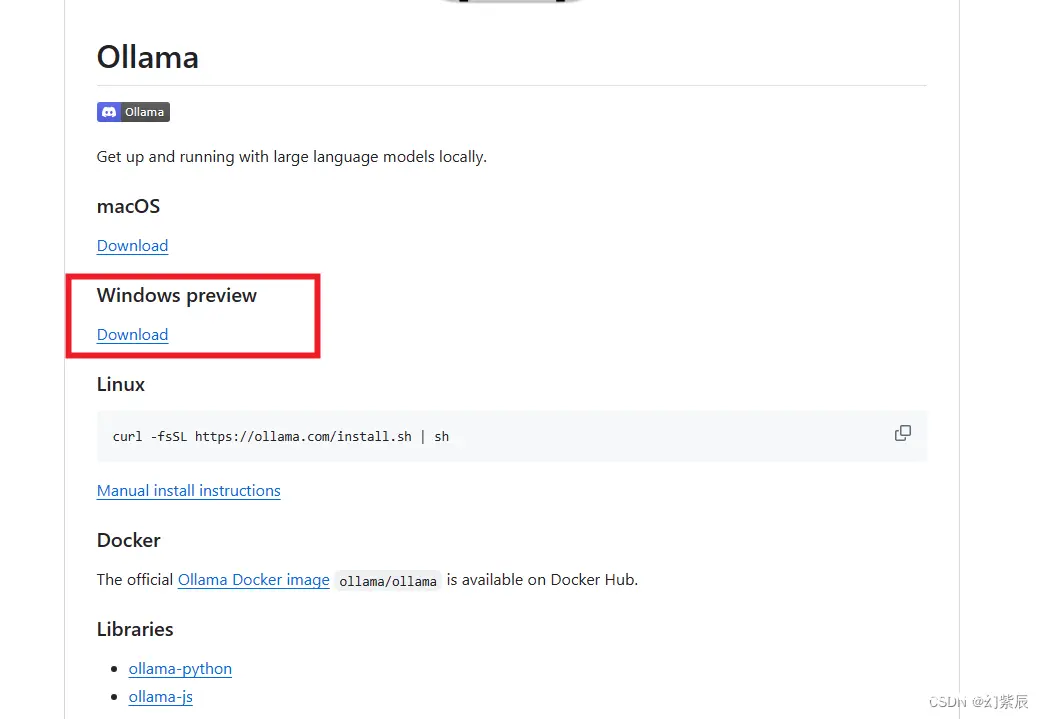

安装完成后可以在cmd命令提示符窗口中输入ollama-v查看是否安装好。输入ollamarunllama3可以直接下载llama3大模型并运行进行对话,默认是llama3:latest版本,8b的一个版本...

如果需要,可以使用AnythingLLM的开发者API进行自定义集成,以满足特定的业务需求。_open-webui自定义知识库...

本文介绍了大规模语言模型的相关概念,并介绍了使用开源工具Ollama部署LLaMa3大模型、使用OpenWebUI搭建前端Web交互界面的方法和流程。_linux安装ollama+openui...