007-Wsl-Ubuntu上LLaMA-Factory如何下载、部署、运行【AI超车B计划】

AI超车计划@产品江湖 2024-06-13 09:01:25 阅读 72

一、目标

了解什么是LLaMA-Factory;

成功在Wsl-Ubuntu环境下安装并运行LLaMA-Factory;

二、路径

学习笔记中关于LLaMA-Factory的简介,了解什么是LLaMA-Factory;

在Ubuntu中,下载LLaMA-Factory;

使用Conda 创建一个LLaMA-Factory专属的Python虚拟环境,并激活;

在Python虚拟环境中,部署LLaMA-Factory并运行;

三、笔记

1、什么是LLaMA-Factory?有什么作用?

LLaMA-Factory是github上的一个开源项目,可以通过web界面,可视化地轻松微调大模型。

特色:

支持微调上几百大模型:LLaMA、LLaVA、Mistral、Mixtral-MoE、Qwen、Yi、Gemma、Baichuan、ChatGLM、Phi 等等。

支持多种大模型训练方法:(增量)预训练、(多模态)指令监督微调、奖励模型训练、PPO 训练、DPO 训练和 ORPO 训练。

多精度支持:32 比特全参数微调、16 比特冻结微调、16 比特 LoRA 微调和基于 AQLM/AWQ/GPTQ/LLM.int8 的 2/4/8 比特 QLoRA 微调。

多算法支持:GaLore、BAdam、DoRA、LongLoRA、LLaMA Pro、Mixture-of-Depths、LoRA+、LoftQ 和 Agent 微调。

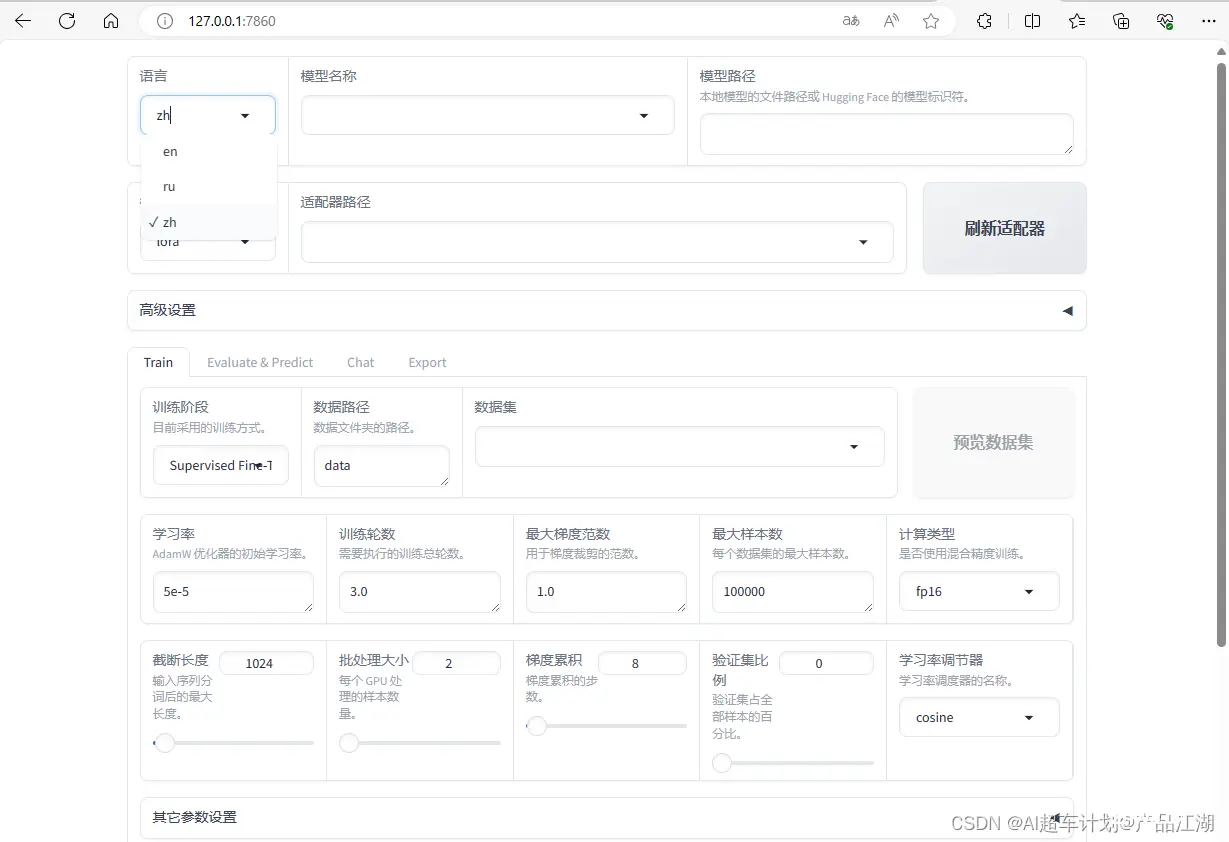

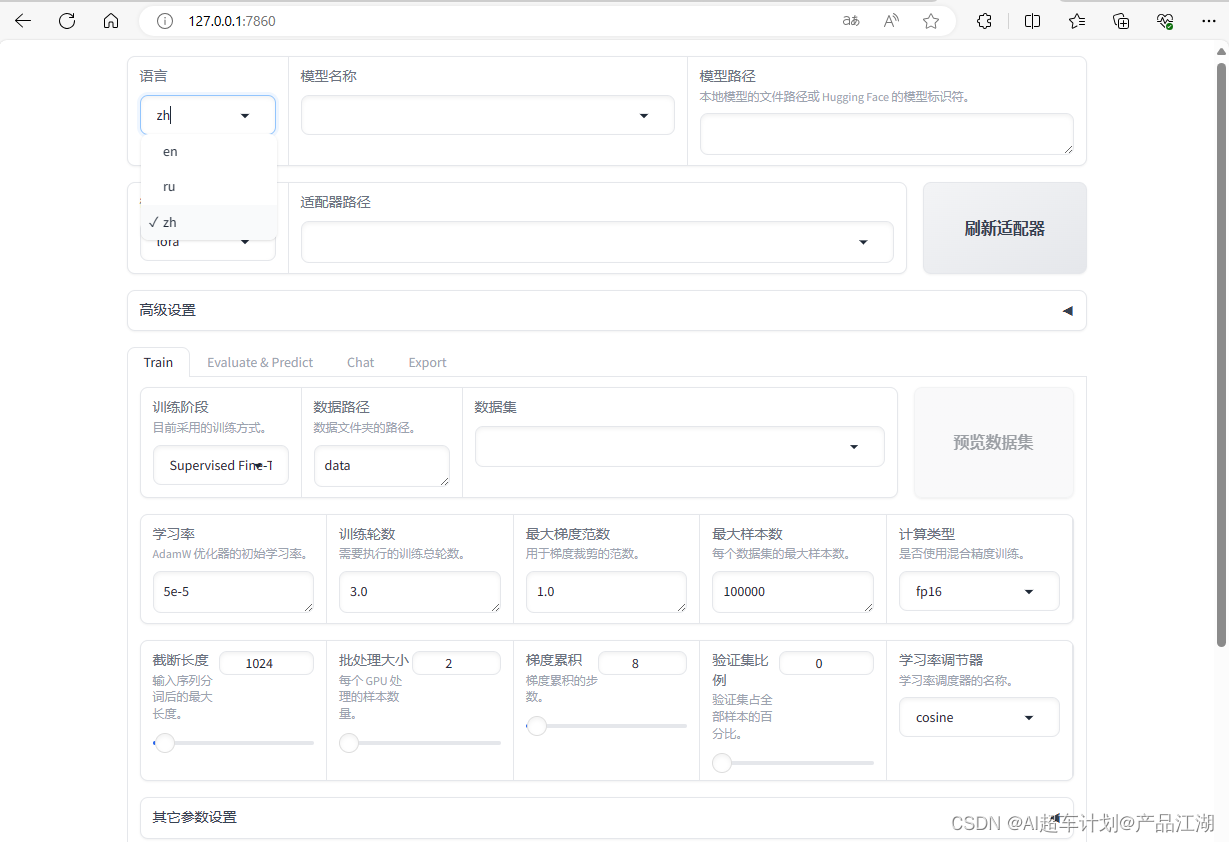

无需代码易操作可视化界面:如图所示,

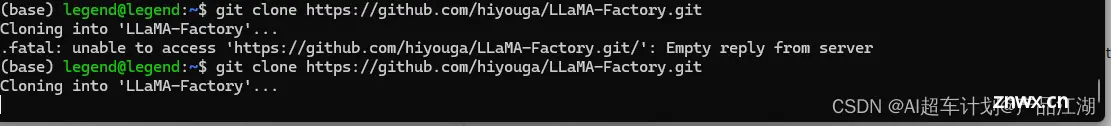

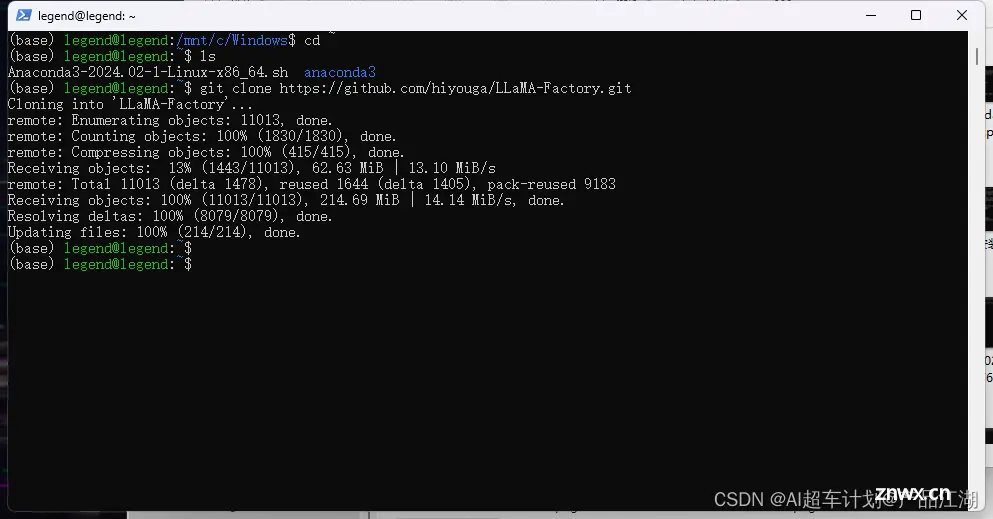

2、下载代码到本地

github 官方代码镜像地址:点我直达

https://github.com/hiyouga/LLaMA-Factory

Terminal中输入以下命令,下载LLaMA-Factory代码项目到本地:

git clone https://github.com/hiyouga/LLaMA-Factory

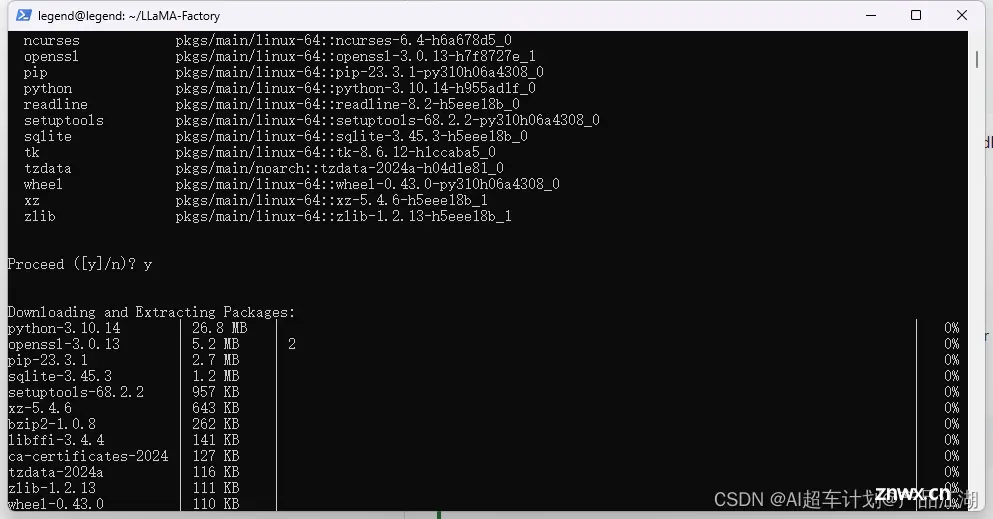

3、通过conda安装llama-factory的专属虚拟环境

① cd到 LLaMA-Factory目录下,在Terminal输入以下命令

conda create -n fine-tuning python=3.10

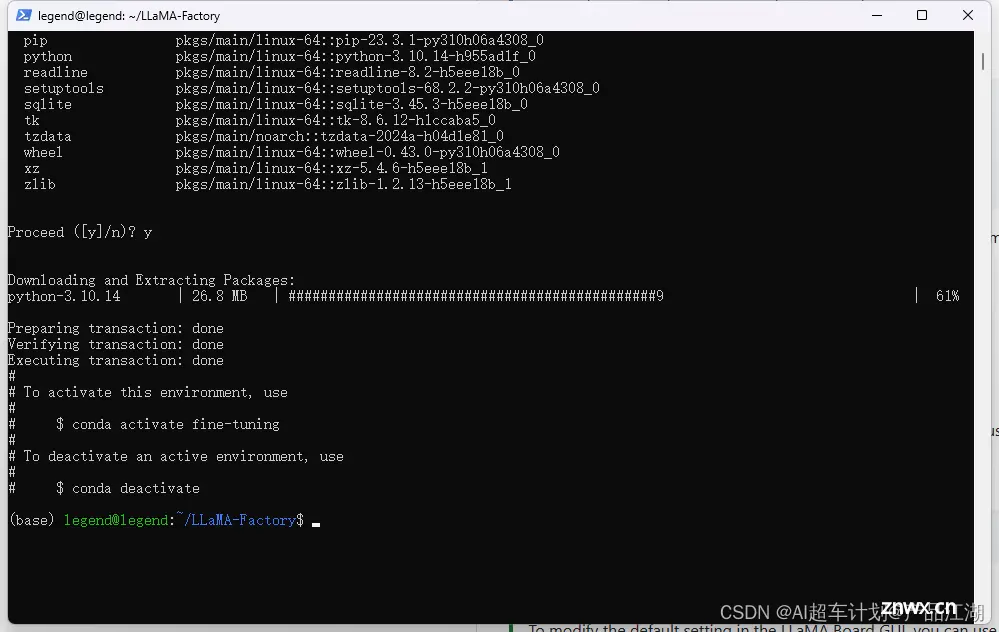

②输入y,回车

开始下载conda 虚拟环境的依赖包

fine-tuning虚拟环境依赖下载完成:

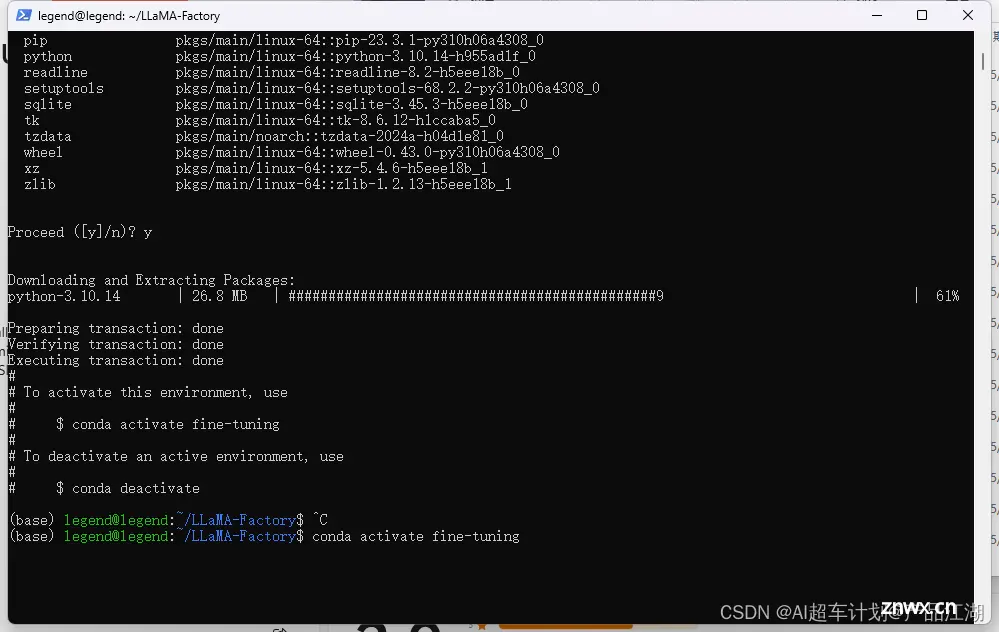

③激活虚拟环境

Terminal中输入

conda activate fine-tuning

激活成功

![]()

4、下载并安装llama-factory的环境依赖

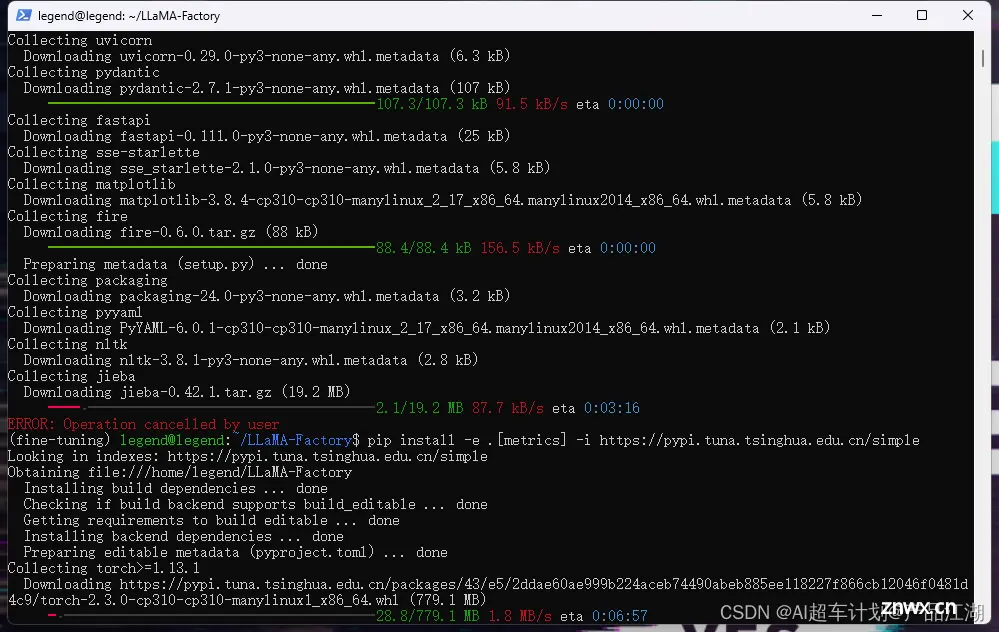

①cd进入LLaMA-Factory目录中,在Terminal中输入:

pip install -e .[metrics]

依赖下载中:

②优化下载源,需要暂停下载 ctl+c,调整指令:

pip install -e .[metrics] -i https://pypi.tuna.tsinghua.edu.cn/simple

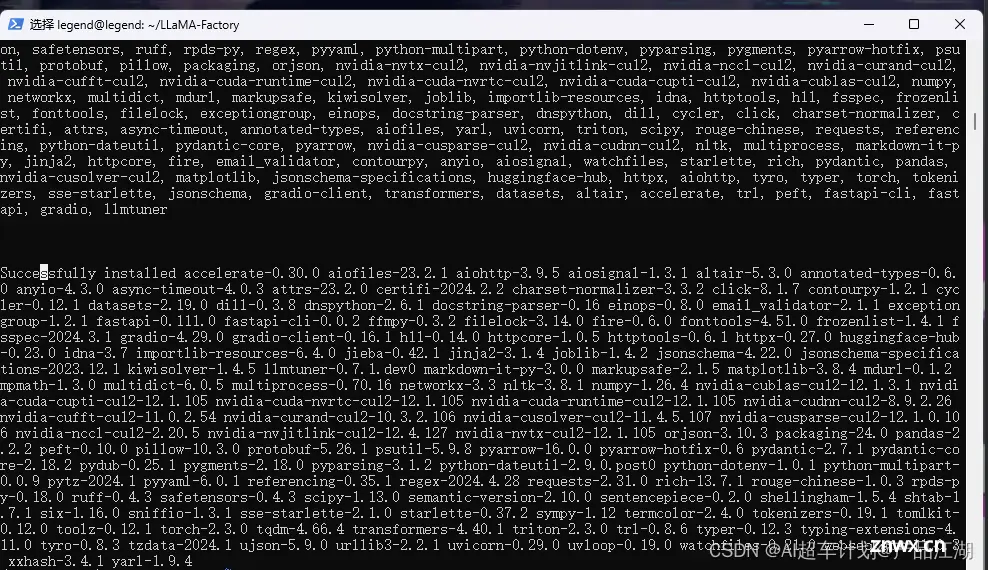

下载速度从几十k,升到几M

下载完成,并自动安装成功:

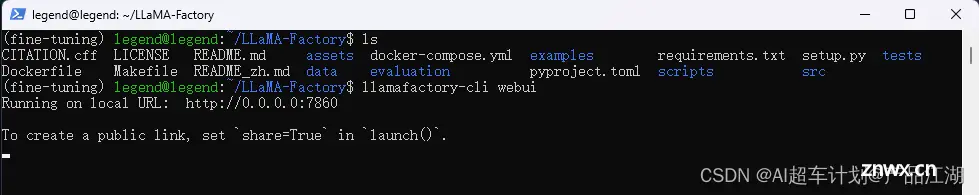

5、运行llama-factory

①在LLaMA-Factory目录中,Terminal中输入以下命令:

llamafactory-cli webui

②复制网址粘贴进浏览器:

http://127.0.0.1:7860/

点击左上角下拉选项卡,支持切换成中文:

6、通过LLaMA-Facotry微调(示意)

微调过程:

微调结果:

什么是AI超车计划?

是“产品江湖”社区发起的AI学习计划,由沐逸@产品江湖(微信号:legend_pmdiss)老师主理,旨在帮助大家在AI时代找到自己的位置和价值。

计划包含:

A计划【不掉队】-- 快速了解各种AI应用的使用,如Kimi、各种GPT,让自己不掉队!

B计划【赶得上】-- 快速了解现有开源的AI开发工具,如dify、Coze,以了解如何迅速构建AI应用,让自己赶得上!

C计划【快超车】--通过低代码平台并借助AI辅助编程,从零到一打造大模型应用,让自己实现快速超车!

了解AI超车计划

上一篇: 【探索】文字游侠AI新时代,每天5分钟自动化创作图文月入1万+,十分适合新手小白,附上渠道和教程(全面)

下一篇: Windows系统电脑本地部署AI音乐创作工具并实现无公网IP远程使用

本文标签

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。