Ollama是一个允许用户在本地启动并运行大型语言模型,它提供了一个简单易用的内容生成接口,类似于OpenAI,但无需开发经验即可直接与模型进行交互_openwebui...

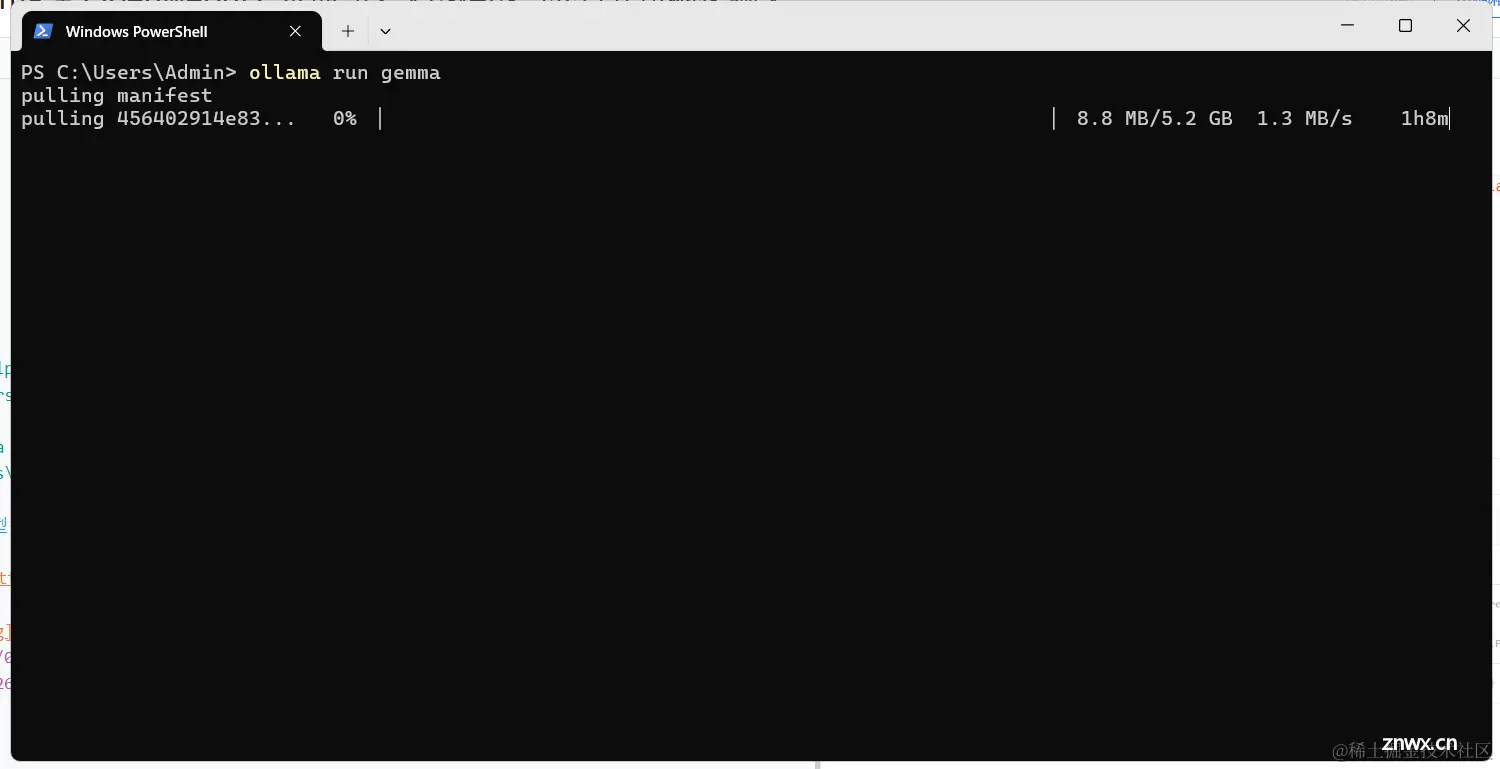

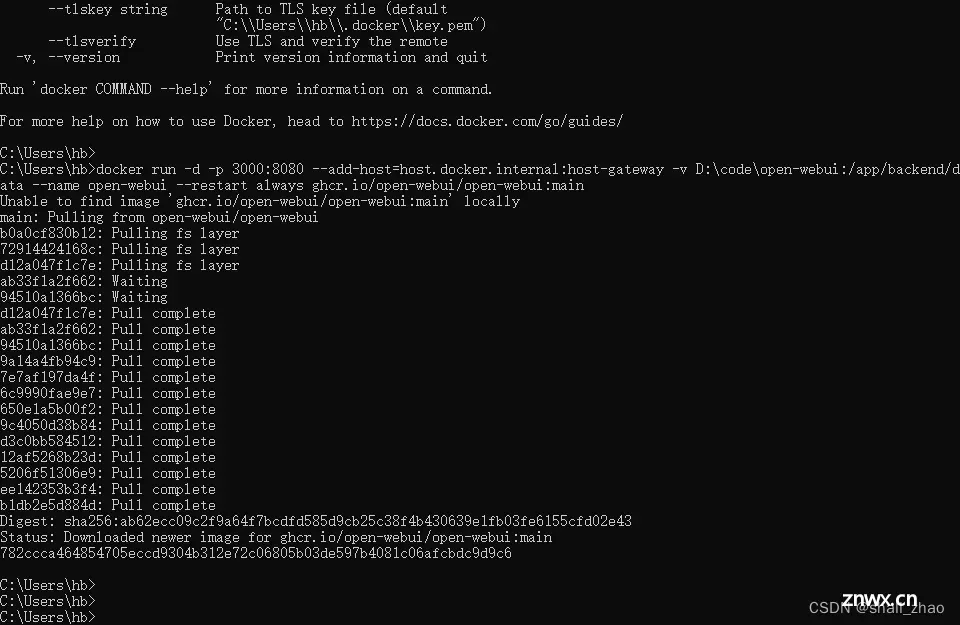

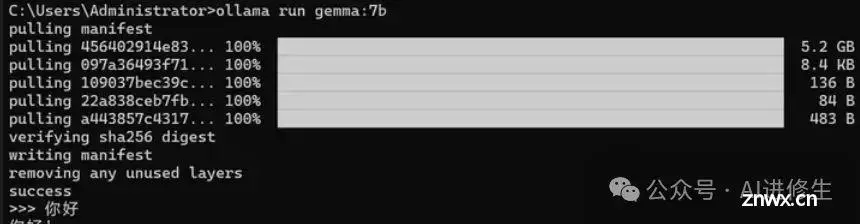

本篇基于windows环境下配置。_docker搭建openwebui...

本地运行大模型耗资源,需要选择较小的模型作为基础模型。在终端中运行时可能会出现CUDA错误,表示显存不足,导致提供的端口失效。若使用HuggingFace,需要申请APIKey并且需要本地有Pyth...

【Llama3:8b】手把手教你如何在本地部署自己的AI大模型_本地部署ai大模型...

一行代码完成Ollama本地部署,提升大语言模型推理服务部署与效果评测效率。_xinference和ollama...

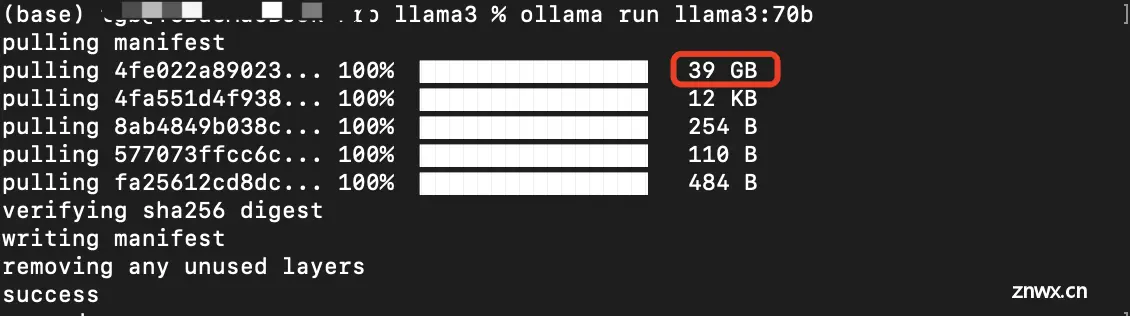

使用MacbookPro安装一个本地大语言模型Meta旗下最新大模型Llama3,80亿(8b)和700亿(70b)两个小参数版本,以及使用langchain完成简单的RAG。_langchainllama...

win10环境安装Ollama,并通过webui访问。以及如何在vscode中使用Ollama实现githubcopilot功能_ollama修改下载地址...

通过,您可以在本地运行各种大型语言模型(LLMs),并从中生成嵌入。SpringAI通过OllamaEmbeddingClient支持Ollama文本嵌入。嵌入是一个浮点数向量(列表)。两个向量之间的距离衡量它...

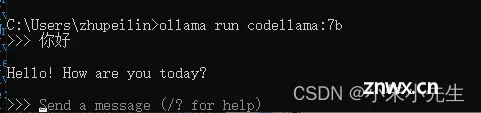

Ollama是一个用于在本地计算机上运行大模型的软件软件运行后端口,自己写的程序要调大模型就用这个端口ollamalist:显示模型列表ollamashow:显示模型的信息ollamapull:拉取模型ollam...

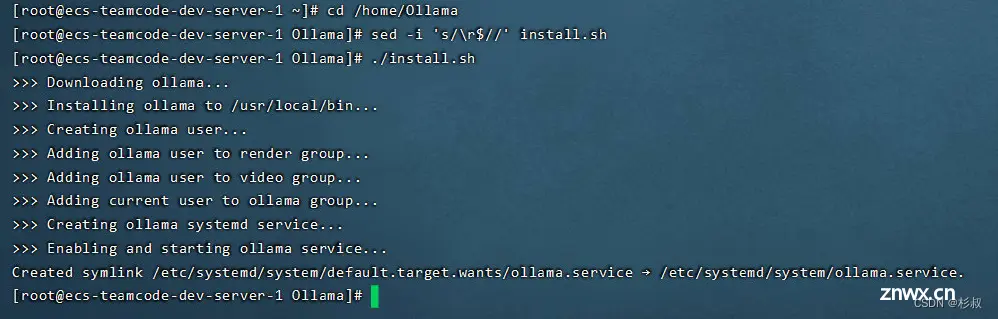

在线安装地址https://ollama.com/download选择服务器系统,按照步骤完成安装。下载地址https://github.com/ollama/ollama/releases/总共需要修改两个点...