Ollama是一款用于本地运行大语言模型的工具,支持对LLM模型进行管理、训练和推理。通过Ollama,用户可以在本地机器上运行GPT-4、BERT等模型,并利用Ollama提供的Web界面或...

等,进一步支撑你的行动,以提升本文的帮助力。_crewai...

简介如何用ollama在linux部署大模型_linux离线安装ollama...

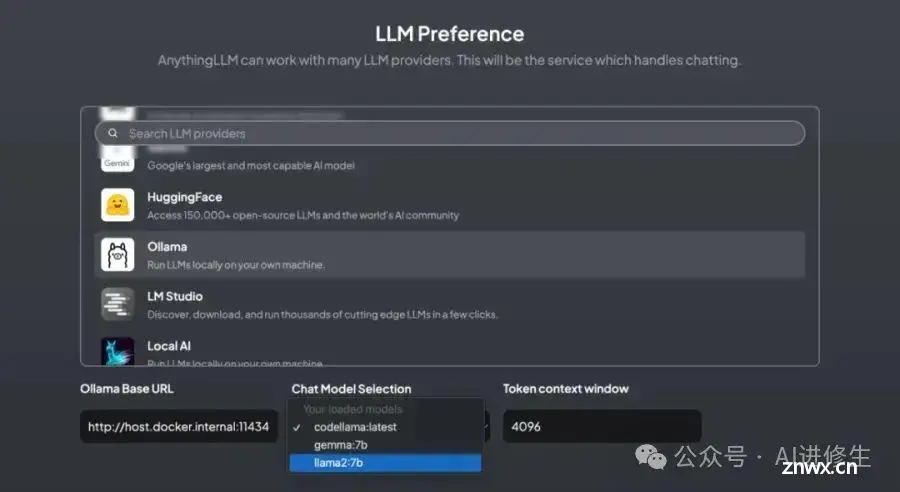

本文主要分享如何在群晖NAS本地部署并运行一个基于大语言模型Llama2的个人本地聊天机器人并结合内网穿透工具发布到公网远程访问。本地部署对设备配置要求高一些,如果想要拥有比较好的体验,可以使用高配置的服务器设...

本地运行大模型耗资源,需要选择较小的模型作为基础模型。在终端中运行时可能会出现CUDA错误,表示显存不足,导致提供的端口失效。中文支持不够完善。\\3.文中提到的技术软件工具有:Ollama、Chatbox...

python调用ollama库详解,包含:准备Ollama软件、准备ollama库ollama库的基本使用ollama库的进阶使用:options参数设置、返回的json对象处理_pythonollama...

Ollama是一个基于Python的工具,专为本地调用大型语言模型而设计。它提供了用户友好的接口,使开发者能够在本地环境中快速加载和管理模型,简化了大模型的集成与使用流程。Ollama适用于各种应用场景,...

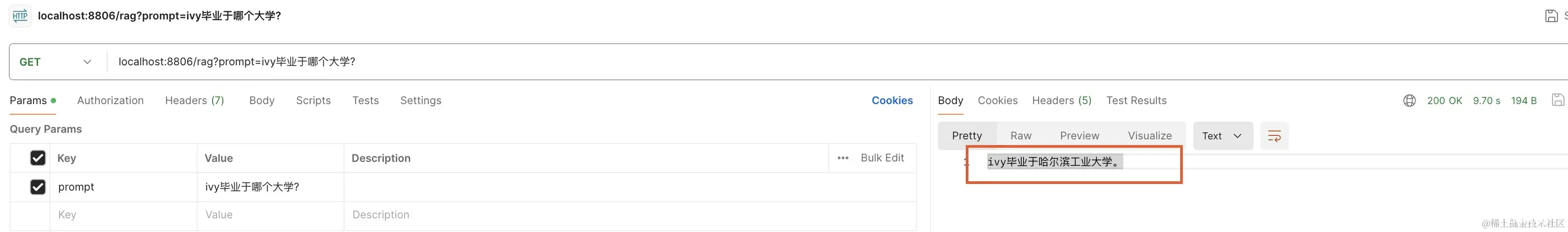

了解完嵌入模型、向量数据库相关知识后,在此基础上可以实现一个RAG本地问答系统。_springairag...

通过手动下载必要文件并修改安装脚本,你可以有效解决由于网络问题导致的Ollama安装失败。这种方法特别适合在受限网络环境下工作或部署的用户。希望这篇指南能帮助你顺利安装Ollama,并在你的开发环境中开始使用这...

OpenWebUI(FormerlyOllamaWebUI)也可以通过docker来安装使用1.详细步骤1.1安装OpenWebUI#官方建议使用python3.11(2024.09.27),conda的使用参考其他文章co...