随着大语言模型发展越来越成熟,Apache开源组织也出了自己的SpringAI开源工程SpringAI项目旨在简化包含人工智能功能的应用程序的开发,避免不必要的复杂性。该项目从著名的Python项目(例如Lan...

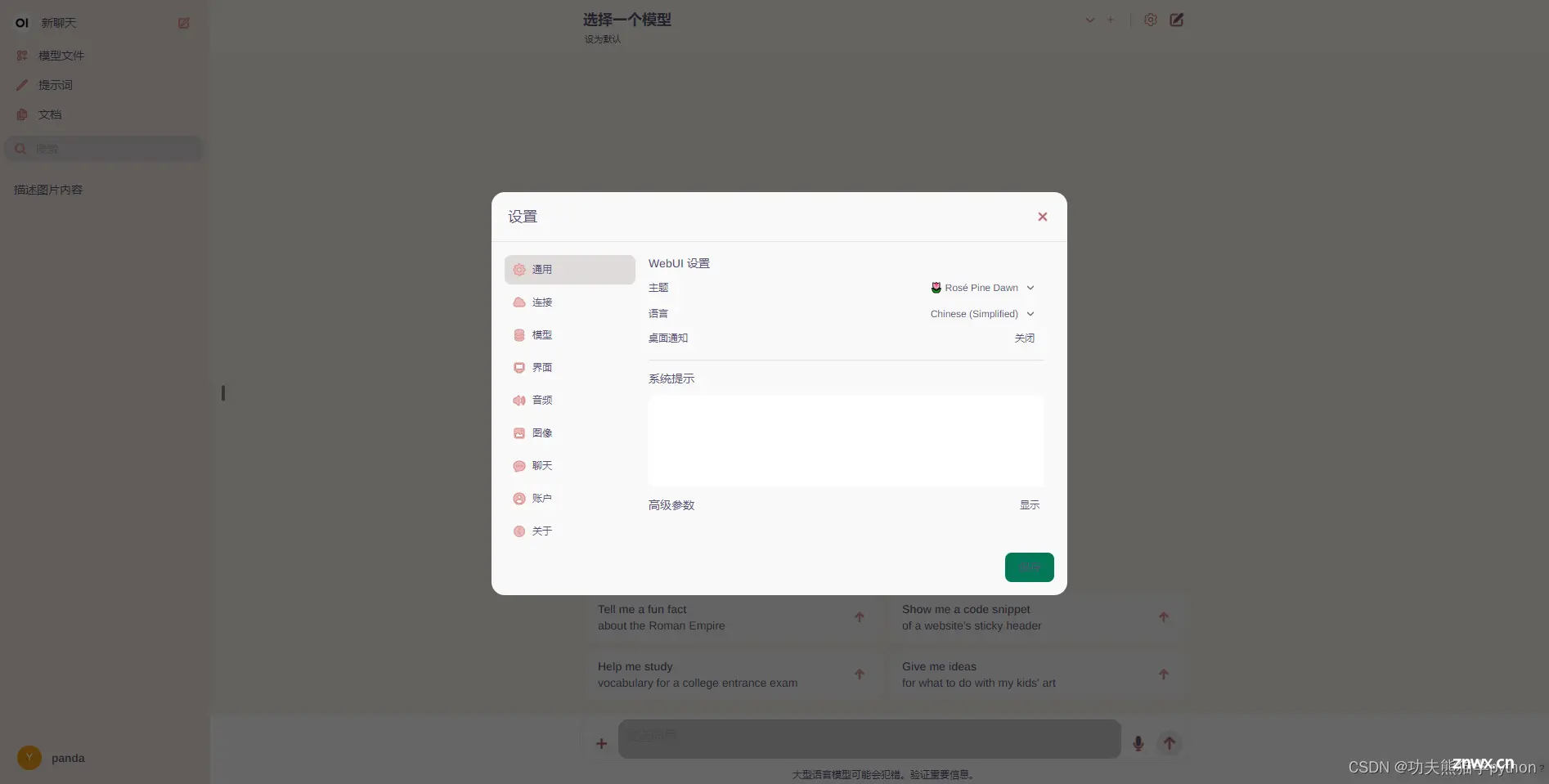

OpenWebUI是一种可扩展、功能丰富且用户友好的自托管WebUI,旨在完全离线运行。它支持各种LLM运行器,包括Ollama和OpenAI兼容的API。open-webui项目地址。_olla...

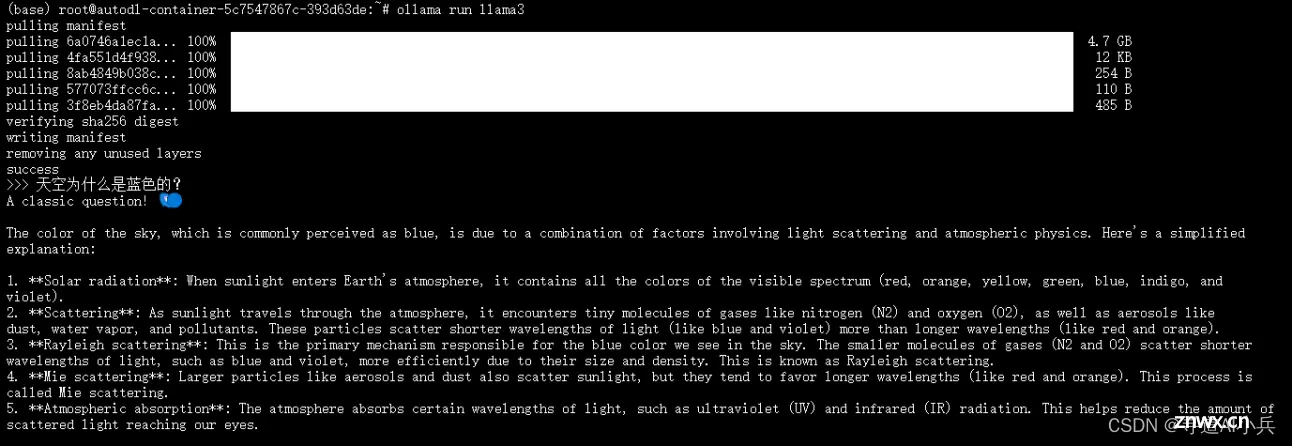

Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。它提供了一套简单的工具和命令,使任何人都可以轻松地启动和使用各种流行的LLM,例如GPT-3、Megatron-Turi...

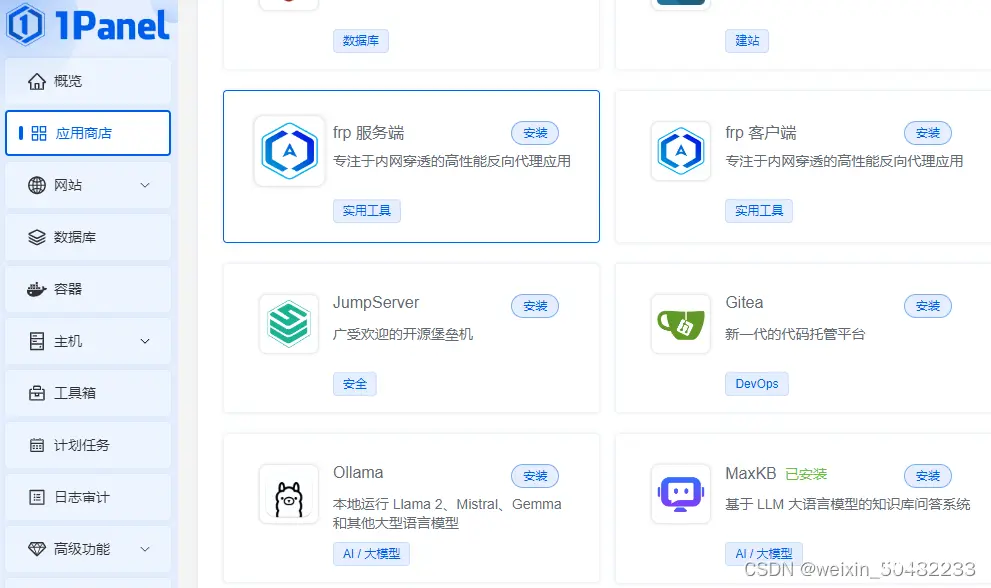

Ollama是一个开源平台,用于管理和运行各种大型语言模型(LLM),例如Llama2、Mistral和Tinyllama。它提供命令行界面(CLI)用于安装、模型管理和交互。您可以使用Olla...

我们正处在人工智能技术飞速发展的时代,其中大型语言模型(LLMs)已成为技术革新的前沿话题。这些模型以其强大的语言理解和生成能力,正在改变我们与机器交互的方式,并在自然语言处理(NLP)、内容创作、代码生成等多...

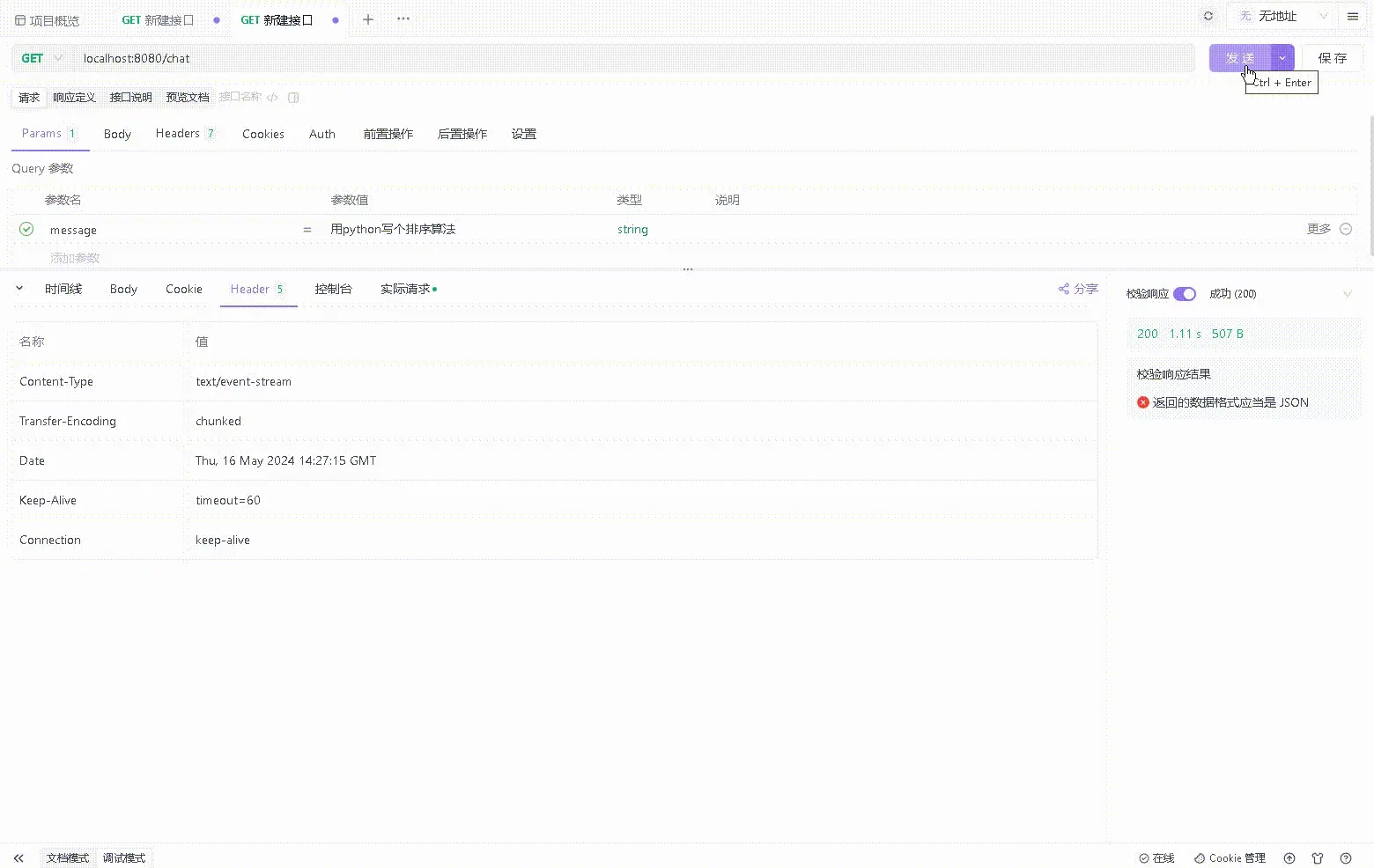

SpringAI不仅提供了与OpenAI进行API交互,同样支持与Ollama进行API交互。Ollama是一个发布在GitHub上的项目,专为运行、创建和分享大型语言模型而设计,可以轻松地在本地启动和...

打开编辑,可以直接修改文件保存的路径,即本机目录。llama3:70b,一张A100(80G显存)可以运行起来,45G显存就可以运行,但能不能推理没尝试过。如果在演示中,出现限制次数问题,可以在应用中,点击应用...

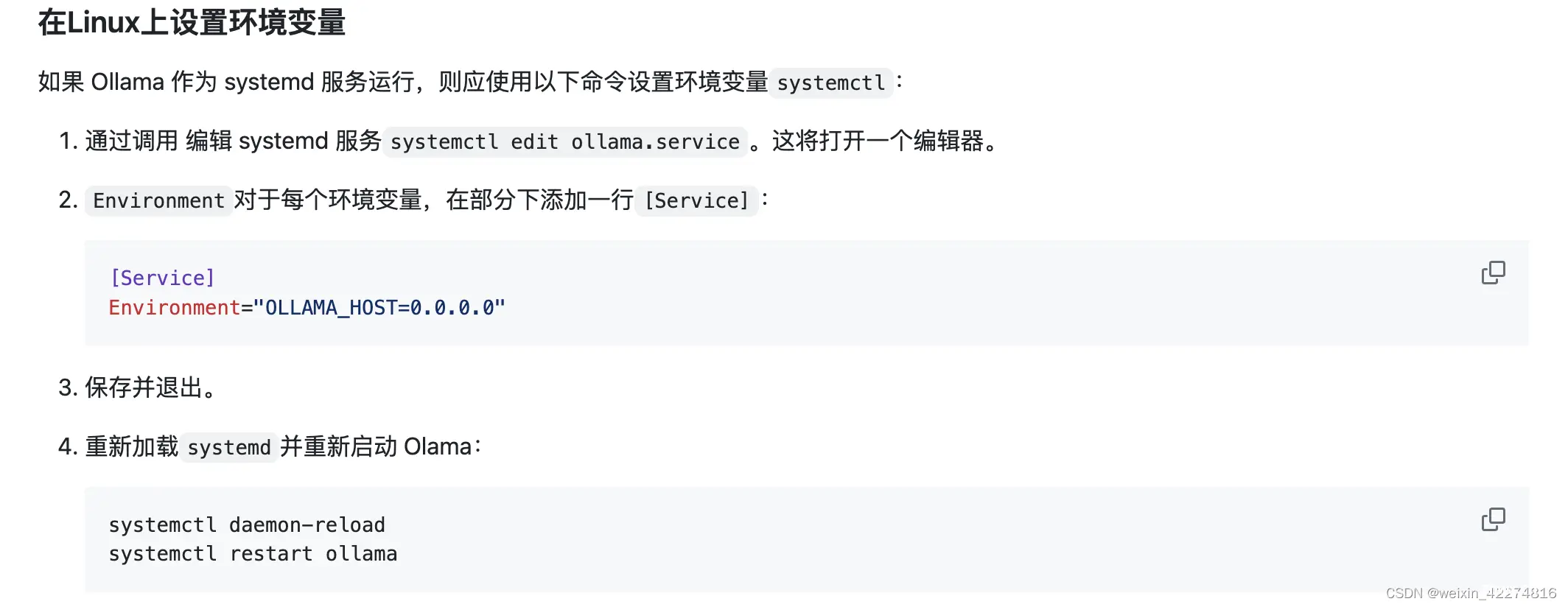

需要在linux中设置环境变量,将ollama作为systemd服务运行。#Linux中docker中的应用无法访问本地的ollama问题。运行命令最好以sudo权限运行。,其它系统参考官方文档。_exitingchainwith...

Docker下OpenWebUI,Ollama的安装实践_open-webuidocker...

Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。qwen-2(Qwen-2,量子阱增强神经网络版本2)是阿里巴巴集团开发的先进人工智能语言模型。基于Qwen-1的成功...