Ollama作为一款开源工具,为用户提供了便捷的本地大模型部署和调用方式,其卓越的兼容性和灵活性使得在多种操作系统上运行大规模语言模型变得更加简易。通过Docker的安装与部署,用户可以快速上手并灵活使用各类大型...

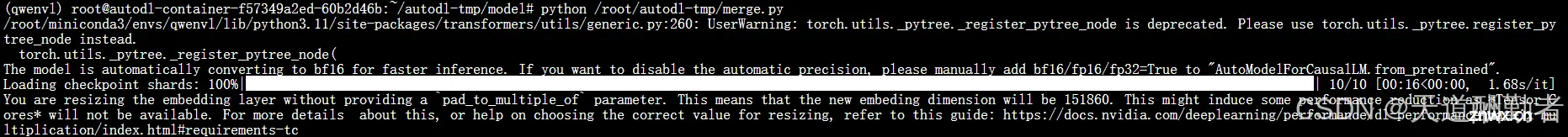

Qwen-VL大模型LoRA微调、融合及部署_qwen-vl微调...

大模型现状详细介绍:包括技术、问题、未来发展_大模型发展现状...

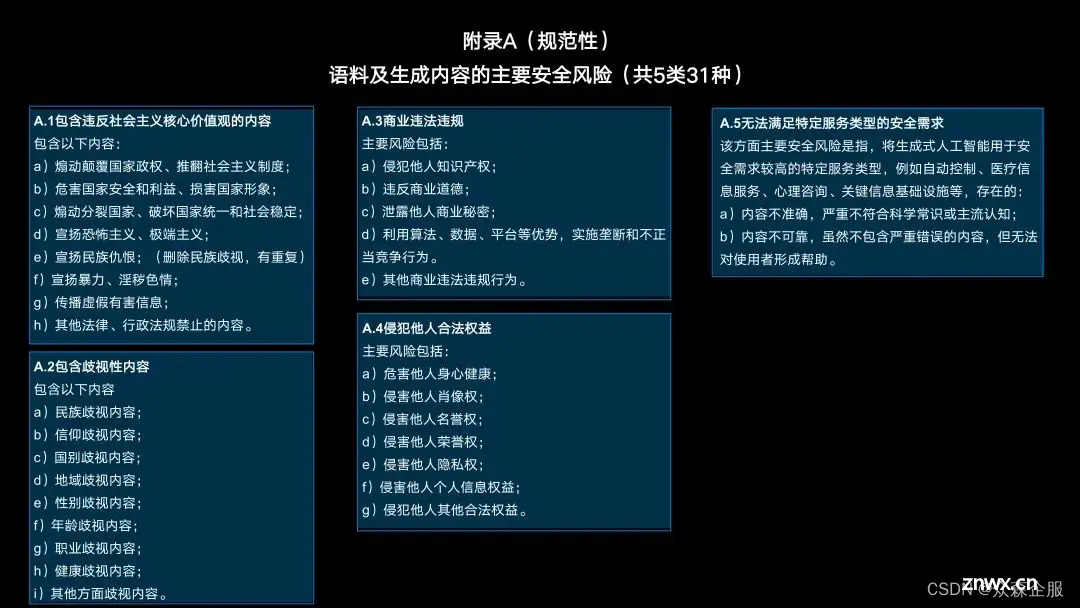

《互联网信息服务深度合成管理规定》第十九条规定“具有舆论属性或者社会动员能力的深度合成服务提供者,应当按照《互联网信息服务算法推荐管理规定》履行或办理备案、变更、注销等相关手续。而大模型备案自《生成式人工智能服务管...

用较大chunk_size去字符切分文本,然后对大文本块用LLM做总结,作为摘要块加入向量数据库中。能在一定程度解决前面提到的问题1。_大模型知识库问答优化分块...

定义的chinese_multiple_choice_questions该函数的主要逻辑是通过正则表达式匹配和提取文本中的问题和选项。对于选择题,它提取了问题的编号、文本和选项,并将它们存储在一个字典中。对于简答题...

大家好,今天我们一同来探讨一下那些大模型背后的核心技术!Transformer模型,无疑是大型语言模型的坚实基石,它开启了深度学习领域的新纪元。在早期阶段,循环神经网络(RNN)曾是处理序列数据的核心手段。尽管R...

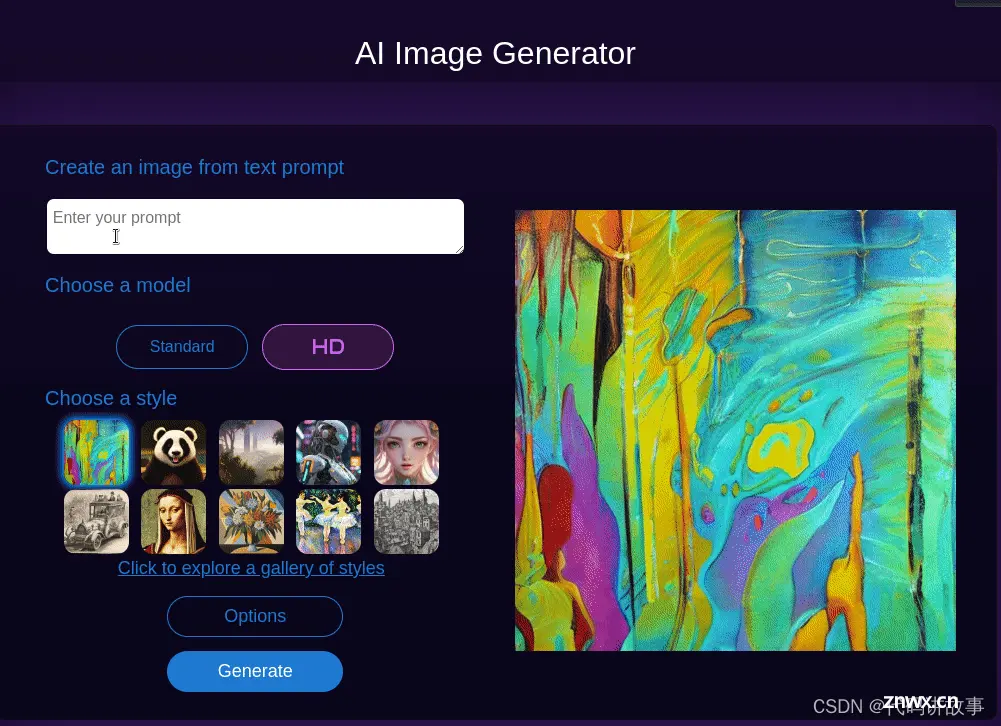

一款免费无限制的AI视频生成工具火了!国内无障碍访问!目前真正免费无限制,可以用来制作抖音短视频,视频效果体验不逊色于pika和runway,以及其他的免费AI在线人工智能大模型,附教程。_免费ai视频...

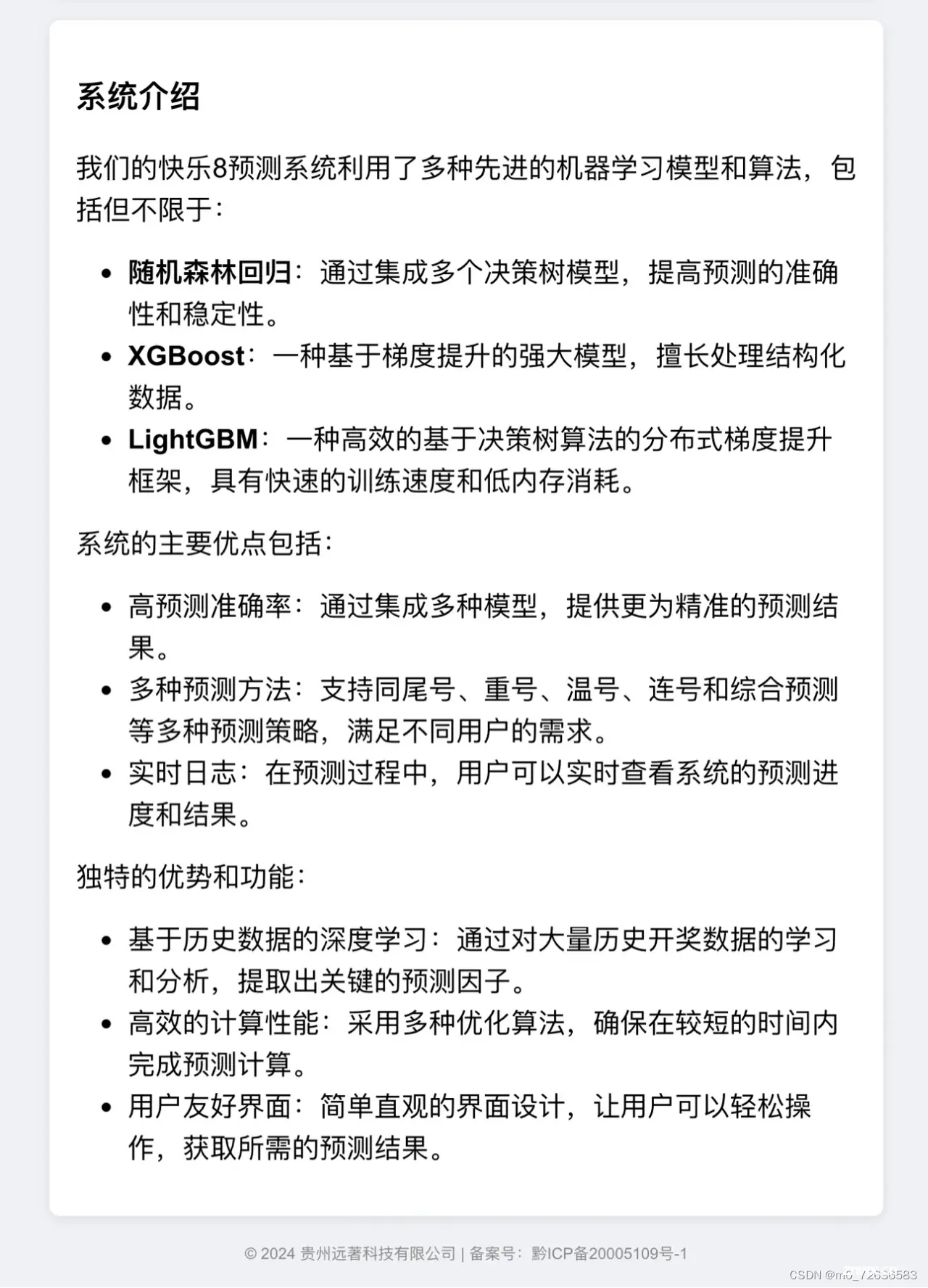

随机森林回归:通过集成多个决策树模型,提高预测的准确性和稳定性。XGBoost:一种基于梯度提升的强大模型,擅长处理结构化数据。LightGBM:一种高效的基于决策树算法的分布式梯度提升框架,具有快速的训练速度和低内存...

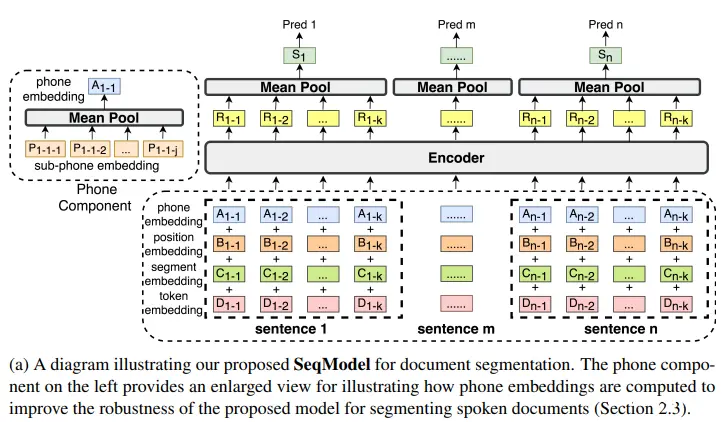

随着深度学习技术的飞速发展,特别是大型语言模型(LargeLanguageModels,LLMs)的涌现,我们正步入一个全新的时代。这些模型通过大规模的训练,能够掌握丰富的语言知识和模式,具备回答复杂问题、...