2024年4月18日,meta开源了Llama3大模型[1],虽然只有8B[2]和70B[3]两个版本,但Llama3表现出来的强大能力还是让AI大模型界为之震撼了一番,本人亲测Llama3-70B版本的推理...

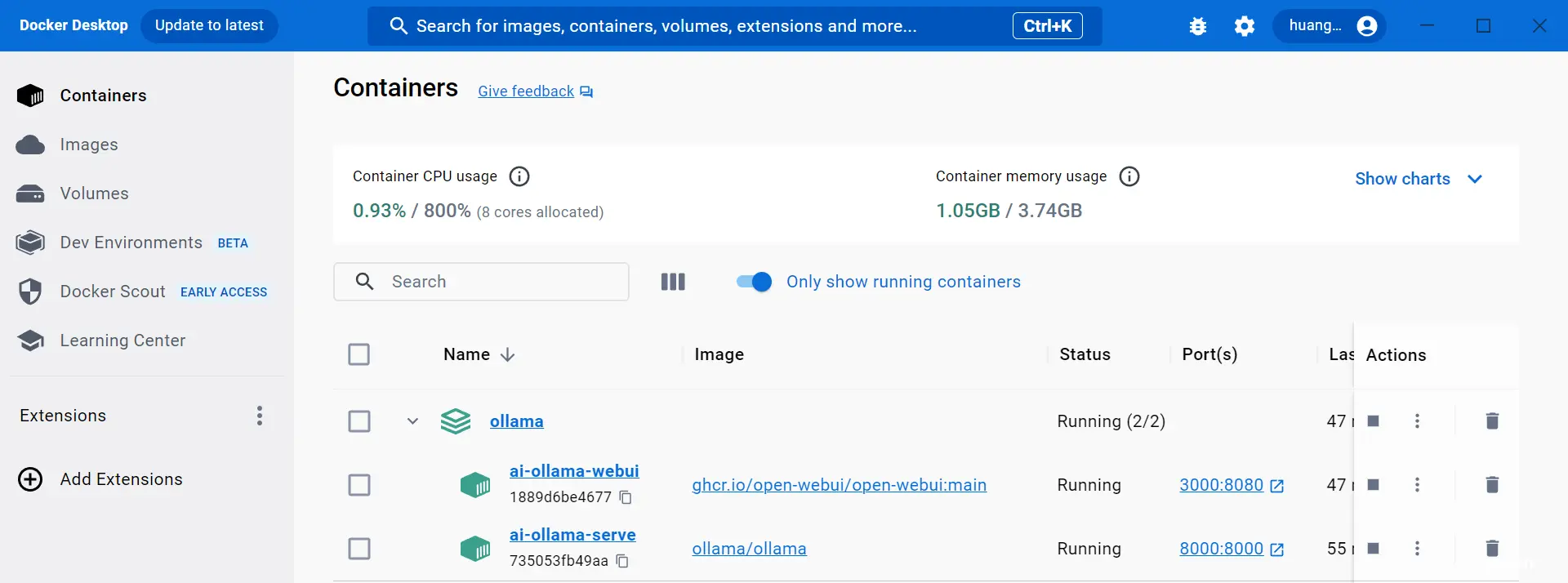

docker部署ollama。_ollamadocker部署...

ollama是大模型部署方案,对应docker,本质也是基于docker的容器化技术。ollama提供了openAI兼容的api,可以最大限度的减少理解和开发成本。_ollama安装...

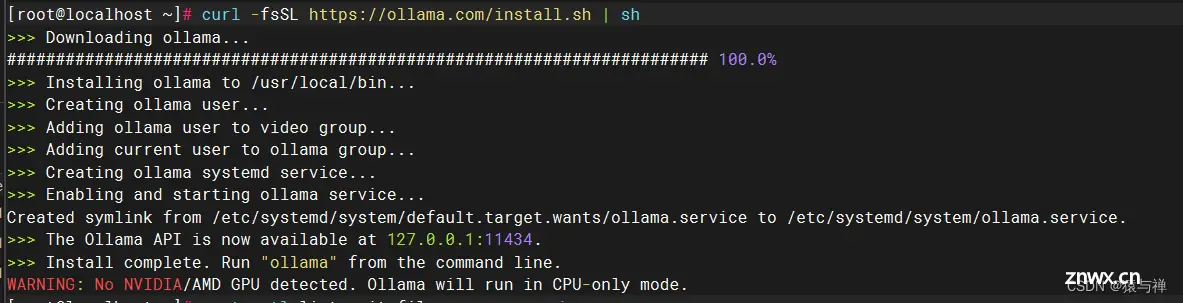

Ollama轻量级、可扩展的框架,用于在本地机器上构建和运行大型语言模型(LLM)。提供了一个简单的API来创建、运行和管理模型,以及一个预构建模型库,可以轻松用于各种应用程序。明显优势:易于使用、轻量级、可扩展、预构建...

趁着Llama3的热度试了一下Ollama,果然部署推理大模型很有用。一个现实的需求是,如果我们要在局域网中访问Ollama上大模型的服务,应该怎么办呢?参考了一下其他博客的方法。就可以通过局域网或者另一台机子上的La...

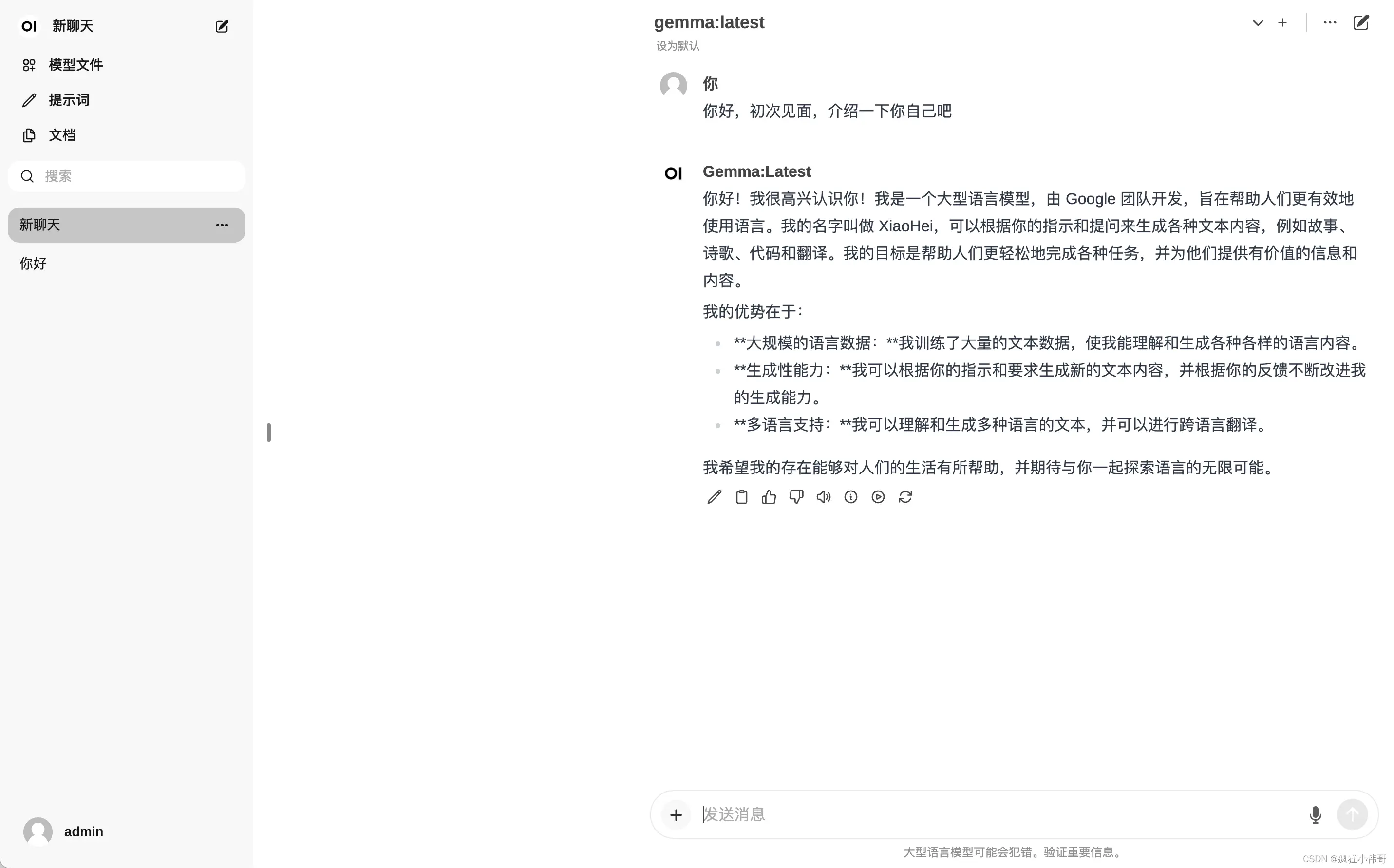

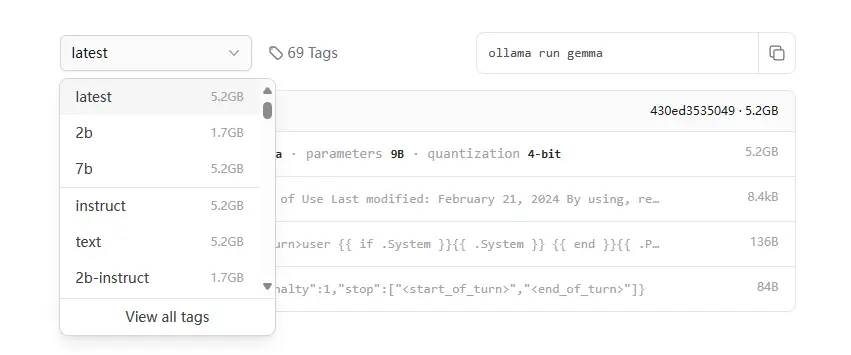

将${inner_ip}替换成你本机IP(用hostname-I可查看)几行命令教你私有化部署自己的AI大模型,每个人都可以有自己的GTP。(ollamarungemma)安装谷歌gemma大模型。(ollam...

详细介绍如何利用ollama集成open-webui本地部署大模型应用_ollama无法连接...

一些简单步骤:启动Ollama:在命令行中输入ollama命令来启动Ollama。部署模型:使用ollamarungemma:2b命令来部署Gemma模型。这将从Ollama的模型库中下载并安装Gemma模型的最新版本。使用模型:模型安装完成后,你可...

ollama+fastgpt搭建本地私有AI大模型智能体工作流(AIAgentFlow)--windows环境;windows搭建真正本地RAG检索agent。_fastgptollama...

本文介绍了如何在本地使用Ollama的Gemma模型进行文本处理,包括安装、模型选择、在SpringAI中的应用以及嵌入向量的计算。作者还提到了如何下载其他模型如mofanke/dmeta-embedding-z...