ollama集成open-webui本地部署大模型应用

猿与禅 2024-07-02 13:33:04 阅读 50

文章目录

概述

安装ollama

运行指定模型

命令帮助

docker 安装 webui

WebUI与ollama在同一台机器

WebUI与ollama不在同一台机器(推荐)

更新

open-webui离线安装

open-webui使用

验证访问

导入模型文件

参考资料

概述

ollama是一款在本地启动并运行大型语言模型的工具,主要功能是在 Docker 容器内部署和管理 LLM 的促进者,它使该过程变得非常简单。它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型

Ollama 将模型权重、配置和数据捆绑到一个包中,定义成 Modelfile。它优化了设置和配置细节,包括 GPU 使用情况。

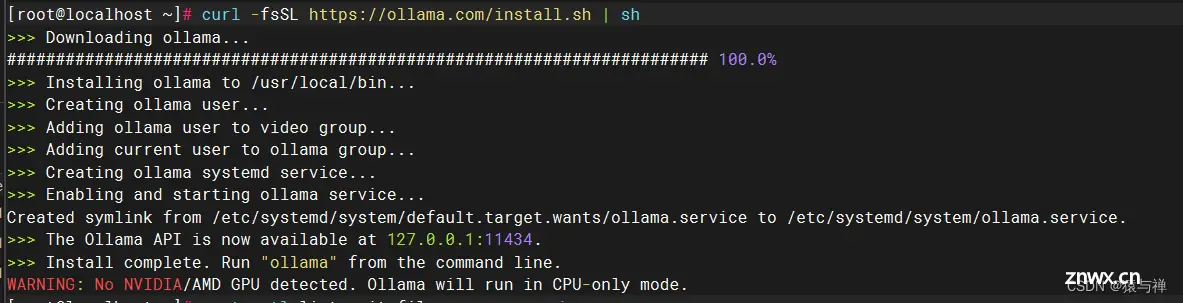

安装ollama

在线安装:

curl -fsSL https://ollama.com/install.sh | sh

ollama离线安装教程

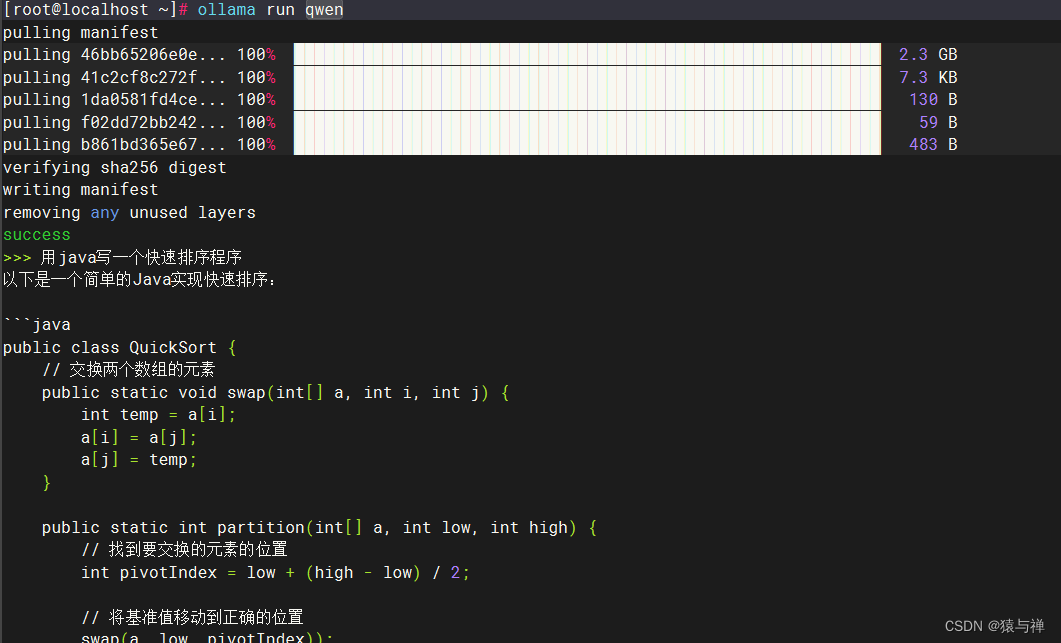

运行指定模型

这时候我就发现了ollama的一个坑,我们在成功启动ollama的时候就已经

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。