经典网络模型系列——Swin-Transformer详细讲解与代码实现_swintransformer...

本文对使用transformers的AutoModel自动模型类进行介绍,主要用于加载transformers模型库中的大模型,文中详细介绍了应用于不同任务的ModelHead(模型头)、使用模型头、输出模型结...

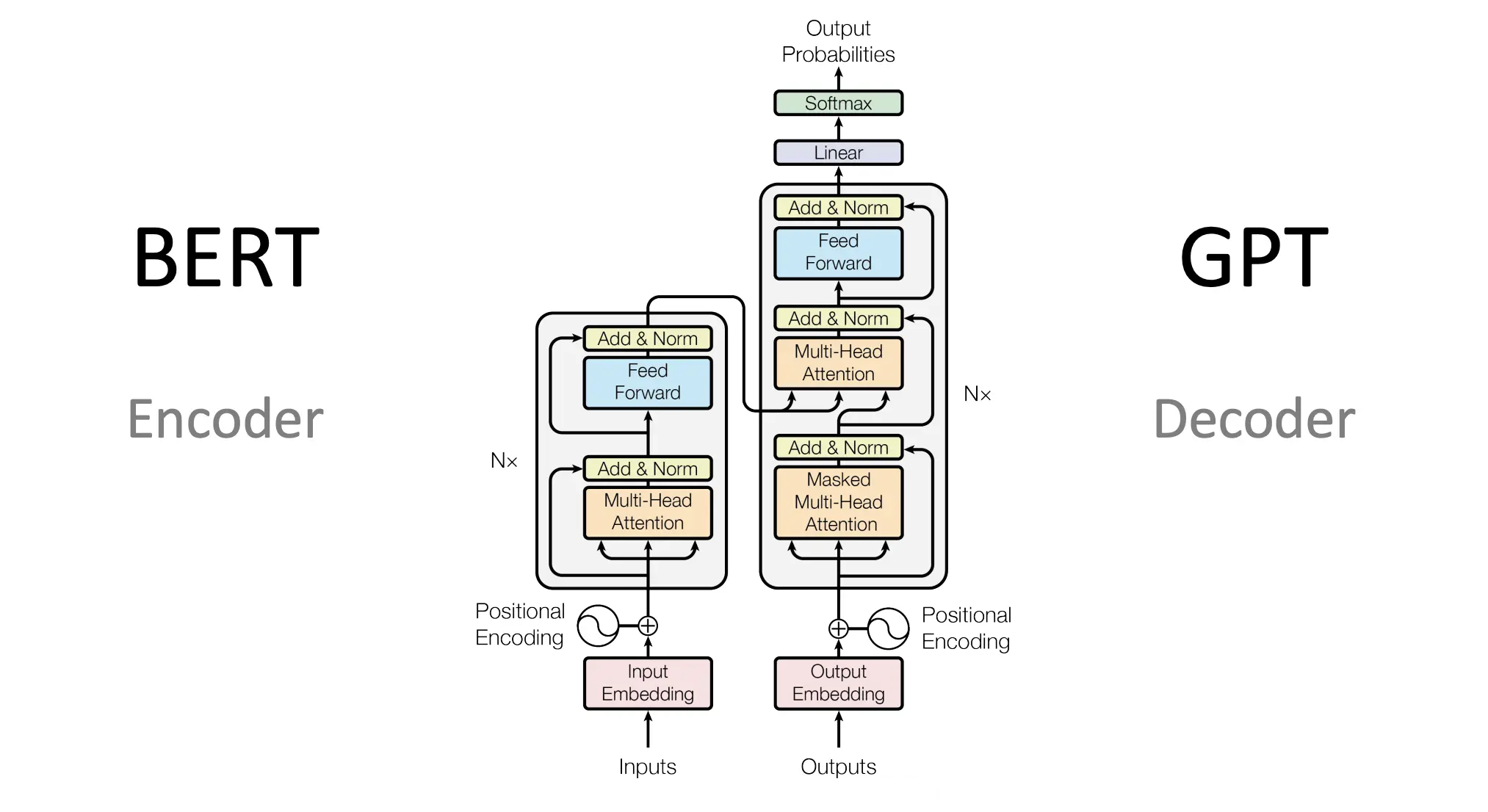

大侠幸会,在下全网同名「算法金」0基础转AI上岸,多个算法赛Top「日更万日,让更多人享受智能乐趣」抱个拳,送个礼在现代自然语言处理(NLP)领域,Transformer模型的出现带来了革命性的变化。它极大地提升了语言模型的性能和效率,而自注...

在AI语言模型学习任务中,数据是至关重要的部分。一个高质量的数据集不仅决定了模型的上限,还影响着模型训练的效率和效果。然而,获取、处理和组织数据往往耗时耗力。为了简化这一过程,HuggingFace推出了Da...

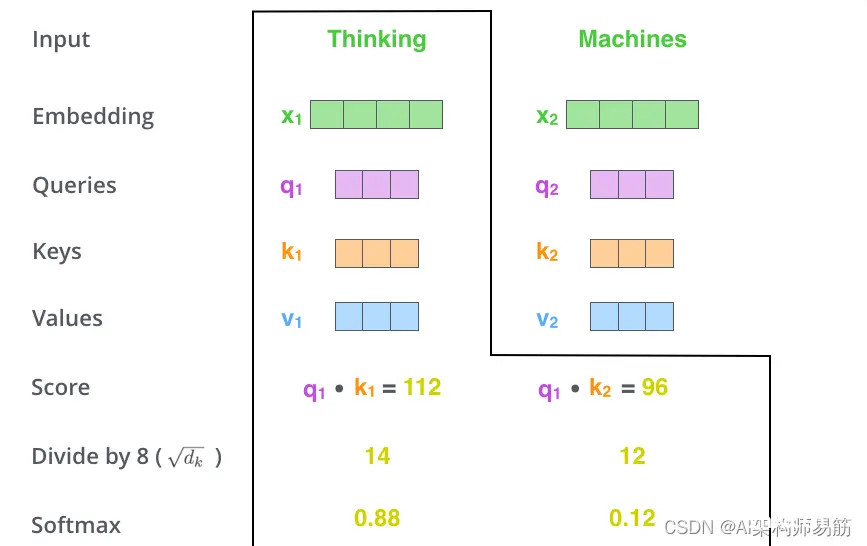

它们是用于计算和思考注意力的抽象概念。一旦你继续阅读下面的注意力是如何计算的,你就会知道几乎所有你需要知道的关于每个向量所扮演的角色。计算self-attention的第二步是计算一个分数。假设我们正在计算本...

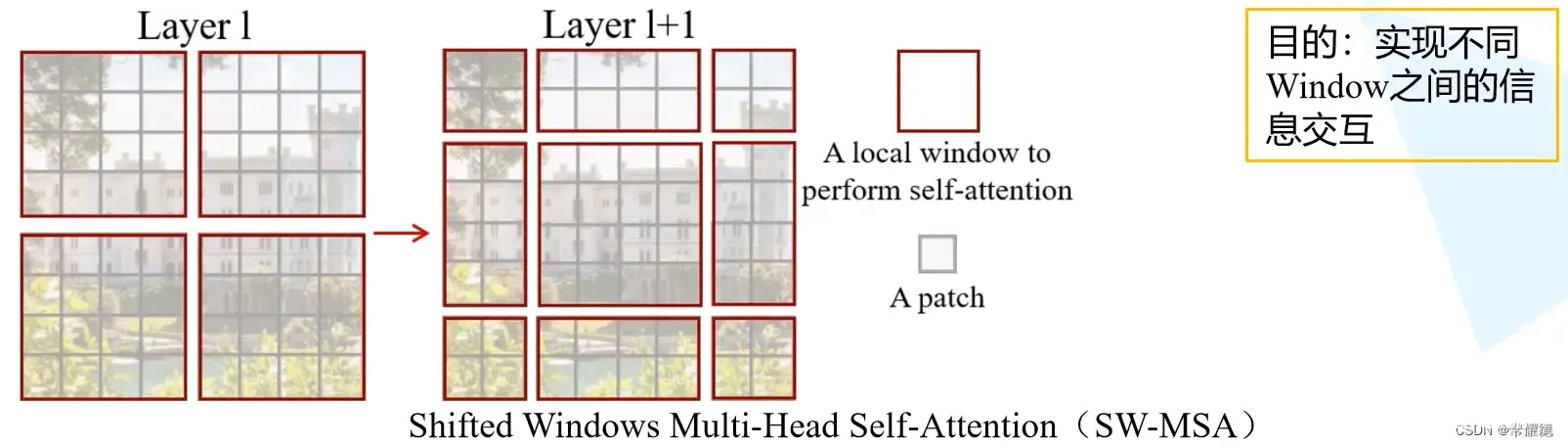

SwinTransformer是一种为视觉领域设计的分层Transformer结构。它的两大特性是滑动窗口和分层表示。滑动窗口在局部不重叠的窗口中计算自注意力,并允许跨窗口连接。分层结构允许模型适配不同尺度的图片...

Google在人工智能领域的贡献是不可小觑的,尤其是在Transformer模型的研究和发展中。Transformer模型最初由Vaswani等人在2017年的论文《AttentionisAllYouNe...

本文介绍了Transformer,一种强大的神经网络架构,尤其在自然语言处理和机器翻译中取得成功。文章详细讲解了Transformer的工作原理、组成部分、优势以及在自动驾驶中的感知、决策规划和数据分析应用。...

本文简要介绍了device_map=\"auto\"等使用方法,多数情况下与CUDA_VISIBLE_DEVICES=1,2,3一起使用,可以简单高效的进行多卡分布式推理及训练计算,至于多机多卡场景,多用torc...

通过本文,我们深入探讨了ModuleNotFoundError:Nomodulenamed‘transformers’错误的原因、解决方案以及相关的Python包和模块知识。我们提供了安装transfor...