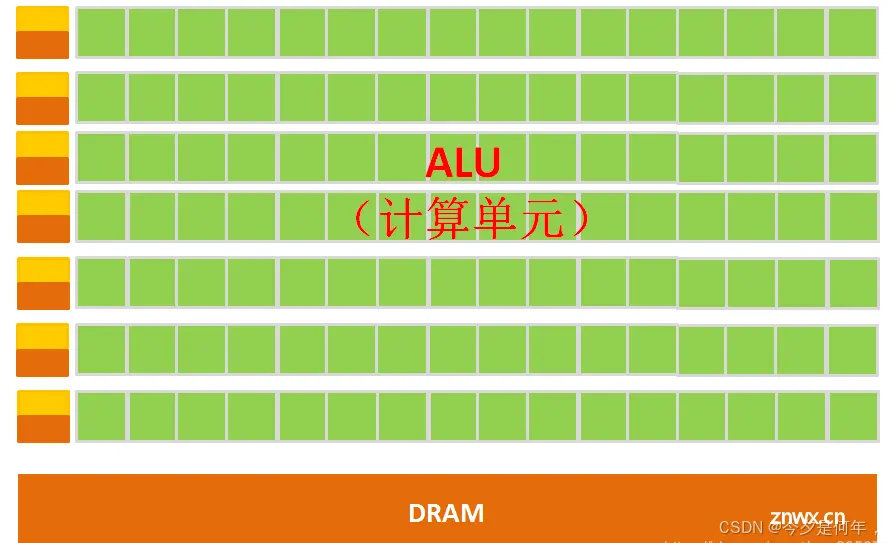

CPU是计算机系统的核心,负责执行操作系统和应用程序的指令。它由多个核心组成,每个核心可以独立执行任务。CPU的设计重点是处理复杂的逻辑运算和顺序任务,如分支预测、指令调度等。现代CPU通常包含多个层级的缓存(如L1、L2和L3缓存),以...

对比分析NVIDIA的H100、A100、A6000、A4000、V100、P6000、RTX4000、L40s、L4九款GPU,哪些更推荐用于模型训练,哪些则更推荐用于推理。_l4gpu...

在使用PyTorch框架时,可以通过以下步骤查看可用的GPU数量,指定使用的GPU编号,并在代码中体现这一点。_torch查看可用gpu...

使用@cuda.jit装饰器定义GPU核函数,这与CPU加速中使用的@jit类似,但@cuda.jit@cuda.jit#核函数体,使用CUDA线程索引进行计算#例如:position=cu...

通过llama.cpp运行7B.q4(4bit量化),7B.q8(8bit量化)模型,测量了生成式AI语言模型在多种硬件上的运行(推理)速度.根据上述测量结果,可以得到以下初步结论:(1...

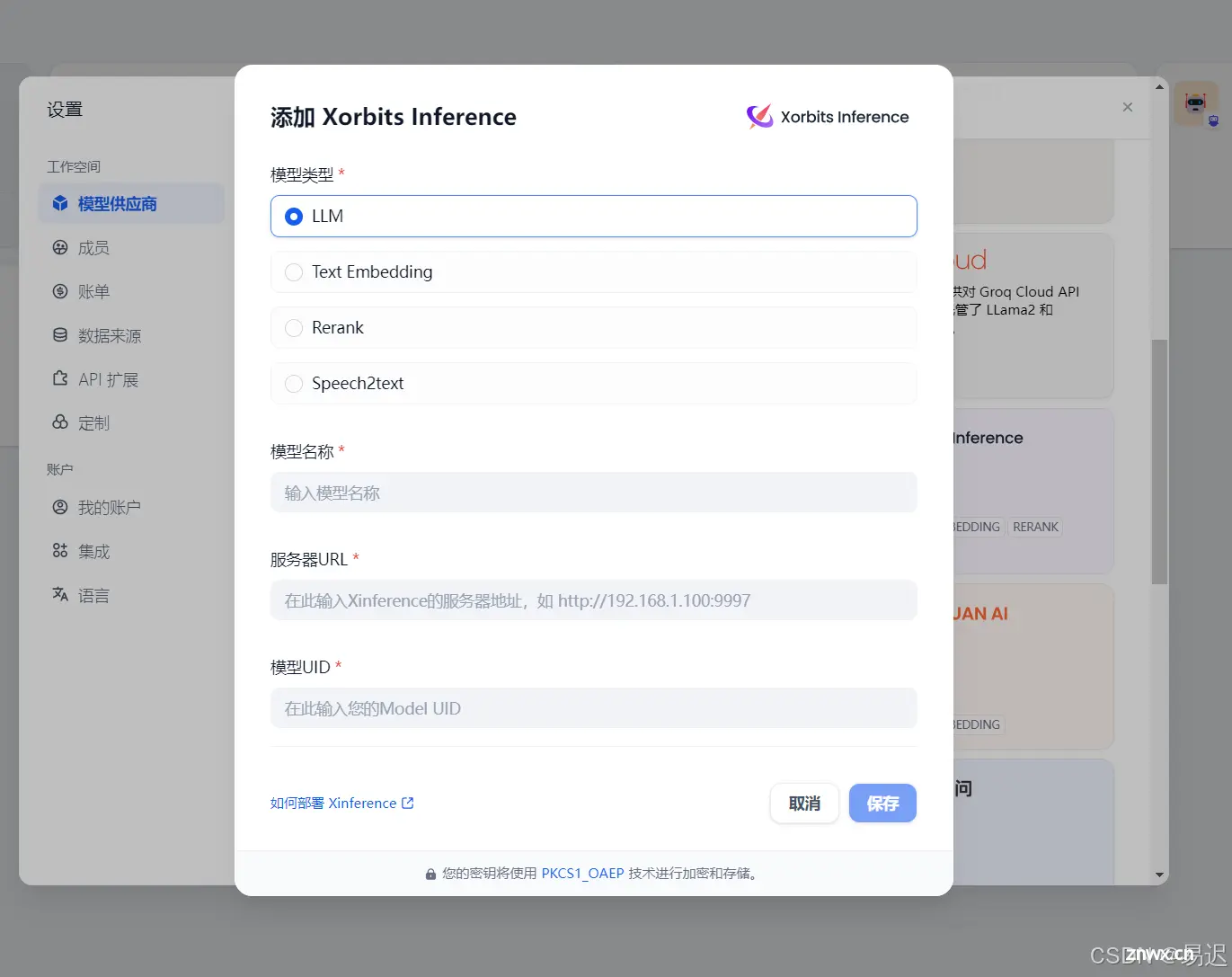

在前一篇文章RAG项目对比之后,确定Dify目前最合适的RAG框架。本次就尝试在本地GPU设备上部署Dify服务。Dify是将模型的加载独立出去的,因此需要选择合适的模型加载框架。调研一番之后...

等,进一步支撑你的行动,以提升本文的帮助力。_获取openwebui的请求头...

作者:运维有术星主随着人工智能、机器学习、AI大模型技术的迅猛发展,我们对计算资源的需求也在不断攀升。特别是对于需要处理大规模数据和复杂算法的AI大模型,GPU资源的使用变得至关重要。对于运维工程师而言,...

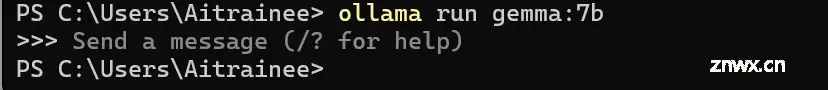

转载:KubeSphere最佳实战:探索K8sGPU资源的管理,在KubeSphere上部署AI大模型Ollama随着人工智能、机器学习、AI大模型技术的迅猛发展,我们对计算资源的需求也在不断攀...

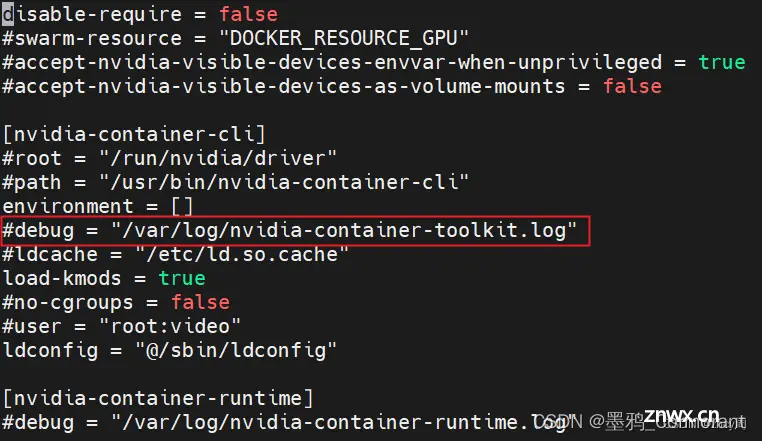

docker容器访问GPU资源使用指南_nvidia-docker...