Rolling-Unet:重振MLP对于医学图像分割高效提取长距离依赖的能力 (从零到一,用思维导图的方式让你理解Rolling-Unet)

秌枫 2024-08-26 14:31:05 阅读 78

论文链接 :Rolling-Unet: Revitalizing MLP’s Ability to Efficiently Extract Long-Distance Dependencies for Medical Image Segmentation | Proceedings of the AAAI Conference on Artificial Intelligence

https://ojs.aaai.org/index.php/AAAI/article/view/28173

Rolling-Unet详细思维导图:

https://kdocs.cn/l/cjWmQTVaTzws

https://kdocs.cn/l/cjWmQTVaTzws

由于组会讲解Unet变式,所以对Rolling-Unet学习,文章尽可能总结和更好的方式表现出Roling-UNet模型,初次涉及,有误的地方,请各位大佬指教哈。

目录一到五:都是对于原文的讲解(直接用自己开组会准备的ppt来解释)

目录六:本人对文章的解读和展示(原文看不懂不理解的可以直接看这个)

Rolling-Unet的思维导图在6.2存放

目录

一:Abstract(摘要)

二:本文的主要贡献

三:Method

3.1 R-MLP Module

3.2 OR-MLP and DOR-MLP

3.3 Lo2 Block and Feature Incentive Block

四:Experiments

五:Conclusion

六:我对Rolling-Unet的理解

6.1Rolling-Unet采用了以下策略来改进网络结构:

6.2 采用了Lo2 Block来替代这些卷积层

一:Abstract(摘要)

| Medical image segmentation methods based on deep learning network are mainly divided into CNN and Transformer. However, CNN struggles to capture long-distance dependencies, while Transformer suffers from high computational complexity and poor local feature learning. To efficiently extract and fuse local features and long-range dependencies, this paper proposes Rolling-Unet, which is a CNN model combined with MLP. Specifically, we propose the core R-MLP module, which is responsible for learning the long-distance dependency in a single direction of the whole image. By controlling and combining R-MLP modules in different directions, OR-MLP and DOR-MLP modules are formed to capture long-distance dependencies in multiple directions. Further, Lo2 block is proposed to encode both local context information and long-distance dependencies without excessive computational burden. Lo2 block has the same parameter size and computational complexity as a 3×3 convolution. The experimental results on four public datasets show that RollingUnet achieves superior performance compared to the state-ofthe-art methods. | 基于深度学习网络的医学图像分割方法主要分为CNN和Transformer。然而,CNN很难捕获长距离依赖关系,而Transformer的计算复杂度高,局部特征学习能力差。为了有效地提取和融合局部特征和远程依赖关系,本文提出了一种结合MLP的CNN模型rollling - unet。具体来说,我们提出了核心R-MLP模块,该模块负责学习整个图像在单一方向上的长距离依赖关系。通过对不同方向的R-MLP模块进行控制和组合,形成OR-MLP和DOR-MLP模块,以捕获多方向的远程依赖关系。此外,在不增加计算负担的情况下,提出了Lo2块对本地上下文信息和远程依赖关系进行编码。Lo2块具有与3×3卷积相同的参数大小和计算复杂度。在四个公共数据集上的实验结果表明,RollingUnet的性能优于当前的方法。 |

二:本文的主要贡献

(1)提出了一种新的远程依赖捕获方法,并构建了R-MLP模块。

(2)在1的基础上,构建OR-MLP和DORMLP模块,可以获得更多方向上的远程依赖关系。

(3)在2的基础上,提出Lo2区块。它同时提取本地上下文信息和远程依赖关系,而不增加计算负担。Lo2块具有与3×3卷积相同的参数和计算级别。

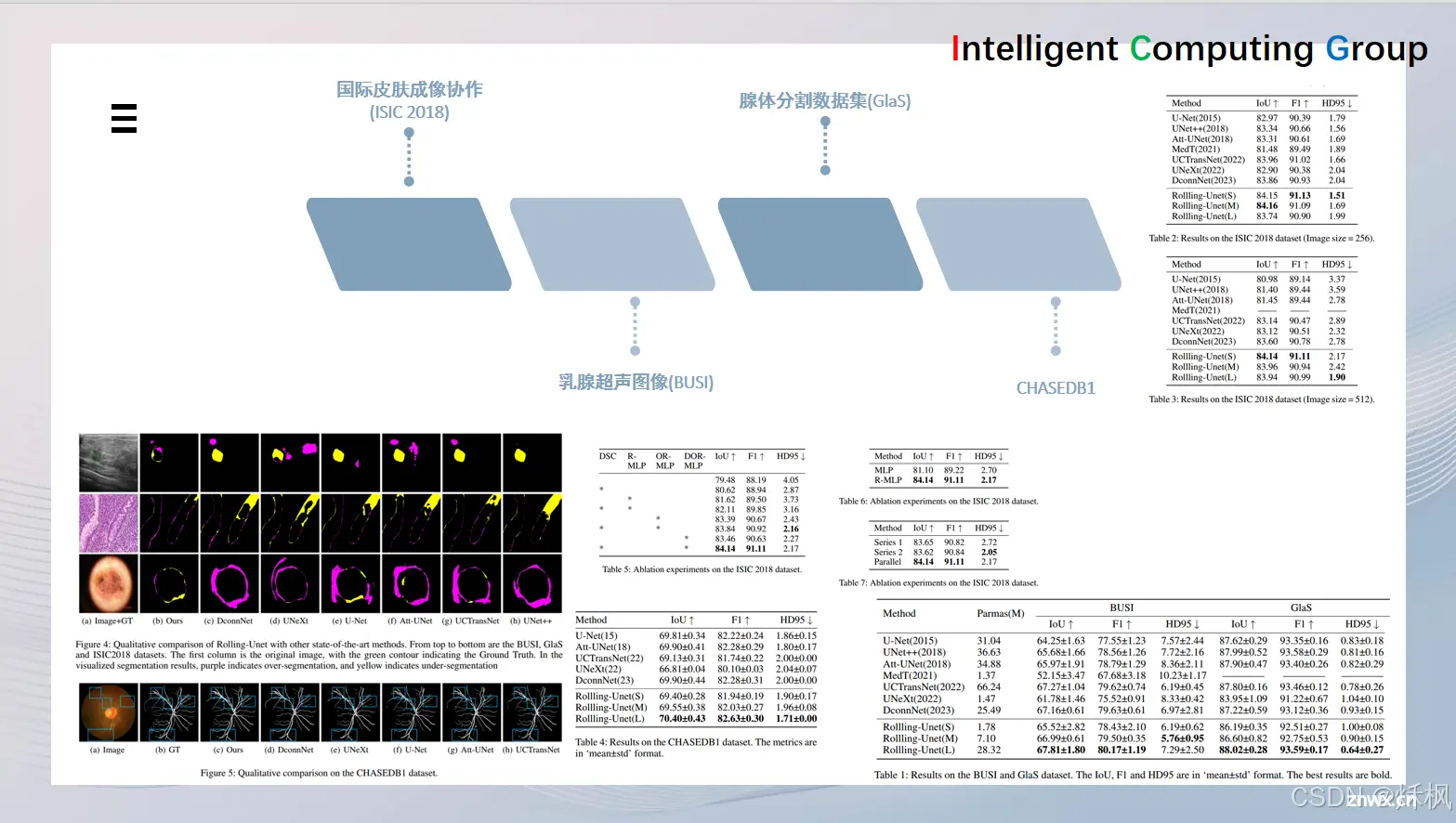

(4)在3的基础上,构建了不同参数尺度的Rolling-Unet网络。在4个数据集上,Rolling-Unet的所有尺度都超过了现有方法,充分验证了我们方法的有效性。

三:Method

3.1 R-MLP Module

3.2 OR-MLP and DOR-MLP

3.3 Lo2 Block and Feature Incentive Block

四:Experiments

五:Conclusion

六:我对Rolling-Unet的理解

6.1 Rolling-Unet采用了以下策略来改进网络结构:

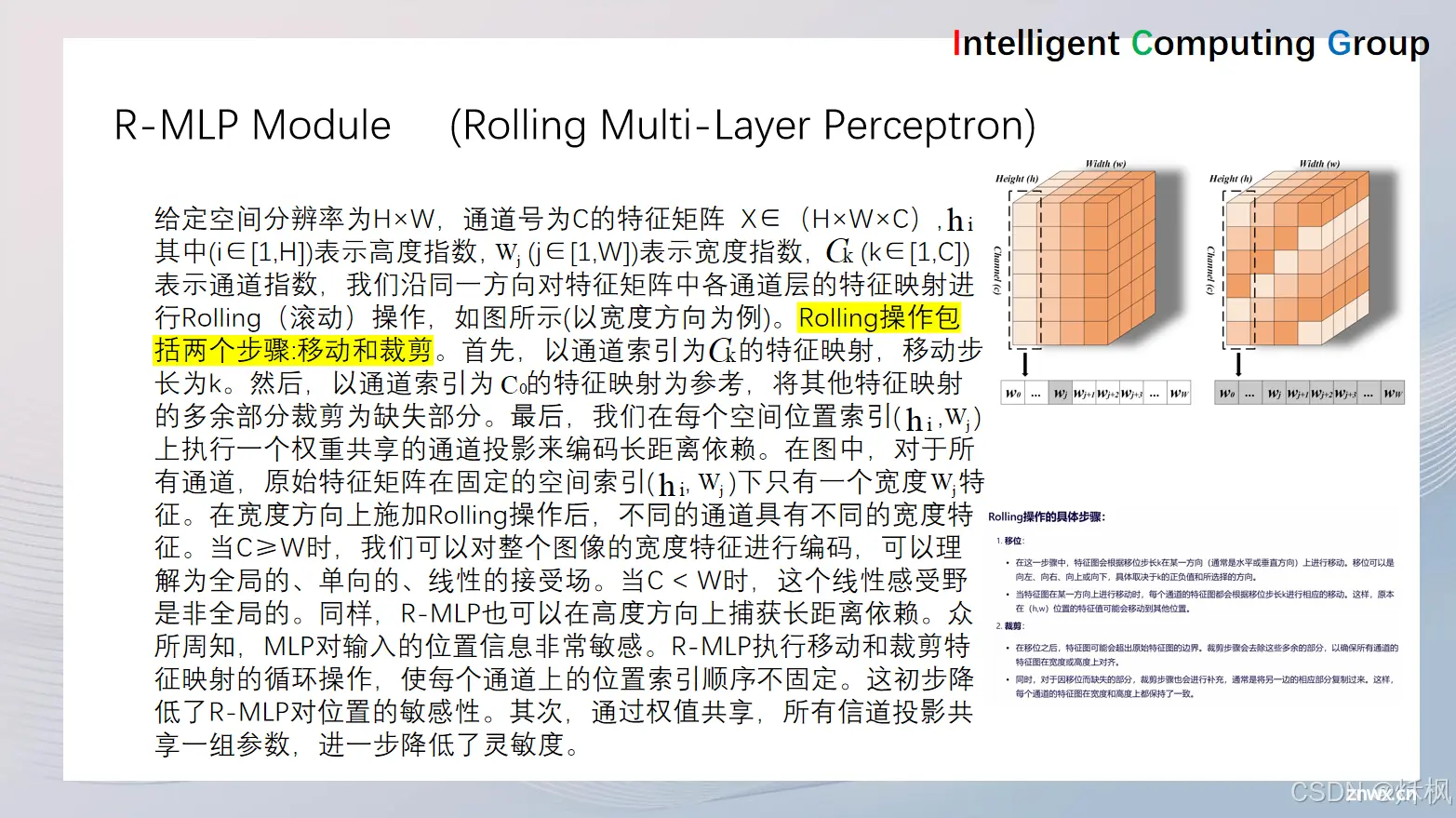

R-MLP模块:Rolling-Unet提出了R-MLP(Rolling Multi-Layer Perceptron)模块,该模块负责学习整个图像在单一方向上的长距离依赖关系。通过滚动操作(Rolling operation),R-MLP能够在不增加计算负担的情况下捕获长距离信息。

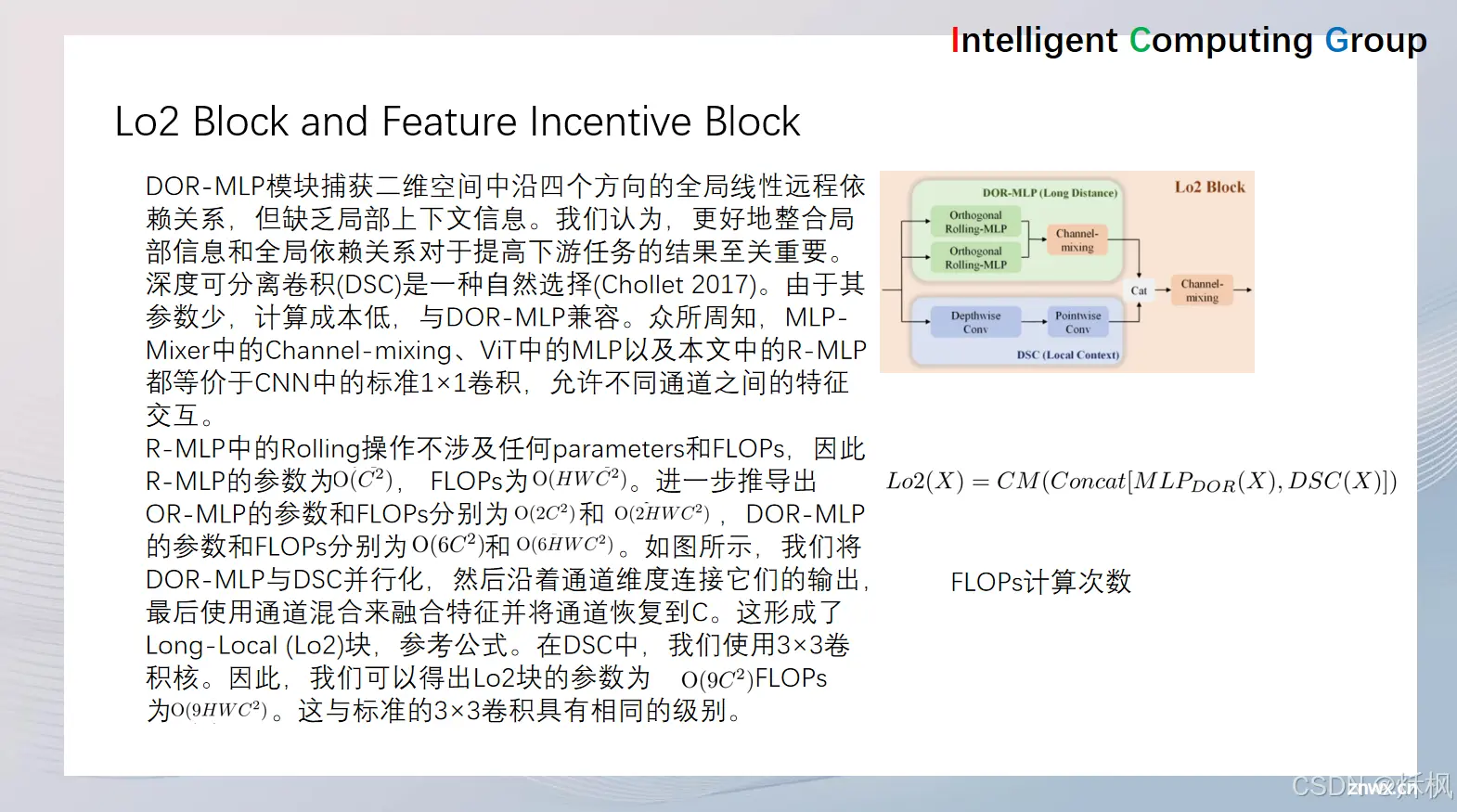

OR-MLP和DOR-MLP模块:通过对不同方向的R-MLP模块进行控制和组合,Rolling-Unet进一步构建了OR-MLP(Orthogonal Rolling MLP)和DOR-MLP(Double Orthogonal Rolling MLP)模块。这些模块能够捕获多个方向(包括水平、垂直、对角正向和对角负向)的长距离依赖关系。

Lo2 Block:为了同时提取局部上下文信息和长距离依赖关系,Rolling-Unet提出了Lo2 Block(Long-Local Block)。该模块由DOR-MLP模块和深度可分离卷积(DSC)模块并行组成,通过拼接和融合两个子模块的输出,Lo2 Block能够在不增加计算负担的情况下有效地提取和融合局部特征和长距离依赖关系。

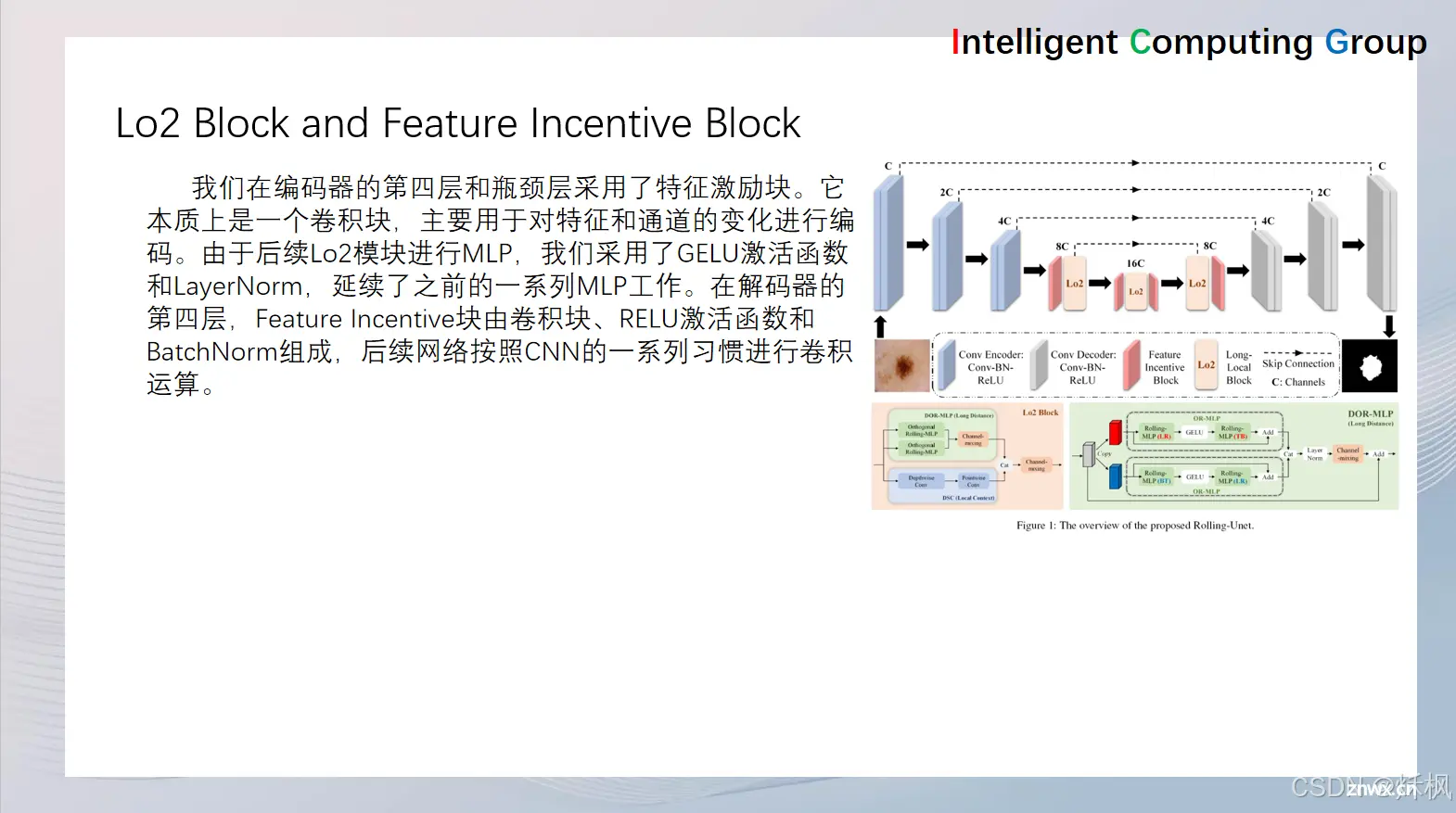

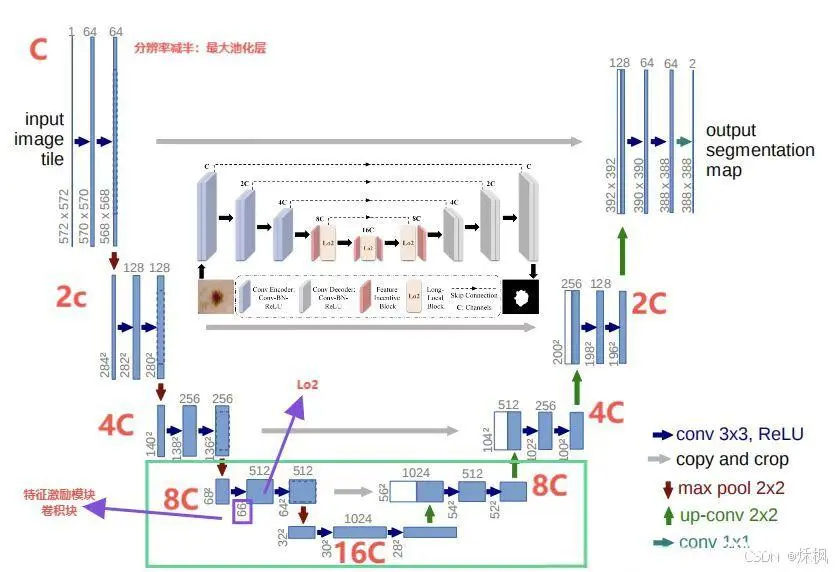

网络结构:Rolling-Unet采用了U-Net的U型框架,包括编码器、解码器、瓶颈层和跳跃连接。在编码器的第四层和瓶颈层,Rolling-Unet使用了Lo2 Block替代了原本的卷积层。这种替代使得网络能够更好地提取和融合特征,从而提升医学图像分割的性能。

Feature Incentive block(特征激励模块):在编码器的第四层和瓶颈层采用了特征激励块。它本质上是一个卷积块,主要用于对特征和通道号的变化进行编码。在解码器的第四层,Feature Incentive块由卷积块、RELU激活函数和BatchNorm组成,后续网络按照CNN的一系列习惯进行卷积运算。

Rolling-Unet对于UNet而言,就是把UNet的第四层和瓶颈进行了改善

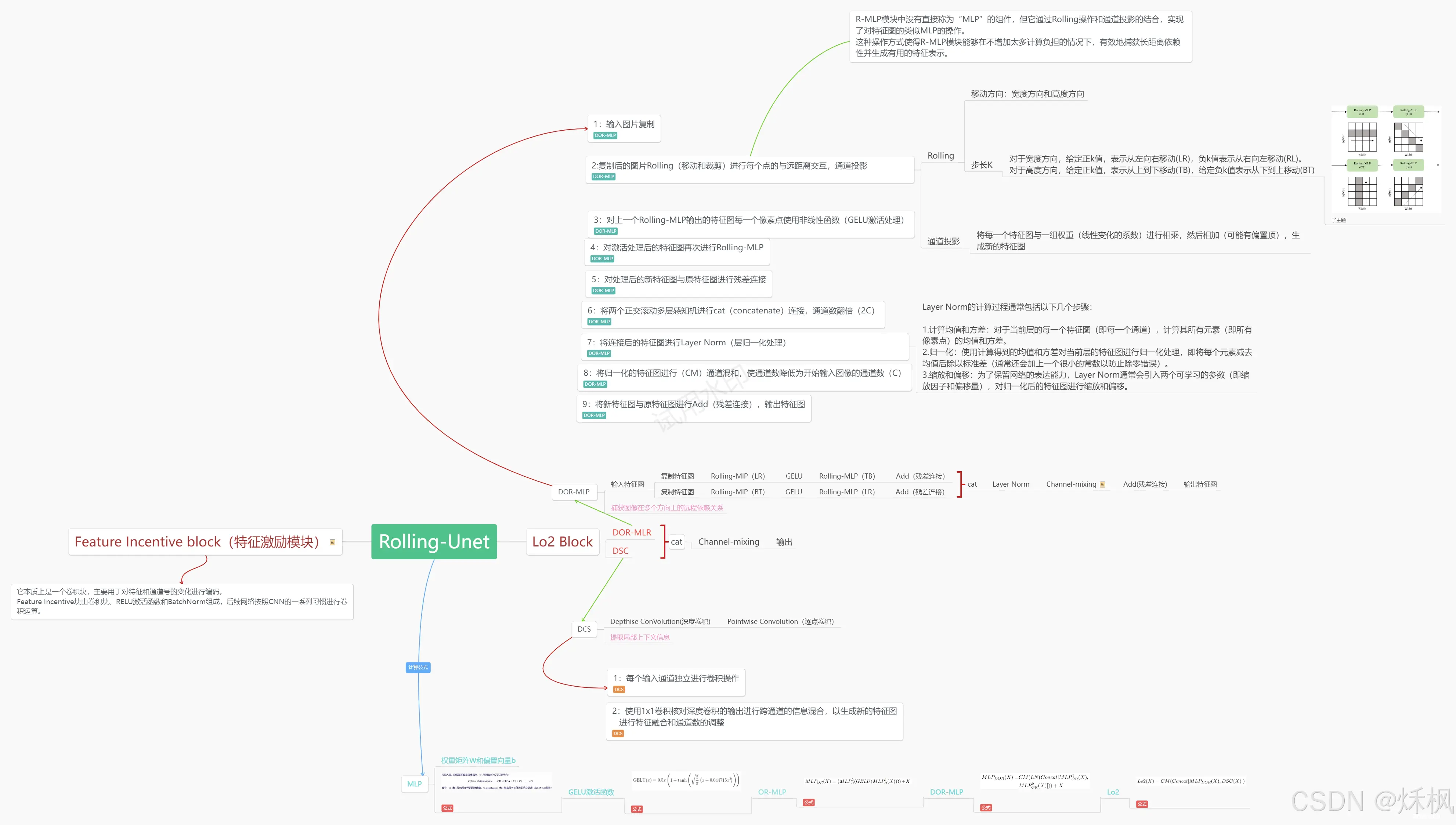

6.2 采用了Lo2 Block来替代这些卷积层

本文的重中之重来了

Rolling-Unet思维导图

【金山文档 | WPS云文档】 Rolling-Unet

https://kdocs.cn/l/cjWmQTVaTzws

图片不清,可以访问连接获取

本图主要是具体详细展示Lo2模块和其整个计算公式(细品细品再细品)

Lo2模块分为DOR-MLR和DSC

DOR-MLR:捕获图像在多个方向上的远程依赖关系

DSC:提取局部上下文信息

图片中含有详细讲解,我就不多在此提及了

文章到这里就解读结束了,文章中的语言可能存在不严谨不准确的地方,尽可能使用简单的语言把问题描述出来,初次涉及,有误的地方,请各位大佬指教哈。

上一篇: 【Datawhale AI夏令营第三期逻辑推理方向】Task1笔记:AI大模型初体验,跑通 baseline

下一篇: 深入理解变分图自编码器(VGAE):原理、特点、作用及实现

本文标签

用思维导图的方式让你理解Rolling-Unet) Rolling-Unet:重振MLP对于医学图像分割高效提取长距离依赖的能力 (从零到一

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。