深入理解变分图自编码器(VGAE):原理、特点、作用及实现

专业发呆业余科研 2024-08-26 14:31:23 阅读 52

图神经网络(Graph Neural Networks, GNNs)在处理图结构数据方面展现出强大的能力。其中,变分图自编码器(Variational Graph Auto-Encoder, VGAE)是一种无监督学习模型,广泛用于图嵌入和图聚类任务。本文将深入探讨VGAE的原理、特点、作用及其具体实现。

原理

VGAE结合了图自编码器(Graph Auto-Encoder, GAE)和变分自编码器(Variational Auto-Encoder, VAE)的思想,能够有效地学习图结构数据的节点嵌入。其核心思想是通过变分推理方法,在低维潜在空间中表示节点,从而能够重构图结构。VGAE的主要组成部分包括:

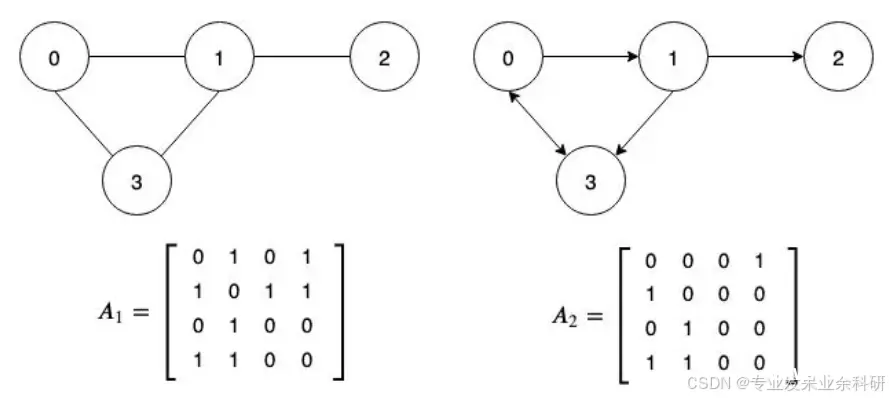

编码器(Encoder):使用图卷积网络(GCN)将输入特征编码为潜在变量的均值和方差。变分推理部分(Variational Inference):通过重参数化技巧从均值和方差中采样潜在变量。解码器(Decoder):通过内积操作重构邻接矩阵,从潜在变量中恢复图结构。

特点

无监督学习:VGAE无需标签信息,可以通过图结构数据自动学习节点表示。变分推理:通过引入变分推理,VGAE能够有效处理数据中的不确定性。图结构重构:通过重构邻接矩阵,VGAE在捕捉图结构信息方面表现出色。

作用

图嵌入:VGAE能够将高维的节点特征映射到低维的潜在空间,生成节点的嵌入表示。图聚类:通过学习到的节点嵌入,可以应用聚类算法进行节点聚类。图结构重构:通过重构邻接矩阵,可以用于图补全和图生成任务。

实现

下面是一个使用PyTorch和PyTorch Geometric库实现VGAE的具体示例。我们将以Cora数据集为例,展示如何构建和训练VGAE模型。

import torch

import torch.nn.functional as F

from torch_geometric.nn import GCNConv, VGAE

from torch_geometric.datasets import Planetoid

from torch_geometric.utils import train_test_split_edges

# 加载Cora数据集

dataset = Planetoid(root='/tmp/Cora', name='Cora')code>

data = dataset[0]

class GCNEncoder(torch.nn.Module):

def __init__(self, in_channels, out_channels):

super(GCNEncoder, self).__init__()

self.conv1 = GCNConv(in_channels, 2 * out_channels)

self.conv2 = GCNConv(2 * out_channels, 2 * out_channels)

self.conv_mu = GCNConv(2 * out_channels, out_channels)

self.conv_logvar = GCNConv(2 * out_channels, out_channels)

def forward(self, x, edge_index):

x = F.relu(self.conv1(x, edge_index))

x = F.relu(self.conv2(x, edge_index))

return self.conv_mu(x, edge_index), self.conv_logvar(x, edge_index)

# 初始化模型

channels = 16

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

model = VGAE(GCNEncoder(dataset.num_features, channels)).to(device)

data = train_test_split_edges(data).to(device)

optimizer = torch.optim.Adam(model.parameters(), lr=0.01)

def train():

model.train()

optimizer.zero_grad()

z = model.encode(data.x, data.train_pos_edge_index)

loss = model.recon_loss(z, data.train_pos_edge_index)

loss = loss + (1 / data.num_nodes) * model.kl_loss()

loss.backward()

optimizer.step()

return loss.item()

for epoch in range(1, 201):

loss = train()

print(f'Epoch: {epoch:03d}, Loss: {loss:.4f}')

model.eval()

with torch.no_grad():

z = model.encode(data.x, data.train_pos_edge_index)

auc, ap = model.test(z, data.test_pos_edge_index, data.test_neg_edge_index)

print(f'AUC: {auc:.4f}, AP: {ap:.4f}')

细节

从输入变量的维度变化角度来看:

输入层:

节点特征矩阵 X:维度 N×F邻接矩阵 A:维度 N×N

编码器:

第一层GCN卷积层:输入维度 N×F,输出维度 N×2C第二层GCN卷积层:输入维度 N×2C,输出维度 N×2C均值和方差GCN层:输入维度 N×2C,输出维度 N×C

变分推理部分:

生成节点嵌入 Z:维度 N×C

解码器:

重构的邻接矩阵 A^:维度 N×N

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。