编程初学者入门训练1~20题...

我们打开output文件夹,这里面的所有文件都是你刚刚保存的模型,后面的数字就是不同步数下保存的模型。然后save_steps的意思是模型多少步会保存一次的意思,这里我输入的是50也就是说,模型每50步的时候,...

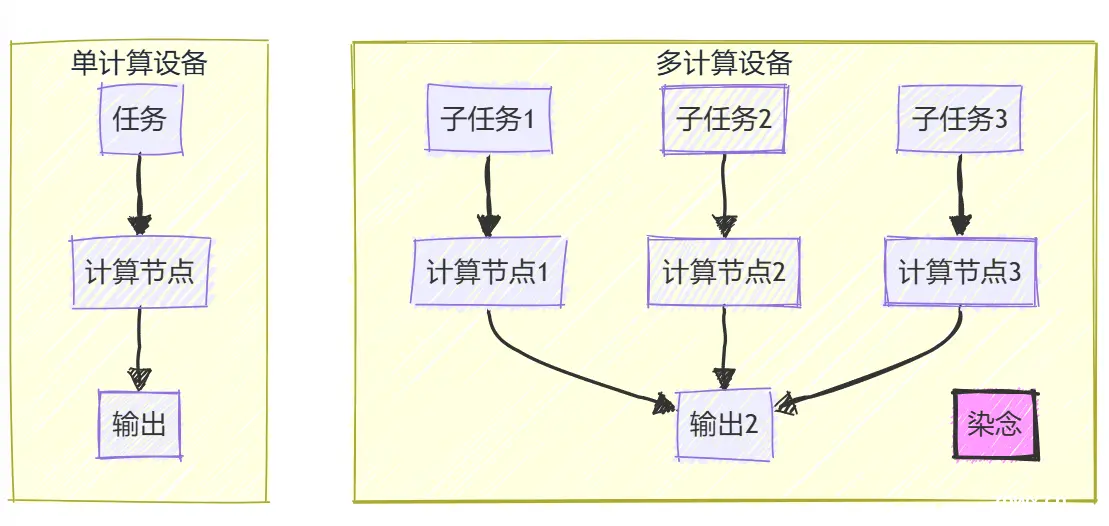

首先想要说明的是,并行训练和分布式训练的概念其实都能讲,但前者可能更侧重于技术实施,而后者更倾向于设备,网络等资源层面的分布式,在本专栏,我们都一视同仁。从个人观点来说,如果偏软件点,说并行最好了。并行训练是指将...

Gemma是Google推出的轻量级、先进的开放模型系列,采用与Gemini模型相同的研究成果和技术构建而成。它们是仅使用解码器的文本到文本大型语言模型(提供英语版本),为预训练变体和指令调整变体具有开...

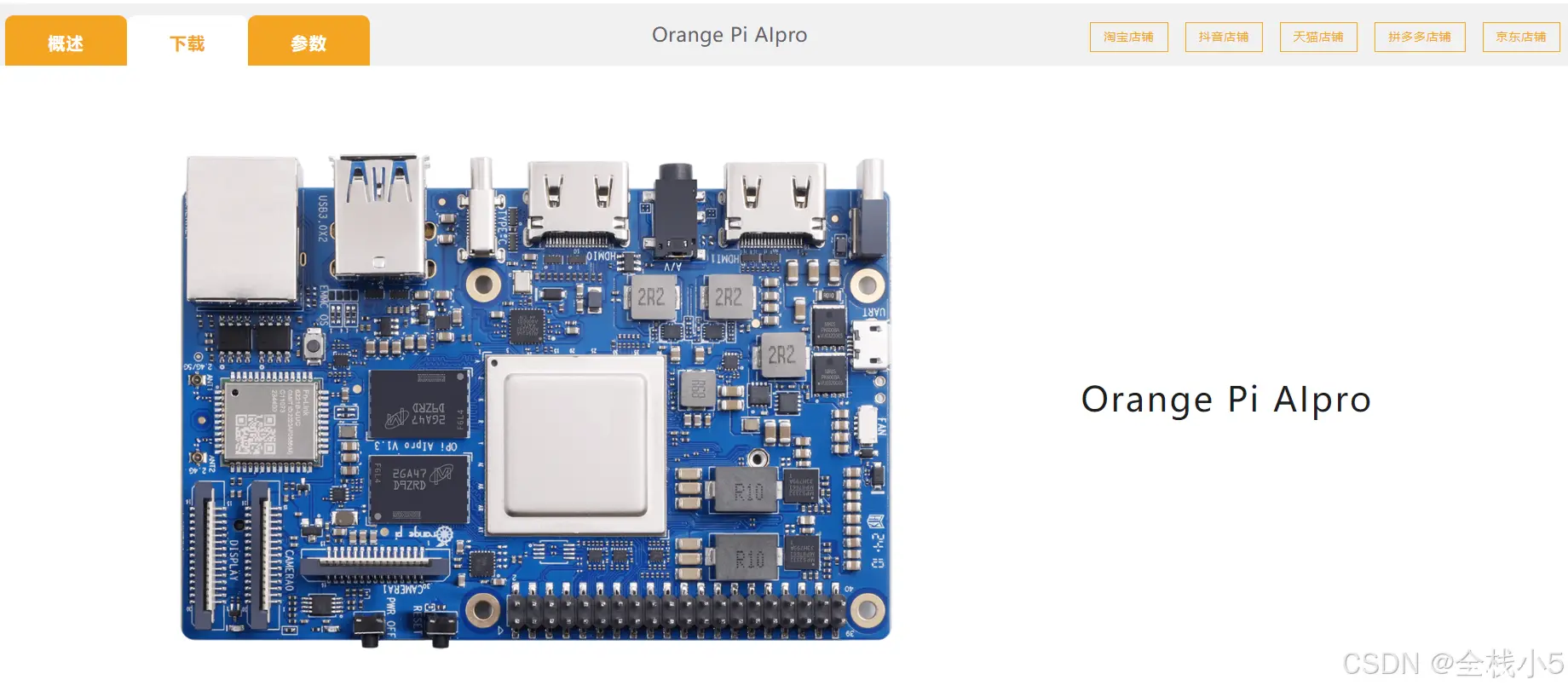

作为业界首款基于昇腾深度研发的AI开发板,OrangePiAIpro无论在外观上、性能上还是技术服务支持上都非常优秀。接口丰富,扩展能力强。支持Ubuntu、openEuler操作系统,满足大多数AI算法...

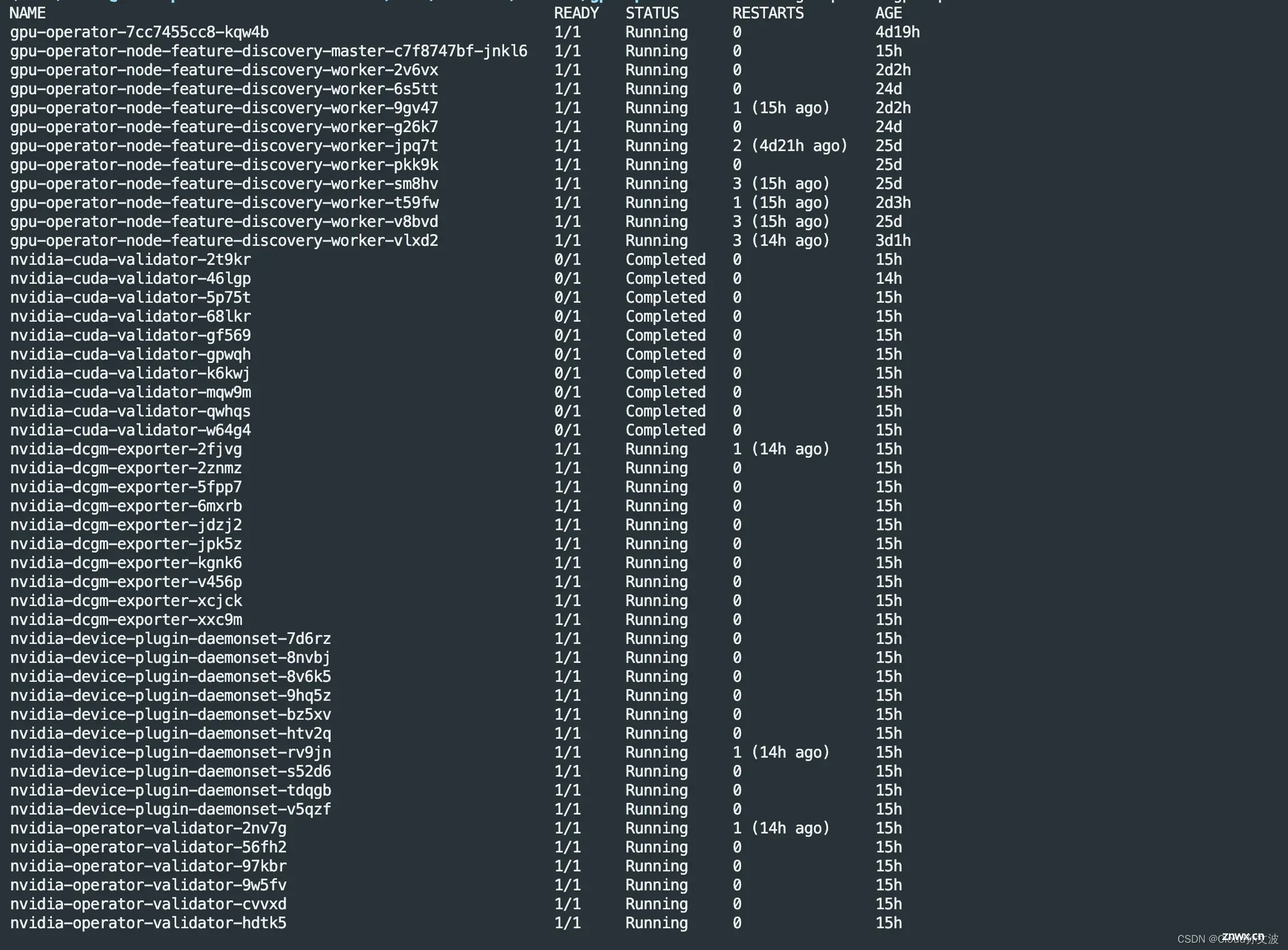

Ant系列GPU支持NvLink&NvSwitch,若您使用多GPU卡的机型,需额外安装与驱动版本对应的nvidia-fabricmanager服务使GPU卡间能够互联,否则可能无法正常使用GPU实例。【摘...

YOLOv8保姆级动手把手攻略_yolov8训练coco数据集...

在AI训练过程中,优化器不收敛(OptimizerNotConverging)是一个常见且令人头疼的问题。优化器的有效性直接影响模型的训练效果。本文将详细探讨这一问题的成因,并提供多种调整和解决方案。关键词:A...

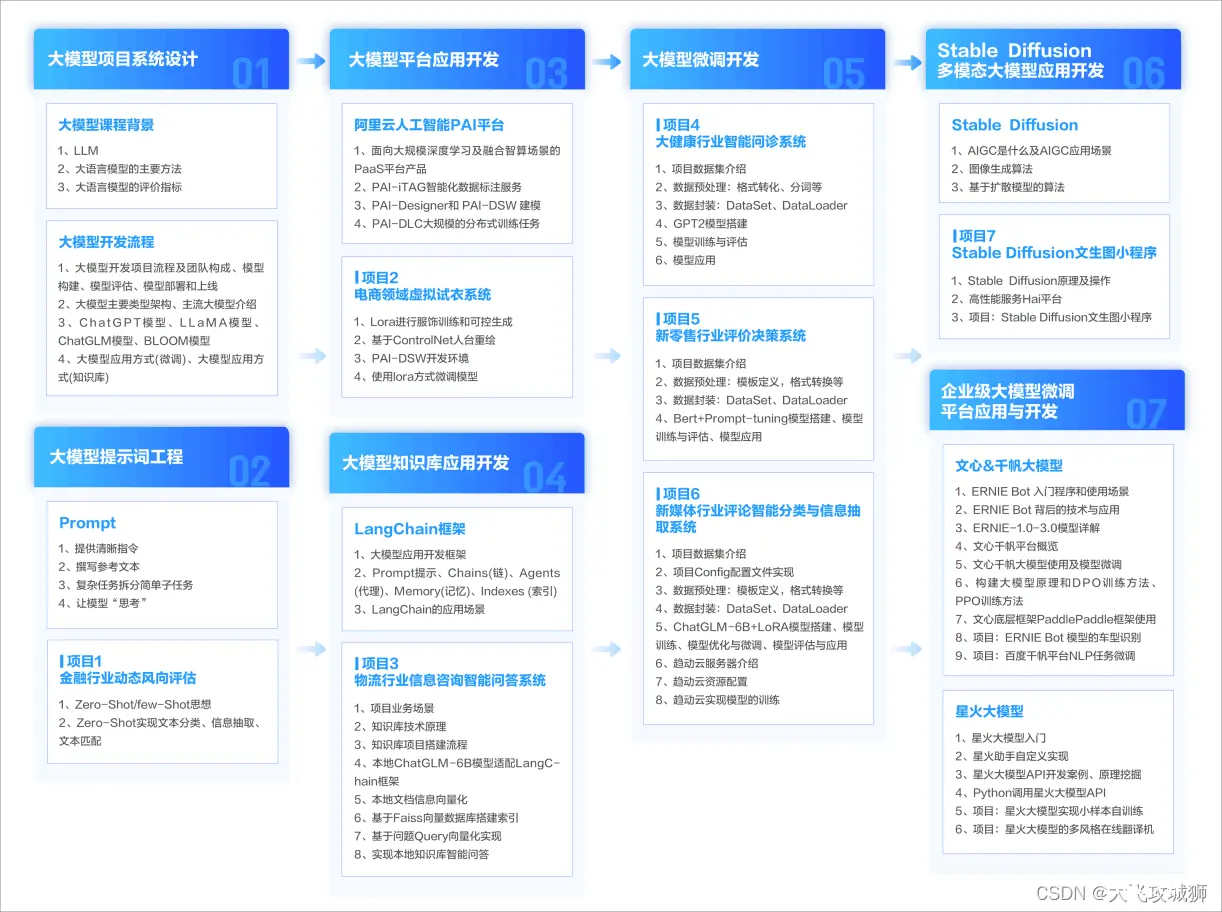

•能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力:大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。...

在HuggingFace的Transformers库中,Trainer类是一个强大的工具,用于训练和评估机器学习模型。它简化了数据加载、模型训练、评估和日志记录的过程。_transformers.trainer...