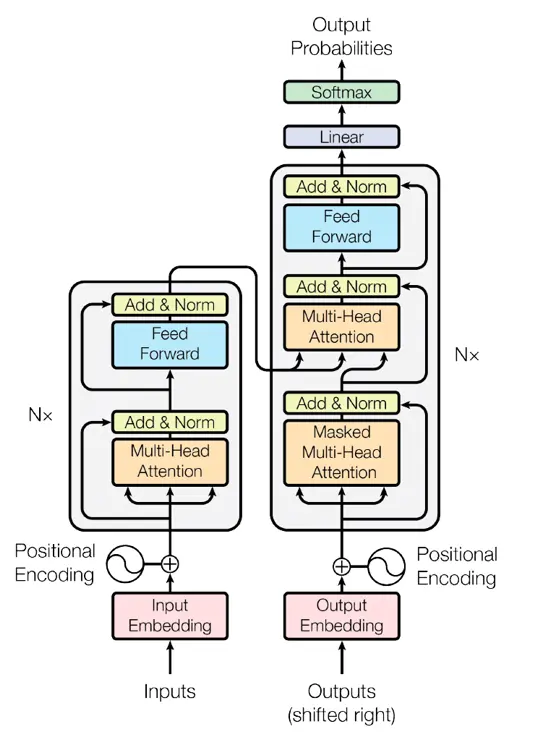

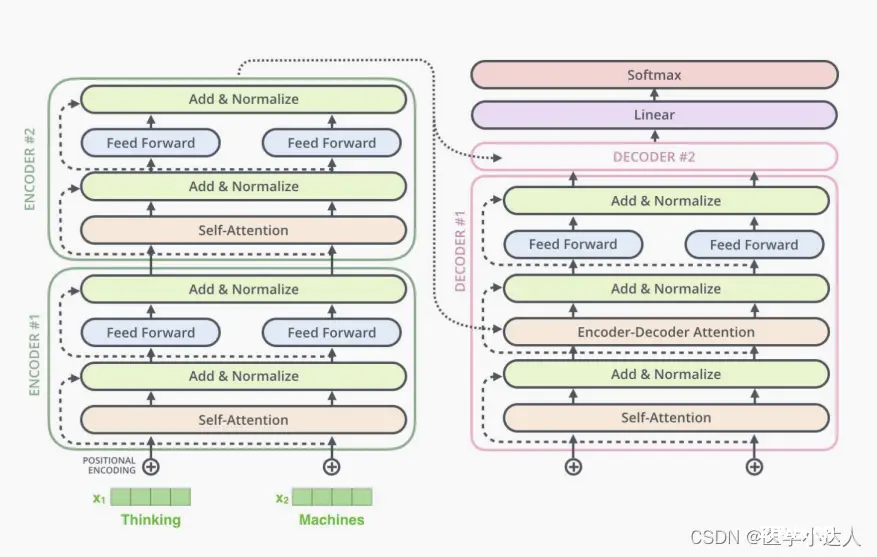

transformer结构是google在2017年的AttentionIsAllYouNeed论文中提出,在NLP的多个任务上取得了非常好的效果,可以说目前NLP发展都离不开transformer。最...

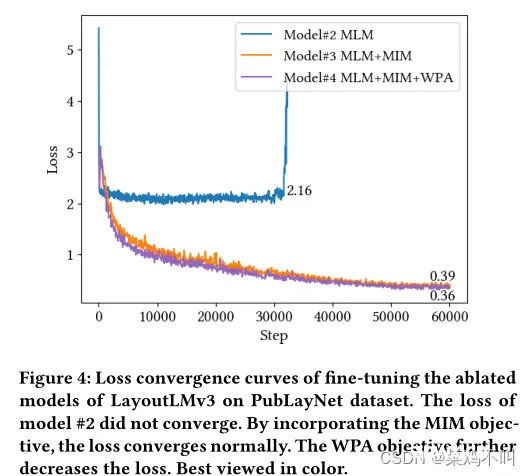

从而缓解了这个问题。比较模型#3和模型#2的结果,MIM目标有利于CORD和RVL-CDIP。由于简单地使用线性图像嵌入改进了FUNSD,因此MIM不会进一步对FUNSD做出贡献。通过在...

一篇文章弄懂Transformer+项目训练。_transformer的地位...

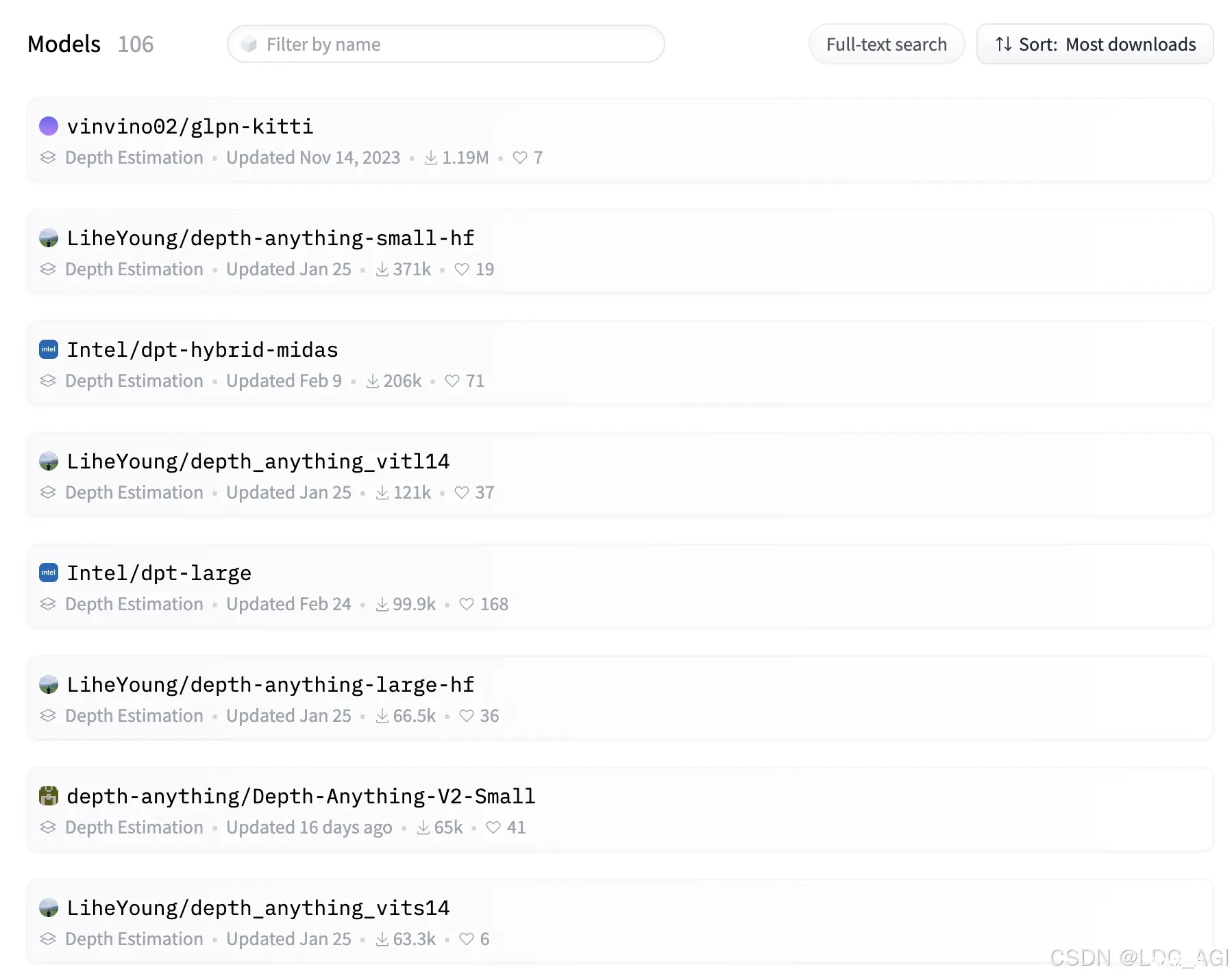

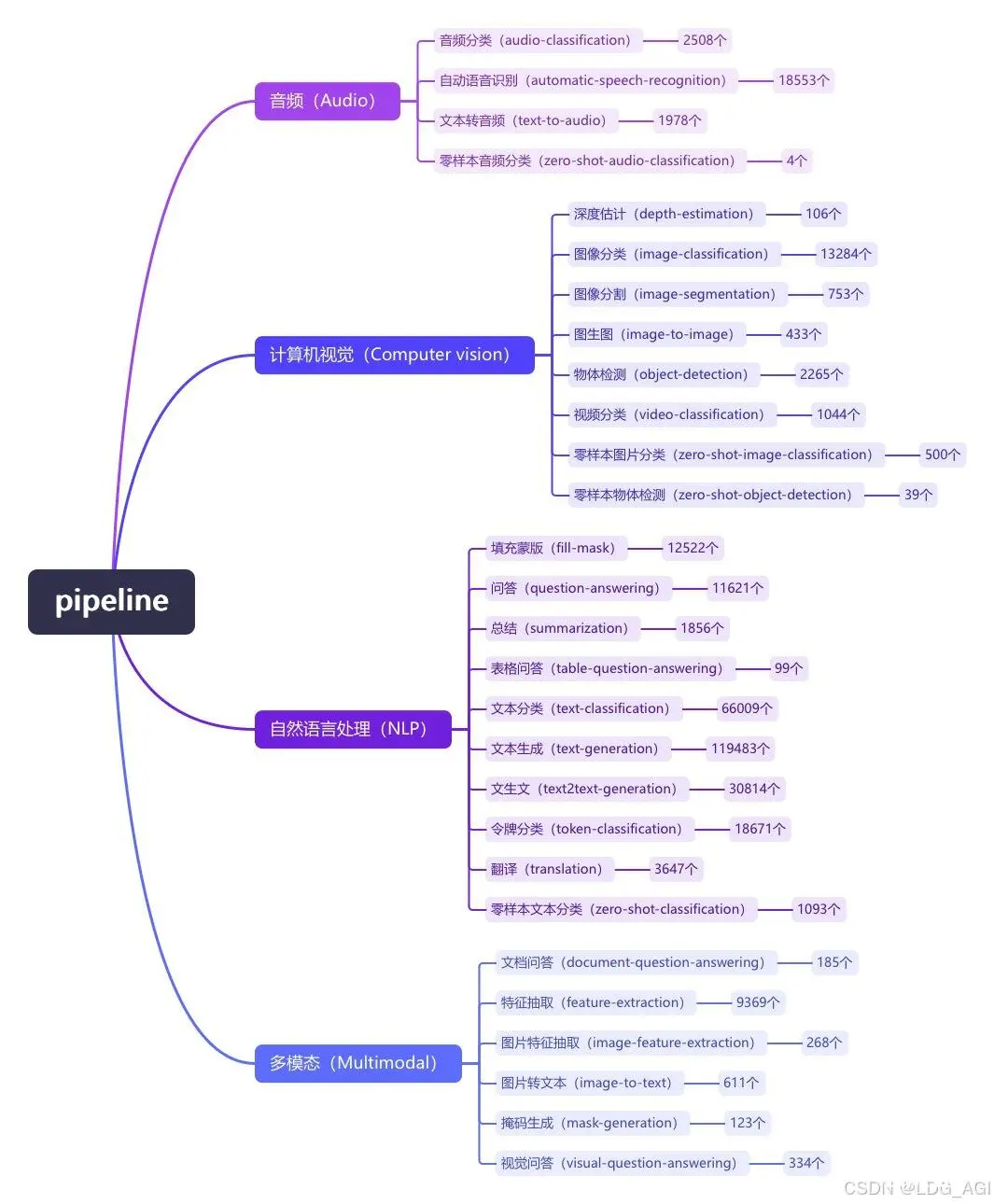

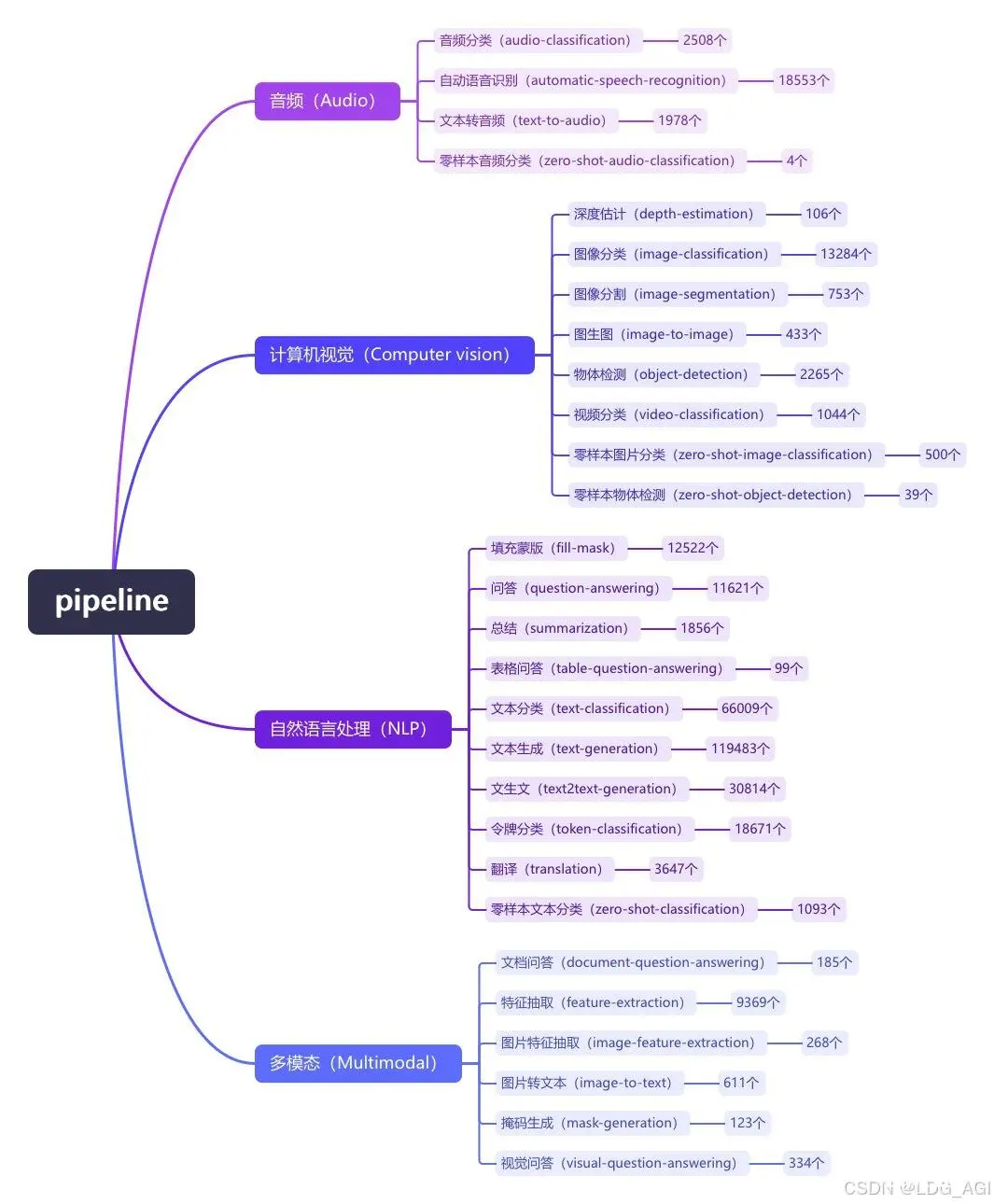

本文对transformers之pipeline的深度估计(depth-estimation)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline...

在处理“我决定明年再回去”这一小部分时,自注意力机制允许模型直接关联到“去年我去了西湖”中的“西湖”,从而建立了一个直接的联系。这是因为在计算注意力分数时,每个单词的表示(查询)会与所有其他单词的表示(键)进行比较,从而直接捕捉到它们之间...

本文对transformers之pipeline的零样本音频分类(zero-shot-audio-classification)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,...

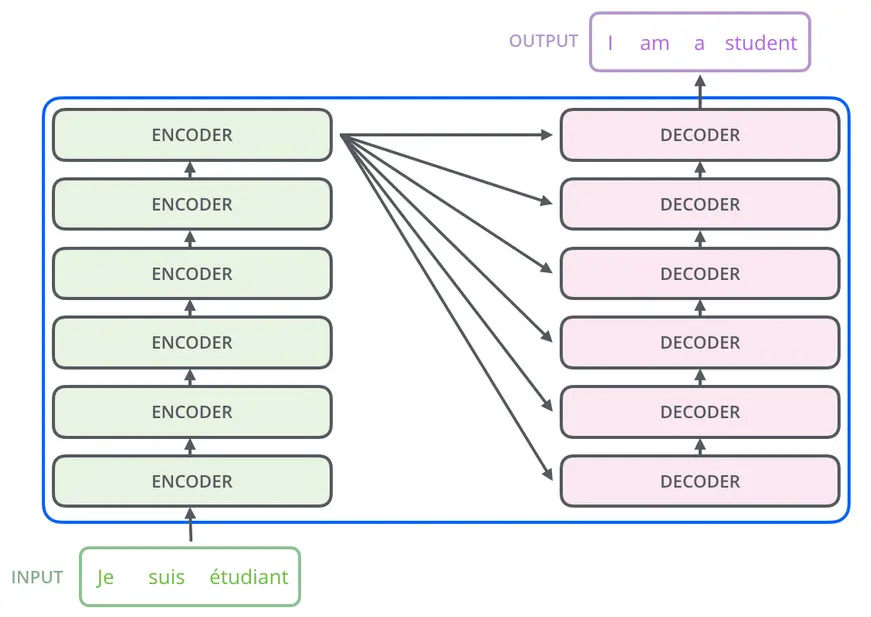

1AI的转换器是啥?转换器,一种将输入序列转换或更改为输出序列的神经网络架构。它们通过学习上下文和跟踪序列组件之间的关系来做到这一点。例如,请考虑以下输入序列:“天空是什么颜色的?”转换器模型会使用内部数学表示法来识别颜色、天空和蓝色这三个词之间的相关性...

本文对transformers之pipeline的文本生成语音(text-to-audio/text-to-speech)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,...

Python用pytorch从头写transformer源码,一行一解释;机器翻译实例代码;超详细实现Transformer代码;transformer源码解读_pytorchtransformer...

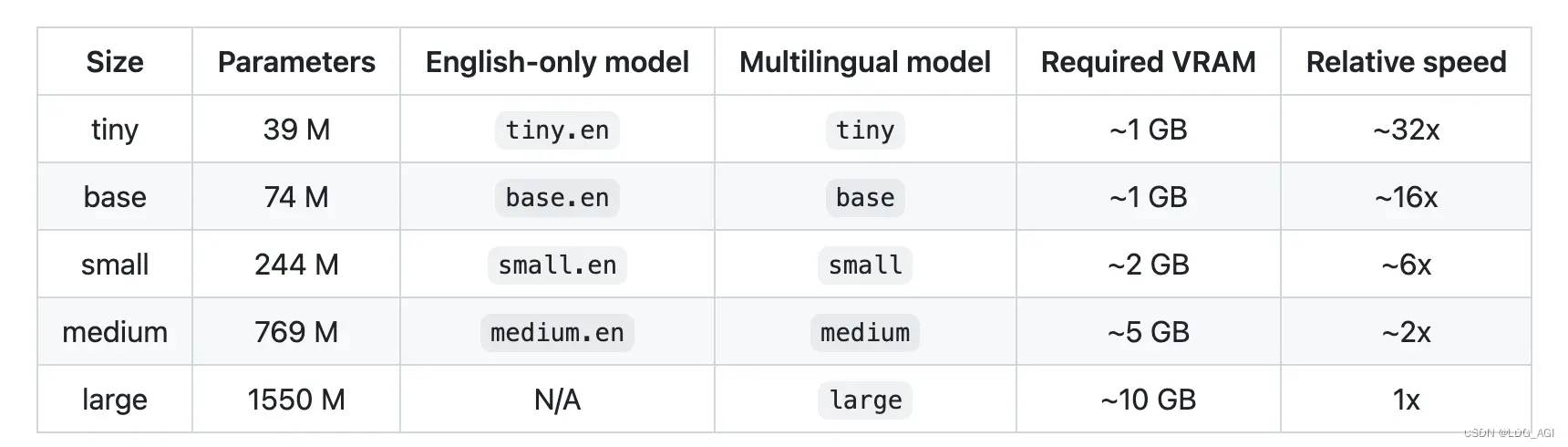

本文对transformers之pipeline的自动语音识别(automatic-speech-recognition)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,...