自此,不管是学术界,还是工业界均掀起了基于Transformer的预训练模型研究和应用的热潮,并且逐渐从NLP领域延伸到CV、语音等多项领域。Transformer模型是一个具有里程碑意义的模型,它的提出催生了众...

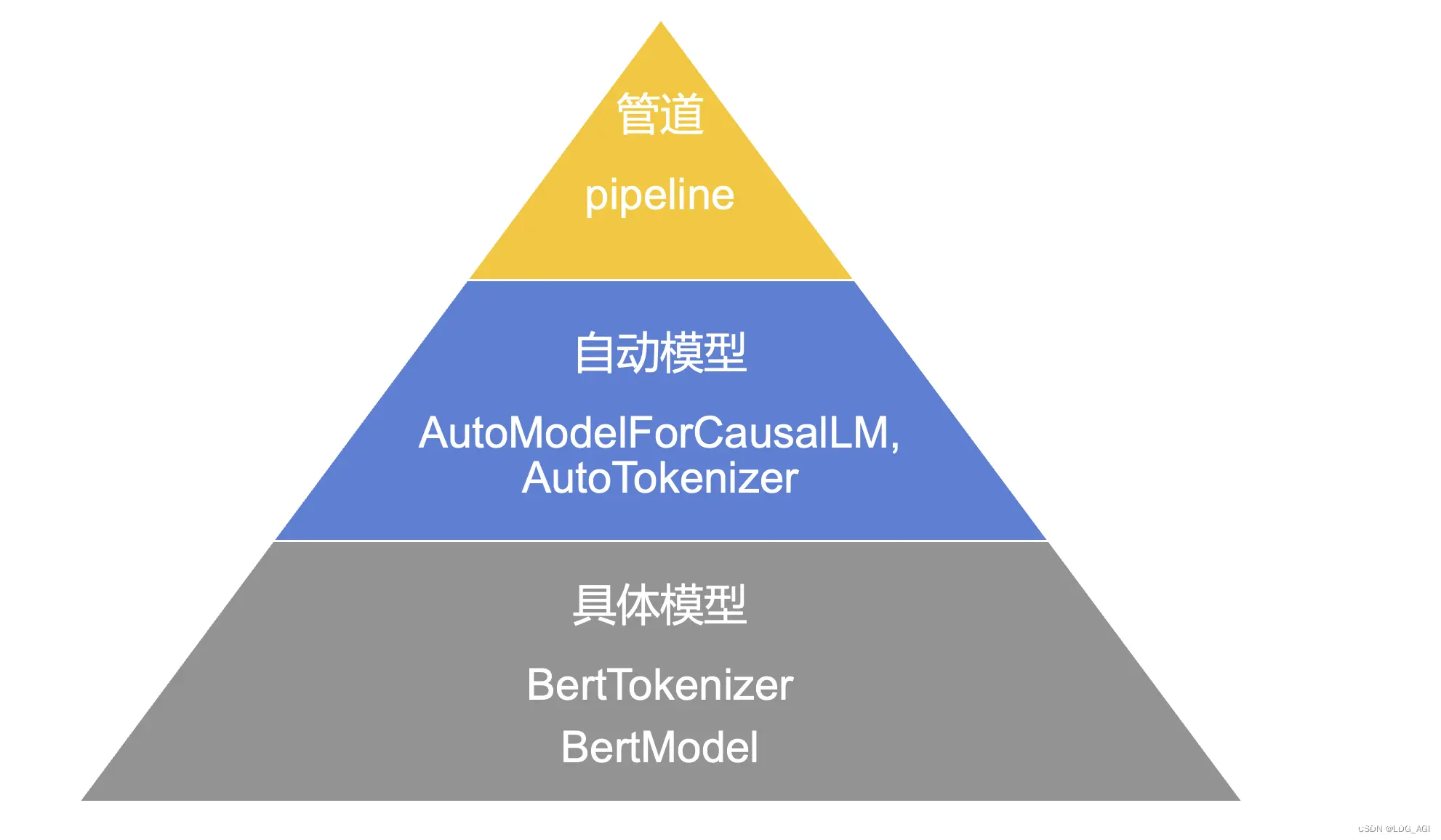

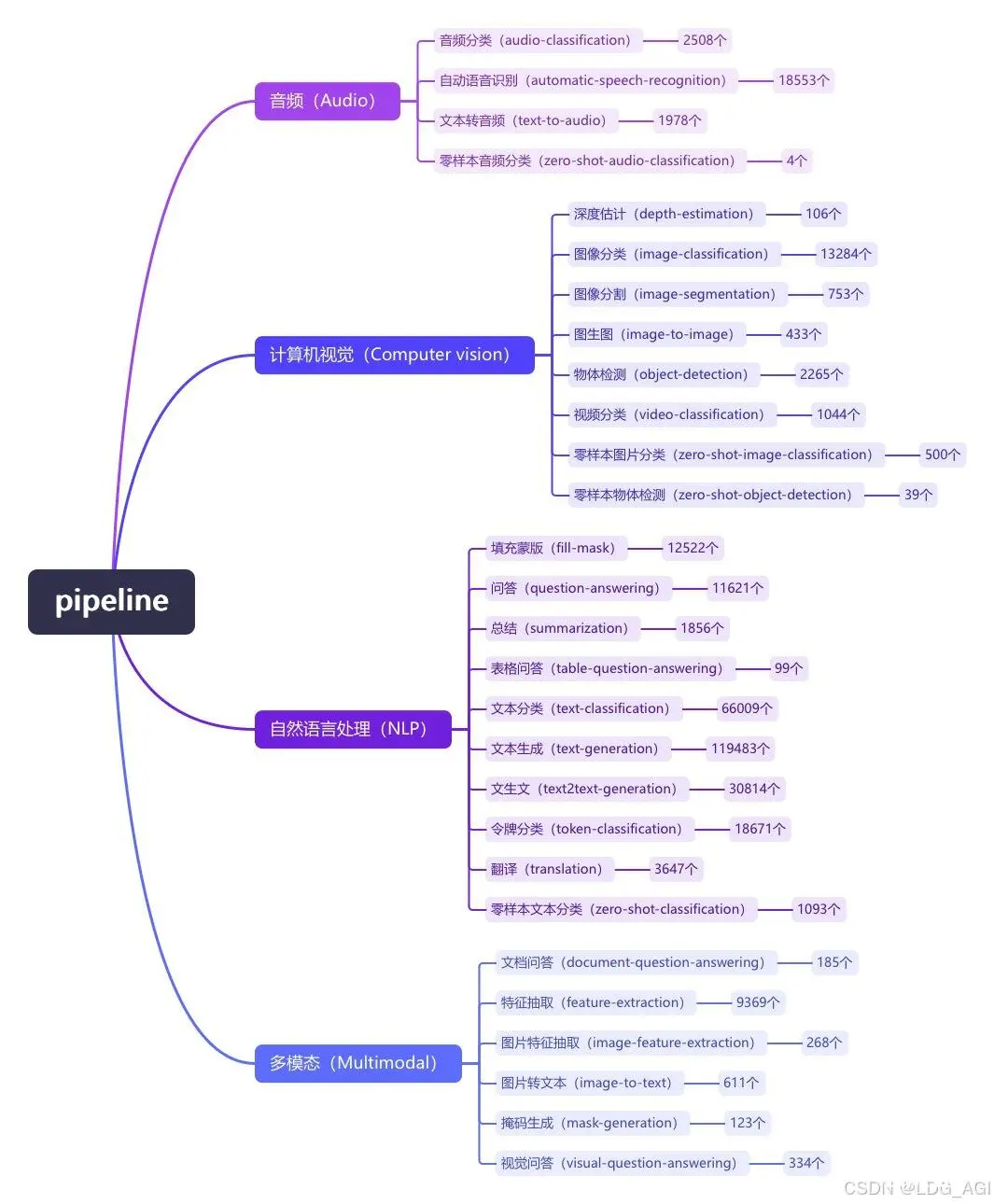

Transformers包括管道pipeline、自动模型auto以及具体模型三种模型实例化方法,如果同时有配套的分词工具(Tokenizer),需要使用同名调度。在上述三种应用方式中:管道方式使用最简单,但灵活...

在WebGL中,`WebGLUniformLocation`是一个表示着色器中统一变量(uniformvariable)位置的对象。统一变量是在着色器之间共享的数据,它们在渲染过程中由应用程序设置,而不是由...

本文对transformers之pipeline的填充蒙版(fill-mask)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline使用文中的2行代码极...

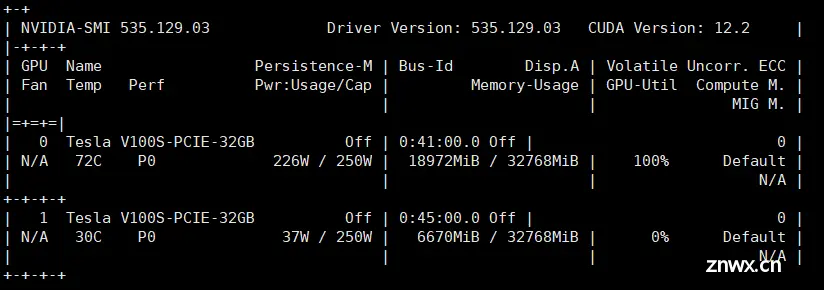

HuggingFace的库支持自动模型(AutoModel)的模型实例化方法,来自动载入并使用GPT、ChatGLM等模型。在方法中的device_map参数,可实现单机多卡推理。_transformer多卡推理...

文章讲述了在遇到问题时,由于apt库未更新,作者提供了使用`sudoapt-getupdate`和`sudoapt-getupgrade`命令进行更新,然后安装Docker和DockerCompose的解决方案。...

在本文中,作者引入了MambaVision,这是首个专门为视觉应用设计的Mamba-Transformer混合骨架。作者提出了重新设计Mamba公式的方法,以增强全局上下文表示的学习能力,并进行了混合设计集成模式...

Python的logging库是标准库的一部分,旨在为应用程序提供灵活的日志记录功能。它可以轻松地记录不同级别的日志信息,并可以将日志信息输出到不同的目标,比如控制台、文件、远程服务器等。logging库非常适合...

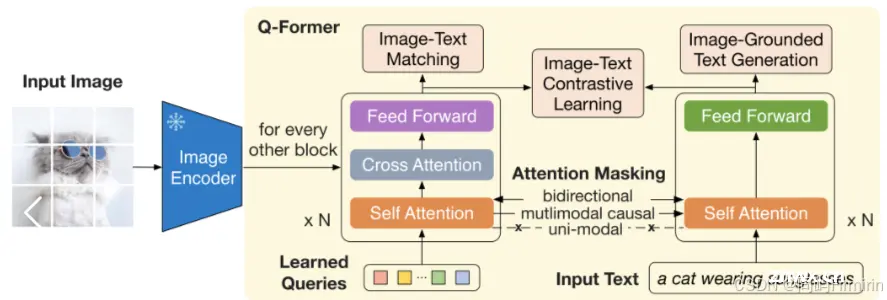

面试中遇到的问题,自己在实践中注意到了却没有深究原因,没有回答好,特此记录和探讨这个问题。多模态大模型中需要一个输入投影模块,将视觉特征投射到LLM能理解的语言特征维度,这里就可以选择各种不同的模块。LLaVA最初...

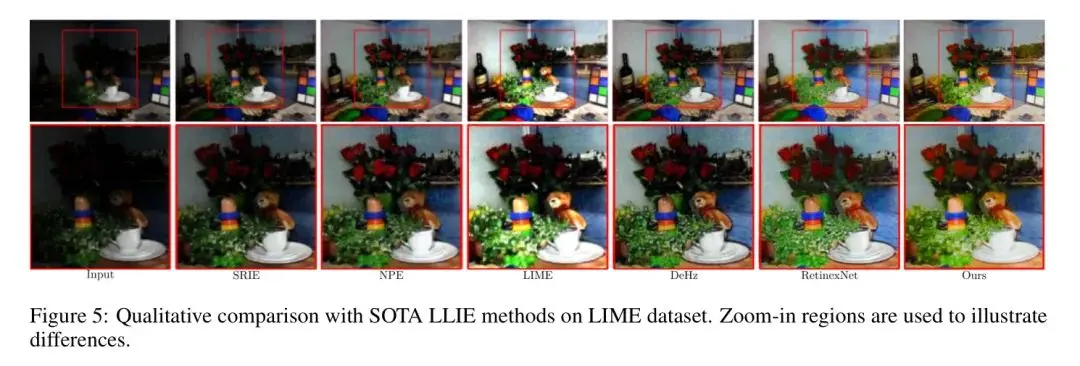

低光照图像增强(LLIE)是计算机视觉(CV)领域的一个重要且具有挑战性的任务。在低光照条件下捕获图像会显著降低其质量,导致细节和对比度的丧失。这种退化不仅会导致主观上不愉快的视觉体验,还会影响许多CV系统的性能。L...