TensorFlow是一个采用数据流图(dataflowgraphs),用于数值计算的开源软件库。TensorFlow最初由Google大脑小组(隶属于Google机器智能研究机构)的研究员和工程师们开...

MXNet在一些大规模的深度学习应用中得到了广泛的应用,特别是在AWS平台上,MXNet是官方推荐的深度学习框架之一,得到了大量的优化和支持。丰富的生态系统:TensorFlow拥有丰富的工具和库,如...

AIEdgeTorch-PyTorch模型转换为TensorFlowLite模型(.tflite)_aiedgetorch...

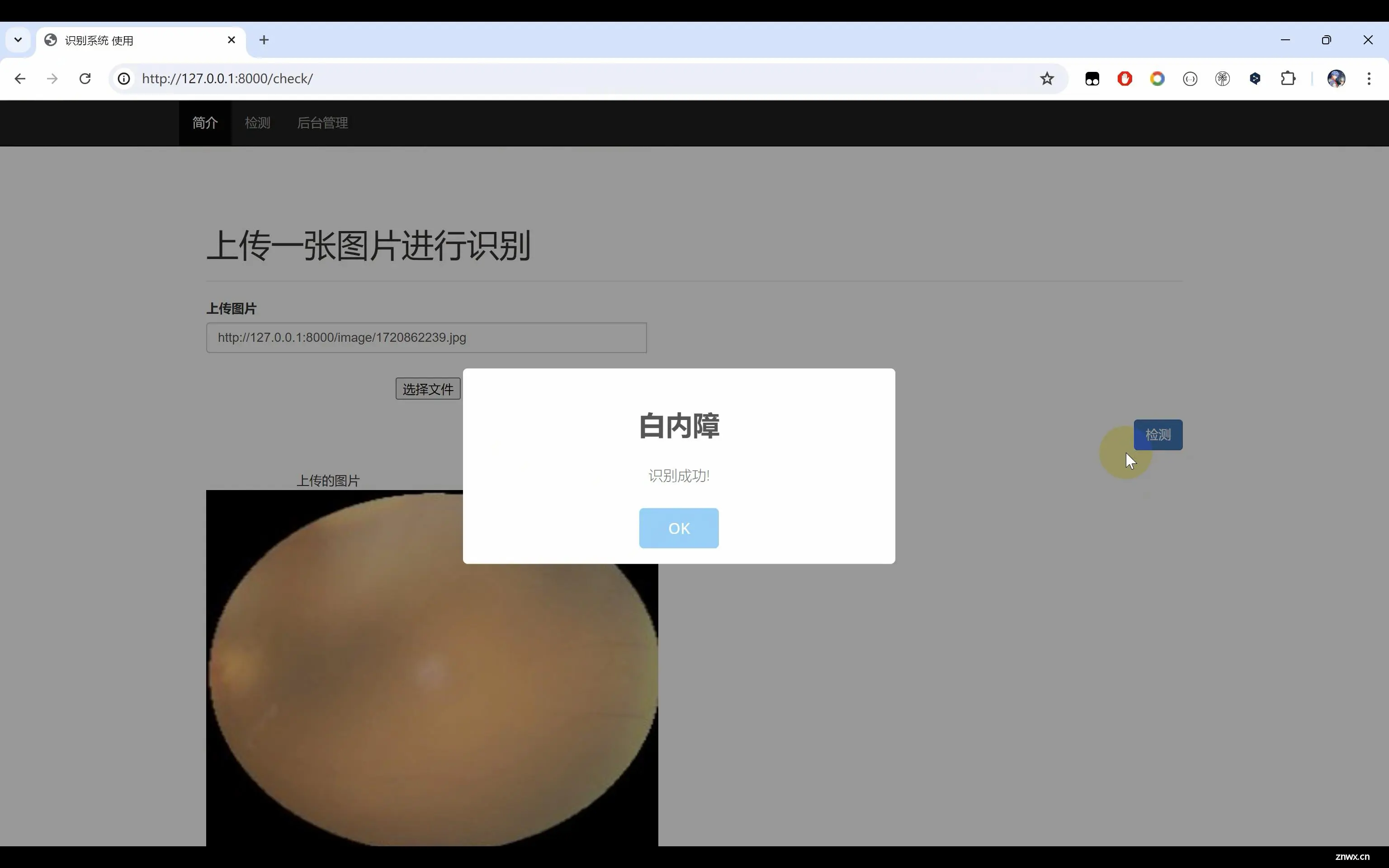

眼疾识别系统,使用Python作为主要编程语言进行开发,基于深度学习等技术使用TensorFlow搭建ResNet50卷积神经网络算法,通过对眼疾图片4种数据集进行训练(‘白内障’,‘糖尿病性视网膜病变’,‘青光眼...

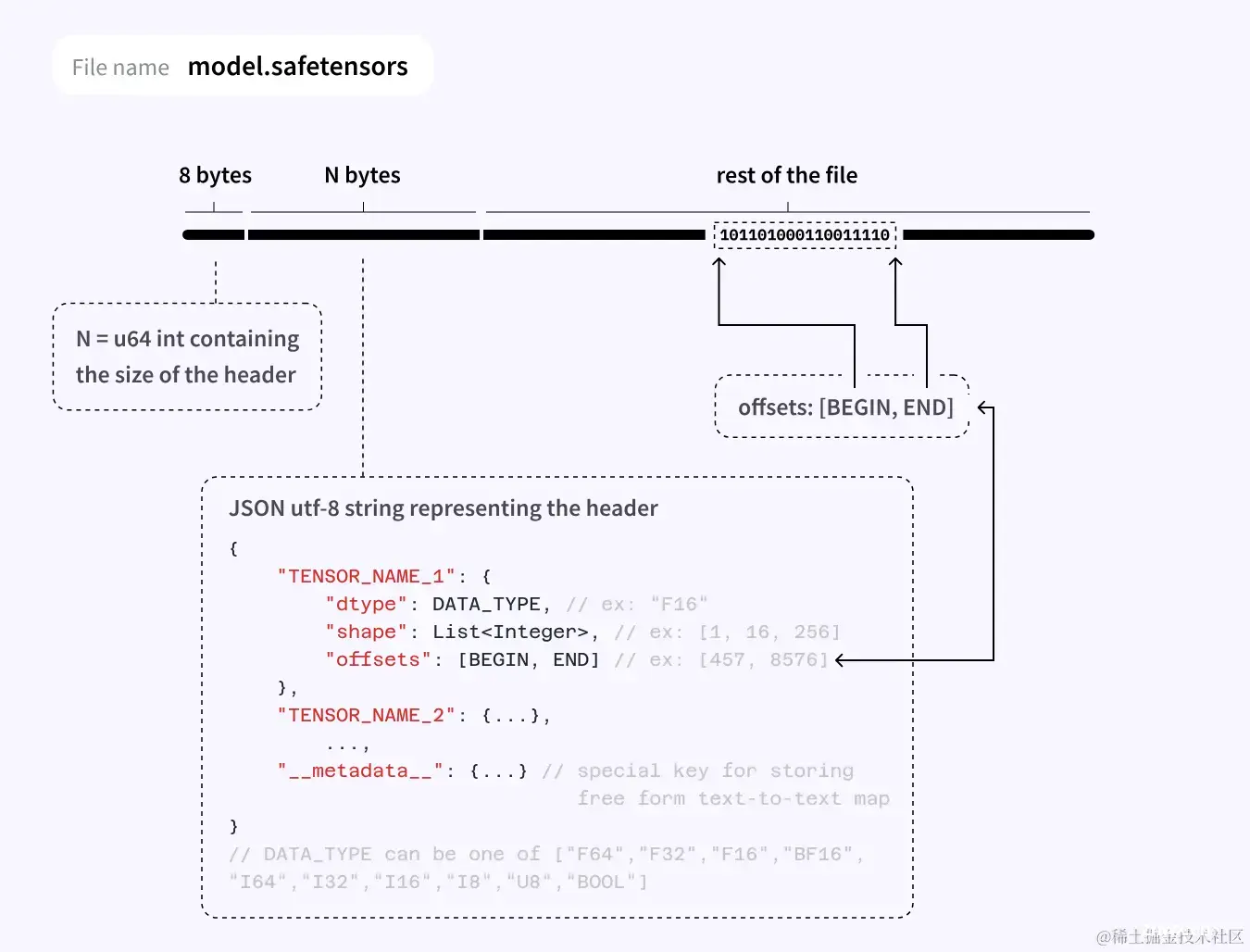

Safetensors是一种用于安全地存储张量的新格式,非常简单,但速度仍然很快(零拷贝)。它是pickle格式的替代品,因为,pickle格式不安全,可能包含可以执行的恶意代码。本文简要介绍了模型权重存储新格...

边缘计算(EdgeComputing)是一种分布式计算架构,它将计算、存储和数据处理任务从数据中心或云计算平台移动到数据产生的地点,即“边缘”设备上。边缘计算常用于需要实时数据处理的应用场景,比如智能城市、自动驾驶...

TensorRT是NVIDIA开发的一款高性能深度学习推理引擎,旨在优化神经网络模型并加速其在NVIDIAGPU上的推理性能。它支持多种深度学习框架,并提供一系列优化技术,以实现更高的吞吐量和更低的延迟...

在使用Rust语言进行机器学习模型处理时,是一个常见的错误。本文将详细介绍该错误的成因、解决方案以及相关代码示例。通过本文的学习,读者可以全面了解该错误的来龙去脉,进而有效避免和解决此类问题。本教程适合各类读者,无论...

推理服务器和推理后端介绍TensorRT+Triton环境搭建Bert模型转化为ONNX中间表示ONNX中间表示编译为TensorRT模型文件Triton服务端参数配置Triton服务端代码实现Triton服务端启动...

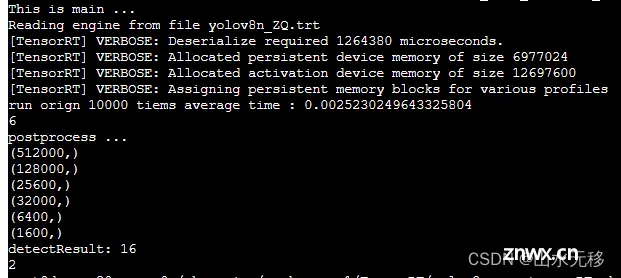

模型和完整仿真测试代码,放在github上参考链接。因为之前写了几篇yolov8模型部署的博文,存在两个问题:部署难度大、模型推理速度慢。该篇解决了这两个问题,且是全网部署难度最小、模型运行速度最快的部署方式。相...