0前言随LLM技术演进,AI应用开发部署越来越复杂。LangServe应运而生,旨在简化AI服务部署和运维的框架。专为LLM部署和管理而设计;本文旨在讲解LangServe的功能特点和实践运用。1概述LangServe提供一整套将LLM部署成产品服...

#note内容概况:结合京粉app学习agent的实践-Agent架构:通过模型训练提升LLM识别工具的准确性;设计可扩展并安全可控的agent架构扩展业务能力。-记忆:多轮对话应用中如何组织、存储和检索...

通过docker方式实现Qwen2.5-7B-Instruct集成vllm,流式输出...

自从我开始搞大模型应用,就一直有一个头疼的问题困扰着我的团队,那就是避免敏感信息。传统的做法是通过一些匹配算法,过滤掉敏感词,这个后面我们再讲。但大模型的对话中,想要防止他做一些不合法的事情,就比较困难了。_大语言模...

LLMs之PE:AIforGrantWriting的简介、使用方法、案例应用之详细攻略目录AIforGrantWriting的简介AIforGrantWriting的使用方法—提示资源AIf...

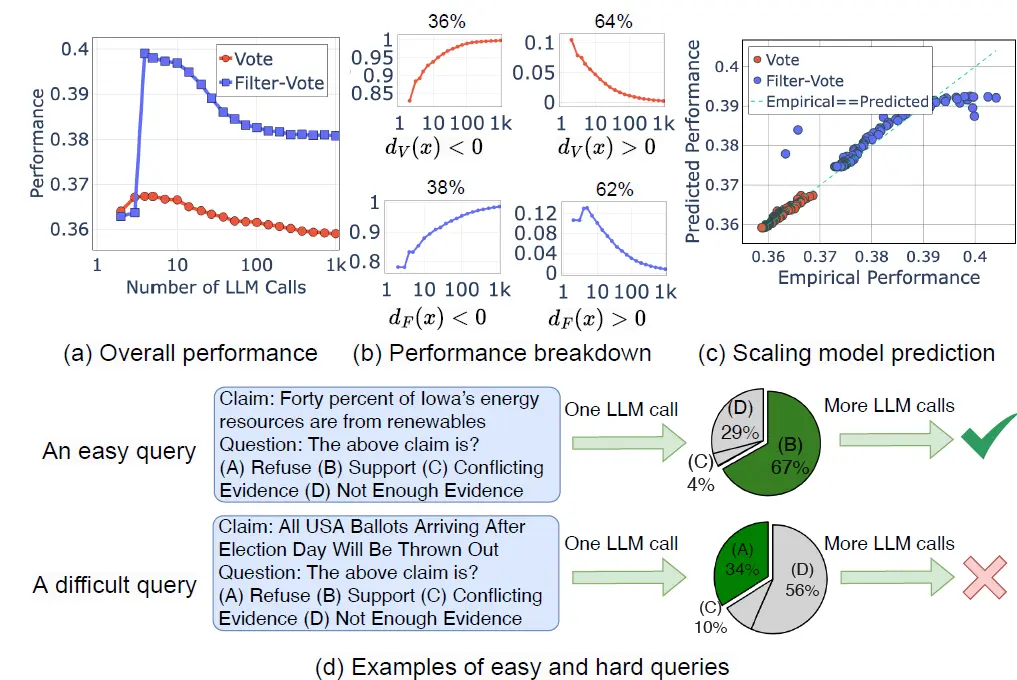

OpenAI的O-1出现前,其实就有大佬开始分析后面OpenAI的技术路线,其中一个方向就是从Pretrain-scaling,Post-Train-scaling向InferenceScaling的转变,这一章我们挑3篇inference-scaling相...

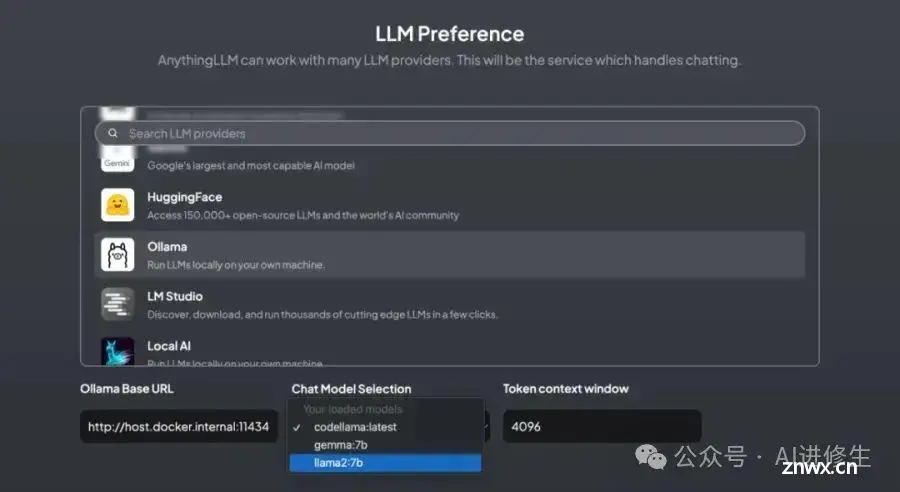

Ollama是一款用于本地运行大语言模型的工具,支持对LLM模型进行管理、训练和推理。通过Ollama,用户可以在本地机器上运行GPT-4、BERT等模型,并利用Ollama提供的Web界面或...

随着ChatGPT迅速火爆,引发了大模型的时代变革,国内外各大公司也快速跟进生成式AI市场,近百款大模型发布及应用。目前,市面上已经开源了各种类型的大语言模型,本章节我们主要介绍其中的三大类......

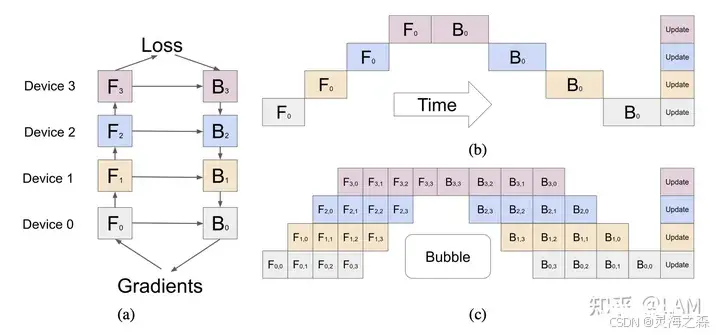

llama3.1论文称使用了:张量并行(TP)、流水线并行(PP)、上下文并行(CP)和数据并行(DP)。并行化可以先粗分为:1.数据并行2.模型并行:张量并行,流水线并行3.上下文并行(llama3.1)4.de...

本地运行大模型耗资源,需要选择较小的模型作为基础模型。在终端中运行时可能会出现CUDA错误,表示显存不足,导致提供的端口失效。中文支持不够完善。\\3.文中提到的技术软件工具有:Ollama、Chatbox...