根据GPU是否可用选择设备类型#初始化模型,并将其放置在指定的设备上#定义批量大小#定义训练轮数#如果在\'patience\'轮中没有改进,则提前停止#对于分类任务,我们使用交叉熵作为性能衡量标准#...

DatawhaleX李宏毅苹果书AI夏令营task1学习笔记,主要学习了深度学习中的鞍点、批量和动量的知识点_文章标题带上“datawhalex李宏毅苹果书ai夏令营...

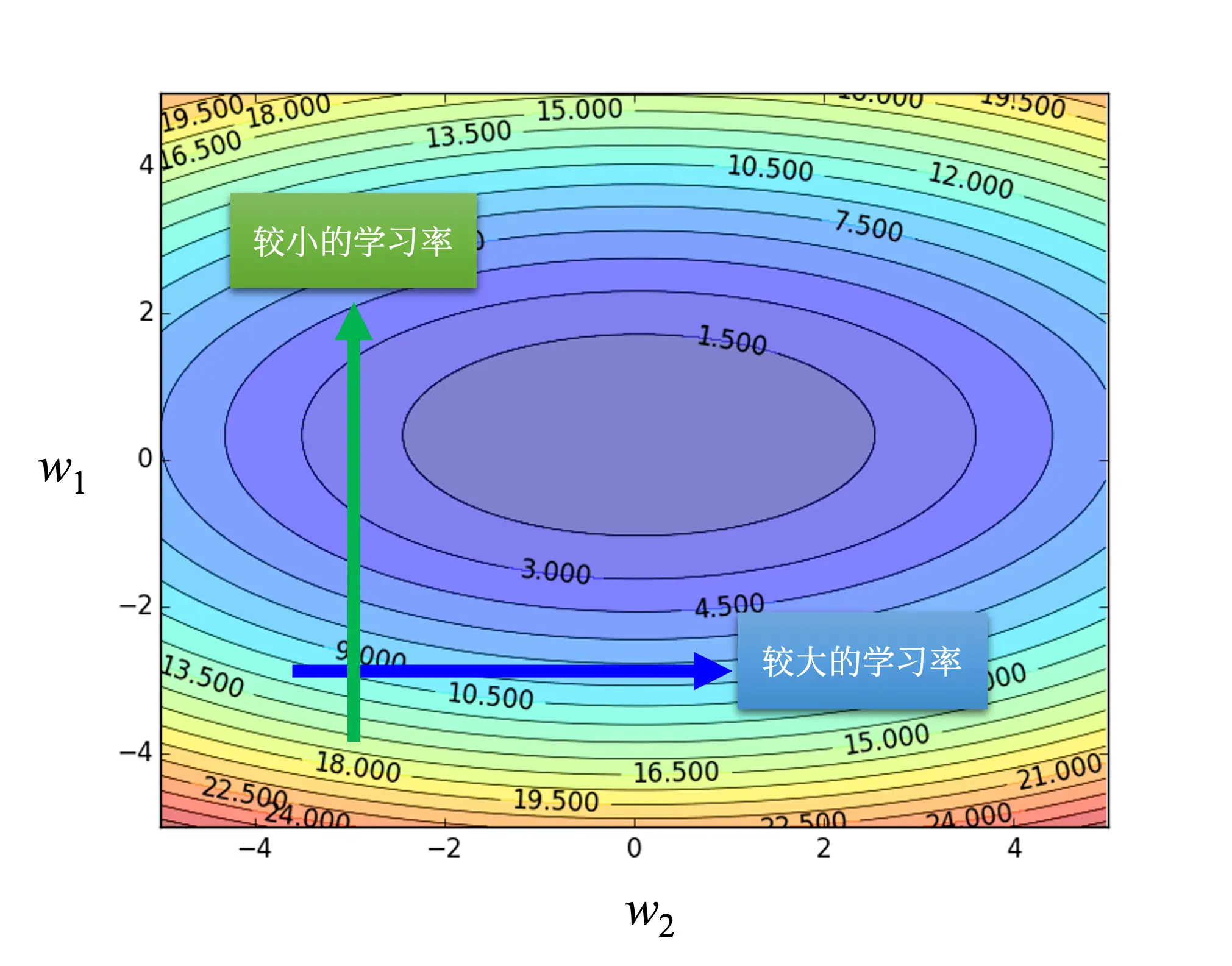

神经网络训练不起来怎么办(5):批次标准化(BatchNormalization)简介_哔哩哔哩_bilibiliTask3:《深度学习详解》-3.7批量归一化-**产生不好训练的误差表面的原因**:输入特征不同维度的值范围差距大可能导致误差表面不...

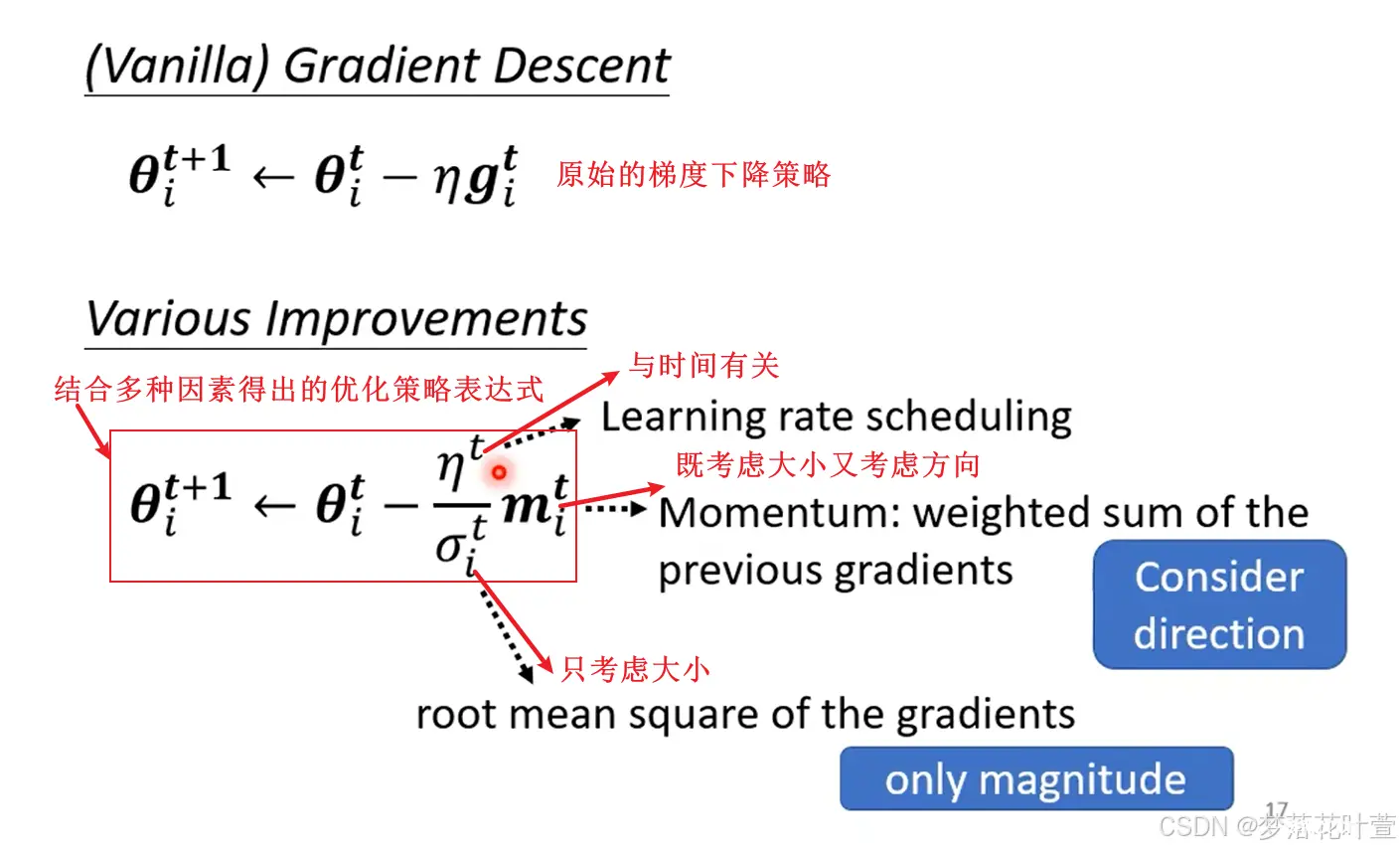

Task2.1:《深度学习详解》-3.3&4&5自适应学习率的概念和方法,包括AdaGrad、RMSProp和Adam等优化器。-**训练网络时的梯度和损失变化**:训练网络时损失可能不再下降,但梯度范数不一定小,梯度可能在山谷壁间“震...

作为一个技术小白,我的逻辑可能并不严密,专业知识并不丰富,但还是想通过这样的一种输出方式,谈谈自己的感受和理解,在写文章的同时帮助自己梳理思路,也为大家提供一点见解。机器要找一个函数f,其输入是可能是种种跟预测P...

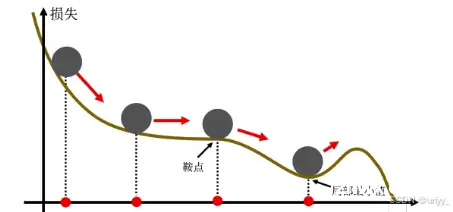

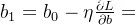

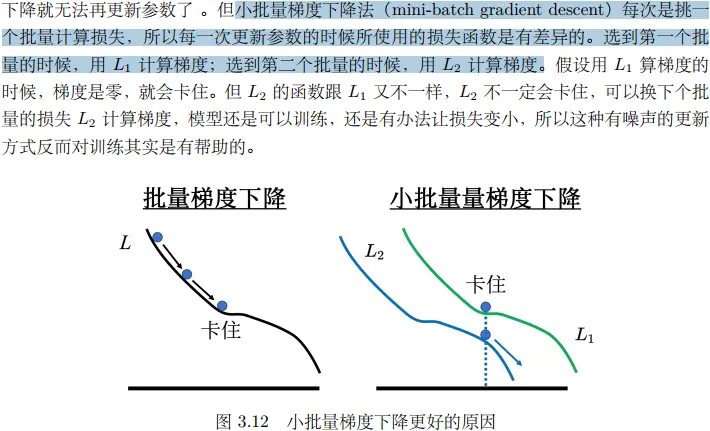

《深度学习详解》3.2节中关于批量和动量的主要内容总结:批量的概念:在深度学习训练过程中,数据不是一次性全部用于计算梯度,而是被分成多个小批量(batch),每个批量包含一定数量的数据。每个批量的损失函数用于计算梯度并更新模型参数。批量大小对梯度下降法的影...

神经网络的优化,通常我们使用梯度下降的方法对获取最优的参数,已达到优化神经网络的目的。另外,我们也可以对学习率进行调整,通过使用自适应学习率和学习率调度,最后,批量归一化改变误差表面,达到优化的目的。同样,也会存在优化失败的时候,在收敛在局部极限值或者鞍点的...