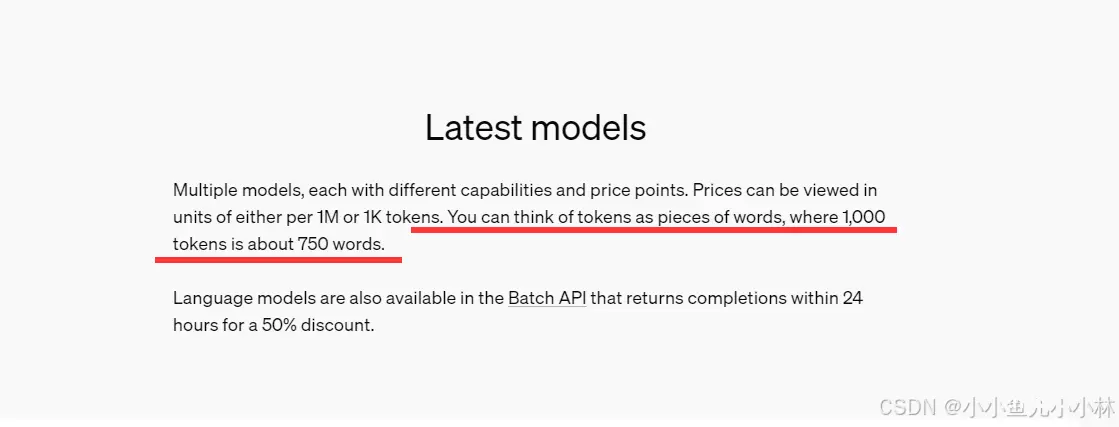

今天我们来聊聊一个你可能听说过,但可能不太了解的词——Token。在那些能聊天、写文章、甚至帮你做决定的智能大模型里,为什么都要用Token来计费。_大模型token...

免费好用的AI大模型工具众多,它们在不同领域和场景下都有出色的表现。...

此外,主板还具备防尘、防潮、抗震、抗电磁干扰等特性,适用于各种严苛的工作环境。随着数字化转型的加速和物联网(IoT)技术的飞速发展,AIoT(人工智能物联网)作为新一代信息技术的重要方向,正...

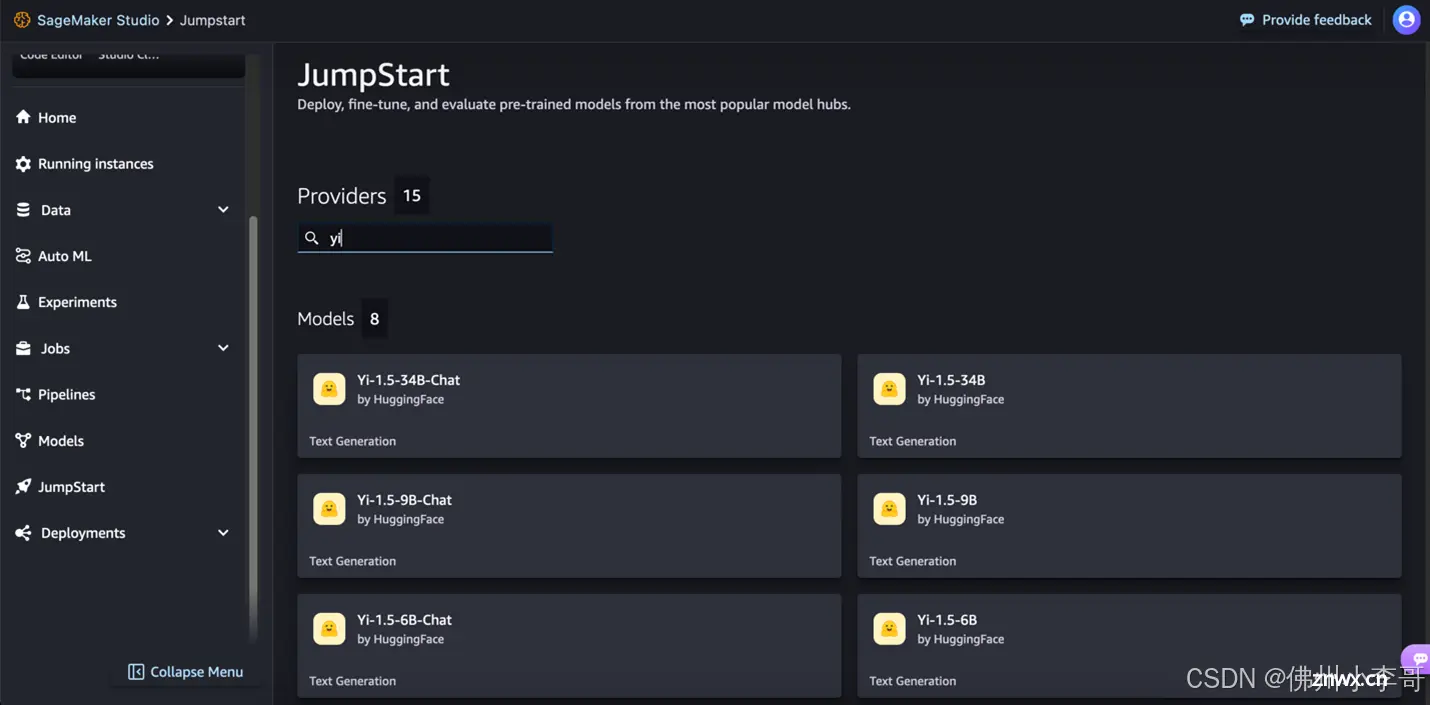

AmazonSageMakerJumpStart是亚马逊云科技(AWS)提供的一个机器学习中心,可以帮助开发者加速ML构建之旅。借助AmazonSageMakerJumpStart,开发者们可以快...

生成式人工智能大模型备案、上线备案、网信办备案、算法备案、安全评估。_大模型备案要多久?...

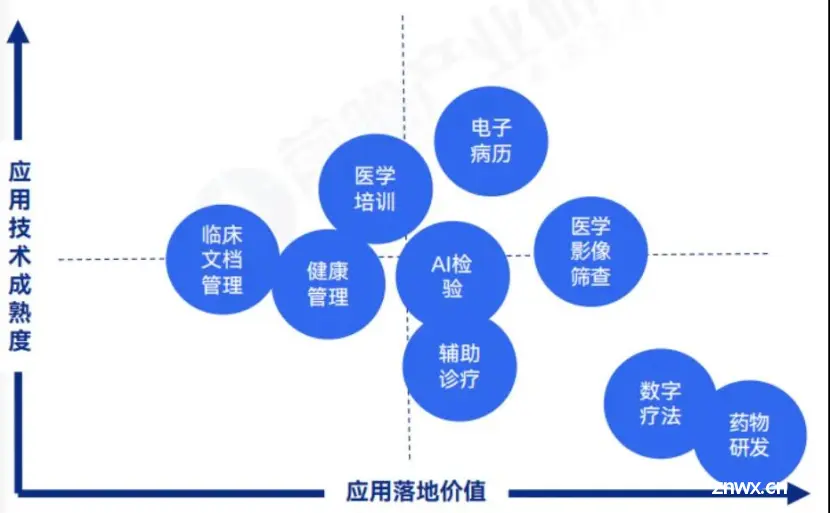

近年来,随着人工智能技术的飞速发展,医疗大模型在中国医疗健康领域的应用日益广泛,成为推动行业智能化转型的重要力量。MarketsandMarkets预测称,到2025年,全球医疗大模型市场规模将达38亿美元,到203...

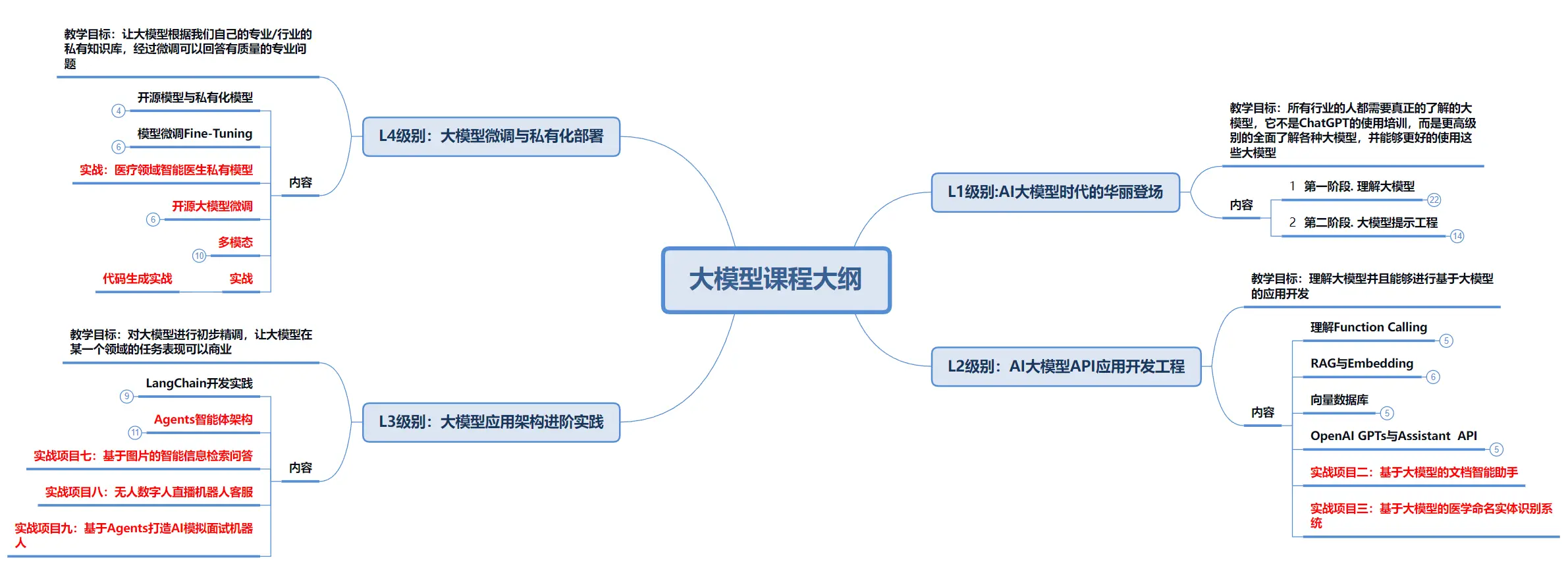

▼最近直播超级多,预约保你有收获—1—AI大模型技术架构全景图AI大模型已经在具体的业务场景落地实践,本文通过梳理AI大模型技术架构的全景视图,让你全面了解AI大模型技术的各个层次,从基础实施层、云原生层...

ChatGPT是由人工智能研究实验室OpenAI在2022年11月30日发布的全新聊天机器人模型,一款人工智能技术驱动的自然语言处理工具.它能够通过学习和理解人类的语言来进行对话,还能根据聊天的上下文进行...

不得不说,是22年底chatGPT的发布让人工智能再次被得到广泛关注。chatGPT所有人都听过,最初我听到它只粗浅的知道它是一个对话工具,好像很厉害,对GPT的认知也以为只是一个简单的品牌代号,就跟AMG、BMW这...

多模态大模型是人工智能领域的一个重要发展方向,它们通过融合多种类型的数据和信息源,提高了模型对复杂场景的理解和处理能力。_多模态网络大模型的模态有哪些...