官方给出的数据就是规范化后的。其中$$Q\\inR^{L\\timesd_{q}$$,$$K\\inR^{L\\timesd_{k}$$,$$V\\inR^{L\\timesd_{v}$$分别...

本文对transformers之pipeline的物体检测(object-detection)从概述、技术原理、pipeline参数、pipeline实战、模型排名等方面进行介绍,读者可以基于pipeline...

1.设置环境变量2.在qtcreator安装目录的bin目录中,用管理员权限打开qtcreator注意:不要在桌面用双击方式启动3.然后就可以正常运行项目了。_qt.qpa.plugin:couldno...

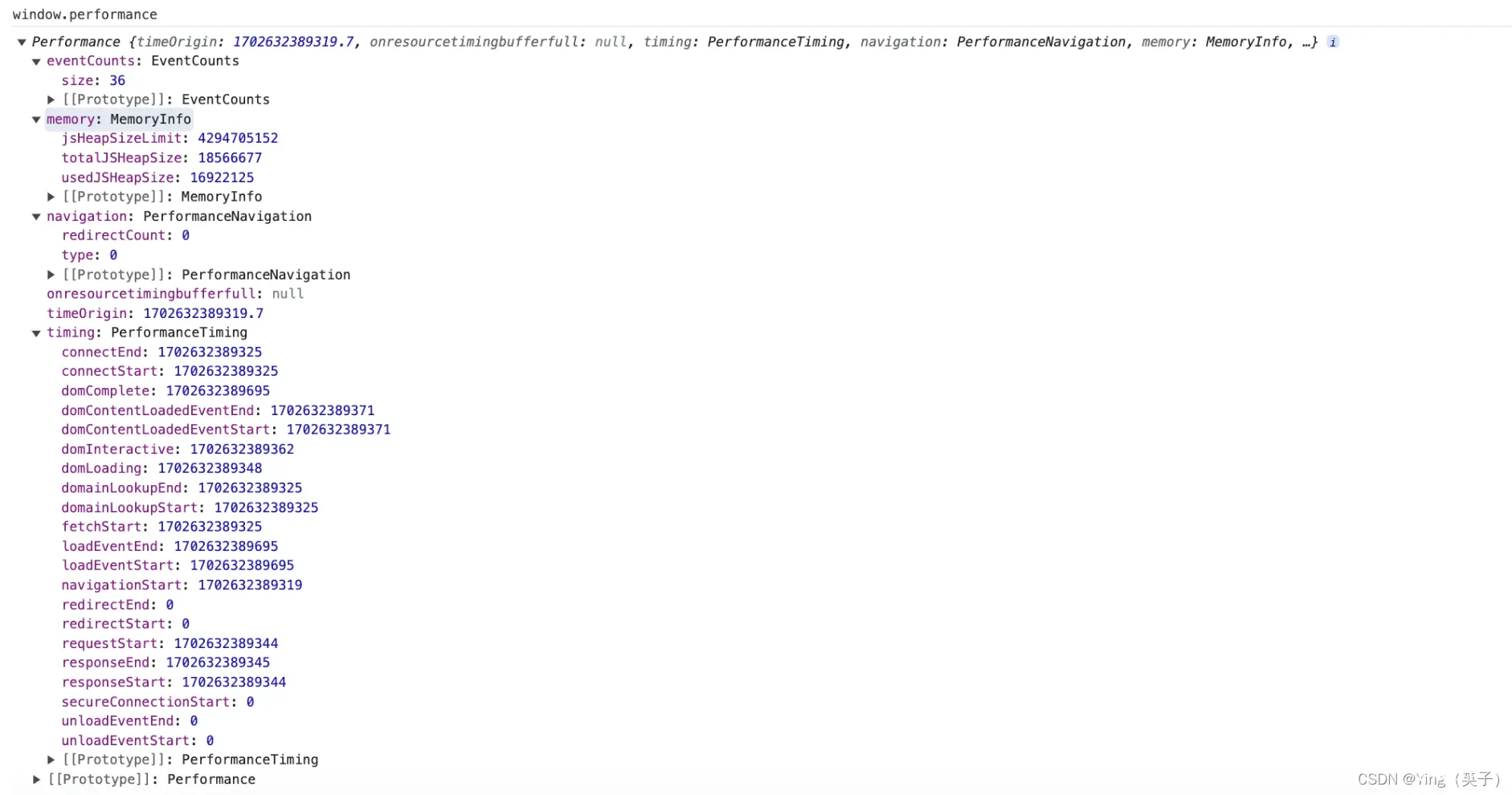

详细介绍在做性能监控时,要了解的WebAPI——performance的属性和使用_window.performance...

在HuggingFace的Transformers库中,Trainer类是一个强大的工具,用于训练和评估机器学习模型。它简化了数据加载、模型训练、评估和日志记录的过程。_transformers.trainer...

本文对使用transformers的AutoModelForCausalLM进行尝试,主要对CausalLM(因果推理模型)进行实例化,需要与同类的AutoTokenizer分词器一起使用。同时,列举了管道模型、...

BiFormer(Bi-levelRoutingAttention)是一种新颖的注意力机制,它通过双层路由机制来捕捉局部和全局特征,从而提高模型的检测性能。其主要思想是在特征提取过程中,分别对局部特征和全局特征...

本文对文生图/图生图(text-to-image/image-to-image)从概述、SD技术原理、SD文生图实战、模型排名等方面进行介绍,读者可以基于DiffusionPipeline使用文中的极简代码进...

论文介绍了一种新型框架TimeXer,它利用Transformer结构处理时间序列预测时的外部变量,通过创新的嵌入层和注意力机制提升预测精度。实验证明TimeXer在多项任务中表现出色,特别是在结合内外部信息方面...

1.HuggingFace是什么,提供了哪些内容2.HuggingFace模型的使用(Transformer类库)3.HuggingFace数据集的使用(Datasets类库)_huggingfa...