总得拆开炼丹炉看看是什么样的。这篇文章将带你从代码层面一步步实现AI文本生成图像(Text-to-Image)中的LoRA微调过程,你将:-了解**TriggerWords**(触发词)到底是什么,...

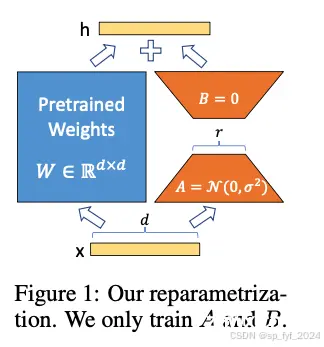

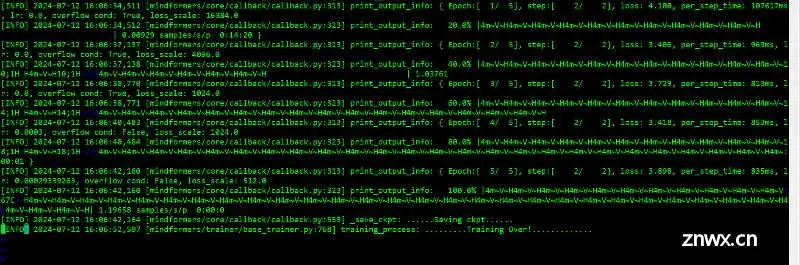

大语言模型的微调技术LoRA及成功背后原理分析文章。...

对于python来讲截取画面的方法有很多,包括比较流行的dxshot.pyd(python的链接库)进行快速截取获取画面,1秒可以截取90多张图片,截取速度非常快;_dxshot...

PagedAdamW8bit在AdamW8bit的基础上进一步优化,通过将参数分片或分页,以更有效地处理内存,适合在更小的GPU内存中训练大型模型。PagedLion8bit在FatDuck格的基础上,进一步优化...

Qwen-VL大模型LoRA微调、融合及部署_qwen-vl微调...

在Diffusion图像生成框架中,使用LoRA(Low-RankAdaptation)微调,难点在于,需要精确控制模型参数的更新以避免破坏预训练模型的知识,同时保持生成图像的多样性和质量,这涉及到复杂的...

本文讲述了高效微调技术QLoRA训练LLaMA大模型并讲述了如何进行推理。_qlora微调...

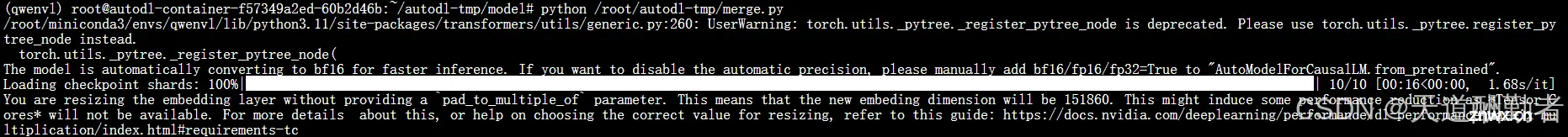

基于Mindformers+mindspore框架在昇腾910上进行qwen-7b-chat的8卡lora微调主要参考文档:https://gitee.com/mindspore/mindformers/tree/r1.0/research/qwe...

LoRA模型是小型的StableDiffusion模型,它们对checkpoint模型进行微小的调整。它们的体积通常是检查点模型的10到100分之一。因为体积小,效果好,所以lora模型的使用程度比较高。...

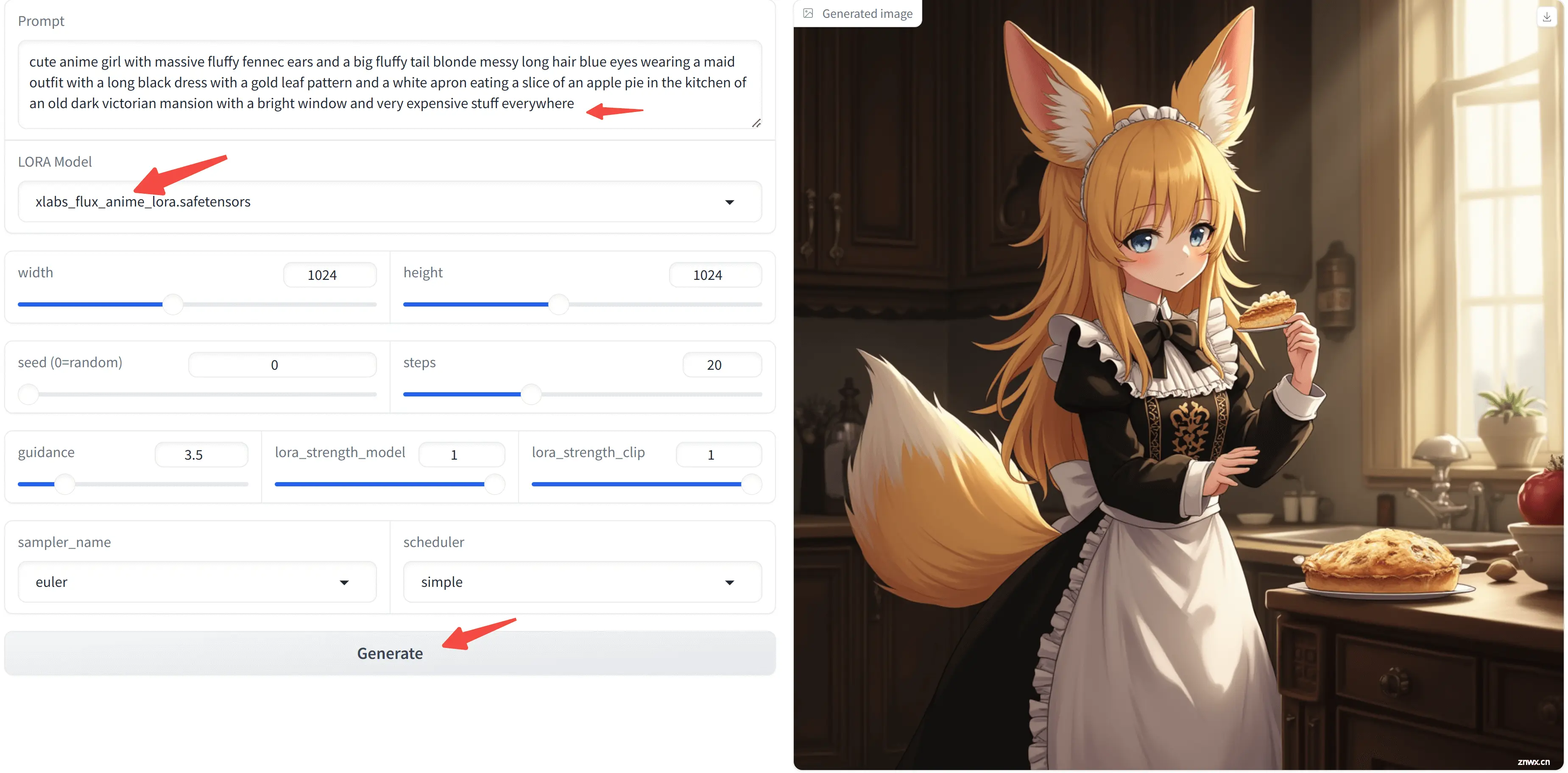

玩转AI绘画新秀FLUX+LoRA_fluxlora...