OrangePi AI Pro体验与测评

默 语 2024-08-09 10:01:02 阅读 67

OrangePi AI Pro体验与测评

OrangePi AI Pro体验测评与应用开发一、前言二、产品简介1.2 硬件规格

三、体验 OrangePi AI Pro开发板MicroSD卡准备连接硬件首次启动连接WIFISSH登录VNC连接1) 查看VNC服务情况2) 安装VNC客户端3.2. 启动 VNC 服务器3.3. 在 Windows 上使用 TightVNC Viewer 连接

四、AI功能体验4.1 运行yolov54.2 运行ocr4.3 运行ResNet50分类4.4. 运行HDR效果增强

五、部署大语言模型测试部署大语言模型测试安装组件开始组件安装:查看是否安装成功:

六.香橙派AiPro综合性能测评总结

博主 默语带您 Go to New World.

✍ 个人主页—— 默语 的博客👦🏻

《java 面试题大全》

《java 专栏》

🍩惟余辈才疏学浅,临摹之作或有不妥之处,还请读者海涵指正。☕🍭

《MYSQL从入门到精通》数据库是开发者必会基础之一~

🪁 吾期望此文有资助于尔,即使粗浅难及深广,亦备添少许微薄之助。苟未尽善尽美,敬请批评指正,以资改进。!💻⌨

OrangePi AI Pro体验测评与应用开发

一、前言

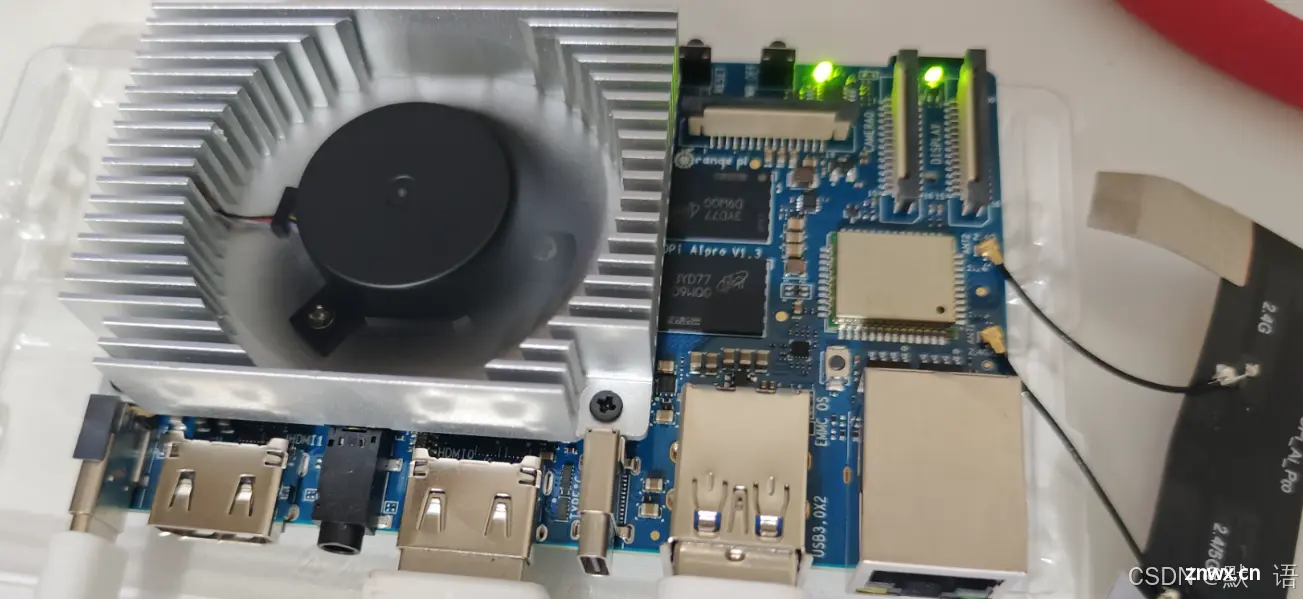

非常荣幸受邀参加此次香橙派开发板的测评活动。除了开发板本身做工精细令人眼前一亮外,举办方还贴心地准备了散热套件、预装系统的TF卡、电源适配器和数据线。官网提供的详尽资料,使得整个体验过程非常愉快。下面让我们正式开始测评,先来看看产品套件的全家福:

二、产品简介

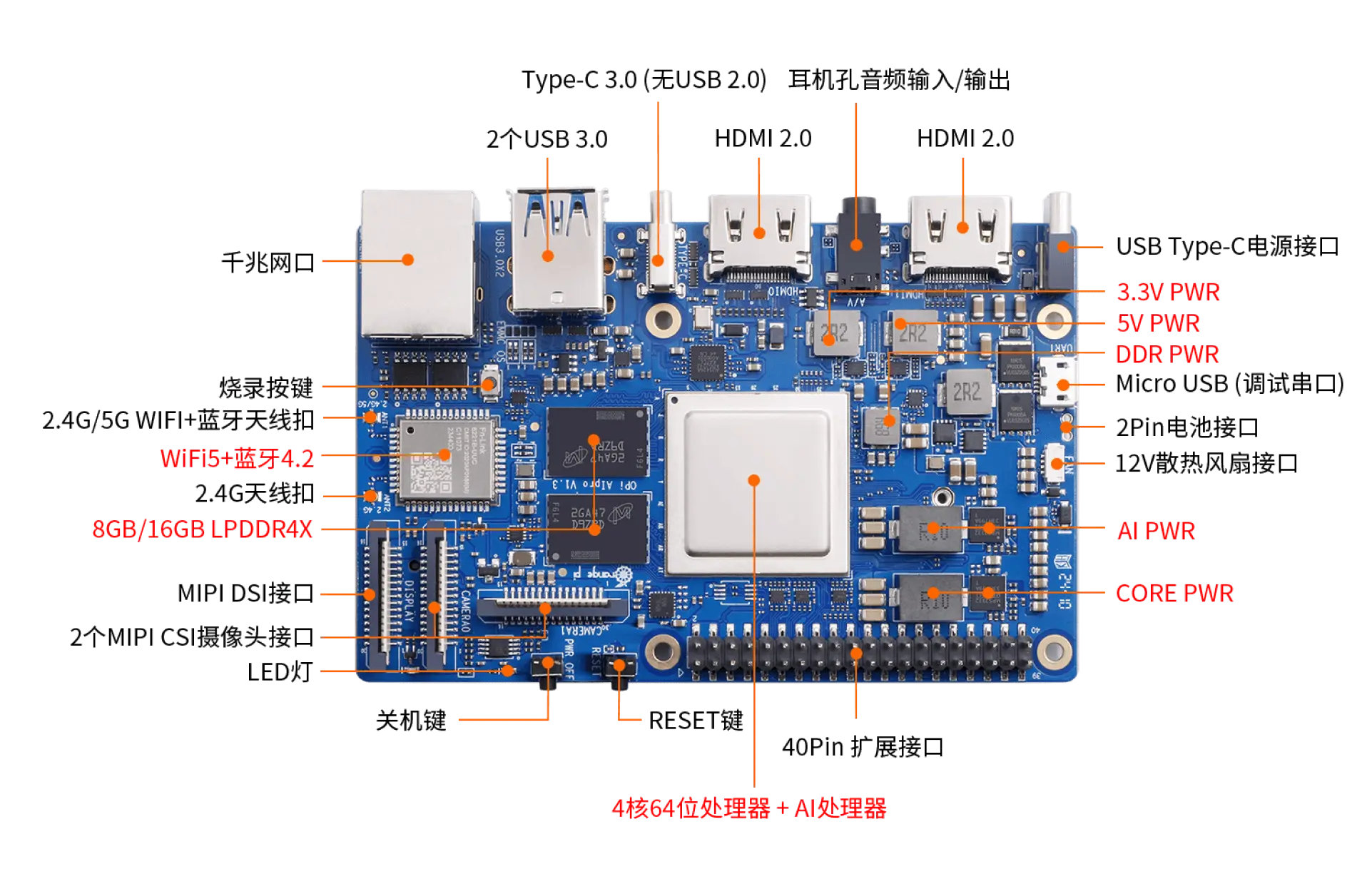

OrangePi AI Pro是香橙派厂商与华为昇腾合作开发的最新一代边缘计算产品。这款AI开发板基于昇腾深度研发,无论在外观、性能还是技术服务支持上都非常出色。它采用昇腾AI技术,集成图形处理器,配备8GB/16GB LPDDR4X内存,并支持32GB/64GB/128GB/256GB eMMC模块,支持双4K高清输出和8/20 TOPS AI算力。

丰富的接口配置赋予了Orange Pi AI Pro强大的扩展能力,包括两个HDMI输出、GPIO接口、Type-C电源接口、SATA/NVMe SSD 2280的M.2插槽、TF插槽、千兆网口、两个USB3.0、一个USB Type-C 3.0、一个Micro USB、两个MIPI摄像头和一个MIPI屏,预留电池接口。

在操作系统方面,Orange Pi AI Pro支持Ubuntu和openEuler,满足大多数AI算法原型验证和推理应用开发需求,广泛适用于AI边缘计算、深度视觉学习、视频流AI分析、图像分析、自然语言处理、智能小车、机械臂、人工智能、无人机、云计算、AR/VR、智能安防和智能家居等领域,覆盖AIoT各个行业。

丰富的接口使得我们可以使用它完成绝大多数的开发场景需求。

1.2 硬件规格

昇腾AI处理器:搭配华为昇腾310NPU,4核64位Arm处理器+AI处理器AI算力:支持半精度(FP16)4 TFLOPS和整数精度(INT8)8 TOPS内存:8GB或16GB存储:板载32MB的SPI Flash,提供Micro SD卡插槽和eMMC插座接口:USB3.0、USB Type-C 3.0、Micro USB、HDMI、CSI、DSI、以太网口、40pin扩展口等Wifi+蓝牙:支持2.4G和5G双频WIFI、BT 4.2操作系统:支持Ubuntu 22.04和openEuler 22.03外观规格:107*68mm、82g

三、体验 OrangePi AI Pro开发板

MicroSD卡准备

使用SD卡读卡器,将Ubuntu镜像写入MicroSD卡中。推荐使用官方工具进行镜像烧录,以确保操作简便。

连接硬件

将MicroSD卡插入Orange Pi AI Pro的相应插槽,连接电源适配器、HDMI线(如果需要直接查看启动过程),以及USB键盘和鼠标。

首次启动

按下电源键启动设备。如果连接了显示器,你将看到Ubuntu的安装界面或直接进入系统(取决于SD卡是否已预装系统并设置了自动启动)。由于我拿到的板子已经预装系统,直接上电即可自动开机。

默认系统是<code>Ubuntu 22.04。

接好电源线、屏幕线和USB键盘鼠标后,可以看到显示。初始系统密码为Mind@123

连接WIFI

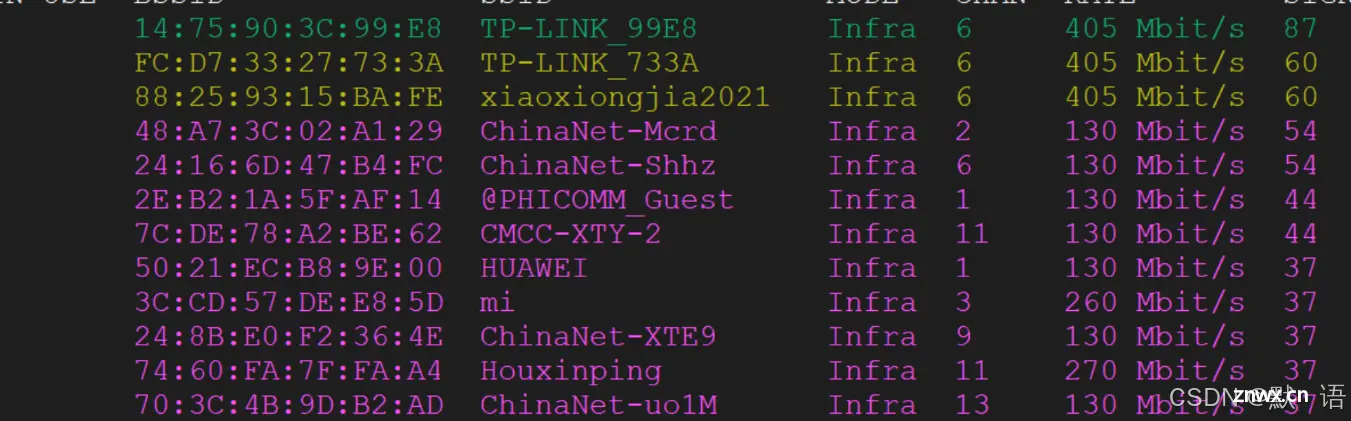

通过nmcli连接WIFI。首先在命令行中输入nmcli dev wifi命令扫描周围的WIFI热点,其中第一个“TP-LINK_99E8”为我当前使用的路由器的WIFI名称。

**连接无线热点:**然后输入如下命令连接WIFI,其中“TP-LINK_99E8”为WIFI名称,“tplink888”为WIFI密码:

<code>nmcli dev wifi connect TP-LINK_99E8 password tplink888

命令模板如下: name是账号 passwprds 是密码

sudo nmcli dev wifi connect name password passwprds

显示连接无线热点成功后,可以查看Orange Pi板子的IP地址。查看IP的命令是:ipconfig

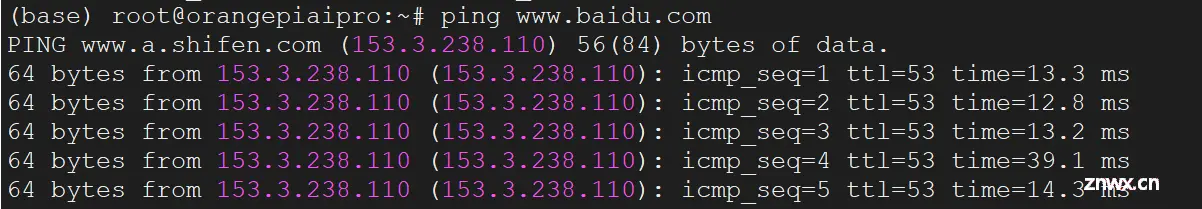

测试网络是否通?可以ping 一下百度来测试是否能正常访问公网:

ping www.baidu.com

如图所示,网络连接成功。

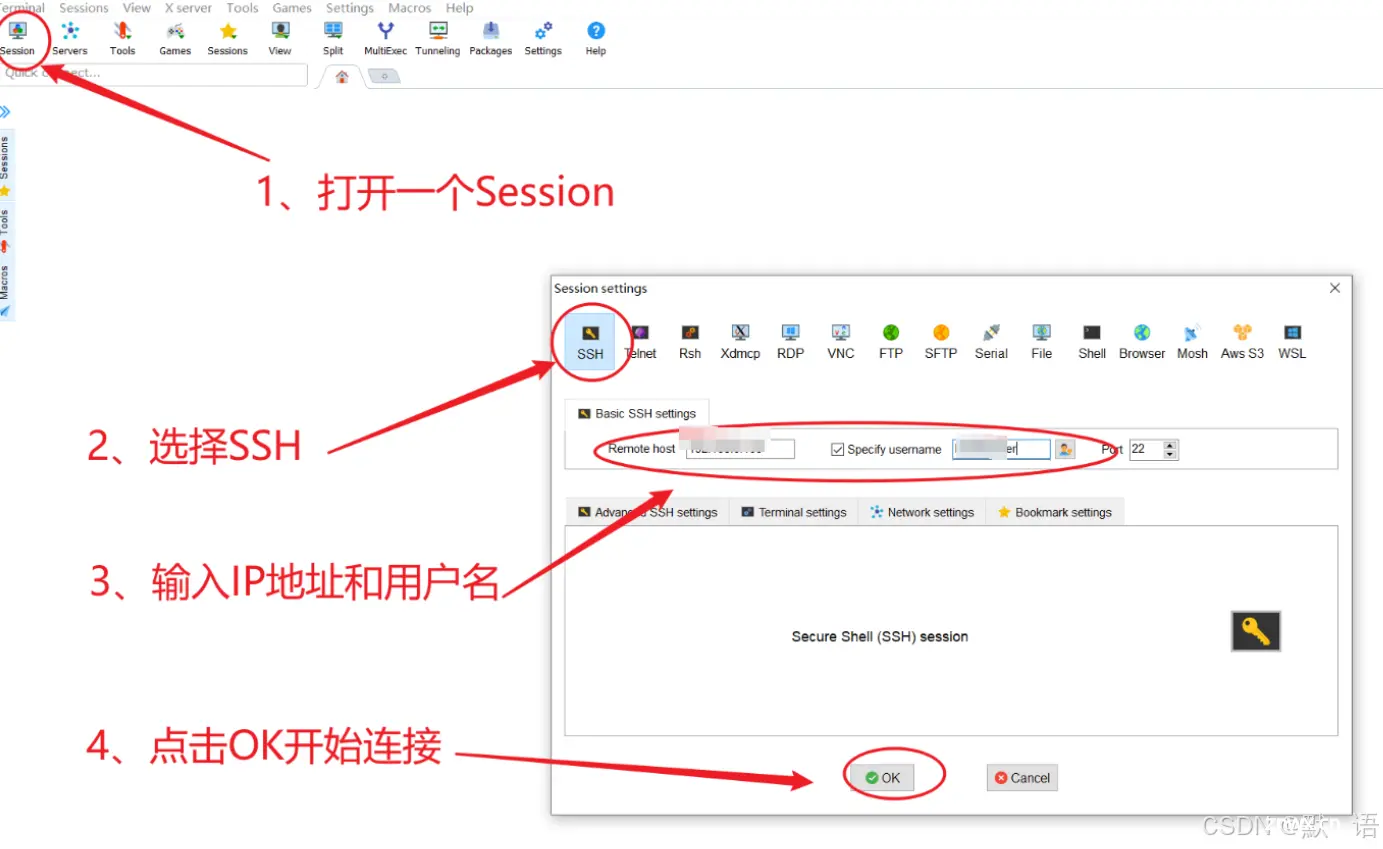

SSH登录

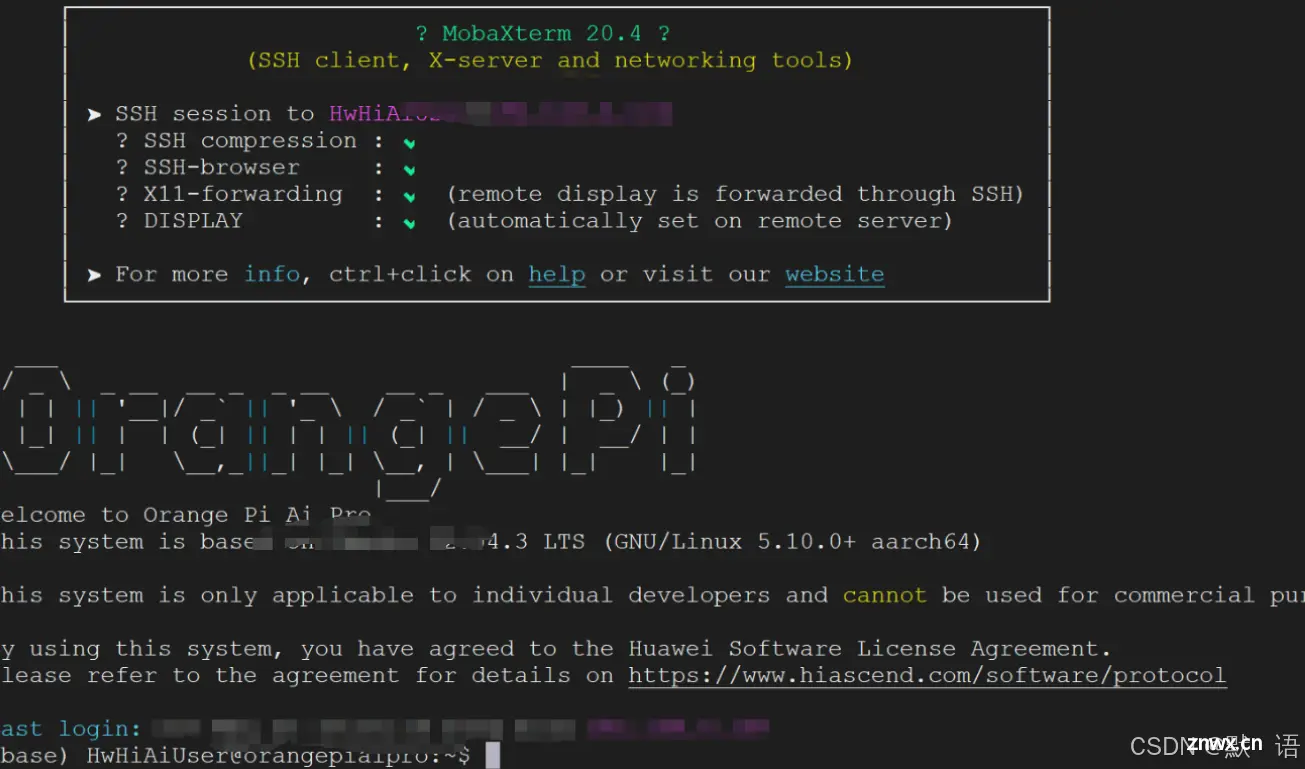

OrangePi AI Pro的Ubuntu系统SSH是默认开启的,所以在连接到网络后即可通过SSH登录。获取到IP地址后,使用MobaXterm软件进行SSH登录:

如下图所示,登录成功:

VNC连接

SSH连接属于命令行管理,但如果希望查看系统中的图片或视频等资源,就必须先将文件拉取到本地,非常麻烦。

解决方法是通过VNC远程连接到Linux系统桌面。官方提供的Ubuntu镜像默认已运行VNC服务,用户直接通过客户端进行远程连接即可。

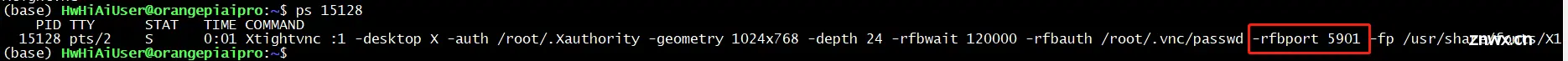

1) 查看VNC服务情况

默认Ubuntu已安装并运行VNC,可以通过以下命令查看服务情况:

<code>ps -ef | grep vnc

查看进程情况:

查看网络监听情况:

<code>netstat -antulp | grep 5901 #查看5901端口是否在进程

2) 安装VNC客户端

sudo apt install tightvncserver

3.2. 启动 VNC 服务器

使用以下命令启动VNC服务器:

vncserver :1

首次运行时,系统会要求你设置一个连接密码。请确保设置一个安全的密码。

3.3. 在 Windows 上使用 TightVNC Viewer 连接

在Windows系统上,打开TightVNC Viewer,输入远程桌面的IP地址和端口,然后使用初始密码Mind@123进行连接。

连接成功后,你应该能看到远程桌面,如下图所示:

通过以上步骤,你可以方便地在不同设备之间使用TightVNC进行远程桌面访问。

四、AI功能体验

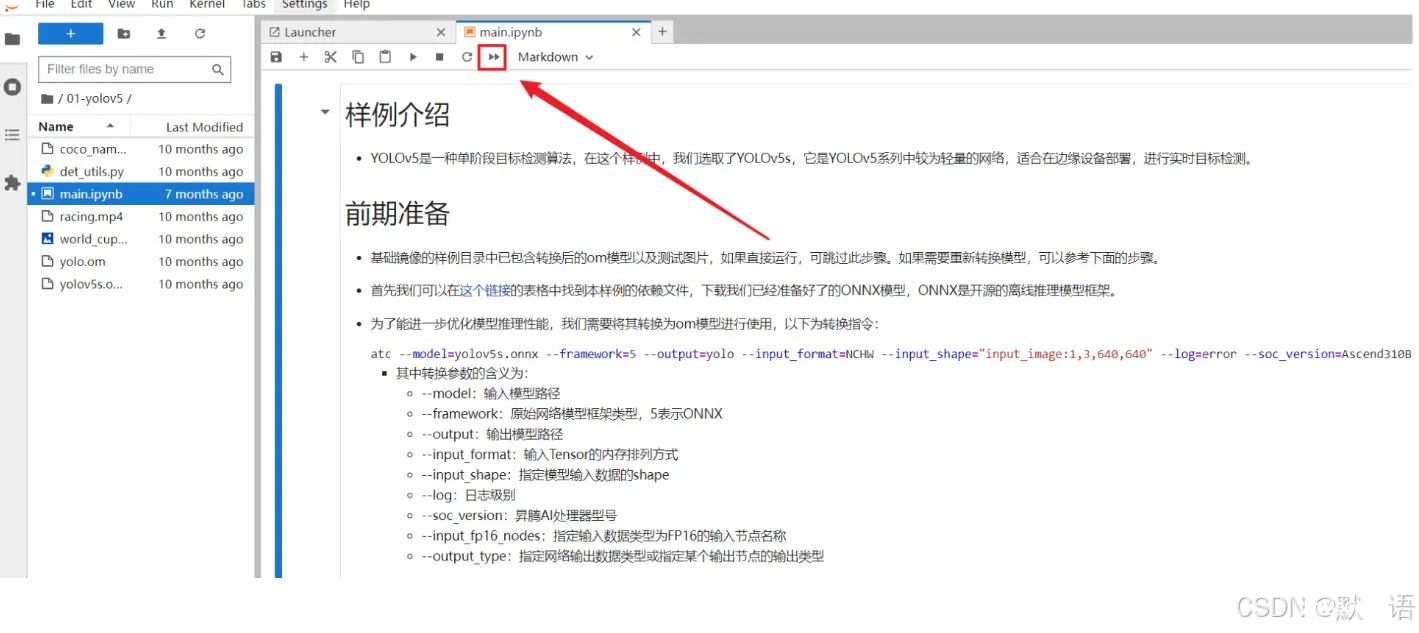

4.1 运行yolov5

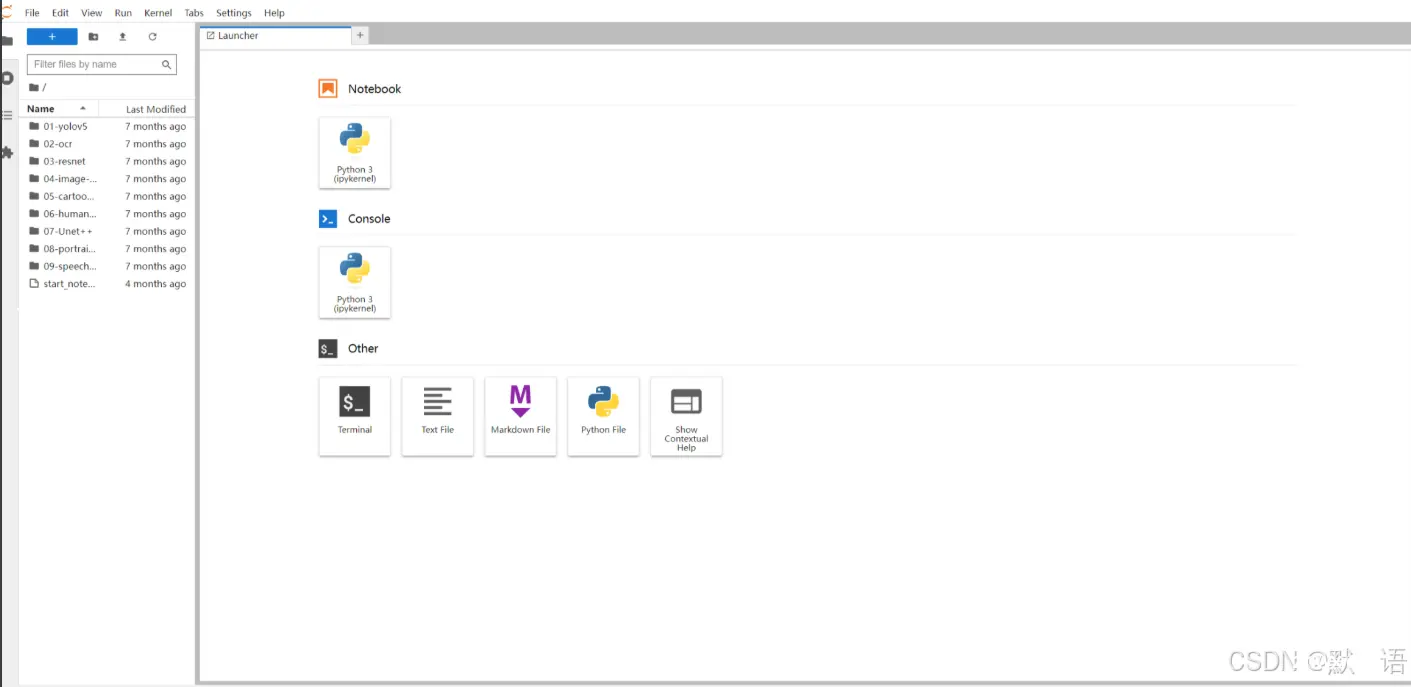

根据文档说明,进入samples目录,然后使用start_notebook.sh脚本启动Jupyter Lab:

<code>./start_notebook.sh IP(当前连接网络所分配的IP地址)

在电脑上打开浏览器即可看到左侧文件管理器中的9个AI应用样例和Jupyter Lab启动脚本。

运行目标检测样例

首先在Jupyter Lab界面双击“01-yolov5”,进入该目录。可以看到目录下有运行该示例的所有资源,其中main.ipynb是在Jupyter Lab中运行该样例的文件,双击打开main.ipynb,在右侧窗口中会显示main.ipynb文件的内容。

单击如下按钮即可运行样例,在弹出的对话框中单击“Restart”按钮,此时样例开始运行。

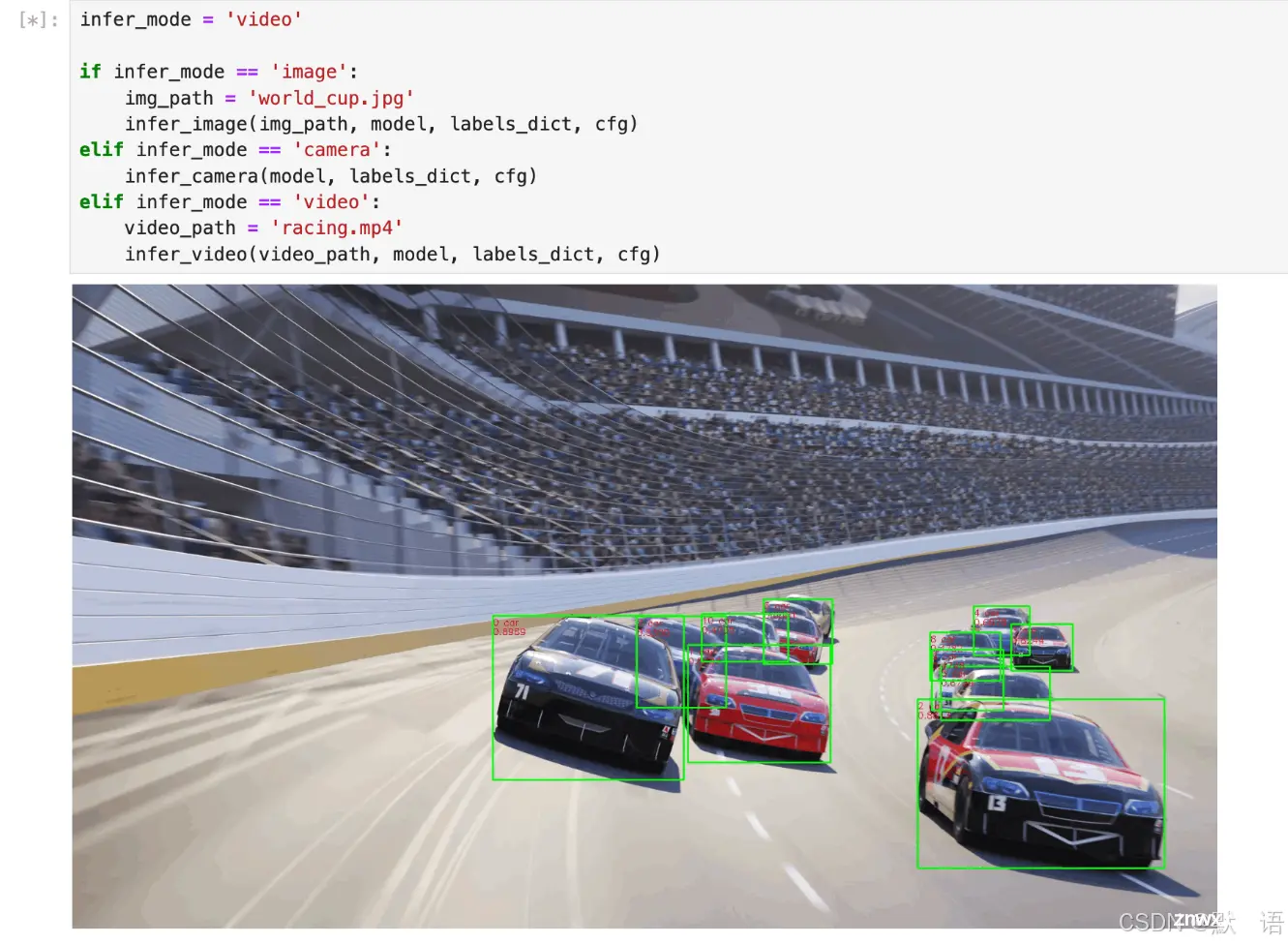

稍等片刻后,我们可以看到在窗口中出现了一段赛车的视频,模型对视频的每一帧进行推理, 并将检测到的赛车标注了出来:

本次体验使用了Jupyter Lab中的目标检测样例,实际场景中,还可以结合自身需求进行相关开发工作。

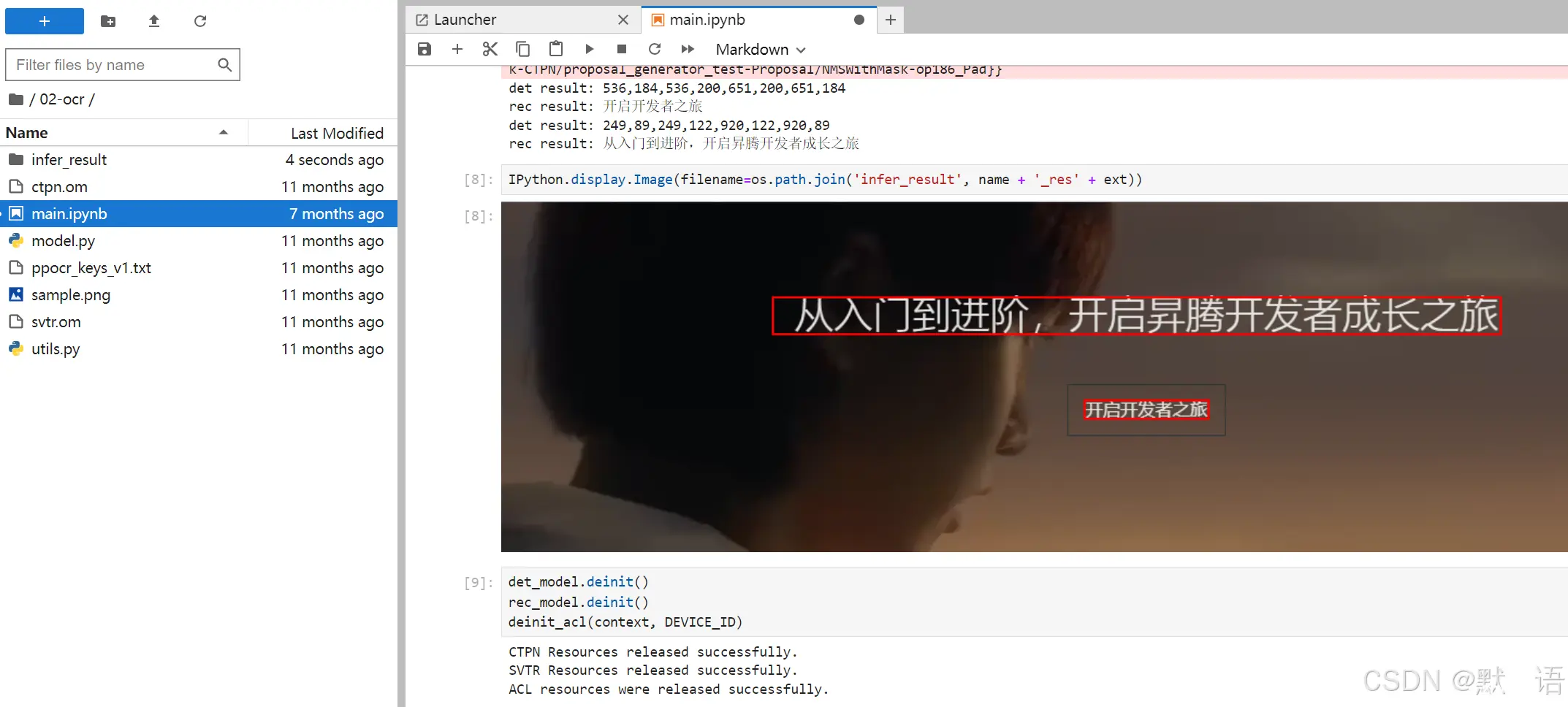

4.2 运行ocr

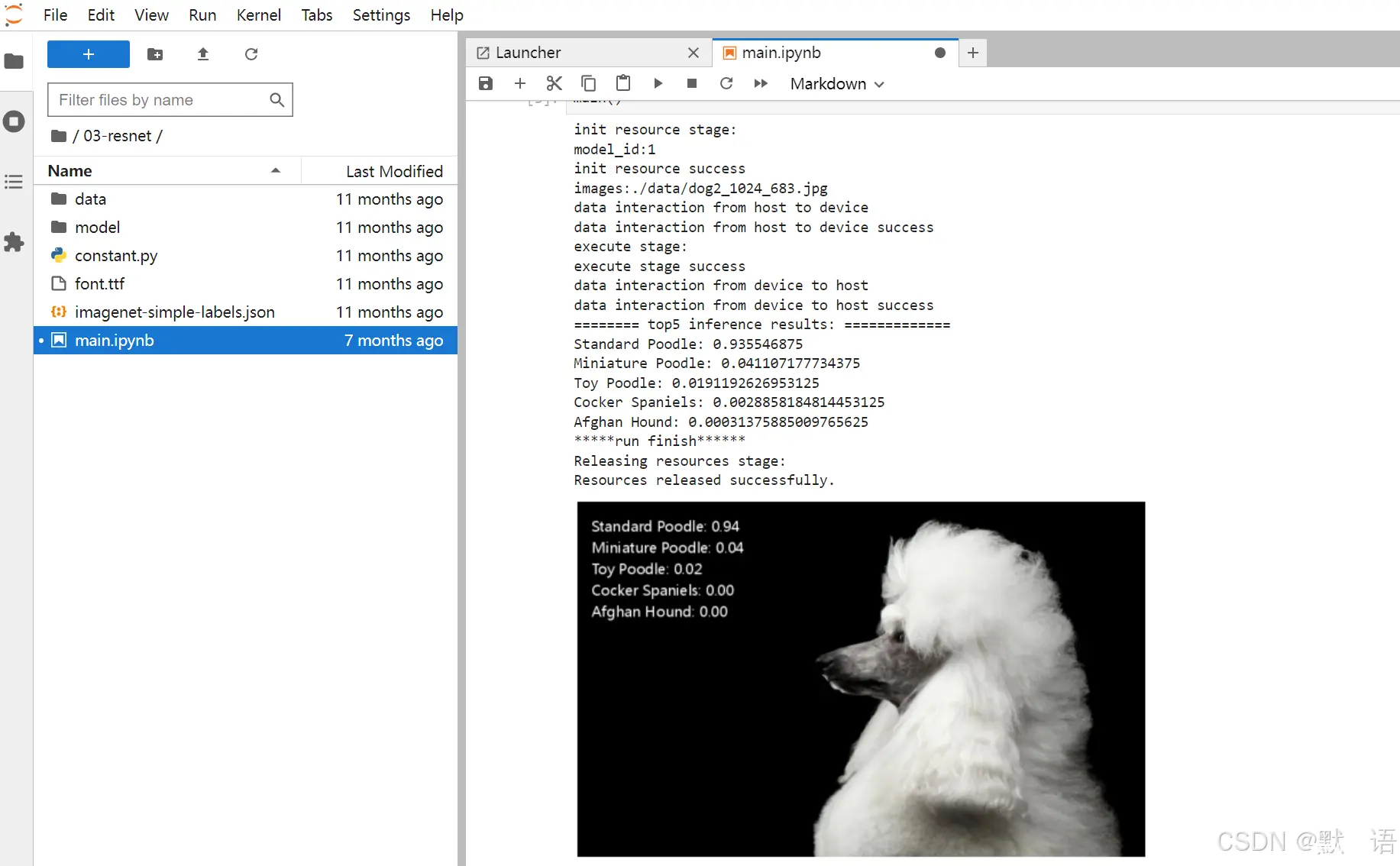

4.3 运行ResNet50分类

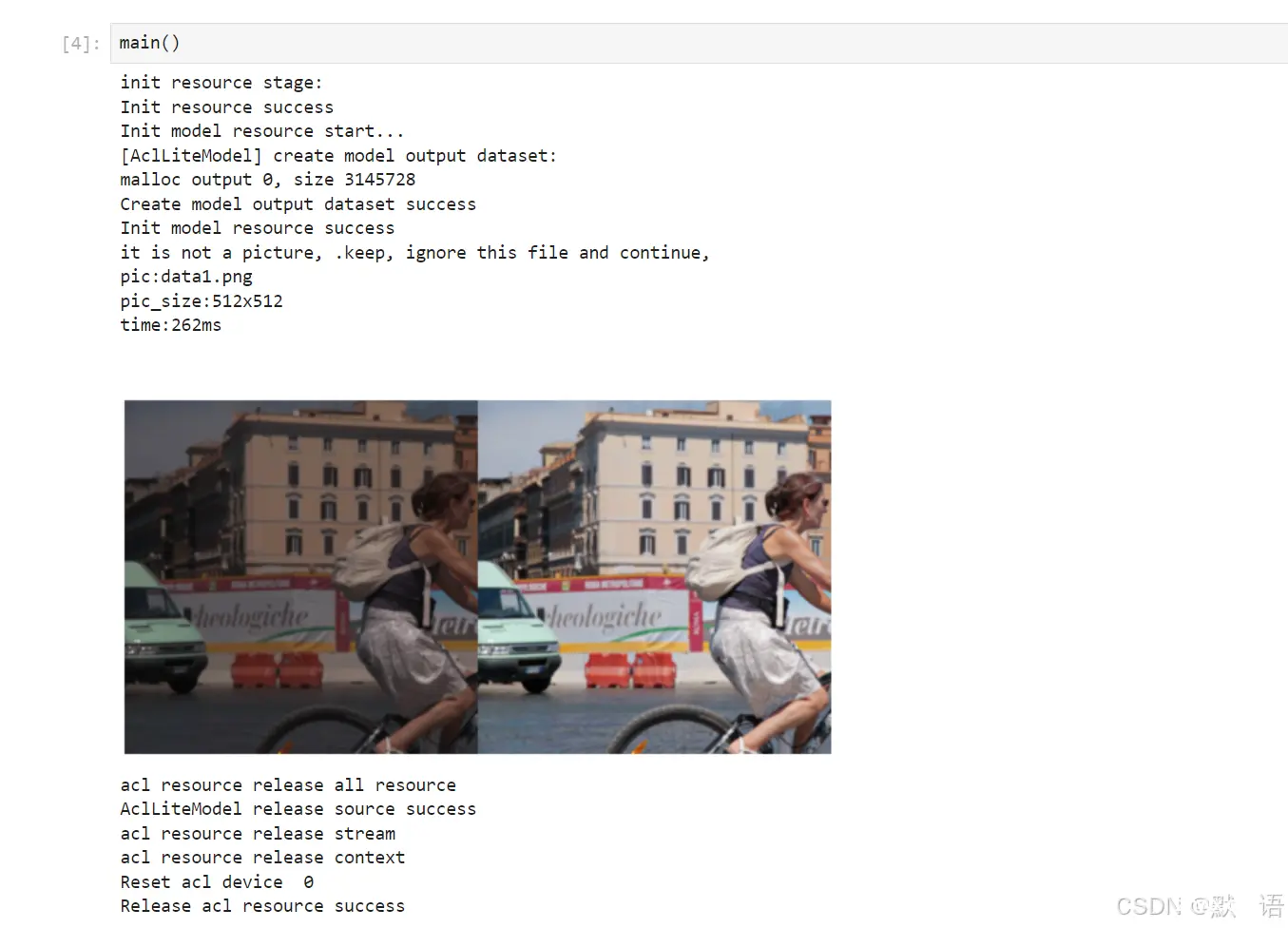

4.4. 运行HDR效果增强

五、部署大语言模型测试

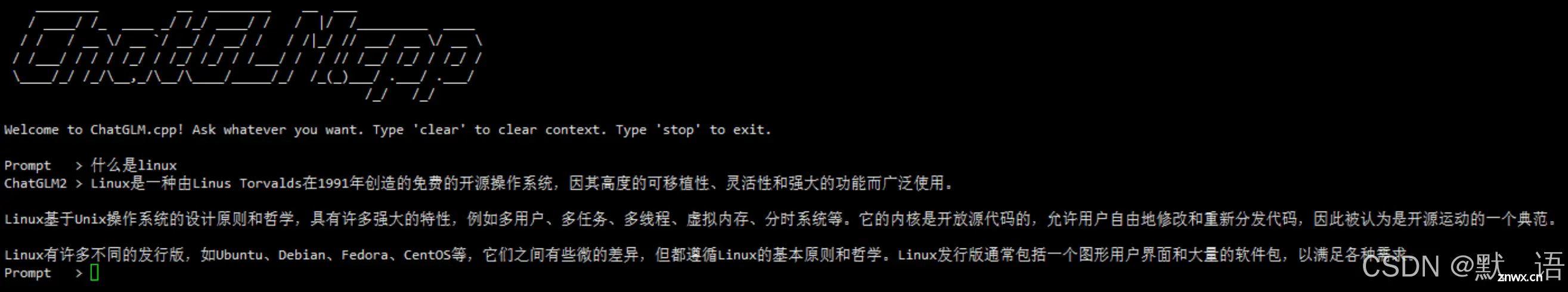

部署大语言模型测试

由于香橙派Kunpeng Pro具备强大的算力,我们将尝试在其上部署大语言模型(Large Language Model, LLM)。LLM是一种旨在理解和生成人类语言的人工智能模型。它们经过大量文本数据的训练,可以执行包括文本总结、翻译和情感分析在内的广泛任务。

安装组件

要使用 chatglm-cpp 部署大模型,需要首先安装 chatglm-cpp 软件包。安装前,可能需要配置 yum 源。

开始组件安装:

<code>yum install chatglm-cpp

查看是否安装成功:

chatglm_cpp_main -h

若成功显示帮助信息,则安装成功。

接下来,下载开源大模型,如 ChatGLM-6B、ChatGLM2-6B 等。将下载的开源大模型通过 chatglm_convert.py 进行模型量化:

python3 /usr/bin/chatglm_convert.py -i model_path/ -t q4_0 -o chatglm-ggml_1.bin

其中,model_path 是开源大模型的存放路径,q4_0 是开源大模型量化的精度,chatglm-ggml_1.bin 是输出的量化模型名称。然后启动模型,进行对话:

chatglm_cpp_main -m model_path -i

其中,model_path 是量化模型的存放路径。

通过以下命令查看命令行选项的用法:

chatglm_cpp_main -h

启动模型界面如下,然后就可以进行交流了~

六.香橙派AiPro综合性能测评

性能表现

香橙派AiPro搭载了昇腾AI技术,配备4核64位处理器和AI处理器,支持高达8TOPS的AI算力,并拥有8GB/16GB LPDDR4X内存。该开发板能够在60FPS的视频上实时进行推理,一张640x640的图像推理时间在15-20ms之间,未进行量化设计,使用float16精度,未来通过Int量化可以进一步提升性能。

散热和噪音

香橙派AiPro配备了高效的散热风扇,即使长时间运行(3小时)后,板子的温度仍保持在较低水平,表现出色。噪音控制方面,开机启动时会有6-10秒的较大声音,但在正常运行过程中几乎无声,风扇的散热效果和静音表现令人满意。

硬件拓展性

香橙派AiPro配备了丰富的硬件接口,包括两个HDMI输出、GPIO接口、Type-C电源接口、支持SATA/NVMe SSD 2280的M.2插槽、TF插槽、千兆网口、USB接口等,还预留了电池接口。这样的设计赋予了开发板强大的可拓展性,能够适应多种应用场景,满足复杂AI应用的开发需求。

操作系统支持

香橙派AiPro支持多种操作系统,包括Ubuntu和openEuler,为用户提供了更多选择,方便根据需求进行开发和部署。多系统兼容性使其适应性更强,适合不同开发环境和项目需求。

使用体验

香橙派AiPro的包装精致小巧,官方提供完整的配件,包括开发板、适配器和充电器。开发板上的静音风扇效果良好,WIFI和蓝牙的天线设计位置方便用户操作。在实际使用中,可以通过HDMI接口连接开发板显示,也可以通过SSH等方式远程连接。官方提供的资料和项目demo较为完善,部署过程简便,适合新手快速上手。

总结

香橙派AiPro作为一款AI开发板,具备强大的AI算力、丰富的硬件接口和良好的操作系统兼容性。其散热和静音表现出色,使用体验便捷,非常适合AI开发者和技术爱好者使用。无论是进行AI算法原型验证、推理应用开发,还是复杂AI应用的开发,香橙派AiPro都能提供强有力的支持,帮助用户实现更多的AI应用创作。

🪁🍁 希望本文能够给您带来一定的帮助🌸文章粗浅,敬请批评指正!🍁🐥

如对本文内容有任何疑问、建议或意见,请联系作者,作者将尽力回复并改进📓;(联系微信:Solitudemind )

点击下方名片,加入IT技术核心学习团队。一起探索科技的未来,共同成长。

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。