2024-09-03 13:01:08

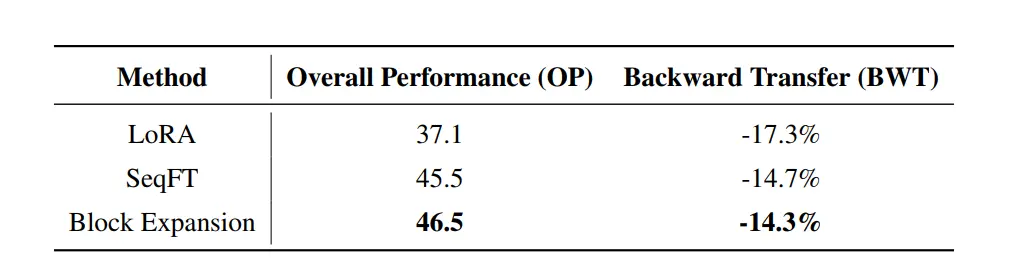

该方法主要通过增加恒定块扩展模型层数,使模型在增量训练过程中仅训练新增层、冻结原始层,保持模型原有能力,防止模型出现灾难性遗忘现象。但有两点存疑:目前来说mistral要好于llama,为啥不用mistral进行...

浏览 85 次 标签: 大模型增量预训练新技巧-解决灾难性遗忘

阅读排行

- 等冬来雪落尽温初晗席令城推荐完本_已完结等冬来雪落尽温初晗(席令城)

- (结局)+(全文)姜黎陆瑾臣(重返人间后小叔火葬场了:全文+结局+番外)全文免费阅读无弹窗大结局_(姜黎陆瑾臣)最新章节列表_笔趣阁(重返人间后小叔火葬场了:全文+结局+番外)

- 楚青枫白悠悠(余生不赴同淋雪白悠悠:结局+番外)全文免费阅读无弹窗大结局_(楚青枫白悠悠)最新章节列表_笔趣阁(余生不赴同淋雪白悠悠:结局+番外)

- 余生不赴同淋雪:完结+结局+番外(余生不赴同淋雪:完结+结局+番外)全文免费阅读无弹窗大结局_楚青枫白悠悠最新章节列表_笔趣阁(余生不赴同淋雪:完结+结局+番外)

- 相思相忆空吟:结局+番外(林暖陆祁景)全文免费阅读无弹窗大结局_(相思相忆空吟:结局+番外)林暖陆祁景最新章节列表_笔趣阁(林暖陆祁景)

- (番外)+(全文)白悠悠楚青枫(余生不赴同淋雪:结局+番外)完整全文在线阅读_白悠悠楚青枫免费阅读最新章节列表_笔趣阁(余生不赴同淋雪:结局+番外)

- 江岁欢顾璟之(弄娇:结局+番外)完结阅读无弹窗大结局_(江岁欢顾璟之)最新章节列表_笔趣阁(弄娇:结局+番外)

- (番外)+(结局)姜黎陆瑾臣:结局+番外(姜黎陆瑾臣)全文免费阅读无弹窗大结局_(姜黎陆瑾臣:结局+番外)最新章节列表_笔趣阁(姜黎陆瑾臣)

- 余生不赴同淋雪:结局+番外(白悠悠楚青枫)完整全文在线阅读_余生不赴同淋雪:结局+番外免费阅读全章节目录(白悠悠楚青枫)

热门文章

- 余生不赴同淋雪:全文+后续(白悠悠楚青枫)完结阅读无弹窗大结局_余生不赴同淋雪:全文+后续免费阅读最新章节列表_笔趣阁(白悠悠楚青枫)

- 余生不赴同淋雪:全文+后续/全集/电子书/大结局(余生不赴同淋雪:全文+后续)白悠悠楚青枫阅读-耽美微白悠悠楚青枫

- 姜黎陆瑾臣:结局+番外(姜黎陆瑾臣)全文免费阅读无弹窗大结局_(姜黎陆瑾臣:结局+番外)最新章节列表_笔趣阁(姜黎陆瑾臣)

- 提出离婚第一天,系统奖励一个亿(陈锋)最新推荐_最新推荐提出离婚第一天,系统奖励一个亿(陈锋)

- 余生不赴同淋雪:结局+番外(楚青枫白悠悠)全文免费阅读无弹窗大结局_(余生不赴同淋雪:结局+番外)楚青枫白悠悠免费阅读无弹窗最新章节列表(余生不赴同淋雪:结局+番外)

- (番外)+(结局)姜黎陆瑾臣:结局+番外(姜黎陆瑾臣)全文免费阅读无弹窗大结局_(姜黎陆瑾臣:结局+番外)最新章节列表_笔趣阁(姜黎陆瑾臣)

- (番外)+(结局)余生不赴同淋雪楚青枫:结局+番外(楚青枫白悠悠)全文免费阅读无弹窗大结局_(余生不赴同淋雪楚青枫:结局+番外)最新章节列表_笔趣阁(楚青枫白悠悠)

- 余生不赴同淋雪结局+番外(楚青枫白悠悠)书荒宝藏热文必读推荐(楚青枫白悠悠)全文免费阅读无弹窗大结局_余生不赴同淋雪结局+番外最新章节列表_笔趣阁(楚青枫白悠悠)

- 楚青枫白悠悠(重返人间后,小叔火葬场了:结局+番外)全文免费阅读无弹窗大结局_(楚青枫白悠悠)重返人间后,小叔火葬场了:结局+番外最新章节列表_笔趣阁(楚青枫白悠悠)

名师推荐

- (重返人间后小叔火葬场了:全文+结局+番外)宝藏小说分享(姜黎陆瑾臣)全文免费阅读无弹窗大结局_(重返人间后小叔火葬场了:全文+结局+番外)最新章节列表_笔趣阁(姜黎陆瑾臣)

- 余生不赴同淋雪:大结局+后续小说楚青枫白悠悠小说余生不赴同淋雪:大结局+后续小说楚青枫白悠悠-余生不赴同淋雪:大结局+后续小说小说在哪里可以看楚青枫白悠悠

- 楚青枫白悠悠全文+番外+大结局(余生不赴同淋雪:结局+番外)免费在线阅读_楚青枫白悠悠(余生不赴同淋雪:结局+番外)全文免费阅读无弹窗大结局

- (番外)+(全文)区区蛟龙,且看贫道一剑斩之!:全文+后续小说免费下载阅读_(张清扬)区区蛟龙,且看贫道一剑斩之!:全文+后续最新章节列表_笔趣阁(张清扬)

- 姜黎陆瑾臣(重返人间后小叔火葬场了:全文+结局+番外)全文免费阅读无弹窗大结局_(姜黎陆瑾臣)最新章节列表_笔趣阁(重返人间后小叔火葬场了:全文+结局+番外)

- (番外)+(全文)乔若锦周祁年:全文+结局+番外(乔若锦周祁年)全文免费阅读无弹窗大结局_乔若锦周祁年:全文+结局+番外最新章节列表_笔趣阁(乔若锦周祁年:全文+结局+番外)

- (番外)+(结局)乔若锦周祁年(乔若锦周祁年:全文+结局+番外)完结阅读无弹窗大结局_(乔若锦周祁年)最新章节列表_笔趣阁(乔若锦周祁年:全文+结局+番外)

- 重返人间后,小叔火葬场了:结局+番外(姜黎陆瑾臣)全文免费阅读无弹窗大结局_重返人间后,小叔火葬场了:结局+番外(姜黎陆瑾臣)最新章节列表_笔趣阁姜黎陆瑾臣

- 等冬来雪落尽温初晗全文小说席令城小说在线阅读