2024-08-07 08:13:00

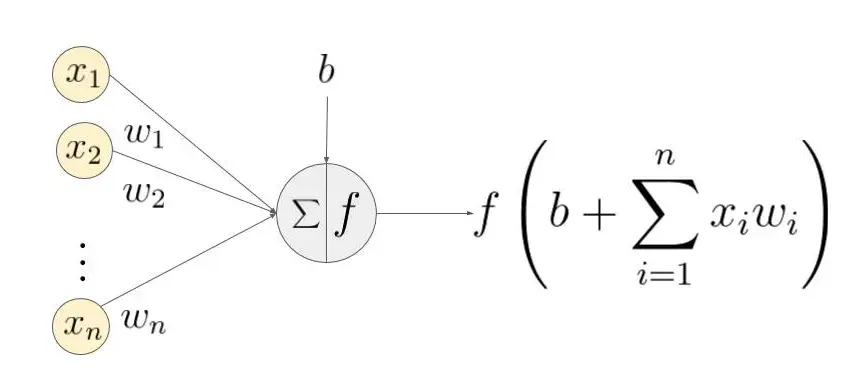

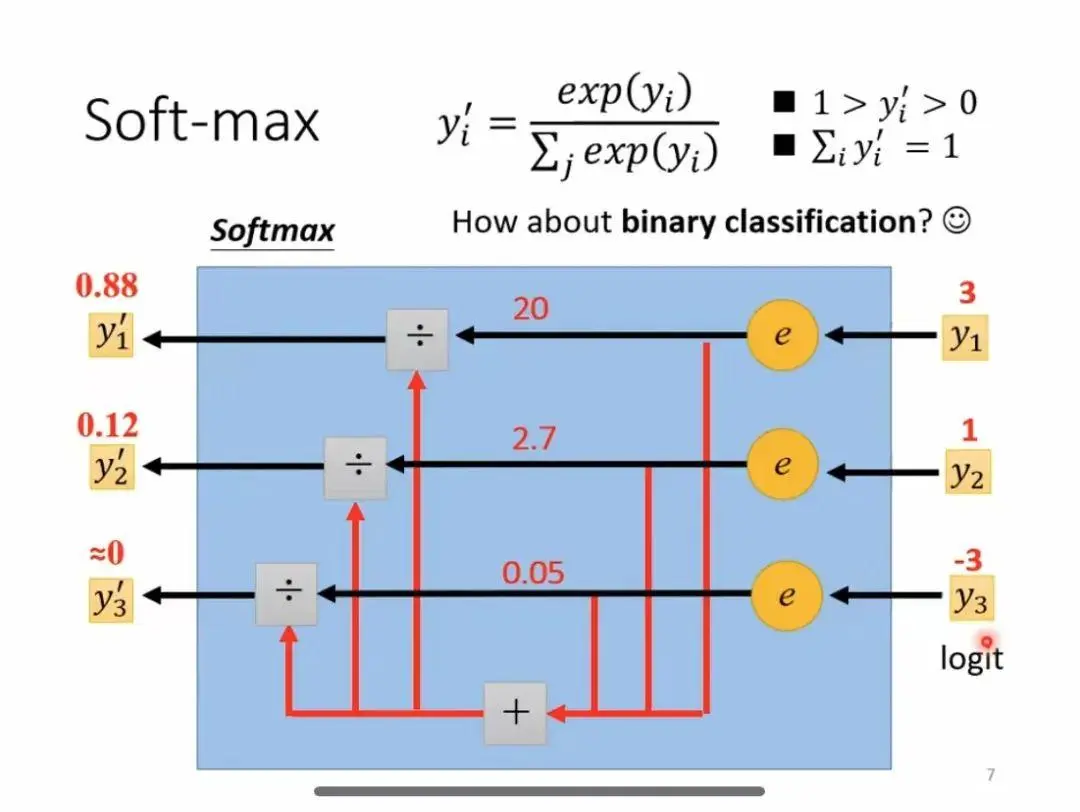

机器学习中,常常见到两个函数名称:sigmoid和softmax。前者在神经网络中反复出现,也被称为神经元的激活函数;后者则出现在很多分类算法中,尤其是多分类的场景,用来判断哪种分类结果的概率更大。本文主要介绍这两个函数的定义,形态,在算法中的作用,以及两个...

2024-06-24 08:31:05

总结了常用的激活函数,如何在工程实践中合理选择激活函数。_softmax函数图像...

2024-06-22 11:31:06

Softmax是一种常用的激活函数,主要用于多分类问题中,可以将输入的神经元转化为概率分布。ReLU的输出范围是[0,+∞),而输入值为负数时输出为0,这导致ReLU输出的分布不对称,限制了生成的多样性。Lea...

2024-06-11 14:01:10

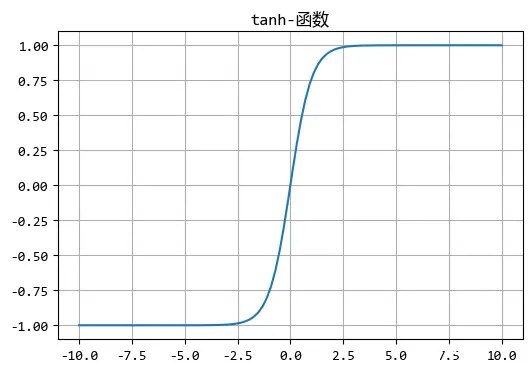

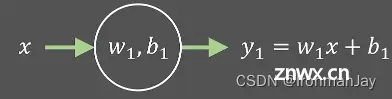

本文总结了关于激活函数、Sigmoid激活函数、tanh激活函数、ReLU激活函数、LeakyReLU激活函数、ParametricReLU激活函数的相关内容,详细介绍了其原理以及优缺点,本文的全部内容如下...