“喂饭级”教程!建筑AI生成设计Stable Diffusion看这篇就够了!

AI绘画君 2024-07-07 12:01:08 阅读 75

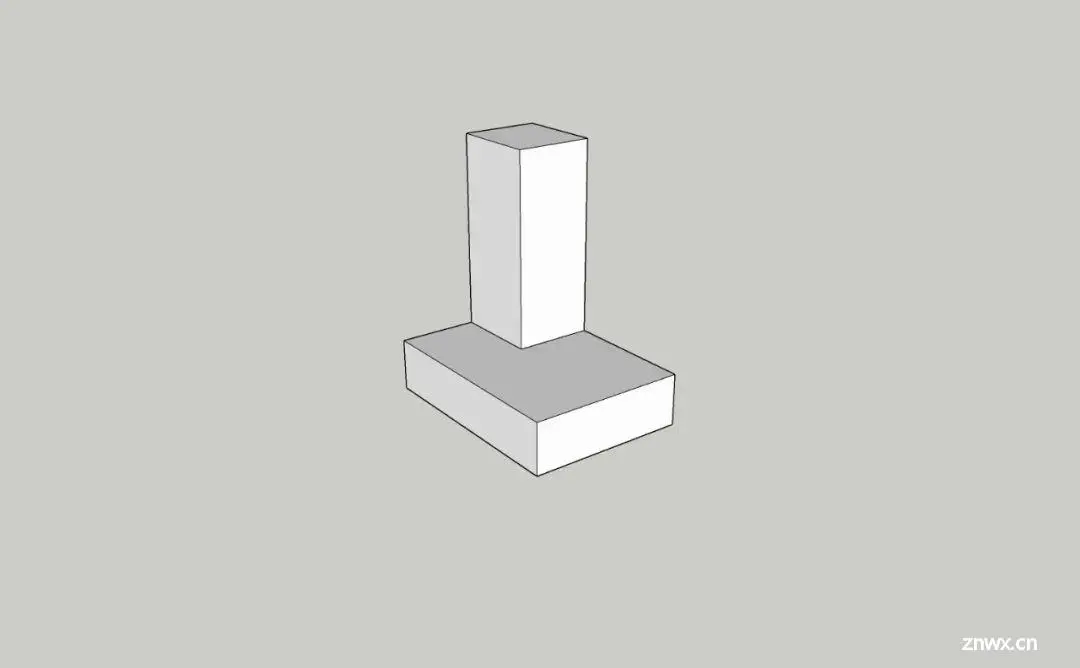

你最近是否看过这样的“魔法案例”,由一张简单的SU体块图片,快速生成多个设计方案,就像这样:

©绘图空间

而看过之后,你是否也在心里想着——“教练!我要学这个!”

今天我们就将带你入门这种“魔法”的源头——生成式AI工具Stable Diffusion。

01

Stable Diffusion本地部署

Stable Diffusion Local Deployment

Stable Diffusion运行需求©绘****图空间

如果你的电脑满足以上要求,那么就可以进行Stable Diffusion的本地部署了。

下载好整合包之后,你需要将文件解压在全英文的安装路径中,这样将减少后期报错的可能。然后按照以下步骤完成Stable Diffusion本地部署。

具体步骤如下:

待启动器页面弹出后,点击“一键启动”:

首次启动Stable Diffusion可能需要较长的时间,请耐心等待:

当Stable Diffusion界面自动弹出时,就代表着你已经完成其本地部署。

02

WebUI简介

Introduction to WebUI

在使用Stable Diffusion创作之前,我们先熟悉一下Stable Diffusion的界面。

在界面的左上角,你可以选择进行创作的基础模型。

在模型选择的下方,是输入提示词的文本栏。与Midjourney不同的是,Stable Diffusion还拥有一行反提示词文本栏,你可以将不希望呈现在画面中的元素输入进去以贴合创作需求。

对书写提示词有疑问的朋友,可稍后阅读我们的往期文章《建筑方向AI绘图描述词Prompt看这篇就够了!》,相信一定会对你有所帮助。而下方也有我们整理的部分建筑方向常用反向提示词以供参考。

建筑方向常用反向提示词整理©绘图空间

提示词文本栏的下方,是采样方法与迭代步数。其中,采样方法我们不作过多探讨,感兴趣的朋友可以自行查找一些AI方向的研究文章进行了解。我们主要介绍一下迭代步数的意义。

简单的来讲,迭代步数影响的是创作画面的细节丰富程度。迭代步数越多,所产生的细节就越多。

但并非迭代步数越多越好,这需要结合创作项目来进行实际调试。可能有时候迭代步数稍低所生成的图片更能贴合创作需求。所以这是一个经验值,大家因创作而异。

在采样方法与迭代步数的下方,是十分好理解的图片宽度、高度、生成批次、每批数量。

我们着重介绍的是在它们下方的提示词相关性。它控制着产出图片受输入提示词的影响程度。我们一般取值范围在7-15。

提示词相关性的下方,是十分重要的随机种子参数以及ControlNet插件。可以说,正是因为有了ControlNet插件,才使得Stable Diffusion区别于Midjourney等“抽盲盒”式AI生成工具,更能应用于建筑方向实际项目之中。

接下来我们就将通过一个案例来讲解如何入门ControlNet。

03

ControlNet入门

Getting Started with ControlNet

我们在AI设计讨论群提供的Stable Diffusion整合包中,已经配置好了ControlNet插件。

而如果有朋友之前已经本地部署了Stable Diffusion,却没有安装ControlNet插件,可以按照以下方式进行安装(该方法也是Stable Diffusion安装插件的通用方法):

Stable Diffusion插件安装流程©绘****图空间

在确保已经安装ControlNet插件之后,你需要将ControlNet的根路径进行更改,具体流程如下:

需要注意的是,该操作需在“科学上网”前提下进行,对“科学上网”有疑问的朋友,可联系我们的客服。

案例教学

case study

下面将通过一个案例介绍如何入门ControlNet。

第1步:填写好提示词与反提示词:

第2步:在SU中搭建一个体块模型,并导出二维图片。

第3步:将导出的SU体块图片拖入到ControlNet中,如下图所示:

第4步:点击enable(启动)按钮。选择preprocessor(预处理方式),并在Model(模型)中选择preprocessor所对应的模型:

第5步:调整权重栏数值,权重越高生成的图片就越贴合我们提供的原始模型图片,具体数值根据实际项目需求进行调整:

第6步:在随机种子栏我们选择默认的-1(对应的是骰子图标),它代表的是本次图片生成将完全随机:

生成批次与每批数量我们分别选择3、4。这样一次我们就能得到12张图片。

第7步:最后点击生成按钮,稍等一会,我们就将得到如下的图片:

©绘图空间

点击单张图片,可以放大对应的作品:

©绘图空间

如果在生成的图片中,有想继续深化的作品,选中它后,在随机种子栏,点击绿色按钮,将获得一段种子代码,此后生成的作品就将基于这个代码进行创作,以保证创作的可控性:

我们获取上图的种子代码,然后在此代码的基础上再进行生成,就会得到如下的图片(我们选择生成4张作品):

©绘图空间

可以看出新生成的作品与我们选中的作品风格、构造都比较接近。

而通过ControlNet插件,我们还可以做到从手绘草图直接生成设计方案:

保持我们上述的提示词、反提示词与各种参数设置不变,直接将手绘图纸拖入到ControlNet中:

点击生成按钮,我们就会得到:

©绘图空间

以上就是在Stable Diffusion中,如何利用ControlNet插件,从SU体块模型、手绘草图直接生成设计方案的方法。

04

总结

Summarize

如果你花了一些时间,认真的阅读了上述内容,最好是在本地部署Stable Diffusion之后,跟着操作了一遍。那么相信你已经成功入门了Stable Diffusion这一建筑方向出图利器。

而与我们之前发布的教程《用AI生成设计图纸,“ChatGPT+Midjourney工作流”看这篇就够了!》相比,本篇的篇幅明显更长一点,而且这还仅仅只是一篇入门级的指导性文章。

因为相较于Midjourney来说,Stable Diffusion需要个人设置的部分更多,有人曾这么简单的形容两者的区别:“Midjourney就像电子产品中的苹果,而Stable Diffusion更像是安卓。两者只是创作方式不同,没有高下之分。”

但对于建筑方向来说,结果更可控的Stable Diffusion显然更受设计师们的青睐。

05

作品分享

work sharing

最近有许多朋友在后台留言,询问AI设计除了可以应用在建筑单体方向上,还有没有别的可能。比如应用于室内设计、城市设计中。

对此我们想说——当然可以!

所以本期的作品分享,除了有建筑单体方向的AI设计作品,我们也收集了一些室内设计、城市设计的作品,与大家共同欣赏:

©小红书****Shutter

©小红书Shutter****

©小红书Shutter****

©小红书Arcai_Vera

©小红书Arcai_Vera

©小红书Arcai_Vera

©小红书叮当当

©小红书尚_なお君

©小红书尚_なお君

©小红书尚_なお君

写在最后

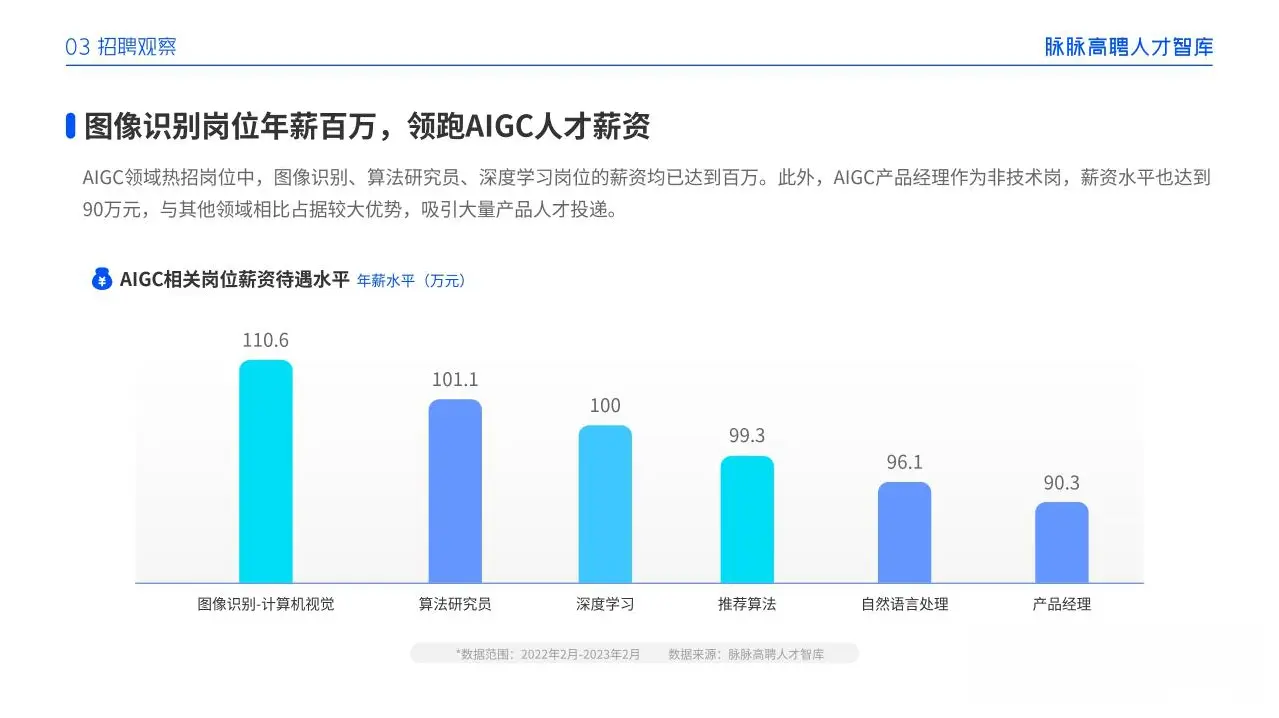

感兴趣的小伙伴,赠送全套AIGC学习资料,包含AI绘画、AI人工智能等前沿科技教程和软件工具,具体看这里。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

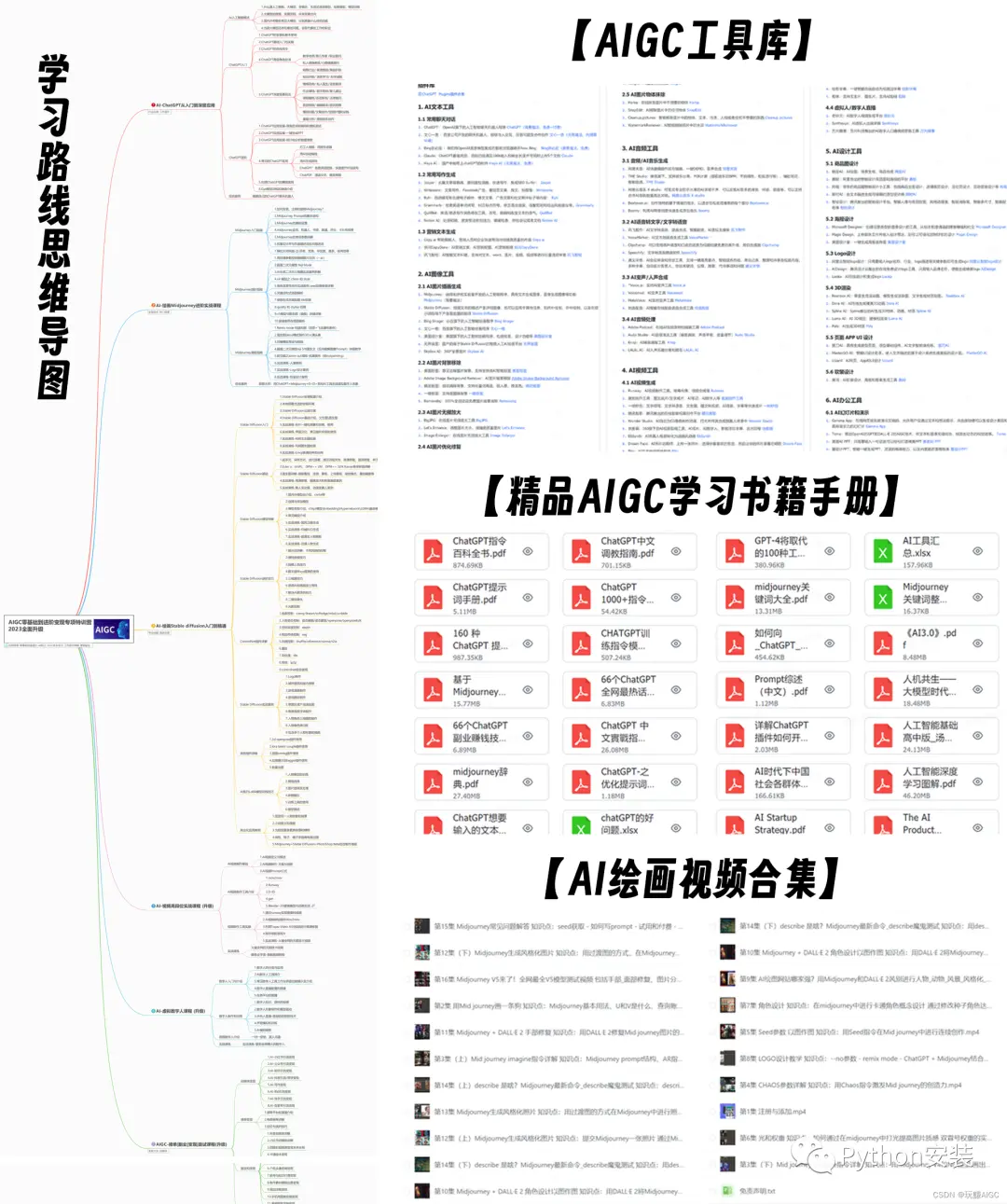

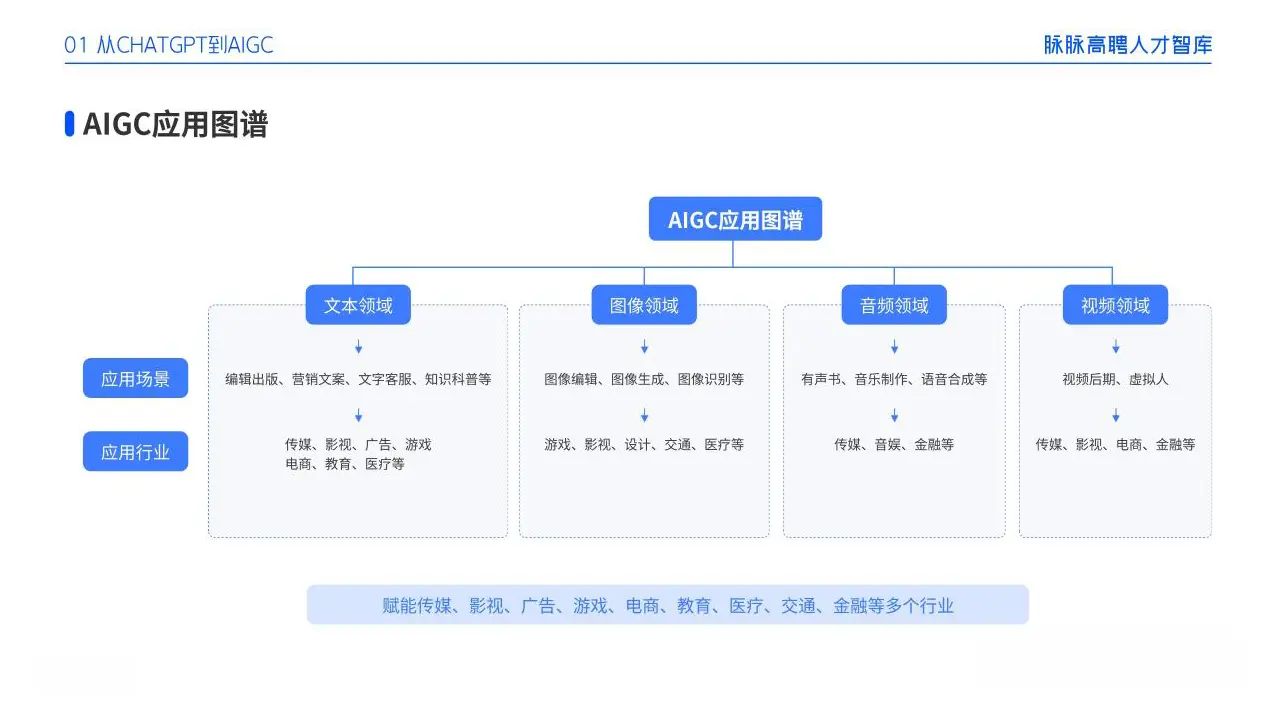

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

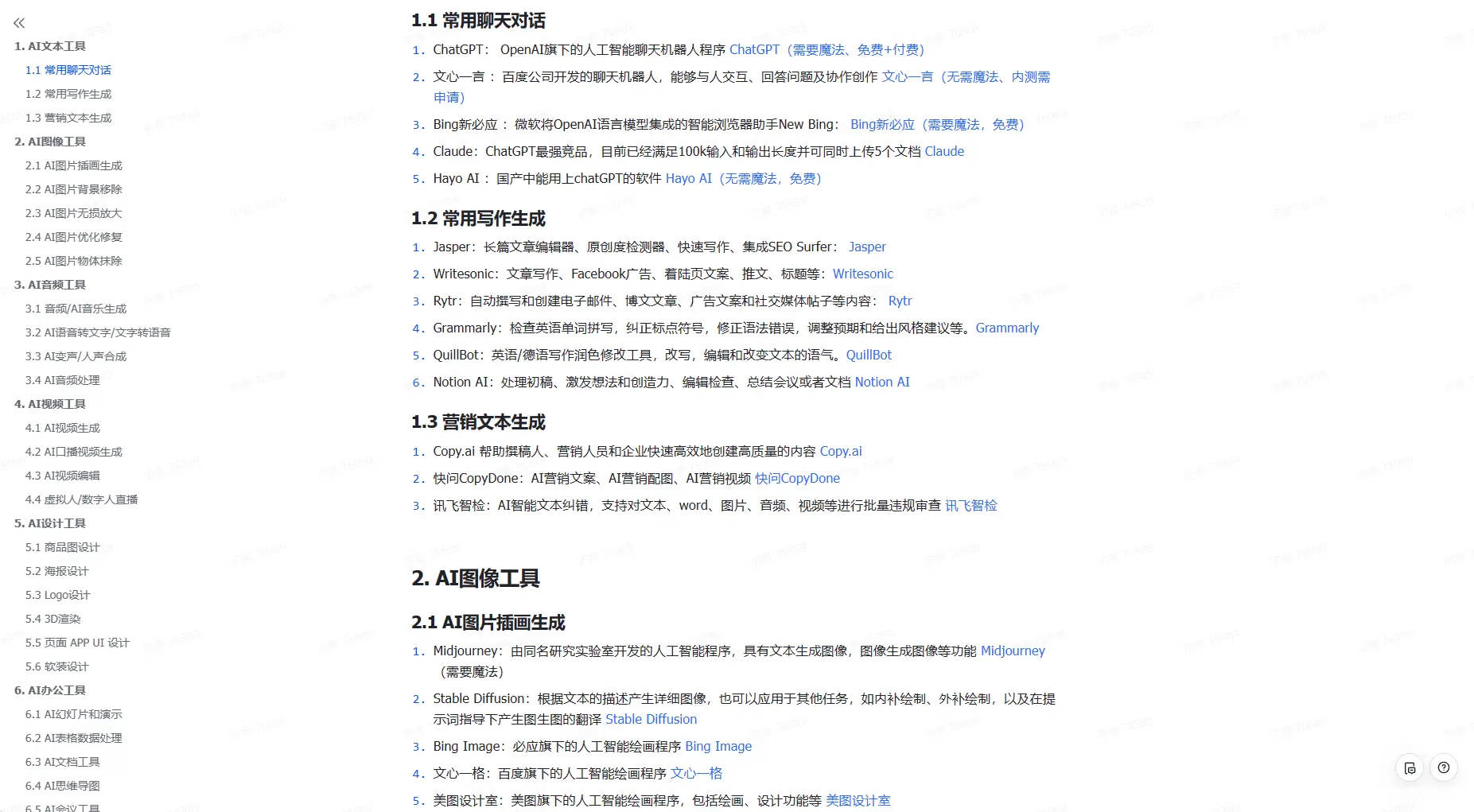

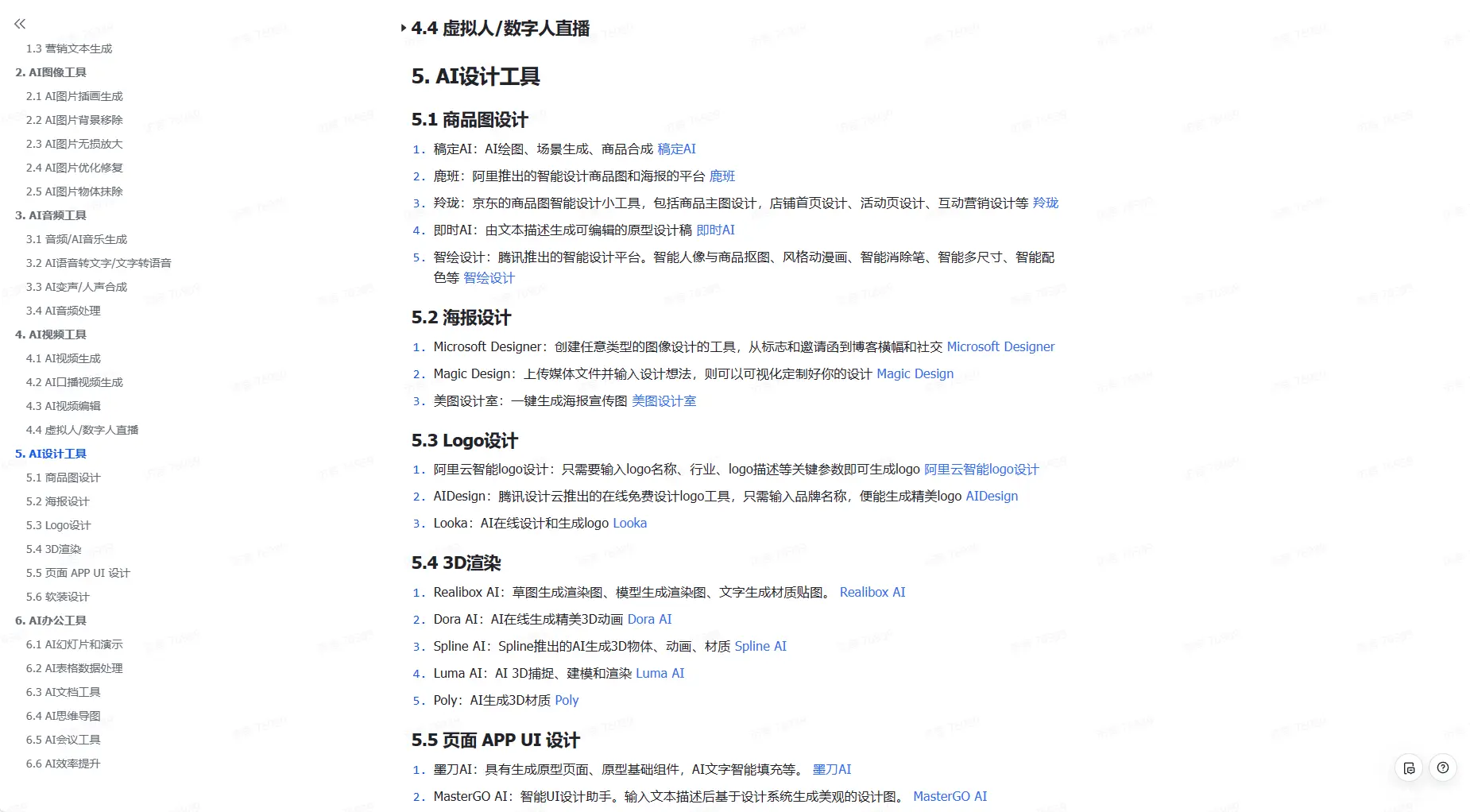

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

若有侵权,请联系删除

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。