如何测试AI对话模型/智能体?看这篇就够了

blues_C 2024-07-29 11:01:02 阅读 98

如何测试AI对话模型/智能体?看这篇就够了

定义应用范围技术测试重点测试策略1.功能测试2.性能测试3.安全性测试4.兼容性测试5.异常处理测试

结语

定义

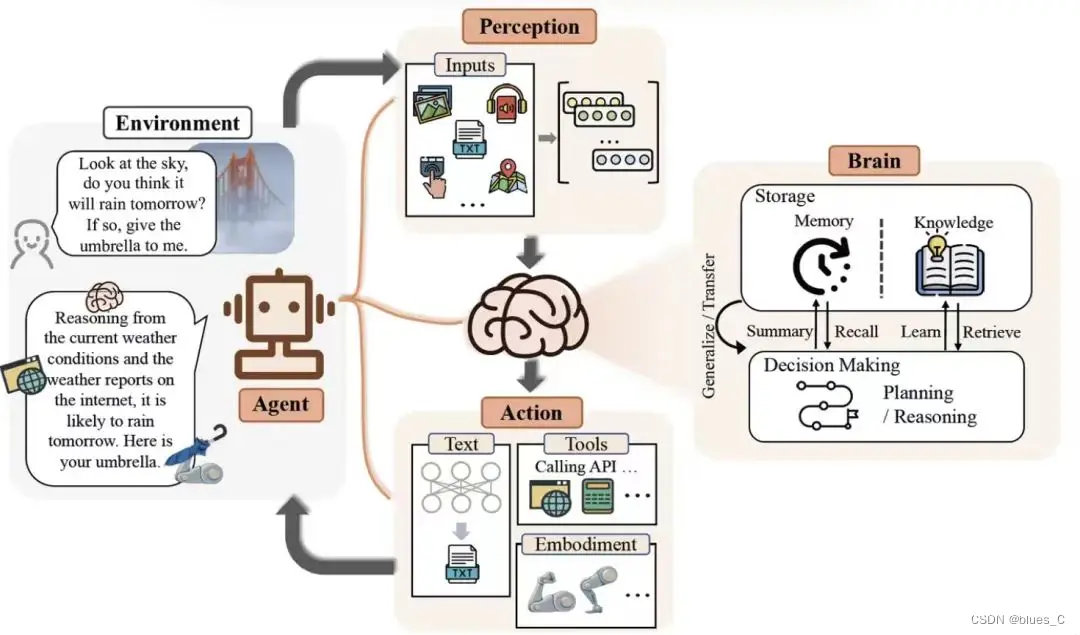

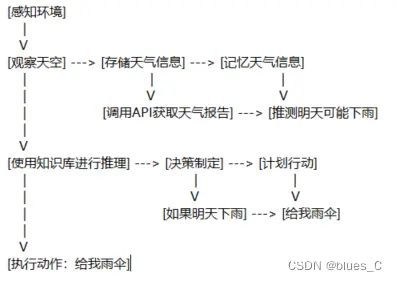

AI对话模型/智能体是专门设计用来模拟人类对话的AI系统,可以理解和生成语言以进行交流。

应用范围

主要用于聊天机器人、虚拟助手、客户服务自动化等场景。

技术

核心是自然语言理解(NLU)和自然语言生成(NLG),也可能结合机器学习、深度学习等技术。

测试重点

生成内容的准确性:

确保AI对话模型生成的回复在信息上是准确无误的,包括事实、数据和引用的正确性。

生产内容的合理性:

验证AI生成的对话内容是否逻辑连贯、上下文相关,并且符合正常交流的流程。

评估内容的创意性:

评价AI对话模型在生成回复时所表现出的创造性和原创性,特别是在处理开放式问题或创造性任务时。

评估内容的伦理标准:

确保AI对话模型的回复遵守社会伦理规范,避免产生歧视性、不当或冒犯性的内容。

用户意图的理解:

测试AI对话模型是否能够准确识别和理解用户的查询意图,即使在表达模糊或多义的情况下。

交互的自然性:

评估AI对话模型的回复是否流畅自然,是否能够模仿人类的对话风格和习惯。

多语言和方言支持:

对于多语言环境下的AI对话模型,测试其对不同语言和方言的识别和生成能力。

文化适应性:

确保AI对话模型在不同文化背景下的回复是恰当的,避免文化误解或不敏感。

安全性和隐私保护:

测试AI对话模型在处理用户数据时的安全性,确保用户隐私不被泄露。

异常和错误处理:

评估AI对话模型在遇到无法理解的输入或系统错误时的应对策略和提示信息。

可访问性和包容性:

确保AI对话模型对所有用户都是可访问的,包括有视觉、听力或其他障碍的用户。

性能和响应时间:

测试AI对话模型的响应速度,确保用户体验不因系统延迟而受到影响。

通过这些测试重点,可以全面评估AI对话模型的性能,确保其在实际应用中既智能又可靠。

测试策略

1.功能测试

功能测试是确保AI对话模型能够理解和回应用户输入的基础。

基础对话测试:通过设定标准对话场景,如问候、询问等,来验证模型的响应是否符合预期。

多轮对话连贯性测试:构建连续的对话场景,评估模型在处理多轮对话时的稳定性和逻辑连贯性。

特殊场景处理测试:模拟包含敏感话题或幽默元素的场景,检验模型的适应性和恰当回应能力。

多语言能力测试:评估模型对不同语言的识别和生成能力,确保其能够服务于多语言用户群体。

2.性能测试

性能测试关注AI对话模型在不同使用场景下的表现。

响应时间测试:使用专业工具测量模型的响应速度,确保用户能够获得及时反馈。

并发用户处理测试:模拟多用户同时使用模型的场景,检验模型的并发处理能力和稳定性。

负载测试:逐步增加对话请求的数量,评估模型在高负载情况下的性能表现。

3.安全性测试

对抗性攻击测试:通过生成对抗性样本,测试模型对恶意攻击的防御能力。

隐私保护测试:确保模型在处理包含敏感信息的对话时,能够保护用户隐私不受侵犯。

数据安全性测试:评估数据在存储、传输和处理过程中的安全性,防止数据泄露。

4.兼容性测试

操作平台和浏览器兼容性测试:验证模型在不同操作系统和浏览器上的表现。

5.异常处理测试

异常输入测试:通过输入异常数据或模拟异常情况,检验模型的容错和异常处理机制。

结语

一个高效、智能且可靠的AI对话模型,不仅是技术进步的体现,更是对人类交流方式的一次革新。它需要在准确性、合理性、创意性、伦理性、用户意图理解、自然性、多语言支持、文化适应性、安全性、隐私保护、异常处理、可访问性以及性能响应上达到高标准。

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。