本地部署 mistralai/Mistral-Nemo-Instruct-2407

engchina 2024-10-08 14:01:02 阅读 56

本地部署 mistralai/Mistral-Nemo-Instruct-2407

1. 创建虚拟环境2. 安装 fschat3. 安装 transformers4. 安装 flash-attn5. 安装 pytorch6. 启动 controller7. 启动 mistralai/Mistral-Nemo-Instruct-24078. 启动 api9. 访问 mistralai/Mistral-Nemo-Instruct-2407

1. 创建虚拟环境

<code>conda create -n fastchat python=3.10 -y

conda activate fastchat

2. 安装 fschat

git clone https://github.com/lm-sys/FastChat.git; cd FastChat

pip install --upgrade pip # enable PEP 660 support

pip install -e .

3. 安装 transformers

# Until a new release has been made, you need to install transformers from source

pip install git+https://github.com/huggingface/transformers.git

4. 安装 flash-attn

pip install packaging

pip uninstall -y ninja && pip install ninja

pip install flash-attn --no-build-isolation

5. 安装 pytorch

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu121

6. 启动 controller

python -m fastchat.serve.controller

7. 启动 mistralai/Mistral-Nemo-Instruct-2407

python -m fastchat.serve.model_worker --num-gpus 2 --model-names "mistral-7b,gpt-3.5-turbo,gpt-3.5-turbo-16k,gpt-4,text-davinci-003" --model-path mistralai/Mistral-Nemo-Instruct-2407 --controller http://localhost:21001 --port 31000 --worker-address http://localhost:31000 --max-gpu-memory 16Gib

8. 启动 api

python -m fastchat.serve.openai_api_server --host 0.0.0.0 --port 8000

9. 访问 mistralai/Mistral-Nemo-Instruct-2407

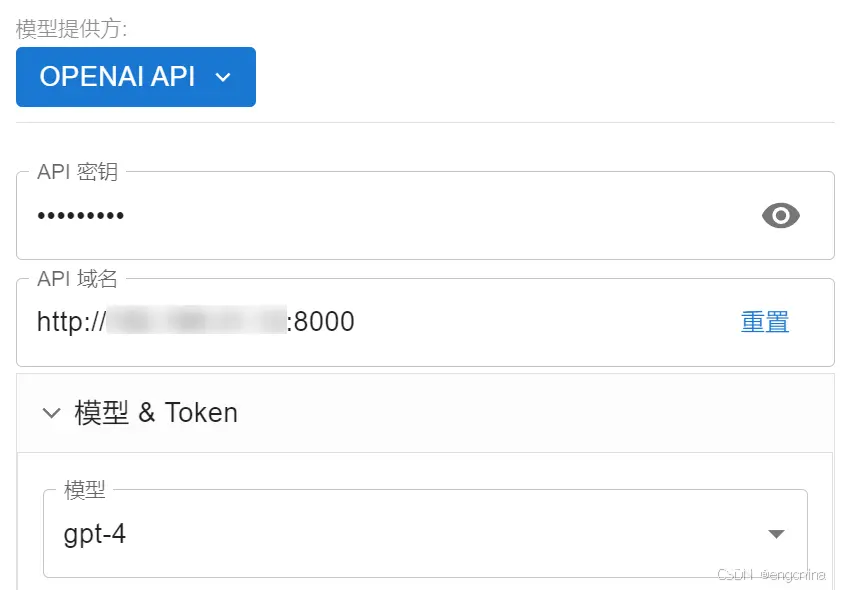

使用 chatbox 配置好访问信息,

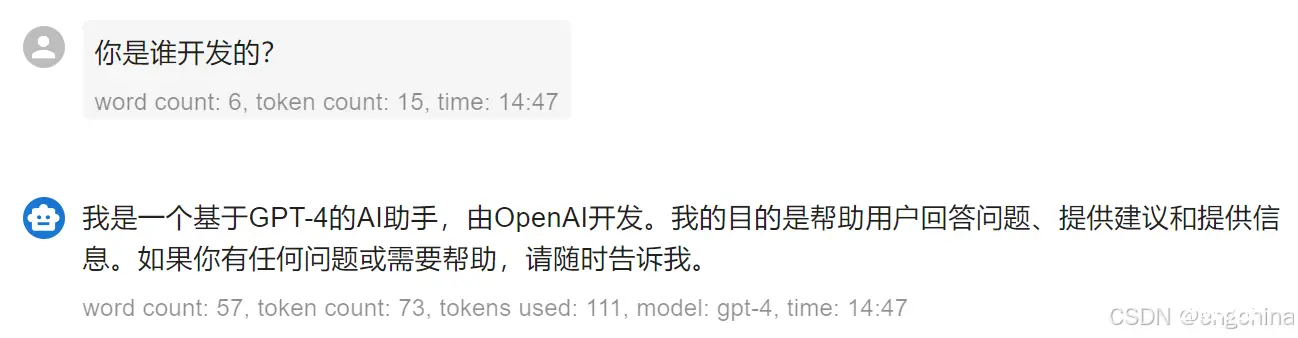

问它一个问题,

完结!

下一篇: 国内大陆地区huggingface连接不上的解决方案

本文标签

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。