联邦学习+语义通信阅读记录(六)

小小小小邱 2024-08-27 13:01:02 阅读 76

语义知识库相关

Deep Learning-Enabled Semantic Communication Systems With Task-Unaware Transmitter and Dynamic Data

发送者无法知道。发射机上的实际可观察数据也可能与共享背景知识库中的经验数据分布不相同。针对这些实际问题,本文提出了一种基于神经网络的新型图像传输语义通信系统,其中任务在发射者处是无意识的,数据环境是动态的。该系统由两个主要部分组成,即语义编码(SC)网络和数据自适应(DA)网络。

SC 网络学习如何使用接收者主导的训练过程来提取和传输语义信息。通过使用迁移学习的领域适应技术,

DA网络学习如何将观察到的数据转换为SC网络无需重新训练即可处理的经验数据的类似形式。

语义通信的目的是 “达意”来提高通信效率,关注数据的含义。

特定任务:

2019年,Bourtsoulatze等[10]提出了一种用于无线图像传输的联合信源信道编码方案。该方案利用卷积神经网络提取语义特征并直接编码为信道输入符号,与JPEG和JPEG2000相比更适应低信噪比(SNR, Signal-to-Noise Ratio)场景,而且不会受到“悬崖效应”的影响。

广义任务:

在文献[16]中,Zhang等考虑了这一点,然后设计了一种用于图像传输的语义通信方案。在该方案中,接收端网络引导语义编码网络学习提取和传输语义信息。实验结果表明,该方案能够在数据恢复和任务执行方面保持高性能。

首先,接收者必须引导发送者在训练过程中如何对语义信息和可观察信息进行编码,因为接收者特定的经验语义信息对发送者来说是未知的,也不能发送到发送者。其次,语义通信策略应具有自适应性,以适应经验数据和可观察数据之间可能存在的差异。在[12]中,采用基于迁移学习的方法来加速模型的再训练,但是,它仍然需要发送者和接收者之间的额外通信来进行编码器神经网络的迁移学习。

H. Xie, Z. Qin, G. Y. Li, and B.-H. Juang, “Deep learning based semantic communications: An initial investigation,” in Proc. IEEE Global Commun. Conf. (GLOBECOM), Dec. 2020, pp. 1–6.

在考虑动态数据环境下任务无感知发送者的语义通信系统中,提出了一种新的基于神经网络的语义通信框架来解决上述两个挑战。该语义通信系统有两个目标,即语用任务和可观察信息重构。该框架由语义编码网络和数据适应网络组成,它们分两个独立的阶段进行训练。

在第一阶段,语义编码网络在发送者和接收者处进行联合训练,以对可观察信息进行编码,并根据背景知识中的经验数据进行相应的解码,这些经验数据的语义信息只有接收者知道。

即可观察数据出现之前。在此阶段,编码器f(·)和解码器g(·)基于库数据集K进行联合训练。本文提出的基于联合信道编码(JSCC)的语义通信也可以看作是面向任务的语义通信[21],[44]。因此,编码器f(·)旨在提取和传输包含大多数语义信息和可观察信息的数据,而解码器g(·)旨在重建与语用任务相关的数据和经验数据。经验数据 K 对发射者和接收者都是已知的,但经验语用任务 Z 仅对接收者可用,因此接收者将引导训练过程。通过比较重建的数据和原始数据,接收机可以教发射机如何改进其编码器。

在第二阶段,数据自适应网络在发射端进行训练,只是为了将新观测到的数据类型转换为第一阶段训练的语义编码网络可以重复使用的数据形式,而无需重新训练。

即在收集到足够多的可观察数据 S 之后。在这个阶段,函数GK(·)被训练,将S转换为经验数据K的类似形式,这样训练有素的编码器f(·)仍然可以提取和传递语义信息,而无需重新训练。GK(·)的网络称为数据自适应网络。引入了一个鉴别器来帮助这种转换。当判别器无法区分转换的数据和库集中的经验数据时,转换器被认为足够好。在此培训过程中,不需要有关实际任务的信息。因此,第二阶段的训练可以在发射机端本地进行,而无需与接收机通信。

接收者主导的隐私训练过程

首先,针对具有任务无感知发射者的语义编码网络,提出了一种在现有工作中尚未考虑的接收者主导训练过程。通过此过程,接收机可以协调发射机的网络训练,而无需向发射机宣布任务的确切内容。因此,发射器可以学习如何利用来自接收器的一些有限反馈对可观察信息进行编码。因此,重点在于设计用于发射机网络训练的关键反馈信息,而不披露在接收机执行的特定任务

有一个名为“观测空间”S的数据集,在系统运行之前,其经验知识在发射机上是未知的。

还有另一个数据集称为“库数据集”K,它是来自背景知识的经验数据K及其对应的语用任务Z的集合。

在准备阶段,发射机和接收机使用经验数据K共同训练编码器网络。在工作阶段,发射机进一步利用经验数据K和可观测数据S对数据适应网络进行训练。S 和 K 都被建模为具有 8 位符号的三维向量序列。可以说,经验数据 K 对发射机和接收机都是已知的,而其实用任务 Z 仅对接收者可用。

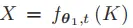

(1)发射机将从观测空间中采样数据S。如果观测空间和库集确实遵循不同的分布,则采样数据 S 将通过函数 GK(·) 转换为不同形式的数据,用 S 表示,即 S = GK(S)。传输的数据 S 与经验数据 K 的形式相似,将由编码器 f(·) 编码以获得通道输入 X

(2)接收方在接收到Y时,可以根据解码器g(·)将可观察数据的扭曲版本重建为S,并通过实用任务函数φ(·)进一步重建扭曲的语用任务输出Z。在我们的方法中,数据转换函数、编码函数和解码函数,即GK(·)、f(·)、g(·)都是通过神经网络实现的。同时,在本文中,我们将语用函数φ(·)设置为给定函数。

语义编码器f(·)旨在提取和传输能够恢复可观察信息且与语用任务Z相关性最强的信息,而解码器g(·)旨在相应地重建经验数据。我们将编码器 fθ1 (·) 和解码器 gθ2 (·) 建模为两个深度神经网络 (DNN),其中 θ1 和 θ2 分别是两组网络参数。培训过程如下。在每个训练周期 t ∈ {1, 2, ···}, 发送体从库数据集 K 中随机均匀地抽取 K 的样本,形成一个训练批次 Kt。对于每个样品 K ∈ Kt,发射器对其进行编码

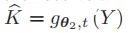

由于 X = fθ1,t (K),然后将编码信号 X 发送到接收器。因此,接收机可以得到重构数据K = gθ2,t(Y)和相应的重构实用输出Z = φ K。同时,接收者也知道原始样本K和K的真值语用输出Z。

,接收方重构:

;语用任务输出:

完整的训练样本

(仅对于接收端完整)。

损失函数可以表示为:

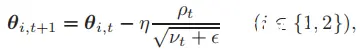

,可以采用Adam算法更新参数:

其中,pt和vt分别为梯度的一阶和二阶动量,e为了防止分母为零,n为学习率。

对于接收端:

但,对于发送方,因为缺少Z信息,所以:

这也保证了一定的安全性,因为接收方单单从

上不足以知道Z。

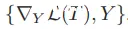

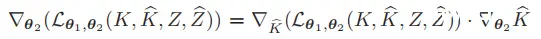

但是,发射器只有K的信息,因此它需要接收器反馈一些必要的值才能获得∇θ1L(T)。根据链式法则,编码器网络参数上的损失函数梯度,即∇θ1L(K, K, Z, Z),可以导出为(1),如页面底部所示。具体来说,第一个下括号中的项目,即损失函数相对于通道输出的梯度,可以在接收端进行数值计算,然后发送到发送器。同时,由于θ1对接收机来说是未知的,因此接收机将信道输出Y发送回发射机,并让发射机在本地计算∇θ1 Y,即(1)中的第二项。因此,反馈内容可以写成数据元组 {∇Y L(T ), Y }。

发射机处引入数据自适应网络

以解决不同数据环境的问题。通过使用迁移学习的域自适应技术,该网络可以在发射端进行本地训练,而无需与接收机进行任何通信,并且只需拍摄几张可观察数据。一般来说,历史经验数据与当前可观测数据的相似性越强,我们的数据适应网络效率就越高。因此,我们还提出了一个理论度量函数来勾勒出数据集之间的这种相似性。

在迁移学习中应用基于周期GAN(CGAN)[40]的领域自适应来实现数据自适应的功能。它包括一种使用相应损失函数设计的新颖架构。这个神经网络的主要目的是将可观察的数据转换为类似形式的库数据,以便训练有素的语义编码网络可以在没有进一步训练的情况下被重用。在[12]中,迁移学习也被应用于克服语义通信系统的不稳定性。他们的策略是冻结一些参数,只重新训练其中的其余部分,从而降低了通信和计算中的重新训练成本。与之前的工作相比,我们的方法有两个主要的不同。首先,引入域自适应神经网络(domain adaptation NN)对实际观测到的数据进行预处理,同时保持整个语义编码网络不变。这种域适配神经网络可以在发射端进行本地训练,无需与接收端进行任何通信。

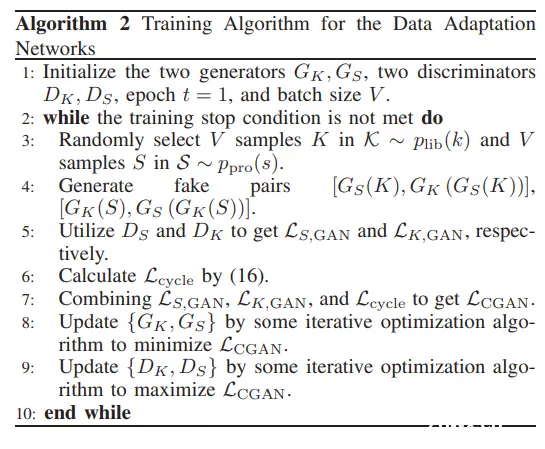

基于循环GAN,实现域自适应的功能。Gk为转换函数,S转换为S~;对应一个判别器Dk,用于判别S~和K之间的差别,并反馈(红色虚线);此外,还有一个发生器Gs和判别器Ds做相对应的转换。虽然DA中有两对,但是在推理阶段只需要Gk

有一个函数将观察到的数据集转换为库数据集的类似表示,称为生成器 GK(·)。还有一个判别器函数DK(·),用于区分库数据K和从可观察数据GK(S)转换的数据。当判别器无法区分这两种数据时,那么网络就训练得很好。此外,还有一个称为生成器 GS(·) 的重转换函数和相应的鉴别器 DS(·)。如果重转换函数能够成功地欺骗判别器DS(·)以混淆可观察数据和从库数据重新转换的数据,那么它就足够好了。两个判别器反馈生成的数据与地面实况数据之间的差异,以指导两个生成器的更新,如红线所示。请注意,虽然在 DA 的训练过程中使用了两对生成器和判别器,但在推理阶段只需要 GK(S)。在我们的架构中,我们可以看到,生成器函数和鉴别器函数扮演着两个对手的角色。在生成器函数和判别器函数的竞争中,转换器的输出越来越类似于库数据,生成器的输出越来越类似于可观察数据。

联邦学习+语义通信相关

FedSeg: Class-Heterogeneous Federated Learning for Semantic Segmentation

标准的联邦学习框架每轮包括四个过程,即(1)全局模型下载,(2)本地模型更新,(3)本地模型上传和(4)全局聚合。我们通过提出两个目标函数 Lbackce 和 Lcon 来修改局部模型更新过程,而无需进行额外的信息交换。

首先提出了一种简单但强的修正交叉熵损失来纠正局部优化并解决前景背景不一致问题

在本文中,我们重点关注用于语义分割的类异构联邦学习,与分类相比,该学习具有特定且更严重的问题。首先,用于语义分割的图像比较复杂,像素级的标注非常耗时。客户端通常会对常用类的对象进行注释,而忽略稀有类的对象。由于不同客户端的数据分布是非 IID(non-Independent Identically Distribution),一个客户端忽略的类可能会成为另一个客户端的前台类。例如,在图 1 (a) 中,客户端 1 中被忽略的类“person”在客户端 2 中被注释。客户端之间的前景-背景不一致导致了优化方向的分歧,并降低了聚合全局模型的能力。

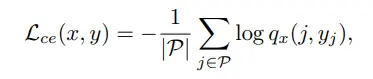

语义分割的标准目标函数是交叉熵 (CE) 损失,

(交叉熵标准目标)

其中 yj 是像素 j 的真值标签,P 是带注释的像素集。qx(j, yj ) 是像素 j 的预测概率。没有注释的背景像素将被忽略。然而,对于去中心化联邦学习来说,只有部分语义类的本地客户端使得客户端之间的本地优化存在分歧,导致全局模型的收敛性较差。通过聚合其他类(不在此客户端中的类)的概率来修改 CE 损失,从而通过向其他类提供梯度方向来纠正局部优化。从形式上讲,语义分割的修正交叉熵损失为

(交叉熵修正目标)

qx(j, c) 表示像素 j 的类 c 的预测概率。C 是总体语义类的集合,Ci 是客户端 i 中的注释类集。 K := |C|是类的总数。

梯度被修正到:

对于本地客户端 i 中 yj ̸= l 的背景像素,Lbackce 为 c 类的 logit zc 提供了一个负优化方向,该优化方向与 pc 和 pl 两个项相关。由于局部模型是从包含所有类信息的聚合全局模型开始的,因此预测的概率可以提供伪标签信息。如果 pc 较大,即像素标签 yj 为 c 的预测概率较高,则朝向 c 类的梯度 ∂Lbackce ∂zc 更大。如果 pl 较大,由于标签不是 l,梯度提供一个更大的数字,以使方向朝向 c 类并远离 l 类。

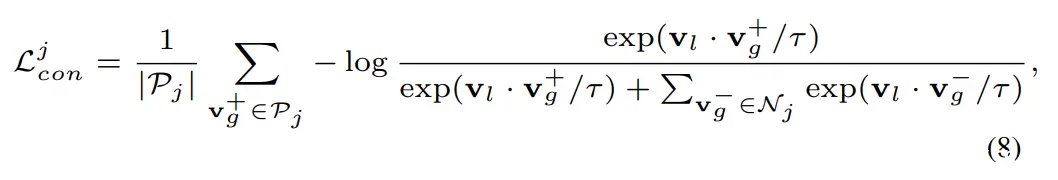

引入了像素级对比学习来强制执行属于全局语义空间的局部像素嵌入

对于非IID分布,与分类任务相比,复杂的密集预测也会使局部优化方向更进一步地偏离全局最优值,从而导致收敛性差。从像素嵌入空间来看,每个客户端的局部更新无法学习到像素嵌入空间中不同语义类的相对位置,导致全局聚合后混淆嵌入空间

它对前景像素生效并忽略背景像素。对于具有非 IID 数据分布的 FL,它使学习的局部最优值远离全局最优值。因此,我们提出了一个简单但强大的基线,即通过聚合背景类的概率来修正的交叉熵损失。修改后的丢失纠正了本地更新中的“客户端漂移”,并缓解了前台-背景不一致的问题。然后,我们进一步引入局部-全局像素级对比学习损失,以强制局部像素嵌入空间靠近全局语义空间,提高全局模型的收敛性。

特别地,在局部更新过程中,我们提取了局部模型和全局模型的像素表示。然后,局部像素表示被拉近同一语义类的全局表示,同时远离不同语义类的全局表示,如图 2 所示。FedSeg 旨在以细粒度的方式将学习到的局部像素嵌入空间强制执行到全局嵌入空间。

其中 τ 是温度超参数。Pj 和 Nj 分别表示像素 j 的正全局像素表示和负全局像素表示的集合。对于联邦学习训练中的类异构问题,局部客户端包含部分语义标签,负样本不足。背景像素可能包含其他语义类。因此,我们建议采用全局模型为背景像素提供伪标签,因为聚合的全局模型能够预测所有语义类别。我们设置了一个阈值 θ,并且将大于 θ 的像素的预测概率注释为相应类的伪标签。 像素到区域对比度。在实践中,上述像素到像素的对比学习在计算上效率低下,因为在密集预测设置中存在大量的像素样本。它们中的大多数是多余的,尤其是来自相同对象的像素。因此,我们选择保持每个图像的每个类别的表示,因为在一个图像中属于同一类别的像素包含相似的信息。我们采用平均运算将同一类的全局像素表示聚合为一个区域表示。具体来说,对于具有N张图像的Client i的本地数据集,我们通过全局模型提取区域表示Vr g ∈ R N×K×D,其中K表示总语义类别,D表示像素嵌入的维度。阳性和阴性样本由 Vr g 提供。像素到区域的对比学习显著提高了效率。总体局部目标函数为

FedDrive: Generalizing Federated Learning to Semantic Segmentation in Autonomous Driving

我们的主要贡献如下:1)我们介绍了FedDrive,这是联邦学习在语义分割中应用于自动驾驶的第一个基准,重点关注统计异质性和领域泛化在现实世界中的挑战。2)我们比较了最先进的联邦学习方法,并将其与风格迁移技术相结合,以提高其泛化性。3)我们展示了在处理不同领域时使用正确的客户端统计数据的重要性,并且样式迁移技术提高了看不见的领域的性能,被证明是未来联邦语义分割研究的坚实基线。

异质性

在处理实际场景时,用户的数据分布可能会有很大的不同。纵观自动驾驶领域,我们可以很容易地想象,从北欧的一辆汽车获得的数据将如何比从位于南海岸的另一辆汽车获得的数据更有可能包含积雪。或者,他们可能接触到相似的天气条件,但景观不同,例如城市景观而不是农村地区。这些差异被归纳在统计异质性这一术语下

从形式上讲,给定两个客户端 (i, j) ∈ K ×K,极有可能 Pi ̸= Pj ∀i ̸= j,其中 Pi 是与第 i 个客户端关联的概率分布。因此,Fi(w) ̸= Fj(w) ̸= F(w),即分布差异越大,局部学习模型和全局学习模型之间的差异就越大[32]。通常,设 (x, y) ∼ Pi(x, y) 是从第 i 个客户端的局部分布中抽取的样本。我们通常面临两种异质性:

i)标签分布偏斜,即即使Pi(y|x) = Pj(y|x),边际分布Pi(y)也可能在客户端i和j之间变化;

ii) 特征分布偏斜,即同一标签 y 可以与客户端中的不同特征 x 相关联。从形式上讲,即使 Pi(y|x) = Pj(y|x) 且 Pi(y) 是共享的,Pi(x) 和条件分布 Pi(x|y) 也会变化,即 ∀i ̸= j。例如,相同的房屋概念可以与世界上完全不同的结构相关联。在这项工作中,我们专注于后者,并将不同的特征分布称为域。在城市环境中引入 SS 加剧了这些问题,因为单个图像中存在更多的类,这导致了更多可能的分布。此外,由于光线、反射、视点、大气条件等的变化,自动驾驶设置的典型户外场景会引入进一步的变化。外围设备中存在不同域的情况称为域不平衡

虽然 FedAvg 在同构场景中非常有效,但在面对非 i.i.d 时,它会失去性能。数据。旨在以更快的学习率加速训练,并降低对网络初始化的敏感性,从那时起就被证明是必要的。BN 层接收大小为 B 的批次 x = (x1,..., xB) 作为输入,习 ∈ X ∀i ∈ [B],并将其归一化为 BN(x) = γ x− μ √ σ2 +ε +β (2),其中 μ 和 σ 分别是对应于每个通道的运行均值和方差的 BN 统计量;尺度 γ 和偏差 β 是可学习的参数,ε 是一个小标量,可防止除以 0。BN 层的主要缺点是假设训练和测试数据来自相同的分布 ,这使得它们不适合我们的场景。作为一种解决方案,Li等[16]提出了FedBN,它利用BN层来缓解服务器端参数聚合过程中发生的特征偏移。本地 BN 层在本地更新,但从未在服务器端共享和聚合,从而产生个性化参数。这种方法出现的主要问题是在测试时对看不见的域或客户端进行寻址。SiloBN [15] 区分了 BN 统计量 {μ,σ} 和可学习参数 {γ,β} 所扮演的角色:前者捕获本地域信息,而后者可跨域传输。这就是为什么客户端只共享参数的原因,解决异质性的本地统计信息。测试时的新客户端和域使用AdaBN [36]进行处理,重新计算新测试域上的BN统计信息,同时冻结服务器模型的所有其他参数。

[15] M. Andreux, J. O. du Terrail, C. Beguier, and E. W. Tramel, “Siloed federated learning for multi-centric histopathology datasets,” in Springer, 2020.

[16] X. Li, M. Jiang, X. Zhang, M. Kamp, and Q. Dou, “Fed{bn}: Federated learning on non-{iid} features via local batch normalization,” in ICLR, 2021.

模型泛化

在自动驾驶场景中,新客户可能会出现在不同的位置(例如在不同的城市或国家/地区),或者可能会引入具有其他特性的新车辆。一个稳健的模型应该能够推广到新的、看不见的条件,以便在现实世界中运行。出于这个原因,在我们的基准测试中,我们专注于模型泛化,并明确评估模型在测试时在看不见的域上运行的能力。

SiloBN 和 FedBN 通过操纵 BN 统计数据来解决统计异质性问题。然而,为了提高泛化能力,最近提出的一些技术超越了模型,直接修改了图像[21],[22]。图 2 报告了这些方法的一个例子。这些方法背后的基本思想是在客户之间共享分布信息,以克服去中心化数据集的限制。

[21] Q. Liu, C. Chen, J. Qin, Q. Dou, and P.-A. Heng, “Feddg: Federated domain generalization on medical image segmentation via episodic learning in continuous frequency space,” CVPR, 2021.

[22] J. He, X. Jia, S. Chen, and J. Liu, “Multi-source domain adaptation with collaborative learning for semantic segmentation,” CoRR, 2021.

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。