Datawhale X 李宏毅苹果书AI夏令营 学习笔记

增删改查农民工 2024-09-08 10:01:01 阅读 51

学习日志

日期: 2024年8月30日

今日学习内容:

今天,我继续学习了深度学习中的优化算法,并且着重理解了如何利用动量法、RMSProp以及Adam等高级优化器来提高模型训练的效率和效果。

1. 动量法的理解:

我学习了动量法如何通过在参数更新时考虑之前的梯度方向,使得模型能够更快地朝着全局最优解的方向前进。动量法可以有效防止模型陷入局部最小值,并能够在陡峭的下降方向上加快收敛速度。

2. RMSProp的原理:

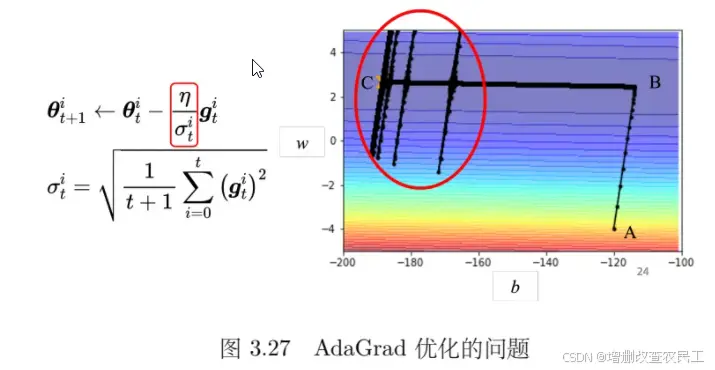

RMSProp是一种可以根据不同参数和不同时间动态调整学习率的方法。在这部分学习中,我理解了如何利用均方根(RMS)来对每个参数的学习率进行自动调整,从而在陡峭的误差表面上采取较小步伐,在平坦的表面上则加大步伐。这种方法可以有效避免学习率过大或过小导致的训练不稳定问题。

3. Adam优化器的学习:

我学习了Adam优化器的工作原理,理解了它是如何结合动量法和RMSProp的优点,通过自适应调整学习率来提高训练的效率和效果。Adam不仅在参数更新方向上具有动量,还能够动态调整学习率,使得它在实际应用中非常有效。通过Adam优化器,我了解到如何更好地在训练深度学习模型时使用合适的超参数配置。

4. 学习率调度:

学习率调度也是今天学习的重要内容之一。通过学习,我了解到如何通过动态调整学习率,避免训练过程中的“爆炸”问题,并最终平滑地收敛到全局最优解。学习率调度可以通过学习率衰减和预热的方法来实现,以确保在训练过程中能够稳定且高效地优化模型参数。

5. 回顾与总结:

今天的学习让我进一步理解了深度学习中的优化算法,特别是在梯度下降的基础上如何通过动量法、RMSProp以及Adam等方法来提高模型的训练效果。我认识到这些高级优化算法在处理复杂的误差表面时,能够通过动态调整步伐大小,使得模型更快地收敛到最优解。此外,学习率调度在训练过程中的重要性也得到了验证,它可以通过调整学习率的大小来避免训练过程中的波动和不稳定。

6. 实践与反思:

在学习的过程中,我尝试应用这些优化算法来实际训练模型,发现通过调整学习率和使用动量,可以显著提高模型的收敛速度和最终的准确率。未来,我计划继续深入研究这些优化算法的细节,并将它们应用到更多的深度学习任务中,以进一步提升模型的性能。

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。