Mistral AI最新力作——Mistral Large媲美GPT-4

人工智能大模型讲师培训咨询叶梓 2024-07-18 13:01:01 阅读 63

Mistral AI自豪地宣布,他们的最新力作——Mistral Large,已经正式面世。这款尖端的文本生成模型不仅在多语言理解上表现出色,更在推理能力上达到了顶级水平。Mistral Large能够处理包括文本理解、转换和代码生成在内的复杂多语言推理任务。

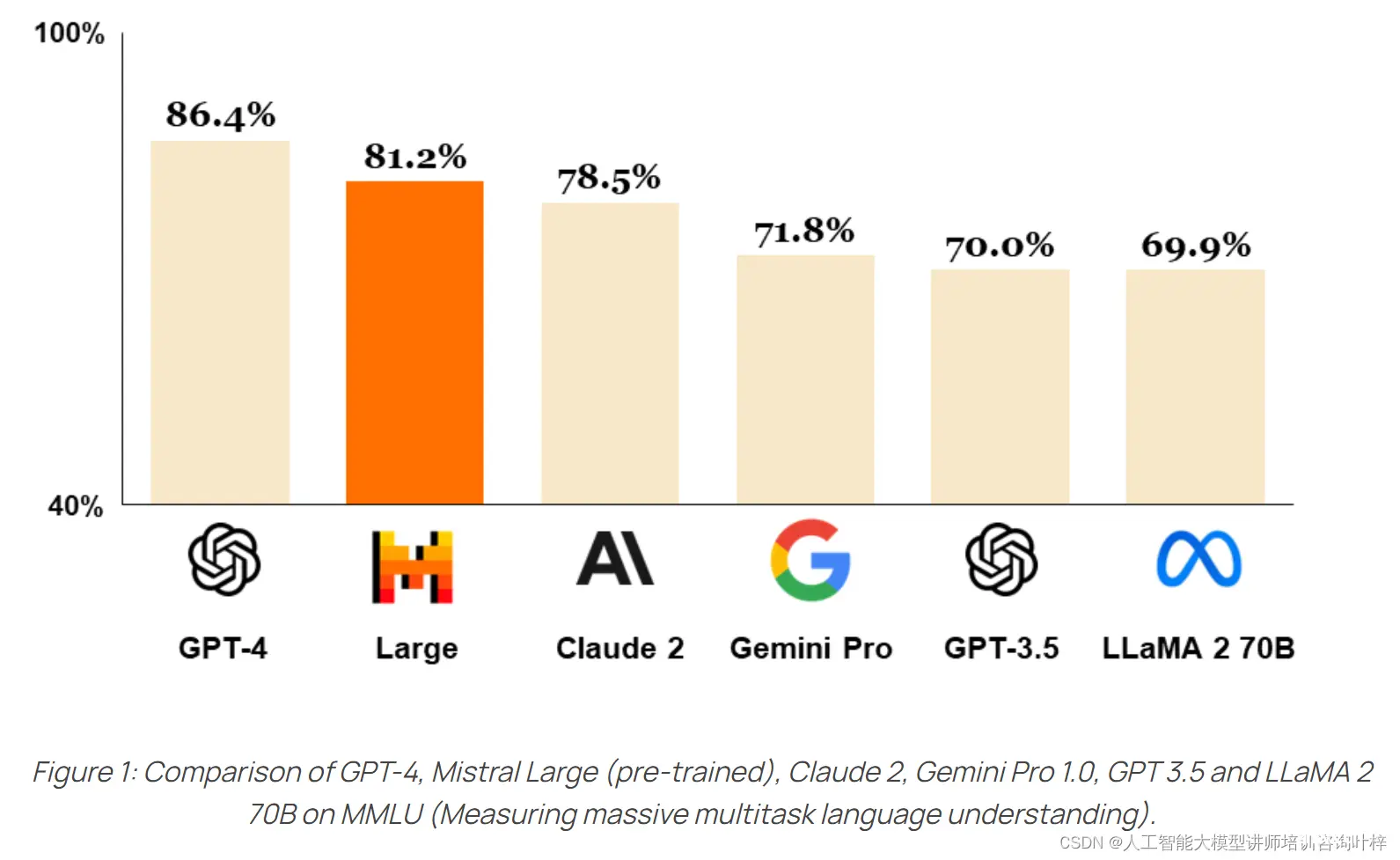

Mistral Large(预训练版本)与其他顶级语言模型(如 GPT-4、Claude 2、Gemini Pro 1.0、GPT 3.5 和 LLaMA 2 70B)在 MMLU(测量大规模多任务语言理解)基准测试中的性能比较。Mistral Large 在这个基准测试中排名第二,仅次于 GPT-4

基准测试表现

Mistral Large 在多个广泛使用的基准测试中取得了令人瞩目的成绩,这些测试包括了对常识、推理和知识理解的评估。它的成绩仅次于 GPT-4,位居全球通过 API 可普遍访问的模型中的第二名。这一成绩的取得,凸显了 Mistral Large 在处理复杂任务时的高效性和准确性。

Mistral Large 在常用基准上的性能与顶尖的 LLM 模型进行比较,包括:

MMLU:多任务语言理解

HellaS:HellaSwag 基准测试

WinoG:Wino Grande 基准测试

Arc C:Arc Challenge 基准测试,分别展示了 5-shot 和 25-shot 的结果

TriQA:TriviaQA 基准测试

TruthfulQA:TruthfulQA 基准测试

Mistral Large 在这些测试中的表现显示了其强大的推理和知识能力

多语言支持

Mistral Large 的多语言能力是其显著特点之一。它不仅原生支持英语、法语、西班牙语、德语和意大利语,而且对这些语言的语法规则和文化背景有着深入的理解。这种跨语言的流畅性和敏感度,使得 Mistral Large 能够更好地服务于全球化的应用场景。

Mistral Large、Mixtral 8x7B 和 LLaMA 2 70B 在 HellaSwag、Arc Challenge 和 MMLU 基准测试中的多语言能力,特别是在法语、德语、西班牙语和意大利语上的表现。Mistral Large 在这些语言的基准测试中显著优于 LLaMA 2 70B

上下文理解

Mistral Large 拥有一个 32K tokens 的上下文窗口,这使得它能够处理和记忆大量的信息。在处理大型文档时,这一能力尤为重要,因为它可以确保模型在生成文本时能够准确引用和回忆文档中的相关内容。

精确指令遵循

Mistral Large 的精确指令遵循能力,为开发人员提供了设计定制化内容审查政策的可能性。这种能力意味着模型能够准确地理解和执行用户的指令,从而在内容生成和审查方面提供更高的灵活性和控制力。

函数调用支持

Mistral Large 原生支持函数调用,这一特性极大地扩展了模型的应用范围。结合 Mistral AI 在 la Plateforme 上实施的输出内容限制模式,Mistral Large 能够与现有的技术栈和应用程序无缝集成,推动了开发流程的现代化和自动化。

技术栈现代化

Mistral Large 的推出,不仅仅是一个模型的更新,它还代表了 Mistral AI 对技术栈现代化的承诺。通过提供先进的语言模型,Mistral AI 旨在帮助开发者和企业构建更加智能、高效的系统,以适应快速变化的技术环境。

与微软合作Mistral Large现已在Azure AI Studio和Azure Machine Learning上提供,为开发者提供了与Mistral AI API同样无缝的用户体验。

平台部署

Mistral Large 模型目前可通过两种主要的平台进行访问和使用:

"La Plateforme": Mistral AI 自己的基础设施,安全地托管在欧洲。这个接入点为开发者提供了一个安全的环境,使他们能够跨 Mistral 提供的各种模型创建应用程序和服务。

Azure AI Studio 和 Azure Machine Learning: Mistral Large 也通过微软的 Azure 平台提供,使得用户可以利用 Azure AI Studio 的交互式环境和 Azure Machine Learning 的机器学习服务来使用 Mistral Large 模型。Beta 客户已经在使用这些服务中取得了显著的成功。

自部署选项

除了通过平台部署外,Mistral AI 还提供了自部署选项:

用户可以根据自己的需求,在他们自己的计算环境中部署 Mistral Large 模型。这种部署方式特别适用于那些对数据隐私和安全性有极高要求的敏感用例。

自部署允许用户直接访问模型权重,这意味着他们可以完全控制模型的运行环境,并根据自己的特定需求进行定制。

Mistral AI 提供了成功部署的案例故事,并鼓励有兴趣的用户联系他们的团队以获取更多详细信息。

与Mistral Large一同发布的还有Mistral Small,这是一款针对低延迟工作负载优化的新模型。Mistral Small在性能和成本上都优于Mixtral 8x7B,并具有更低的延迟,是介于Mistral AI的开源模型和旗舰模型之间的精致中间解决方案。

Mistral Large和Mistral Small的推出,为开发者和企业提供了更多的选择和可能性。现在,Mistral Large已在la Plateforme和Azure上提供,并且可以在Mistral的beta助理演示器le Chat上体验:Le Chat by Mistral AI

参考链接:Au Large | Mistral AI | Frontier AI in your hands

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。