AI论文阅读笔记 | Timer: Generative Pre-trained Transformers Are Large Time Series Models(ICML 2024)

梦魇大英雄 2024-10-14 11:31:05 阅读 99

一、基本信息

题目:Timer: Generative Pre-trained Transformers Are Large Time Series Models会议:ICML 2024原文:https://arxiv.org/abs/2402.02368源码:https://github.com/thuml/Timer

二、基本内容

1、解决什么问题

虽然深度学习对时间序列的分析做出了显著的贡献,但在数据稀缺的真实世界场景中,深度模型可能会遇到性能瓶颈,而这些瓶颈可能由于当前基准测试中小模型的性能饱和而被掩盖。现有的小模型缺乏大模型所展示的少样本泛化(few-shot generalization)、可扩展性(scalability)和任务通用性(task generality)。

2、怎么解决

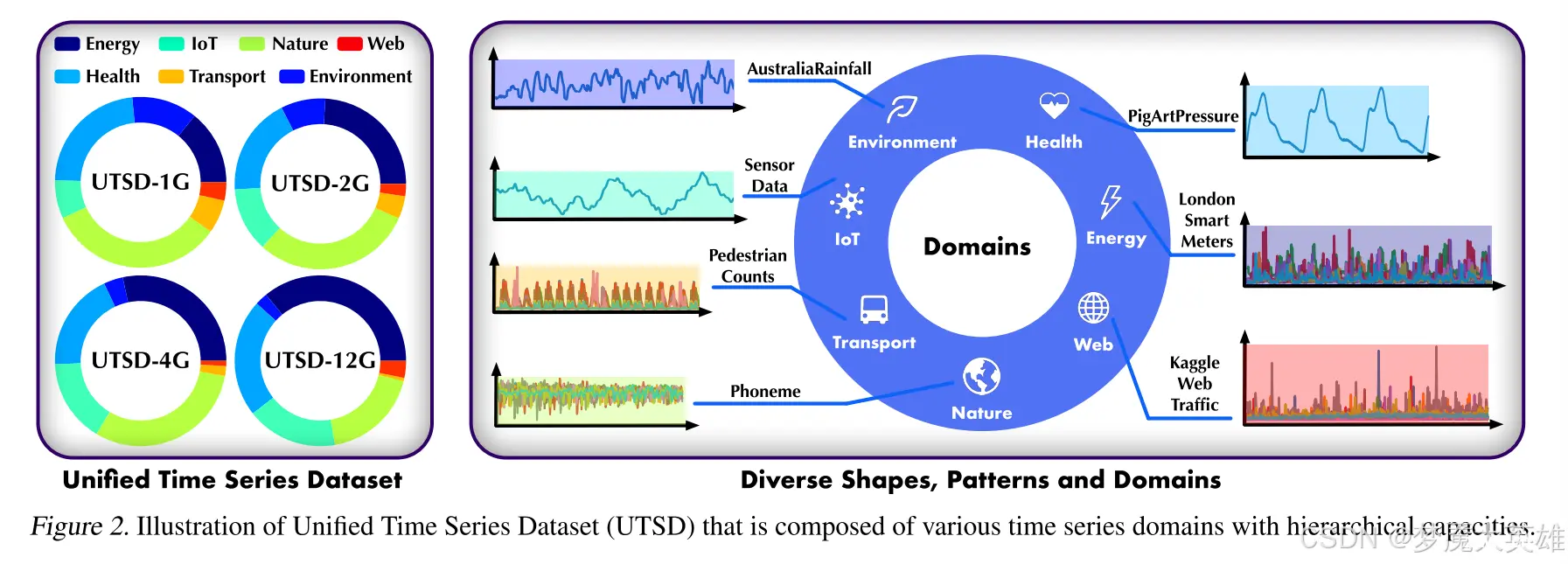

构建了统一的时间序列数据集 (Unified Time Series Dataset ——UTSD)

本文建立了筛选高质量数据和堆叠的时间序列语料库的层次标准,通过对公开的时间序列数据集进行聚合,并对聚合后的数据进行协同处理,构建了具有层次化能力的统一时间序列数据集(UTSD)如图所示。包含7个域,10亿个时间点(UTSD-12G),涵盖了时间序列分析的典型场景。

数据集链接:https://huggingface.co/datasets/thuml/UTSD

训练策略——单序列序列(S3)格式

采用生成式预训练方法,将单序列序列(S3)作为不同时间序列的标准语句,如下图所示。不同于自然语言 ,序列的幅度、频率、平稳性、数据集的变量数、序列长度等差异使得构造统一的时间序列并非易事。本文提出将异构时间序列转换为单序列序列(S3),保留了具有统一上下文长度的序列变化模式。模型观察了不同时间段、不同数据集的序列,增加了预训练的难度,使模型更关注时间变化。S3不需要时间对齐,这适用于广泛的单变量和不规则时间序列。

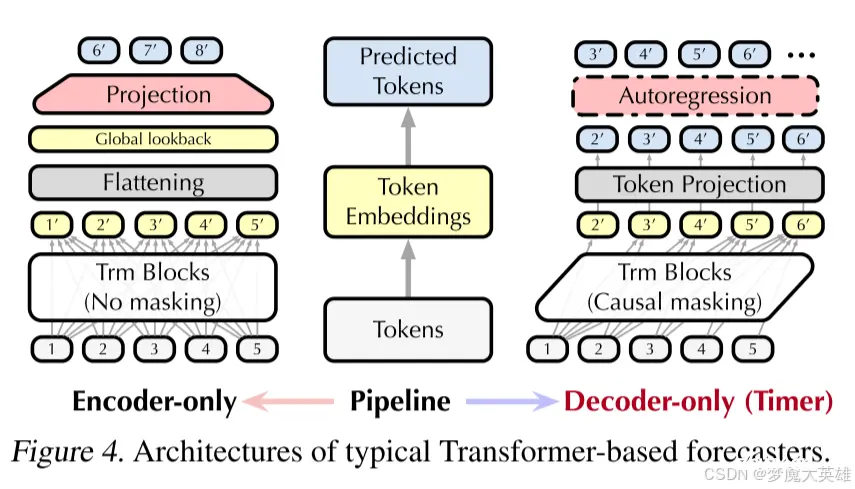

采用生成式的预训练目标

采用了GPT风格的生成式预训练目标,通过预测下一个时间点来进行预训练。将时间序列的预测、插补和异常检测转化为一个统一的生成式任务,允许模型学习时间序列的生成过程,从而在下游任务中展现出更好的泛化能力。

Timer(a large-scale pre-trained Time Series Transformer)的提出

基于以上几点,论文提出了Timer,采用与大语言模型类似的解码器结构,具备灵活的上下文长度和自回归生成能力。在多个数据集和多种任务中表现出色。

3、取得了什么效果

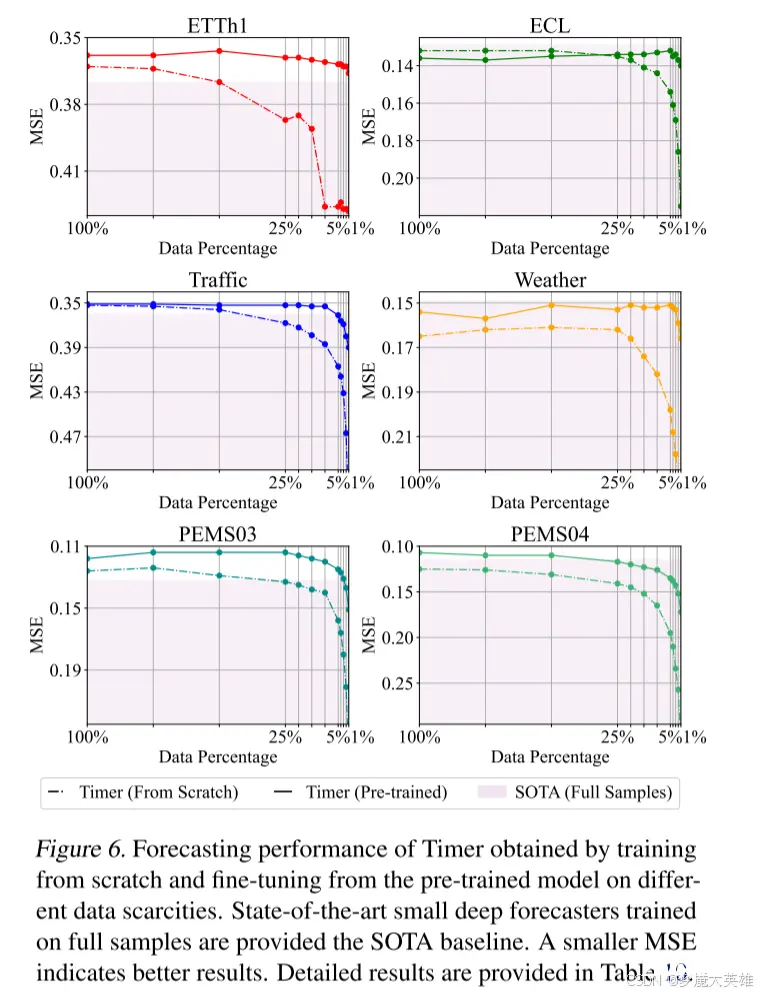

1、时间序列预测

数据集:ETT、ECL、Traffic、Weather、PEMS

SOTA: iTransformer (ICLR 2024)

实验:在不同的数据稀缺性(100%,75%,50%,25%,20%.......1%)下 ,对比了从头开始训练的Timer(虚线)和在UTSD(USTD-12G)上预训练后的Timer(实线)的性能。

结果:

Timer的性能受数据量减少的影响小于基线,随着数据数量的下降,Timer的性能均超过基线,且预训练之后的模型表现比从头训练的好。

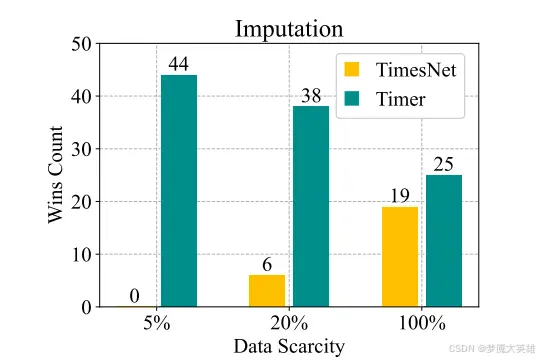

2、 插补

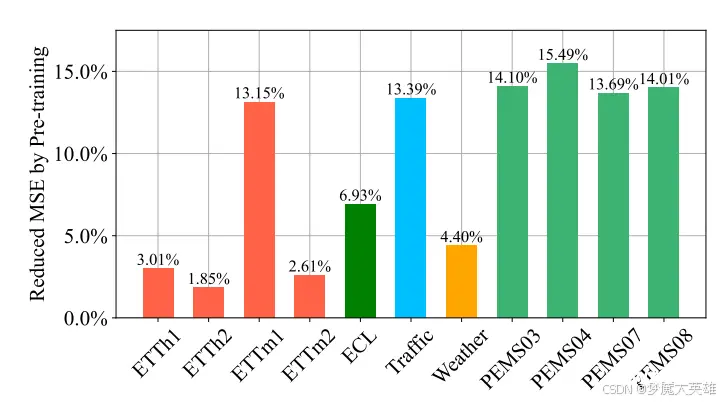

数据集:ETT、ECL、Traffic、Weather、PEMS

baseline: TimesNet (ICLR 2023)

实验:在数据稀缺度为5%,20%,100%的情况下,Timer在44个插补任务中表现分别优于TimesNet100%,86.4%,56.8%。

对于预训练的有效性,以插补错误减少率来表示促进作用,其中,预训练在下游样本只有5%的情况下始终产生积极影响。

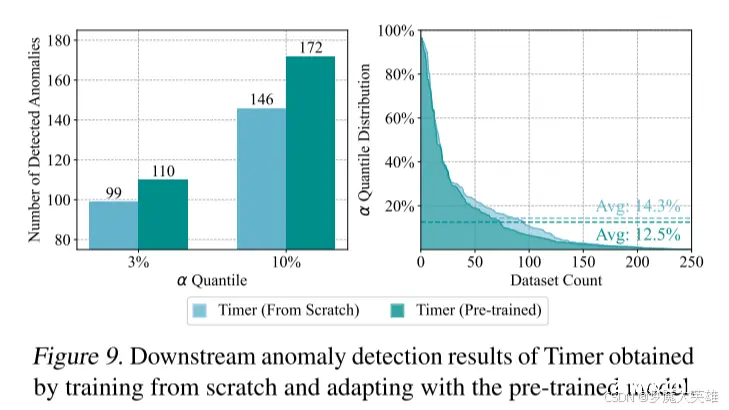

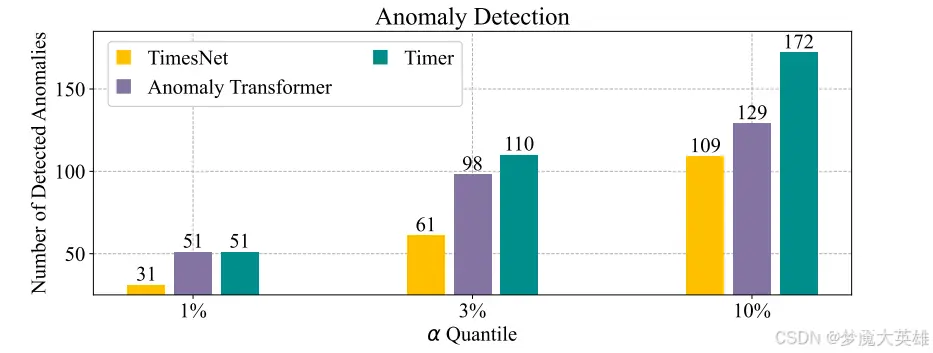

3、 异常检测

数据集:UCR Anomaly Archive(包含250个时间序列数据集)

baseline: TimesNet (ICLR 2023)、Anomaly Transformer(ICLR 2022)

实验:首先在训练集上训练一个预测模型,并计算预测序列和真实值之间的MSE。将置信度高于α的分段标记为异常的潜在位置。

结果:图7右侧表面,Timer优于其他两个异常检测模型。此外,图9左图显示了预训练模型的有效性。

未完待续......

上一篇: 我的人工智能与交通运输课程作业:交通流数据分析报告,格林希尔兹模型、格林伯格对数模型、安德伍德指数模型、两段式三角形基本图模型、东南大学S型三参数模型及非参数驱动的神经网络模型

下一篇: AI服务器PCIE SWITCH接口互联芯片技术,国产替代博通方案

本文标签

AI论文阅读笔记 | Timer: Generative Pre-trained Transformers Are Large Time Series Models(ICML 2024)

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。