/console.log(\'收到的数据:\',value);//处理data:字样,格式化流数据。//发送POST请求。//继续读取下一个数据块。//检查响应是否成功。//检查是否读取完毕。//...

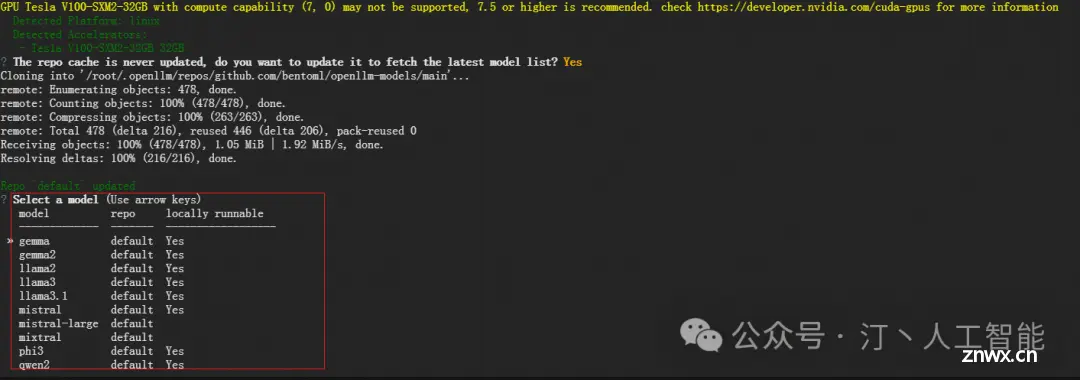

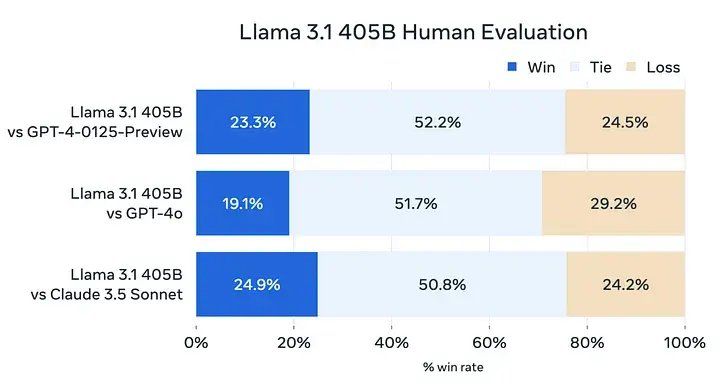

Llama大模型是由Meta的人工智能研究团队开发并开源的大型语言模型,继Llama2+模型之后,Meta进一步推出了性能更卓越的MetaLlama3系列语言模型,包括一个80亿参数模型和一个700亿参数模型。l...

在这篇文章中,我将分享如何在Windows上使用Ollama和OpenUI搭建开源大模型平台的步骤,并介绍我所部署的几个模型及其擅长的领域。_ollamaopenui...

SpringAI+ollama+qwen示例项目-流式、非流式输出【下载地址】SpringAIollamaqwen示例项目-流式非流式输出...

2000+多种开源大模型随意部署!一键搭建本地大模型,不挑环境、不挑配置(ollama安装部署教程《Windows/Linux,Mac》)一、Ollama介绍2.1基本介绍Ollama是一个支持在Windows、Linux和MacOS上本地...

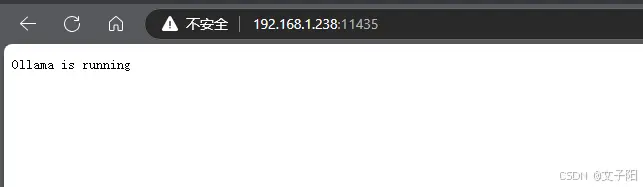

Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。,这是Ollama的官网地址:https://ollama.com/以下是其主要特点和功能概述:1简化部署:Ollama...

关注TechLead,复旦AI博士,分享AI领域全维度知识与研究。拥有10+年AI领域研究经验、复旦机器人智能实验室成员,国家级大学生赛事评审专家,发表多篇SCI核心期刊学术论文,上亿营收AI产品研发负责人。在过去的几个月中,AI驱动的编程助手领域...

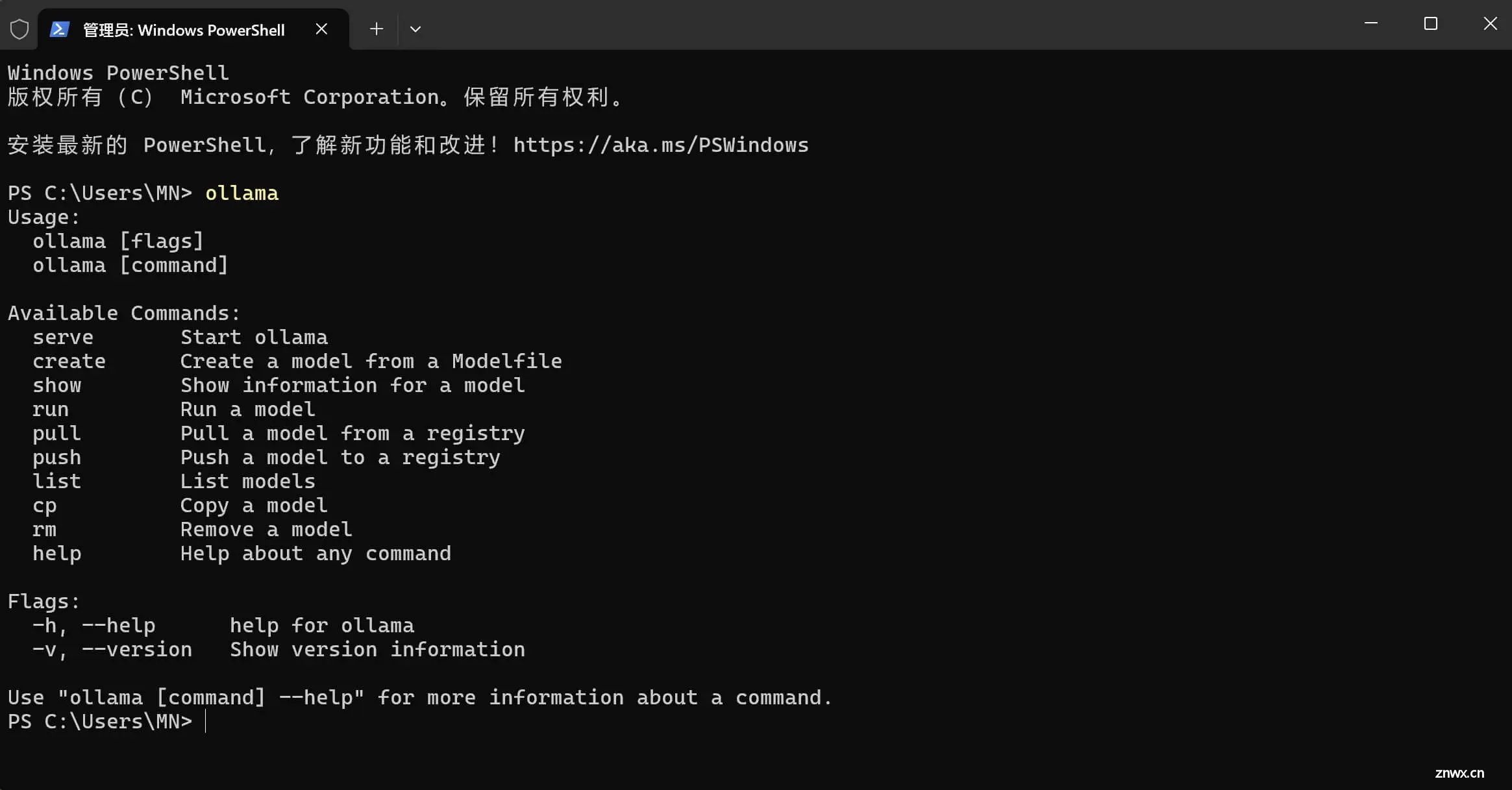

ollamarun#运行模型,会先自动下载模型。ollamapull#从注册仓库中拉取模型。ollamacreate#从模型文件创建模型。ollamalist...

在人工智能(AI)领域,AIPC让我们重新定义智能办公和信息管理。但是,要真正实现这一愿景,我们必须考虑多个关键因素,包括隐私保护、数据安全等。今天将带大家一起看下如何使用OBSIDIAN+OLLAMA+LL...

简单介绍什么是Ollama这玩意儿其实就是一个能够帮你快速启动并运行大语言模型的平台。你可以类比于Java中的Springboot+maven这个ollama是用go语言编写的,我对go语言了解不深,所以更细节的...