Python|flash_attn 安装方法

长行 2024-07-21 12:05:02 阅读 56

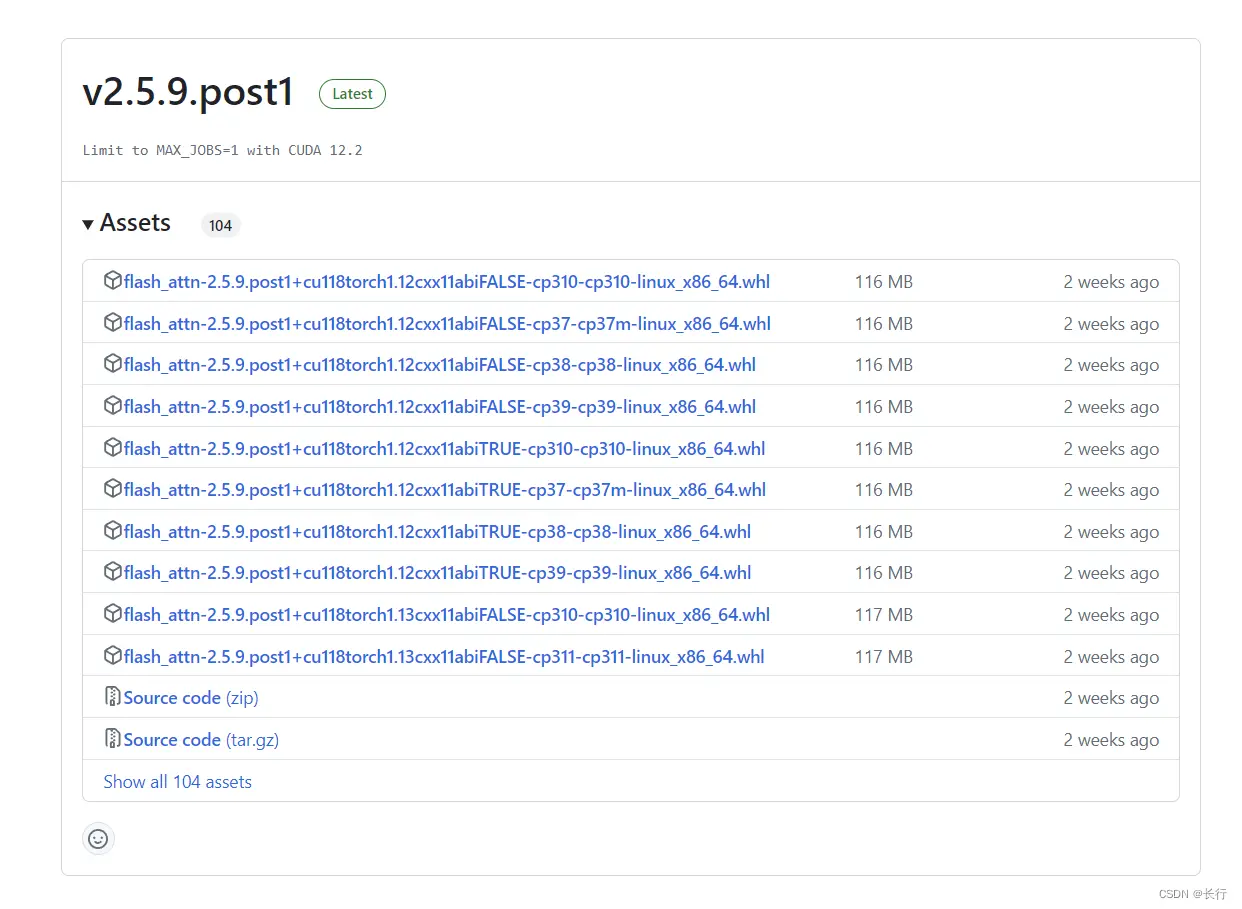

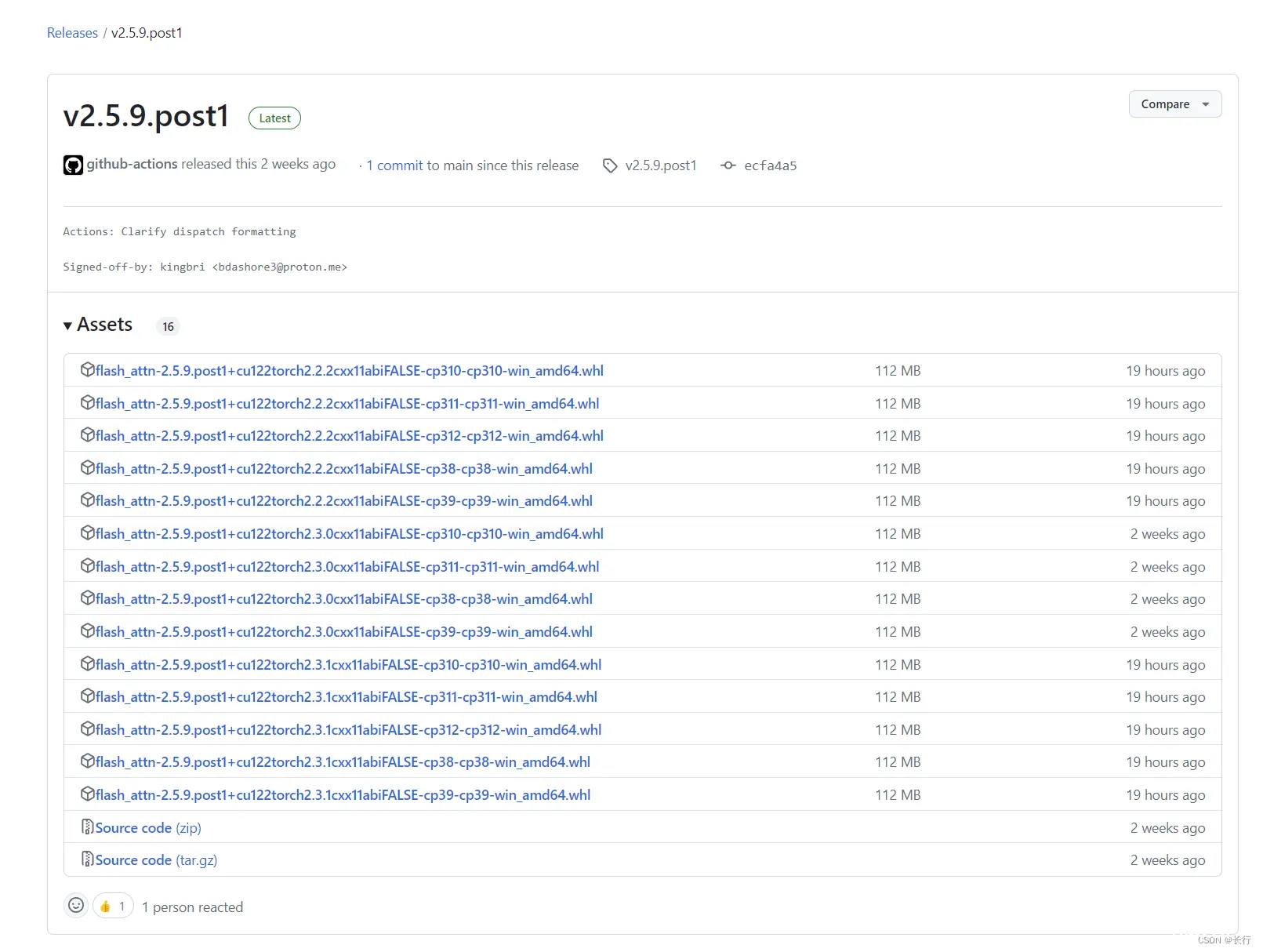

Step 1|打开 <code>flash_attn 的 Github 项目的 releases 页面

flash-attn 的 pypi 地址:https://pypi.org/project/flash-attn/

直接使用 pypi 安装会安装最新版本,不一定适配本地环境,所以需要直接从 release 中选择合适的版本安装。官方包只有 Linux 系统,Windows 系统可以使用大佬编译的包:

Linux 系统 whl 文件下载地址:https://github.com/Dao-AILab/flash-attention/releasesWindow 系统 whl 文件下载地址:https://github.com/bdashore3/flash-attention/releases(非官方)

Step 2|选择适合的版本并下载

在 <code>flash_attn 的版本上,直接选择最新版本即可(若最新版本的 flash_attn 没有适合的 CUDA 版本和 pytorch 版本则应用更早的版本)。

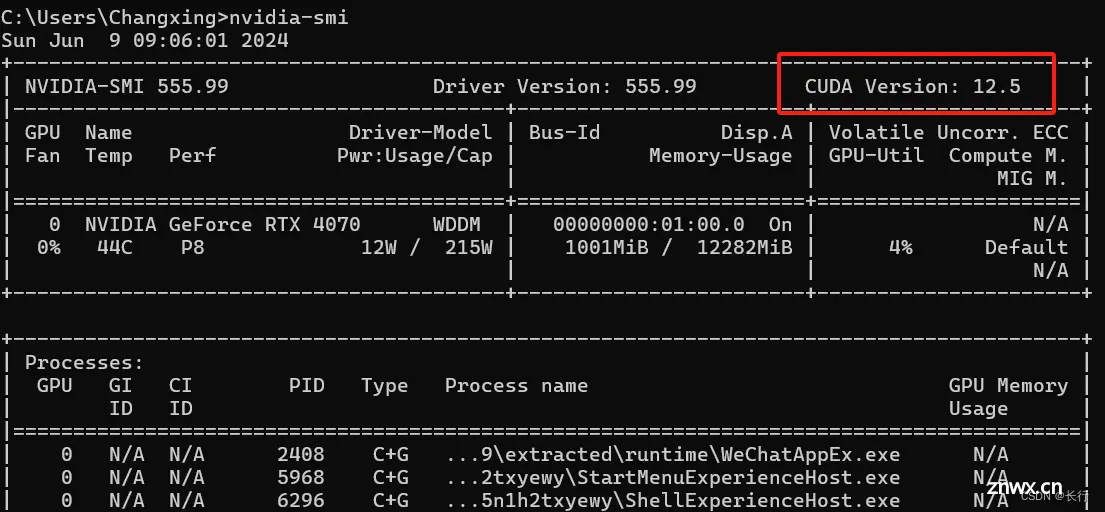

版本文件名中的第一部分(例如 cu118、cu122)为 CUDA 版本。本地 CUDA 版本可以通过 nvidia-smi 命令查看:

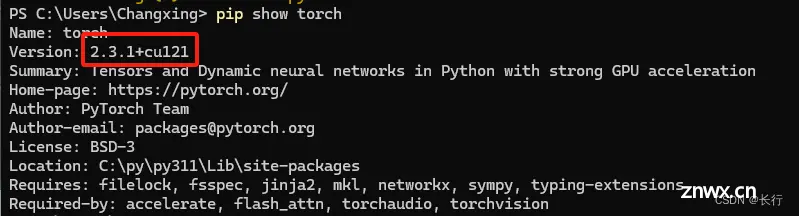

版本文件名中的第二部分(例如 <code>torch2.1、torch2.2、torch2.3)为 pytorch 版本,选择本地 pytorch 对应的版本即可。本地 pytorch 版本可以通过 pip show torch 命令查看:

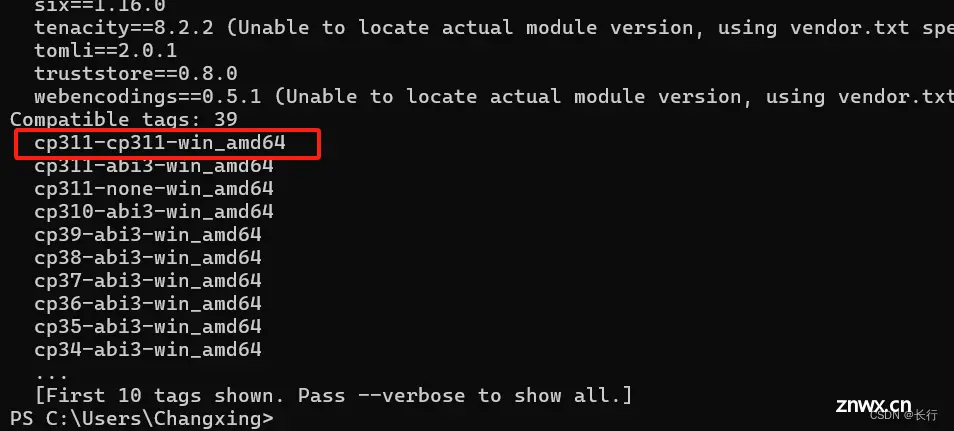

版本文件名的第三部分(例如 <code>cp311-cp311-win_amd64)为 Python 版本,选择本地 Python 版本即可。本地 Python 版本可以通过 pip debug 命令查看:

Step 3|安装 <code>flash_attn 模块

进入下载路径,pip 安装即可:

pip install flash_attn-2.5.9.post1+cu122torch2.3.1cxx11abiFALSE-cp311-cp311-win_amd64.whl

参考文档:https://blog.csdn.net/2301_77818837/article/details/135642828

如果尝试直接编译 whl 文件的话,可能遇到的问题如下:

Python|pip 安装报错 error Microsoft Visual C++ 14.0 or greater is required 的解决方法

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。