玄子Share-本地部署 AI 大模型与构建知识库

玄子Share 2024-07-06 16:01:04 阅读 50

玄子Share-本地部署 AI 大模型与构建知识库

部署环境概述

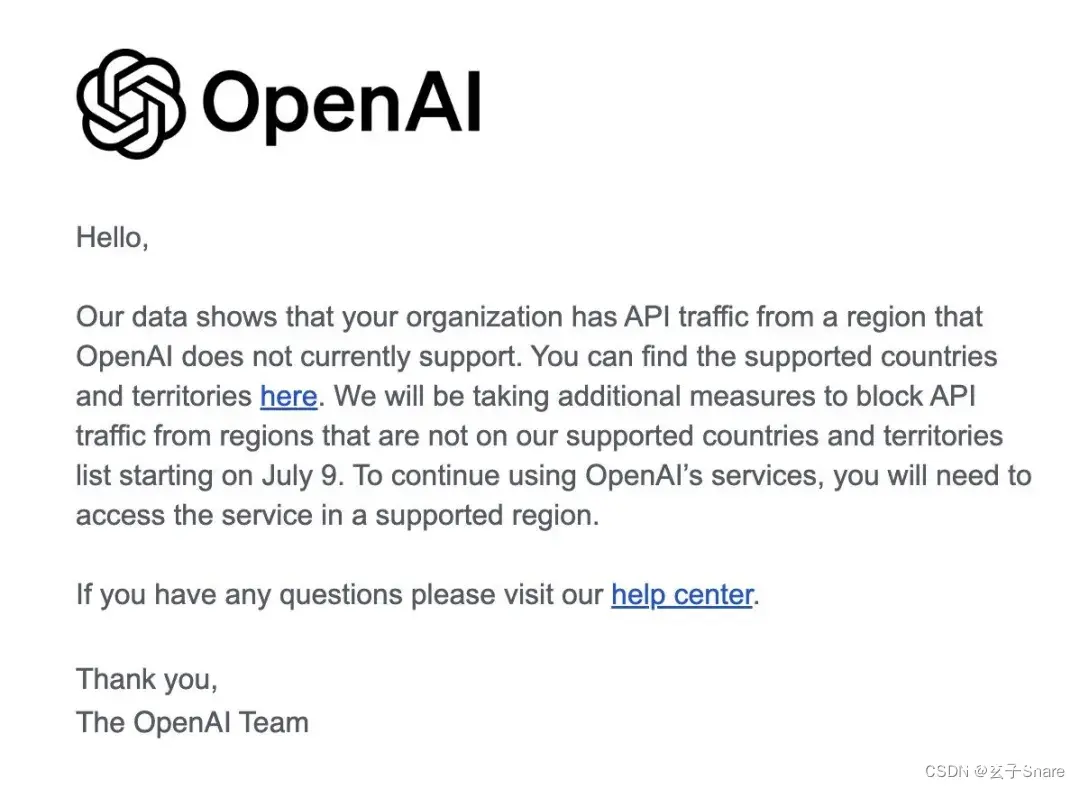

警告!OpenAI 宣布全面封锁中国 API 接入

昨天,许多开发者从 OpenAI 那收到了一份警告信

<code>您好,

据我们的数据监测,贵组织正从 OpenAl 当前未支持的区域产生 API 访问流量。

您可以在官网查阅我们所支持的国家与地区名单。

请注意,自 7 月 9 日起,我们将对不在此支持名单上的区域实施 API 访问限制措施。

为了确保持续使用 OpenAl的各项服务,请在被支持的区域内登录访问。

如有疑问,欢迎访问我们的帮助中心寻求解答。

谢谢,

OpenAl 团队

大家都懂

本地部署 AI 大模型

数据安全与隐私保护:在本地环境中运行AI模型,避免了将敏感数据传输至云端的风险,确保了用户数据的安全性和隐私性。稳定可靠的计算环境:无需依赖互联网连接或外部服务的稳定性,本地部署保障了应用服务的持续可用性,不受网络状况波动的影响。高性能与低延迟:利用本地资源进行模型推理可以显著减少响应时间,并优化整体性能,尤其是在处理实时请求时更为关键。定制化与控制:本地部署允许开发者根据具体需求调整模型配置和参数,实现高度的个性化服务构建,同时便于监控和维护模型性能。成本效益:对于企业来说,无需支付高昂的数据传输费用或订阅大型云平台的服务,尤其是在处理大规模数据集时,本地部署可以显著降低整体运营成本。API调用与外部服务提供:通过API集成,本地部署的AI模型能够无缝地与其他系统和服务对接,增强业务流程自动化和智能化水平,为用户提供更加便捷、高效的体验。

构建 AI 模型知识库

知识抽取与编码:首先,对本地的文本或文档进行处理,提取其中的关键信息和专业知识点,并将这些内容转化为向量表示。这通常利用预训练的语言模型(如BERT、ELMo等)来进行语言理解以及上下文理解。领域知识整合:通过构建针对特定领域的知识图谱或者使用相关的专业词汇库,帮助AI系统更好地理解与领域相关的问题和语境。这些知识可以是行业标准、术语、常见问题解答或专业知识点的集合。模型集成与优化:将生成的向量数据集成到现有AI系统中,通过调整或训练额外的模块使其能够理解和回应基于这些特定领域知识的问题。这可能包括对原始预训练模型进行微调(fine-tuning),以适应特定领域的语言和语境。强化学习与反馈循环:利用强化学习技术让AI在特定领域内进行自我优化,通过实际用户交互或专家评估来调整其响应策略,进一步提高准确性和相关性。持续更新与维护:随着新知识的积累和领域的发展,定期更新和扩展知识库,确保AI系统能够跟上行业动态,并提供更加精确、及时的答案。

总而言之,本地部署,训练数据,远程调用

下载 Ollama

官网下载 Ollama:https://ollama.com/

根据自己操作系统版本下载,下载完成后直接安装即可

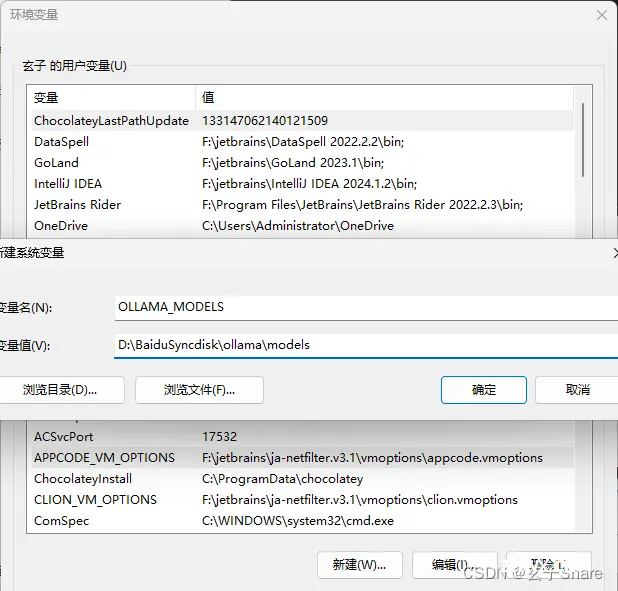

配置 Ollama

大模型默认安装至<code>C:\Users\Administrator\.ollama

模型大小普遍在 4~8G,有需求可配置环境变量,修改安装位置OLLAMA_MODELS

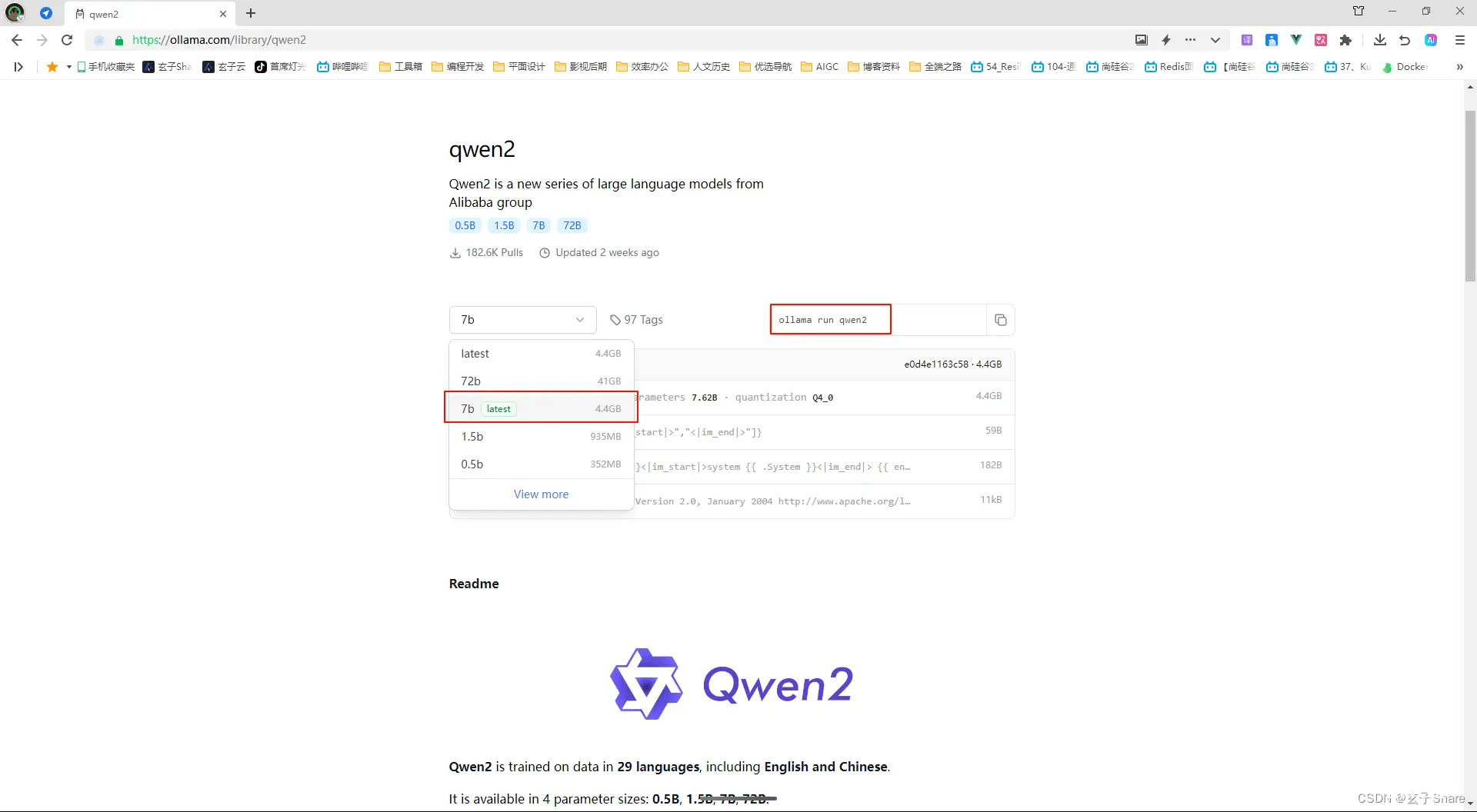

选择大模型

Ollama 官网右上角进入模型仓储,选择大模型下载,这里选用国产大模型 Qwen2

外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传

拉取大模型

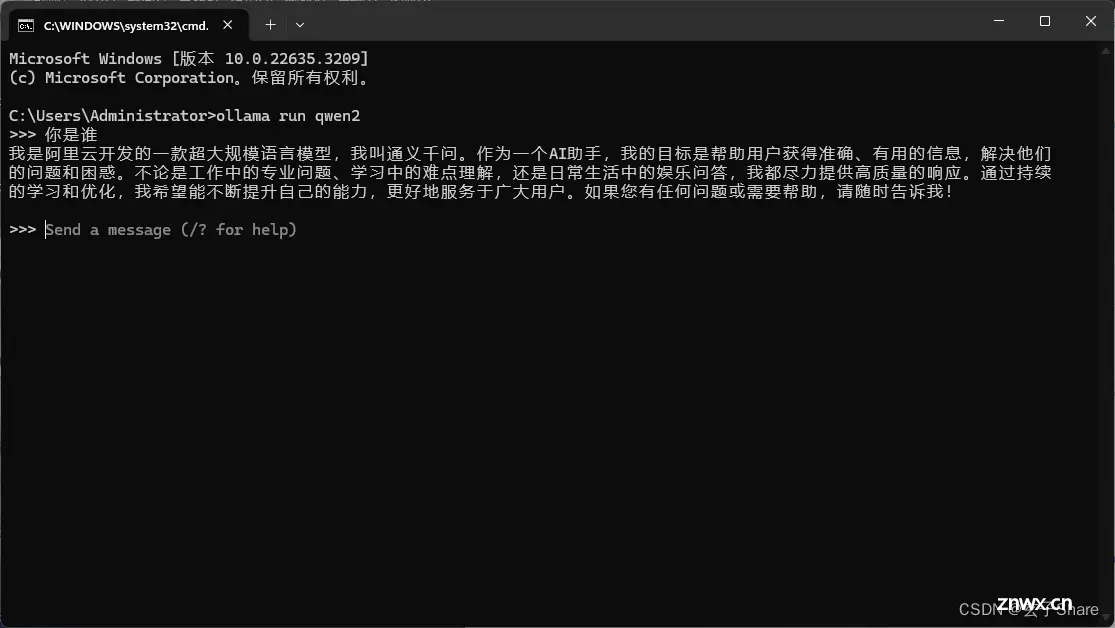

大模型有多个参数,本地部署选用 qwen2:7b 即可,复制命令到 cmd 拉取

需科学上网,若无法拉取,可尝试直接复制大模型文件

<code>ollama run qwen2:7b

若无模型训练需求,此时就可以直接使用了,可安装 open-webui https://github.com/open-webui/open-webui,以图形界面使用 AI 服务

嵌入式模型

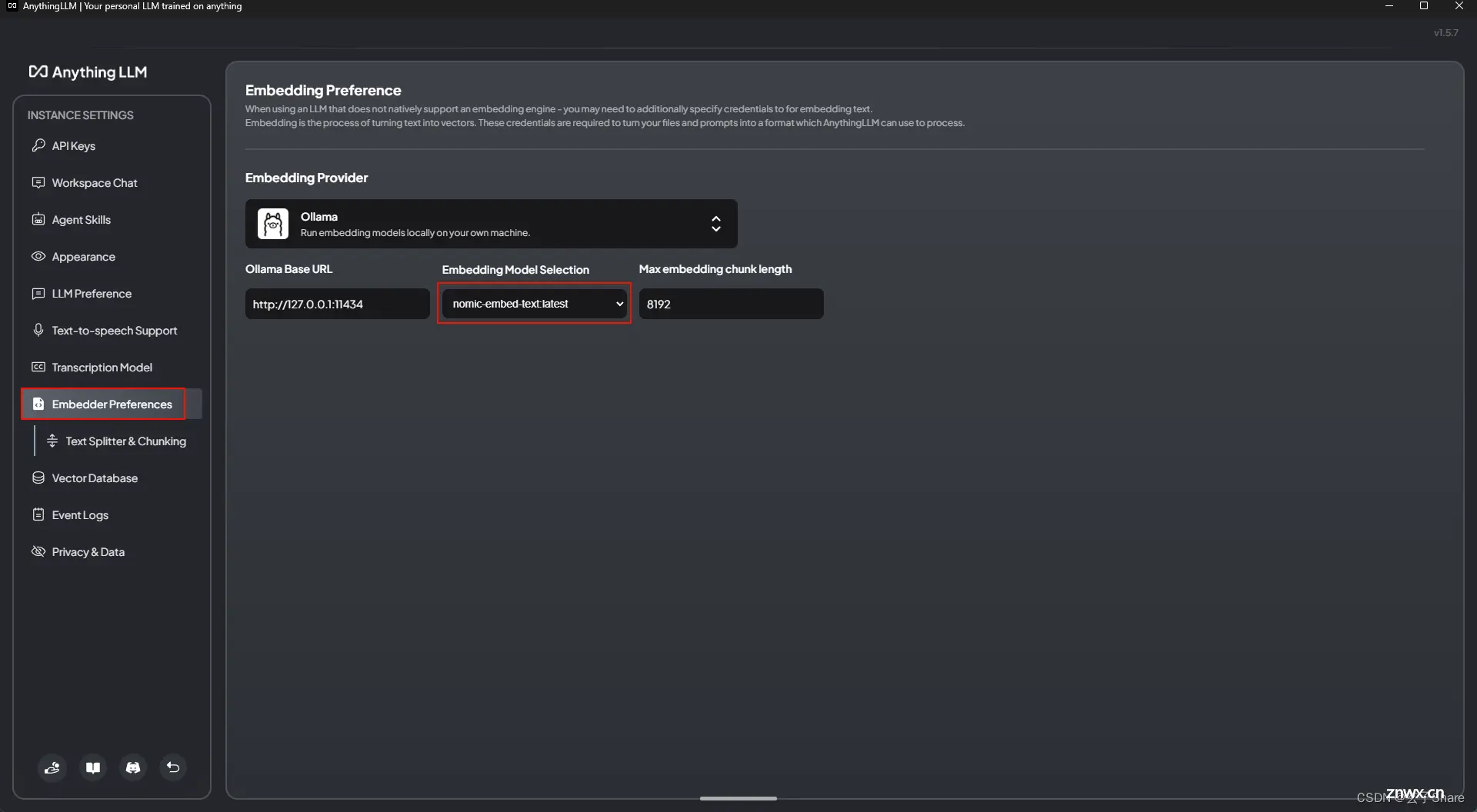

使用 嵌入模型将本地文件或网络链接,转为向量信息,供 Qwen2 回答使用

<code>ollama pull nomic-embed-text

外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传

构建知识库

官网下载 AnythingLLM:https://useanything.com/

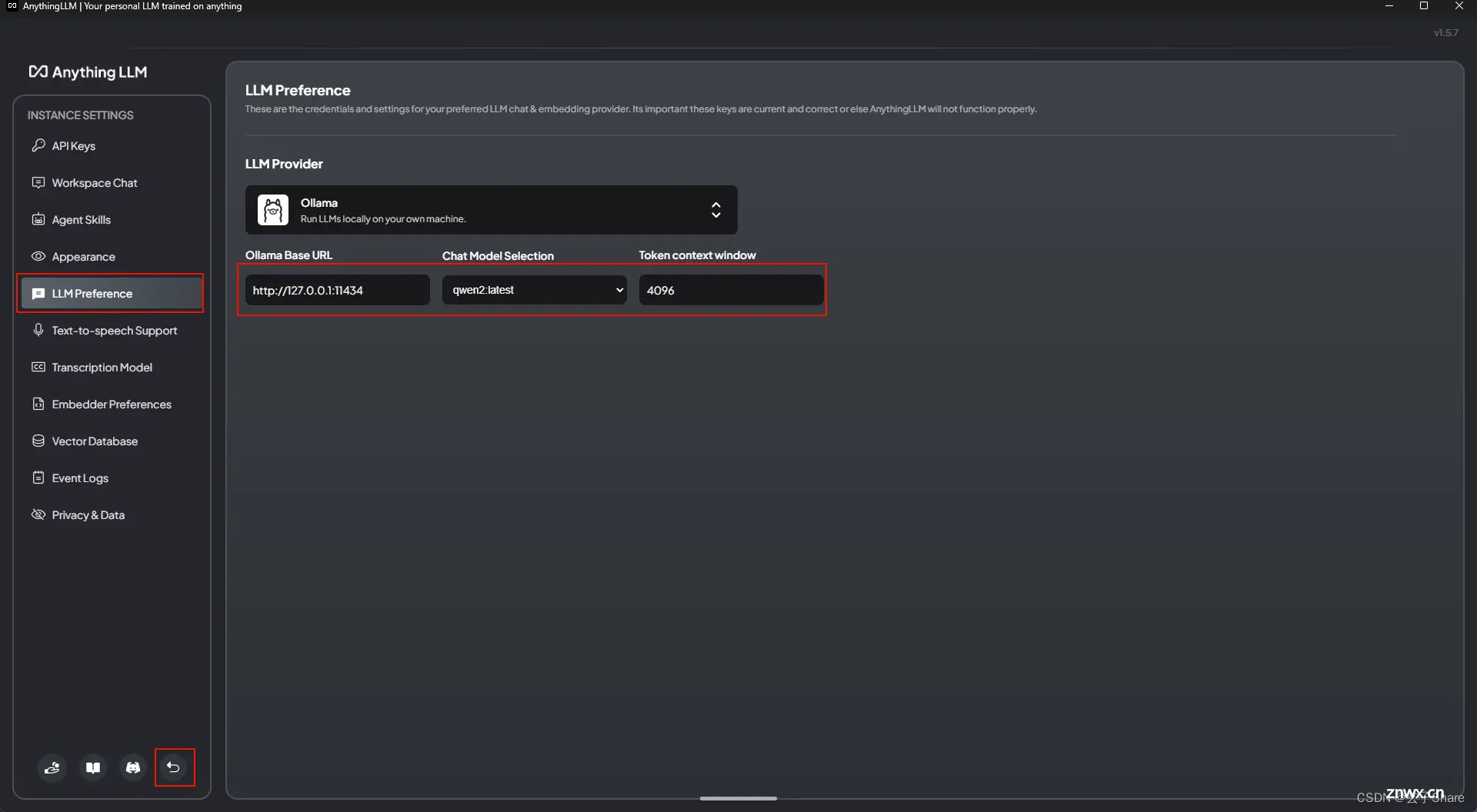

配置知识库

选择基础大模型 Qwen2

选择嵌入模型

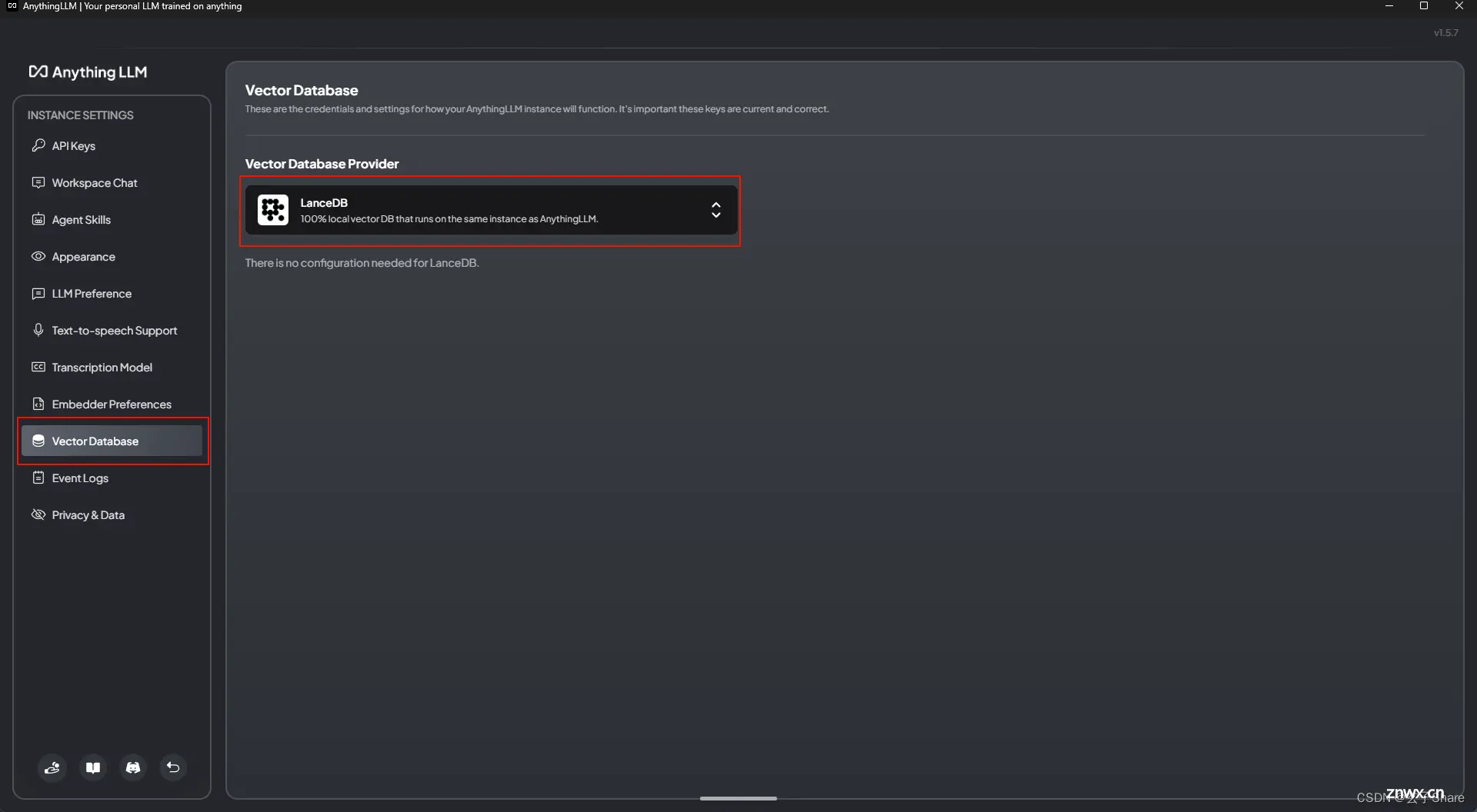

选择向量数据库

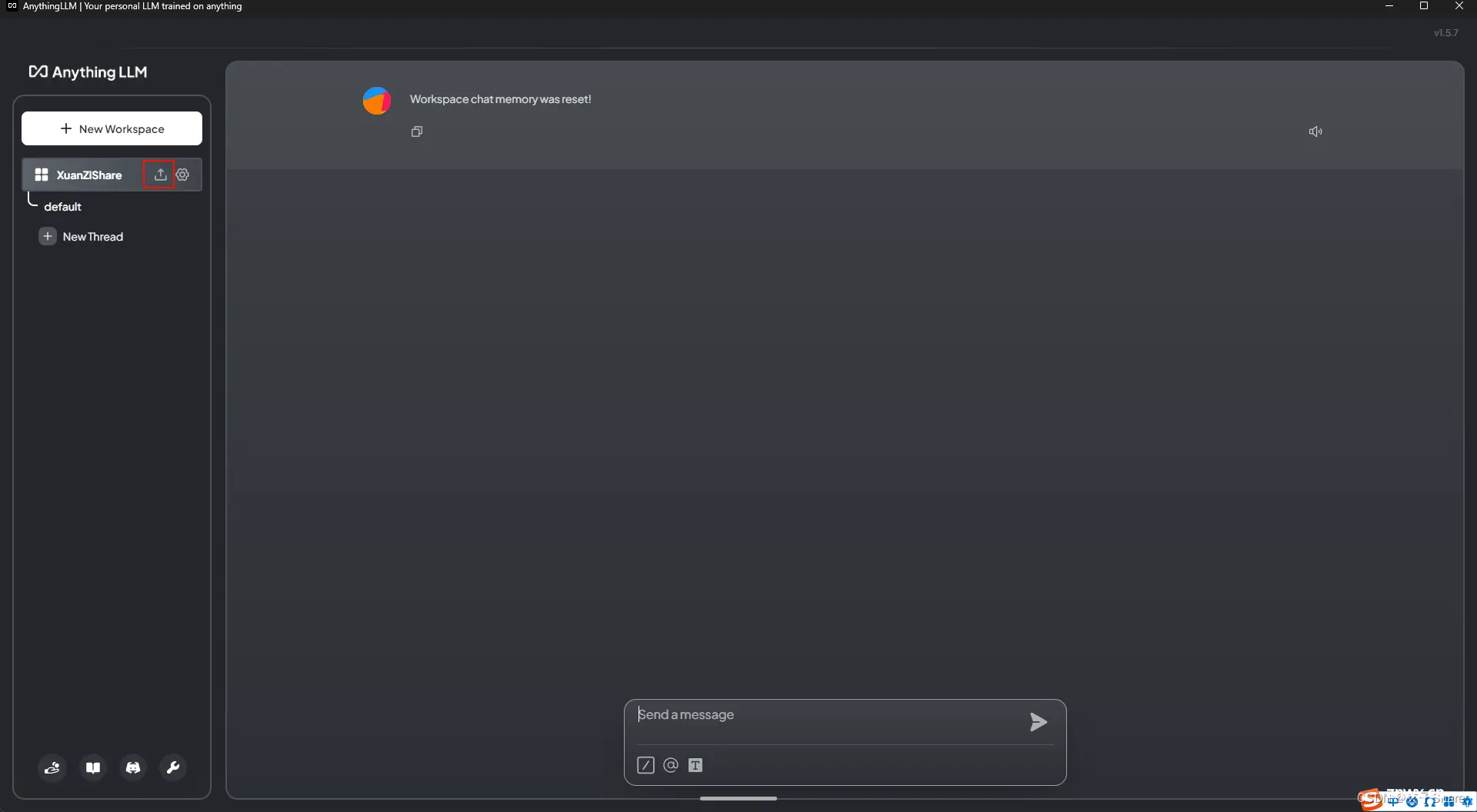

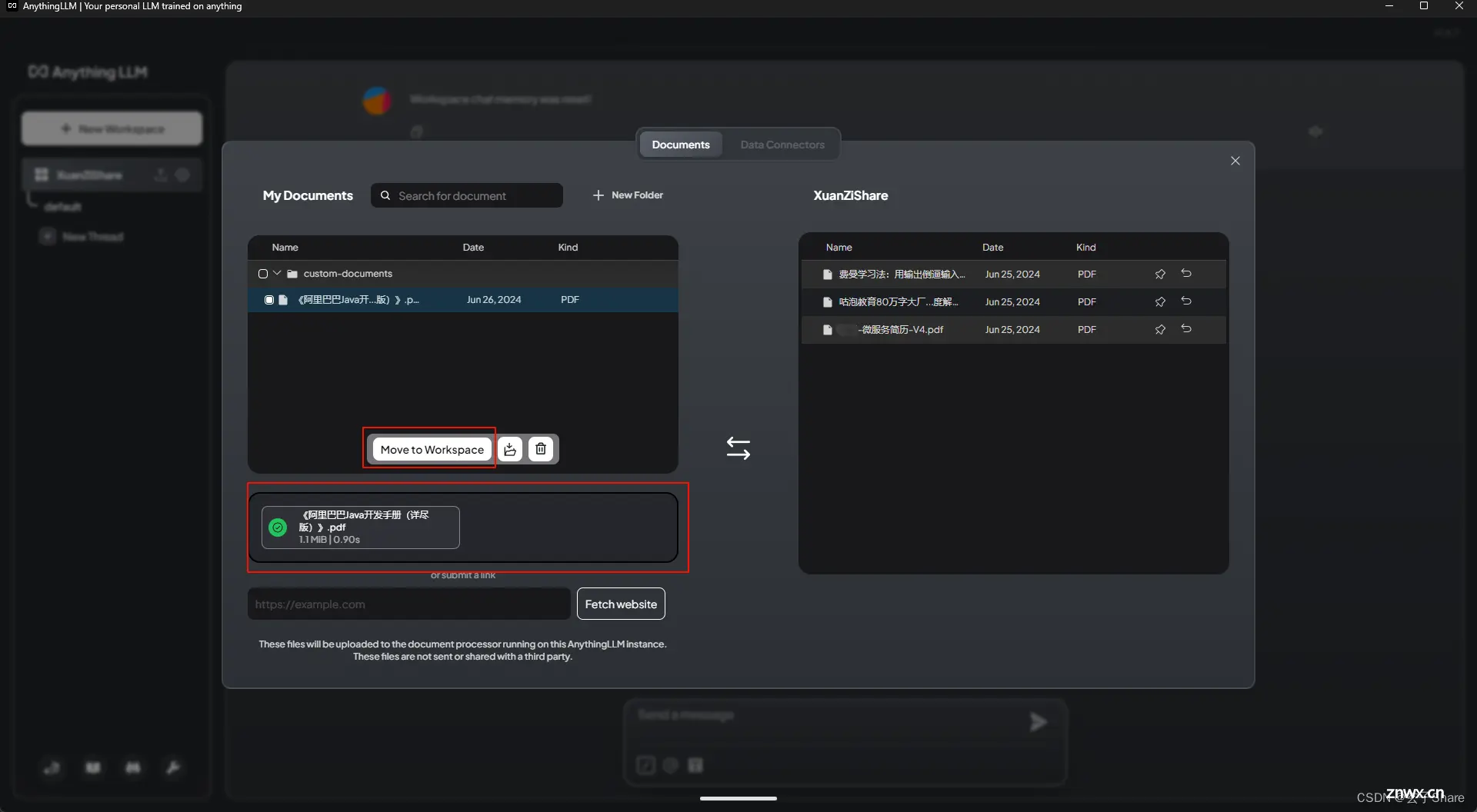

上传本地文件

转为向量数据

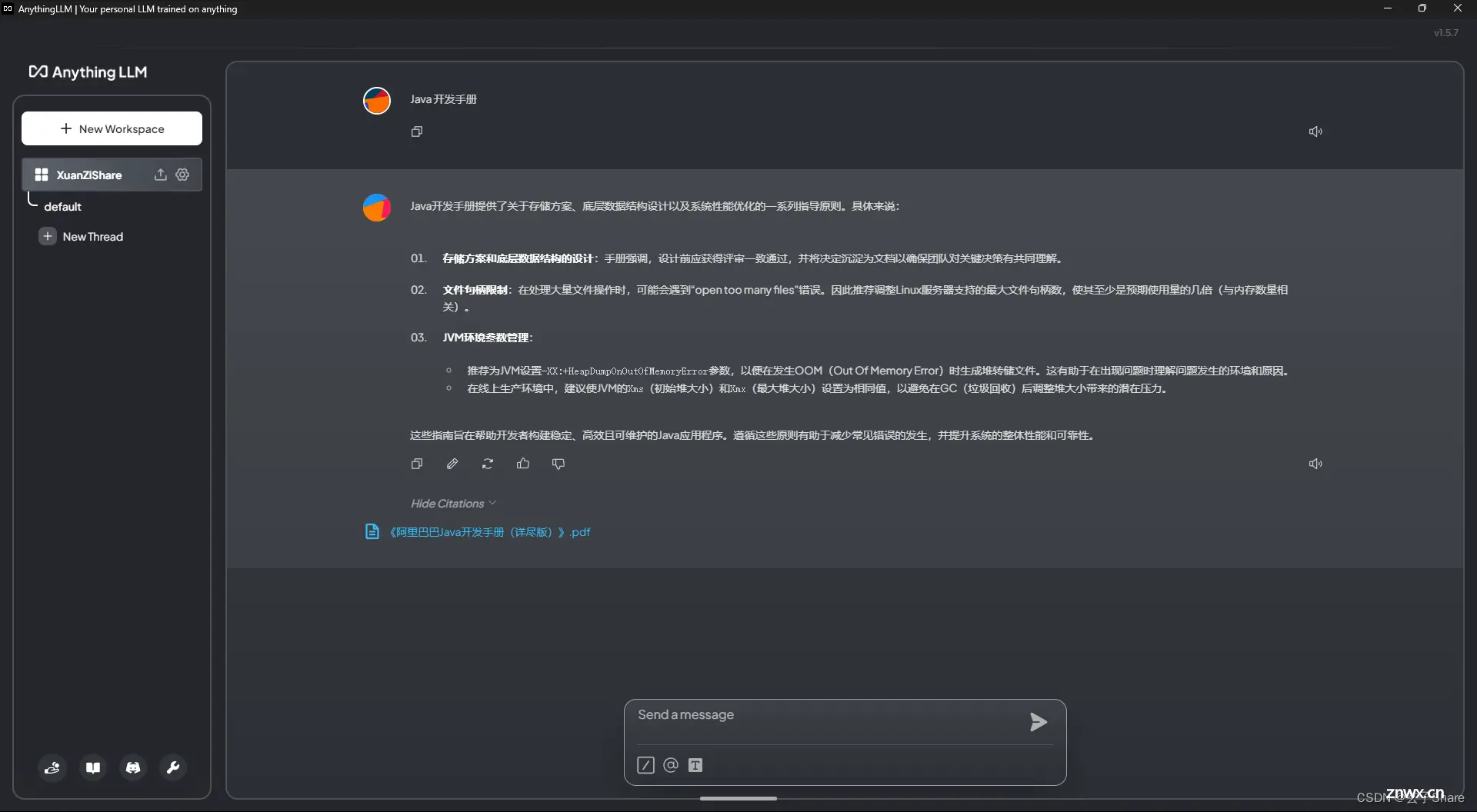

开始提问

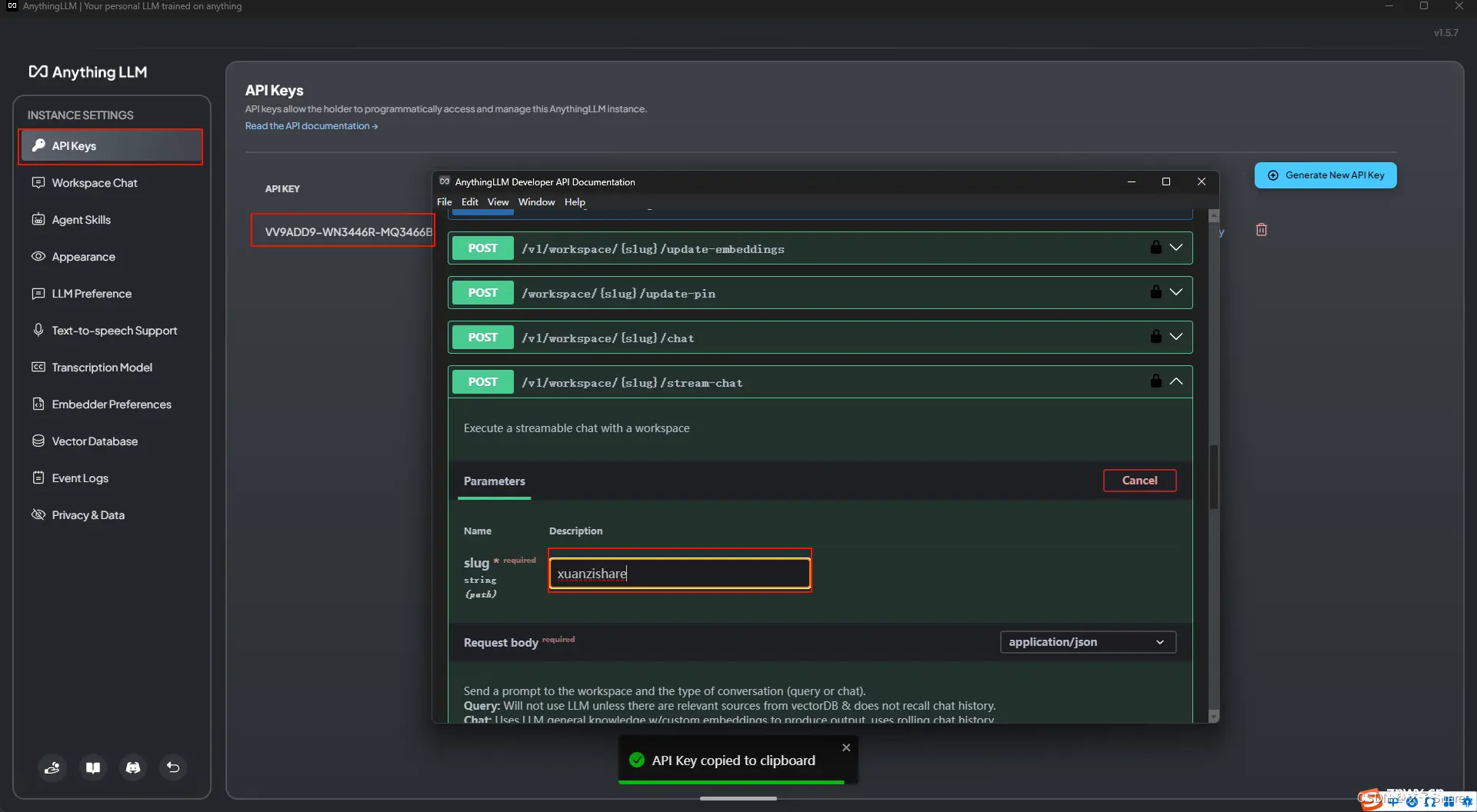

API 接口调用

玄子Share-本地部署 AI 大模型与知识库 2024.06.26

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。