浅谈【AI、算力赋能】“大算力”时代的到来

CSDN 2024-06-15 09:31:02 阅读 95

🔻一、【💣 话题引入:“AI+算力=最强龙头”,你怎么看?】

🙈 AI人工智能是否可以取代人类?

🙈 应不应该限制人工智能的发展?

🙈 AI研究及龙头行业迎来哪些时代机遇与挑战?

🙈 AI人工智能可能会怎样危害人类?

面对科技的高速发展,虽说为人类社会带来了前所未有的机遇和挑战,但同时也产生了众多值得深思的问题。

AI人工智能正以“有益”和“有害”的方式影响着人类,AI的发展是否会迎来觉醒时刻。

🔻二、【🔉 AI、算力赋能为何能成为时代前沿❓】

🌋

数据爆炸:随着互联网、物联网、社交媒体等技术的发展,数据量呈爆炸式增长。AI、算力可以帮助人们更好地处理和分析这些数据,从而提高数据的价值和利用率。

🎉

自动化需求:随着人工智能技术的发展,越来越多的工作可以被自动化完成。AI、算力可以帮助人们更好地实现自动化,提高工作效率和质量。

👀

个性化需求:随着人们对个性化服务的需求不断增加,AI、算力可以帮助企业更好地了解客户需求,提供更加个性化的服务。

💭

人工智能的发展:人工智能技术的发展已经进入了一个快速发展的阶段,AI、算力是人工智能技术发展的重要支撑。

🎊

产业升级:AI、算力可以帮助企业实现数字化、智能化升级,提高企业的竞争力和创新能力。

综上——AI、算力赋能是时代前沿的原因主要是因为它们可以帮助人们更好地处理和分析数据,实现自动化,提供个性化服务,支撑人工智能技术发展,促进产业升级。

🔻三、【🔉 未来的科技趋势❓】

🔔

人工智能:人工智能将继续发展,包括机器学习、深度学习、自然语言处理、计算机视觉等领域。人工智能将应用于各个领域,包括医疗、金融、制造业、交通、教育等。

📱

5G技术:5G技术将成为未来通信技术的主流,它将带来更快的网速、更低的延迟和更大的带宽,为人们提供更加高效的通信服务。

🌐

物联网:物联网将继续发展,将连接更多的设备和物品,实现更加智能化的生活和工作。

☁

区块链:区块链技术将继续发展,将应用于金融、物流、医疗等领域,实现更加安全、透明和高效的数据交换和管理。

💊

生物技术:生物技术将成为未来的重要领域,包括基因编辑、人工合成生物、生物传感器等技术,将为医疗、环保、食品等领域带来重大的变革。

🌀

虚拟现实和增强现实:虚拟现实和增强现实技术将继续发展,将应用于游戏、教育、医疗等领域,为人们提供更加沉浸式的体验。

这些技术将为人们的生活和工作带来更加智能化、高效化和便利化的体验。

🔻四、【🔉 AI人工智能是否可以取代人类,应不应该限制其发展❓】

🌳

案例1:AI智能主持人24小时无休、零工资、零失误。

🍀

案例2:AI发展带来安全和隐私问题,不法分子恶意利用,制作违法和不良信息,诋毁贬损他人名誉,仿冒他人身份等现象也随之产生。

🌲

案例3:使用ChatGPT做作业,AI作弊写出全班最佳论文。

🌴

案例4:在各大领域代替部分人力资源,这可能会导致部分人员失去工作机会。

🔻五、【🔉关于人工智能是否会“消灭”人类:❓】

⚡

1、违背意愿的消灭: 人工智能从肉体上消灭人类或统治世界,从目前技术发展趋势和水平来看,可能性不是很大。

📟

人工智能的迭代:人工智能再创造人工智能,又继续迭代,最终达到人类的几百倍、甚至上万倍。人工智能百倍于现在这个程度只需0.5小时-1小时。而人工智能的迭代发展需要提供强大算力,目前能提供的算力是有限的,所以“消灭”是不大可能的。

☔

2、人类社会适应的消灭: 随着人工智能发展,大部分人不再需要工作,而是由人工智能代替,沉浸在科技的“安乐窝”之中,缺乏人类文明、开拓精神,最终被没有恶意的人工智能“消灭”。只是照着指示做事,所以AI的发展是否会迎来觉醒时刻—这是个值得关注的话题。

🔻六、【🔉 最后谈谈小编对AI、算力赋能的理解】

🔔 1、大算力时代带来了深度学习和神经网络的重大突破。深度学习是一种基于神经网络的机器学习方法,它通常需要大量的计算资源进行训练和推理。大算力时代的到来使得研究人员和工程师能够更好地利用神经网络进行模型训练和优化,从而实现更准确的预测和更高效的决策。

🔔 2、随着硬件技术的不断进步和算法的不断创新,我们有理由相信,在大算力时代,人工智能将在各个领域展现出更为广泛的应用和更高的效能,为人类社会带来巨大的进步和改变。

🔔 3、随着ChatGPT新浪潮的掀起,人工智能就目前而言对社会的影响已经很明显,它的高速发展正在替代着我们人类从事的众多工作。正以“有益”和“有害”的方式影响着我们。

有益:帮助了我们更好的实现自动化,提高工作效率和质量,提供更加个性化的服务。

有害:AI人工智能的发展也给社会带来了巨大冲击,如安全和隐私问题,

🔔 4、对AI依赖性太大,“遇事不决,ChatGPT”,自己的很多困扰好像都可以在ChatGPT那里得到帮助和解决。

🔔 5、如何制胜“AI魔法”,避免AI“野蛮生长”才是当下最大的挑战。所以需要通过主动应对AI带来的潜在挑战,将未来灾难性后果的风险降至最低。

####🍀示例、如何在Python中利用AI进行图像分类,并充分利用算力🍀####🎉 1、选择适当的深度学习框架:常见的深度学习框架包括TensorFlow、PyTorch和Keras等。选择一个您熟悉且适合您的任务的框架。🎉 2、准备图像数据:将图像数据集分成训练集和测试集,并将其进行预处理,如缩放、裁剪、标准化等操作。这些步骤可以使用框架提供的函数或图像处理库(如PIL或OpenCV)来完成。🎉 3、构建和训练AI模型:选择适当的预训练模型(如ResNet、VGG或Inception等),或者自行构建模型。通过框架提供的API或使用框架的高级API,如Keras的Sequential或TensorFlow的Estimator,来构建模型。然后,使用训练集对模型进行训练,使用适当的优化器和损失函数。🎉 4、充分利用计算资源:为了充分利用计算资源,可以考虑以下几个方面:🎉 5、使用GPU加速:在支持GPU的机器上,确保安装了必要的GPU驱动、CUDA和cuDNN,并将模型和数据移动到GPU设备上进行训练和预测。 批量处理:利用GPU进行批量处理可以提高计算效率。通过调整批量大小,使其适合GPU的内存容量,并尽量增大批量大小以减少数据传输和计算时间。异步运算:如果同时有多个图像需要分类,可以考虑使用异步运算来并行处理多个图像,以提高效率。模型压缩和剪枝:对模型进行压缩和剪枝,以减少模型的大小和计算量,从而提高预测效率。🎉 6、进行图像分类预测:使用经过训练的AI模型对测试集或新的图像进行分类预测。将图像输入到模型中,获取预测结果,并根据需要对结果进行后处理(如解码、排序或阈值处理)。🎉 7、优化和调试:根据实际情况,检查和优化代码以提高性能。可以使用CPU和GPU的性能分析工具来识别瓶颈,并对代码进行调整和优化。

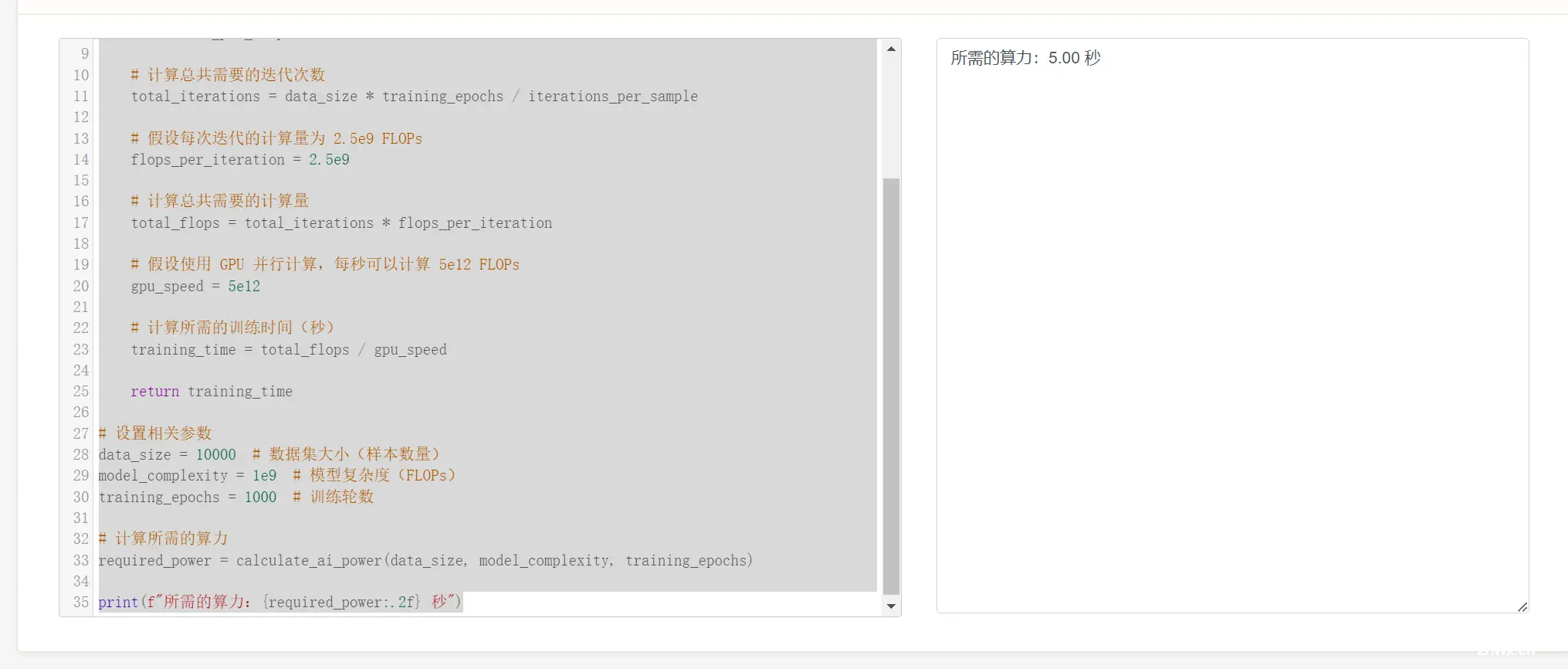

####🍀示例、如何在Python中利用AI进行图像分类,并充分利用算力🍀####import numpy as npdef calculate_ai_power(data_size, model_complexity, training_epochs): # 假设运算单位为 FLOPs flops_per_sample = model_complexity * data_size # 假设单个样本平均需要 1000 次迭代来完成训练 iterations_per_sample = 1000 # 计算总共需要的迭代次数 total_iterations = data_size * training_epochs / iterations_per_sample # 假设每次迭代的计算量为 2.5e9 FLOPs flops_per_iteration = 2.5e9 # 计算总共需要的计算量 total_flops = total_iterations * flops_per_iteration # 假设使用 GPU 并行计算,每秒可以计算 5e12 FLOPs gpu_speed = 5e12 # 计算所需的训练时间(秒) training_time = total_flops / gpu_speed return training_time# 设置相关参数data_size = 10000 # 数据集大小(样本数量)model_complexity = 1e9 # 模型复杂度(FLOPs)training_epochs = 1000 # 训练轮数# 计算所需的算力required_power = calculate_ai_power(data_size, model_complexity, training_epochs)print(f"所需的算力:{ required_power:.2f} 秒")

计算结果:

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。