Llama 3.1:Meta 的开源 AI 巨兽,智能新高度

图灵AI云 2024-08-30 08:31:01 阅读 53

在人工智能的世界里,大型语言模型(LLMs)就像是会魔法的巨人,它们能读懂我们的心思,帮我们解决问题。最近,Meta 公司(就是 Facebook 的母公司)发布了一个叫做 Llama 3.1 的超级智能模型,它就像是 AI 世界里的新宠儿。

Llama 3.1 是什么?

想象一下,如果你有一个超级聪明的助手,能帮你写文章、解决问题,甚至还能和你用不同的语言聊天,那该多酷!Llama 3.1 就是这样一个助手。它有 4050 亿个“大脑细胞”(我们叫它参数),这让它变得非常聪明,能够做很多复杂的事情。

为何如此特别?

开源的魔法:Meta 决定把 Llama 3.1 的模型开放给大家,这意味着任何人都可以免费使用它,甚至根据自己的需要来改进它。比自己搭建类似的系统要便宜很多,这对于预算有限的公司和个人来说是个好消息。

多种语言:Llama 3.1 不仅能说英语,还能说法语、德语、印地语、意大利语、葡萄牙语和西班牙语等八种语言,真是个语言天才!

超长记忆:它能够记住长达 128,000 个词的文本,这让它在处理长篇文章或者多语言对话时更加得心应手。

多种规模:Llama 3.1 有三种版本:405B、70B 和 8B 参数,满足不同计算需求和用例。

其中,405B 是专为需要大量处理能力的高复杂任务设计。它适用于多语言对话代理、长文本摘要和其他高级 AI 任务等应用。在一般知识、数学、工具使用和多语言翻译方面表现出色,并可以通过包括 Hugging Face、GitHub 以及 AWS、Nvidia、Microsoft Azure 和 Google Cloud 等多个云平台进行访问。

性能如何?

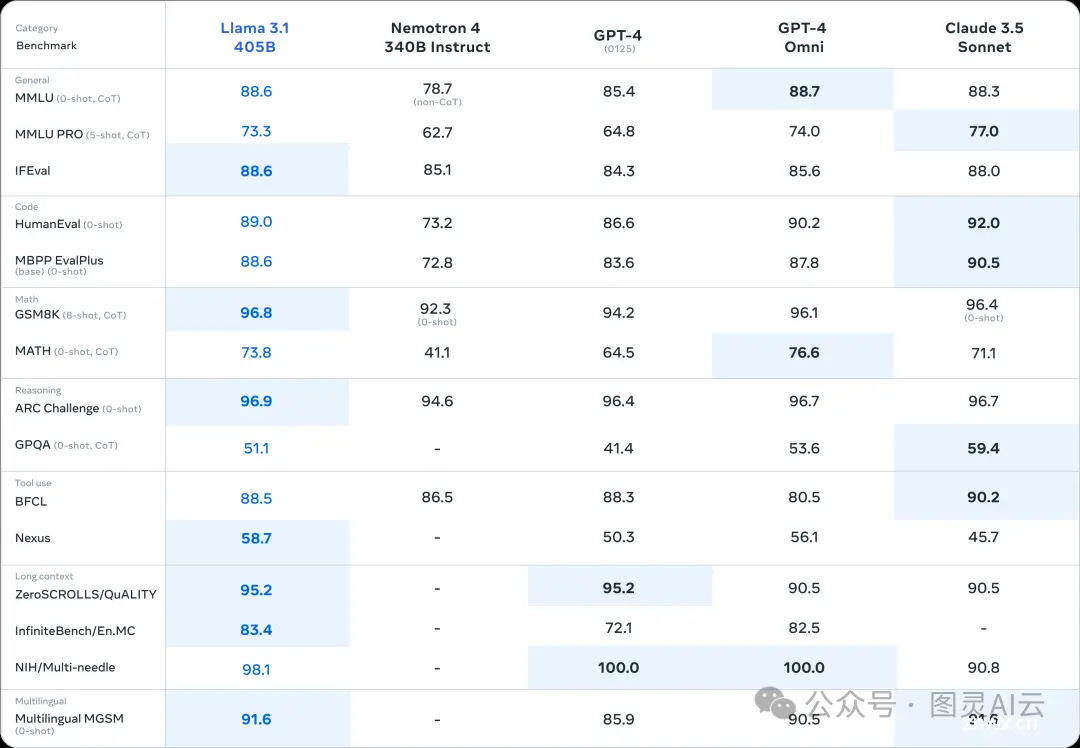

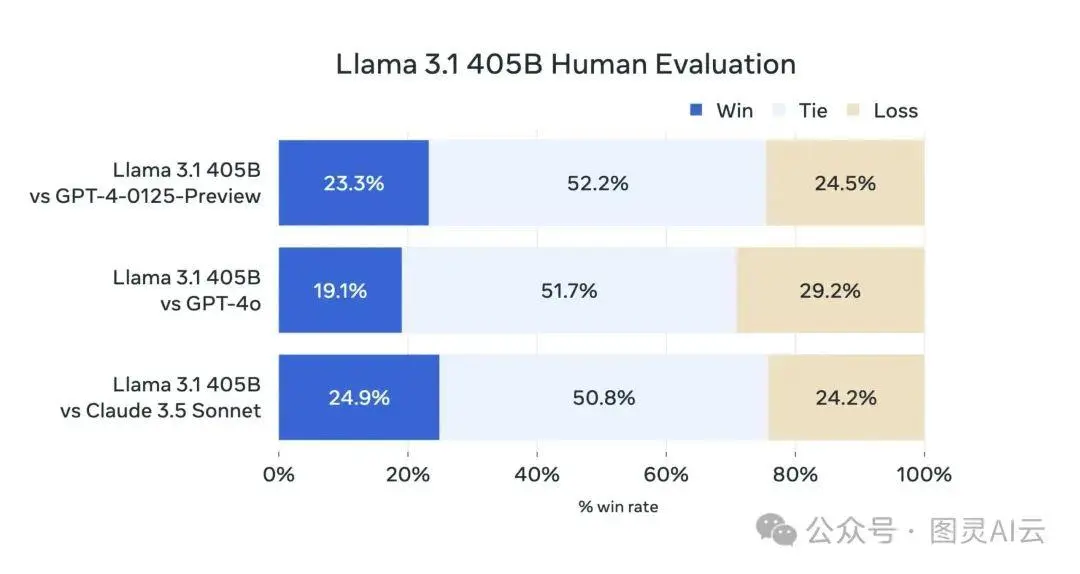

在多个基准测试中,如 GSM8K、Nexus、HumanEval 和 MMLU,Llama 3.1 都展现出了卓越的性能。例如,在 GSM8K 测试中,它在解决数学文字问题方面超越了 Claude 3.5 和 GPT-4o 等模型。在 Nexus 基准测试中,它同样表现出色,超越了竞争对手。

GSM8K: Llama 3.1 在测试数学文字问题的 GSM8K 中击败了像 Claude 3.5 和 GPT-4o 这样的模型。

Nexus: 该模型在 Nexus 基准测试中也超越了这些竞争对手。

HumanEval: Llama 3.1 在 HumanEval 中保持竞争力,该测试评估模型生成正确代码解决方案的能力。

MMLU: 它在评估模型处理广泛主题和任务能力的大规模多任务语言理解(MMLU)基准测试中表现良好。

架构如何?

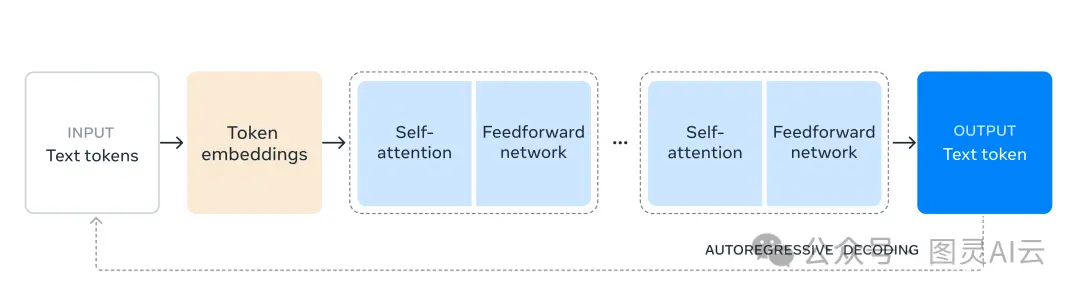

Llama 3.1 的架构建立在标准的仅解码器变换模型之上,该模型经过一些微小的调整以提高其性能和可用性。

架构的一些关键方面包括:

仅解码器变换模型:Llama 3.1 使用了一个仅解码器变换模型架构,这是语言模型的通用框架。这种架构旨在通过基于前一个标记预测序列中的下一个标记来生成文本。

参数大小:模型拥有 4050 亿参数,使其成为可用的最大开源 AI 模型之一。这种广泛的参数大小允许它处理复杂任务并生成高质量的输出。

训练数据和标记:Llama 3.1 在超过 15 万亿个标记上进行了训练。这种广泛的训练数据集帮助模型从大量信息中学习和泛化,提高其在各种任务上的性能。

量化和效率:对于对模型效率感兴趣的用户,Llama 3.1 支持 fp8 量化,这需要 fbgemm-gpu 包和 torch >= 2.4.0。这个功能有助于在保持性能的同时减少模型的计算和内存需求。

怎么保证安全?

虽然 Llama 3.1 很强大,但 Meta 也担心它可能会被用来做坏事。除了 Meta 在 Llama 3.1 中实施了严格的安全测试,他们还设置了很多安全措施,比如:

进行了很多风险评估,确保 Llama 3.1 在发布前是安全的。

增加了一个叫做“Llama Guard”的安全系统,它可以过滤掉不良的输入和输出。。

看来,Meta 希望通过 Llama 3.1 推动 AI 技术的民主化,让全球的研究者、开发者和组织能够无拘无束地利用其力量。通过与亚马逊、Databricks 和 NVIDIA 等技术公司的合作,Meta 正在构建一个强大的生态系统,以支持开发者定制和细化他们自己的模型。

所以,Llama 3.1 不仅是一个技术奇迹,更是 Meta 对开源 AI 未来的一次大胆投资。它的强大性能、多语言能力、环境友好的设计以及与其他顶尖模型的竞争力,预示着它将在 AI 领域扮演重要角色。随着更多的开发者和组织开始利用 Llama 3.1,我们期待它将如何推动技术进步和创新

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。