生成式大语言模型:SGLang推理框架

Eric An 2024-10-09 15:31:04 阅读 64

SGLang: Efficient Execution of Structured Language Model Programs,由斯坦福大学、加州大学伯克利分校、上海交通大学、德克萨斯大学完成。

动机

大型语言模型(LLMs)越来越多地被用于需要多个生成调用、高级提示技术、控制流和结构化输入/输出的复杂任务。现有的系统缺乏用于编程和执行这些应用程序的效率。

方法

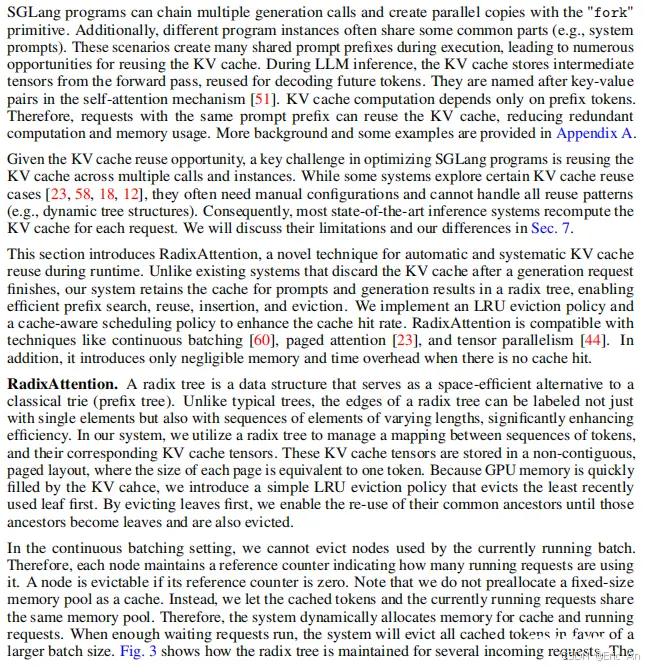

论文介绍了SGLang,这是一个用于高效执行复杂语言模型程序的系统。SGLang由前端语言和运行时(runtime)组成。前端简化了编程,提供了用于生成和并行控制的原语。运行时通过诸如RadixAttention(用于KV缓存重用)和压缩有限状态机(用于更快的结构化输出解码)等新颖优化来加速执行。

实验

使用SGLang实现了各种LLM应用程序,包括代理控制、逻辑推理、少样本学习基准测试、JSON解码、检索增强的生成管道、多轮聊天和多模态处理。在包括Llama7B/70B、Mistral-8x7B、LLaVA-v1.5-7B(图像)和LLaVA-NeXT-34B(视频)在内的模型上进行了性能测试,使用了NVIDIA A10G和A100 GPU。实验结果显示,SGLang在各种工作负载、模型和硬件设置上,与现有的编程和推理系统(如Guidance、vLLM和LMQL)相比,实现了高达6.4倍的吞吐量提升。

结论

SGLang是一个有价值的工具,用于开发高级提示技术和代理工作流程,通过RadixAttention、压缩有限状态机和语言解释器等新颖优化显著提高了复杂语言模型程序的吞吐量和延迟。论文还讨论了SGLang的未来发展方向,包括扩展支持更多输出模态、适应多个存储层次结构的RadixAttention、在RadixAttention中提供模糊语义匹配等。结论强调了SGLang作为一个框架的价值,并指出了其在提高大型语言模型程序执行效率方面的潜力。论文得到了斯坦福自动化推理中心以及来自Astronomer、Google、IBM、Intel、Lacework、Microsoft、Mohamed Bin Zayed University of Artificial Intelligence、Nexla、Samsung SDS、Uber和VMware的支持。通过提出SGLang,展示了一种新的方法来提高大型语言模型程序的执行效率,这对于开发复杂的语言模型应用程序具有重要意义。

上一篇: AI绘画SD中,如何保持生成人物角色脸部一致?Stable Diffusion精准控制AI人像一致性两种实用方法教程!

下一篇: Docker本地部署Chatbot Ollama搭建AI聊天机器人并实现远程交互

本文标签

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。