为什么AI大模型连简单的加法都算不对?

CSDN 2024-10-13 14:01:01 阅读 100

为什么AI大模型连简单的加法都算不对?

问题原因1. 模型的训练目标不是计算器2. 缺乏逐位精度运算的机制3. 小数和浮点数精度问题4. 累积误差5. 语言模型的工作机制——自回归生成6. 训练数据不足以覆盖复杂计算场景

解决办法准备工作代码展示效果展示

参考文章

这个问题引发了一个常见的现象,即大模型(如讯飞星火、Kimi等)在涉及简单的加法运算时,结果经常不准确。我想主要有以下几个原因:

问题原因

1. 模型的训练目标不是计算器

大语言模型(如GPT、讯飞星火、Kimi)并不是为数学运算专门设计的。它们的主要目标是生成符合语义和上下文的自然语言。虽然它们能处理一些简单的运算,但它们在本质上是基于模式匹配和统计语言模型。这意味着它们更擅长处理语言信息,而不是精确地执行数学计算。

2. 缺乏逐位精度运算的机制

在语言模型的架构中,数字和符号只是模型处理的语言片段,而非按照传统编程语言的数值变量进行处理。加法的本质对于模型来说是一种模式学习(例如,看到「2 + 2 = 4」这样的表达),而不是逐位的数值运算。因此,如果出现更复杂的数值组合,模型会根据训练数据和上下文猜测答案,而不会严格遵循数学规则。

3. 小数和浮点数精度问题

当涉及小数和浮点数运算时,大语言模型可能会出现精度问题。语言模型并不会像编程语言中的浮点数计算那样处理精确的小数位数,它可能只是近似输出结果,这就导致了计算结果的不一致。例如,在加法过程中,小数点后的数字可能被舍入或被忽略。

4. 累积误差

当多个数值相加时,错误可能会逐步累积,尤其是当模型在预测下一个数值时。如果模型的某一步运算有微小的偏差,后续步骤会进一步加大误差,最终导致结果偏离正确答案。这就是为什么在处理较多的加数时,错误会更加明显。

5. 语言模型的工作机制——自回归生成

大多数自然语言生成模型(包括GPT系列)采用的是自回归生成机制。每次生成下一个数字时,它基于当前的输入状态来预测下一个数值或符号。因此,模型在加法计算时并非一次性处理所有的数值,而是每次处理一个部分。在预测的过程中,尤其是面对复杂的数值,可能会发生推断上的偏差或错误。

6. 训练数据不足以覆盖复杂计算场景

尽管大模型在训练过程中可能见过大量的数学表达式,但这些表达式可能并不足以让模型完全掌握复杂场景下的数值计算规则。尤其是在涉及多个小数或较大范围的加减乘除运算时,训练数据的局限性可能会导致错误。

解决办法

虽然大语言模型在自然语言生成和理解方面有其独特的优势,但在涉及精确计算时,还是应该使用专门的数学库或计算工具(如Python的<code>numpy、calculator、Excel等)。如果需要在聊天中进行复杂计算,可以通过调用专门的计算插件来确保结果的正确性。下面使用 LangChain 自定义Tool来实现能进行加法计算的AI对话助手。

准备工作

<code>pip install --upgrade langchain

pip install --upgrade langchain-openai

代码展示

from dotenv import load_dotenv, find_dotenv

from langchain_openai import ChatOpenAI

from langchain.agents import initialize_agent, Tool

from langchain.agents import AgentType

# 加载环境变量

_ = load_dotenv(find_dotenv()) # 读取本地 .env 文件,里面定义了 OPENAI_API_KEY

# 模型

llm = ChatOpenAI(model="gpt-4o-mini", temperature=0)code>

# 定义一个能够执行加法运算的函数,支持整型和浮点型数据

def add_numbers(inputs: str) -> str:

try:

# 提取输入中的两个数字,假设用户输入的是"5 + 3.2"这种格式

print("inputs:", inputs)

numbers = inputs.split("+")

if len(numbers) != 2:

return "Please provide input in the format 'a + b'."

# 将字符串转换为浮点数并计算结果,支持整型和浮点型数据

num1 = float(numbers[0].strip())

num2 = float(numbers[1].strip())

result = num1 + num2

return f"The result of { num1} + { num2} is { result}."

except ValueError:

return "Invalid input. Please provide valid numbers in the format 'a + b'."

# 创建Tool工具,LangChain的Agent可以调用这个工具来执行加法

add_tool = Tool(

name="add_numbers",code>

func=add_numbers,

description="Takes two numbers (integer or float) in the format a + b and returns their sum."code>

)

# 初始化代理,并将加法工具传递给代理

tools = [add_tool]

# 使用initialize_agent来创建代理

agent = initialize_agent(

tools,

llm,

agent_type=AgentType.ZERO_SHOT_REACT_DESCRIPTION,

verbose=True

)

# 与代理进行交互,测试整型和浮点型运算

result_int = agent.run("What is 10 + 20?")

result_float = agent.run("What is 5.5 + 3.2?")

print(result_int)

print(result_float)

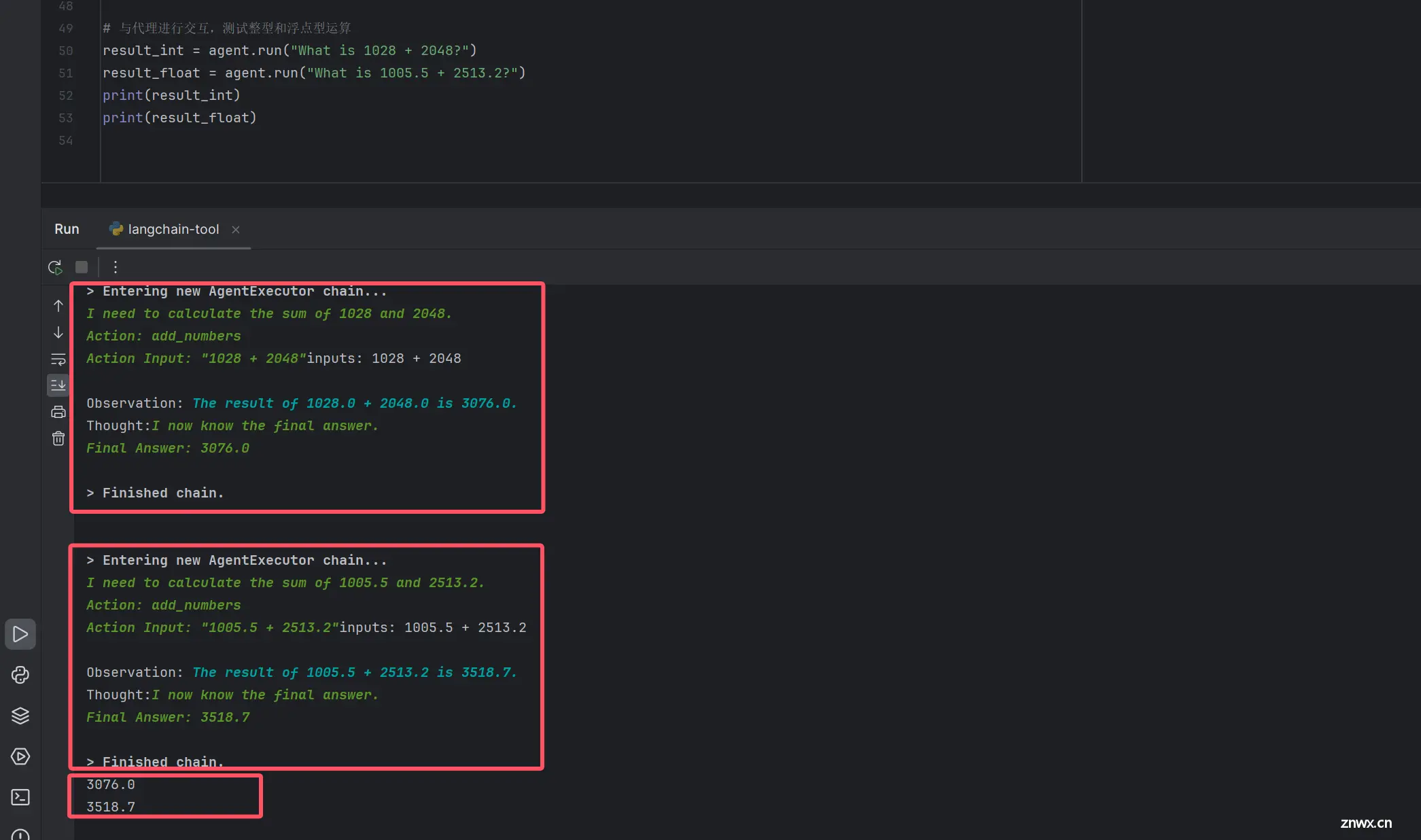

效果展示

通过计算整形1028 + 2048和浮点型 1005.5 + 2513.2 都得到了正确答案。

上面只是参考,更复杂的情况可通过自定义tool来实现!

参考文章

如何开通OpenAPI key?

100行代码实现自己的RAG知识库

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。