AI面试指南:AI工具总结评测,助力求职季

GoAI 2024-10-12 14:31:01 阅读 77

AI面试指南:AI工具总结评测,助力求职季

摘要: 在竞争激烈的AI领域秋招季,准备充分并借助高效工具是提升面试通过率的关键。本文主要介绍一些针对秋招的AI面试工具和学习资源,分为简历优化、面试助手、手撕代码练习三个方向,这些工具不仅能帮助求职者优化简历、丰富面试知识,还能提高编程技能,为秋招做好充分准备,帮助求职者提高面试准备的效率和成功率。

🎉面试首选:

👨💻作者简介: CSDN、阿里云人工智能领域博客专家,新星计划计算机视觉导师,百度飞桨PPDE,专注大数据与AI知识分享。

博主专栏系列: 深度学习、计算机视觉、机器学习、大模型、NLP、多模态、AIGC、大数据开发、数据分析等

AI专栏:最全AI领域专栏来啦,《深入浅出AI》重磅更新!

本次分享将从知识库总结、简历优化平台、面试AI助手、手撕代码平台介绍,下面正式开始:

一、知识库总结

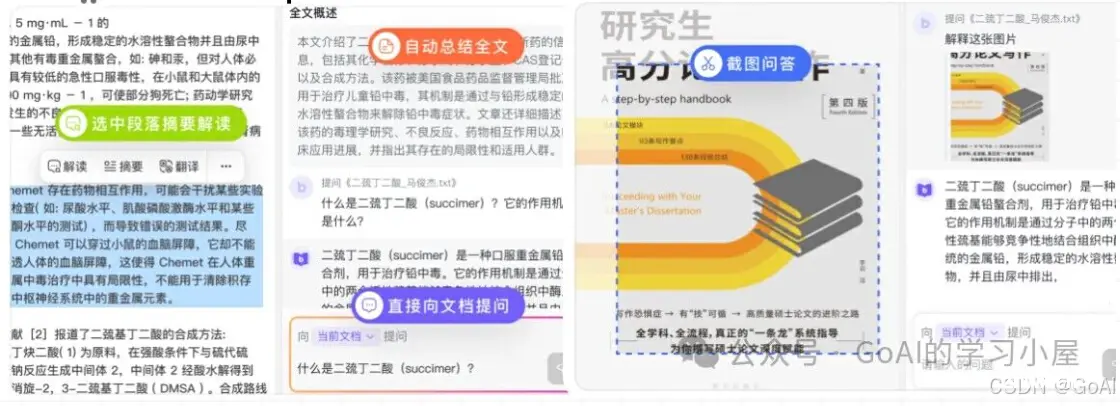

1.包阅AI:

官网 【包阅AI即时提练总结,高效获取答案 】

包阅AI提供免费AI读论文/报告/合同,主要针对文档内容和AI对话结论,均可生成笔记。个人感受使用下来比较方便,可帮助大家快速积累相关技术的论文综述及理论知识,有助于面试前期搭建自己的知识库。

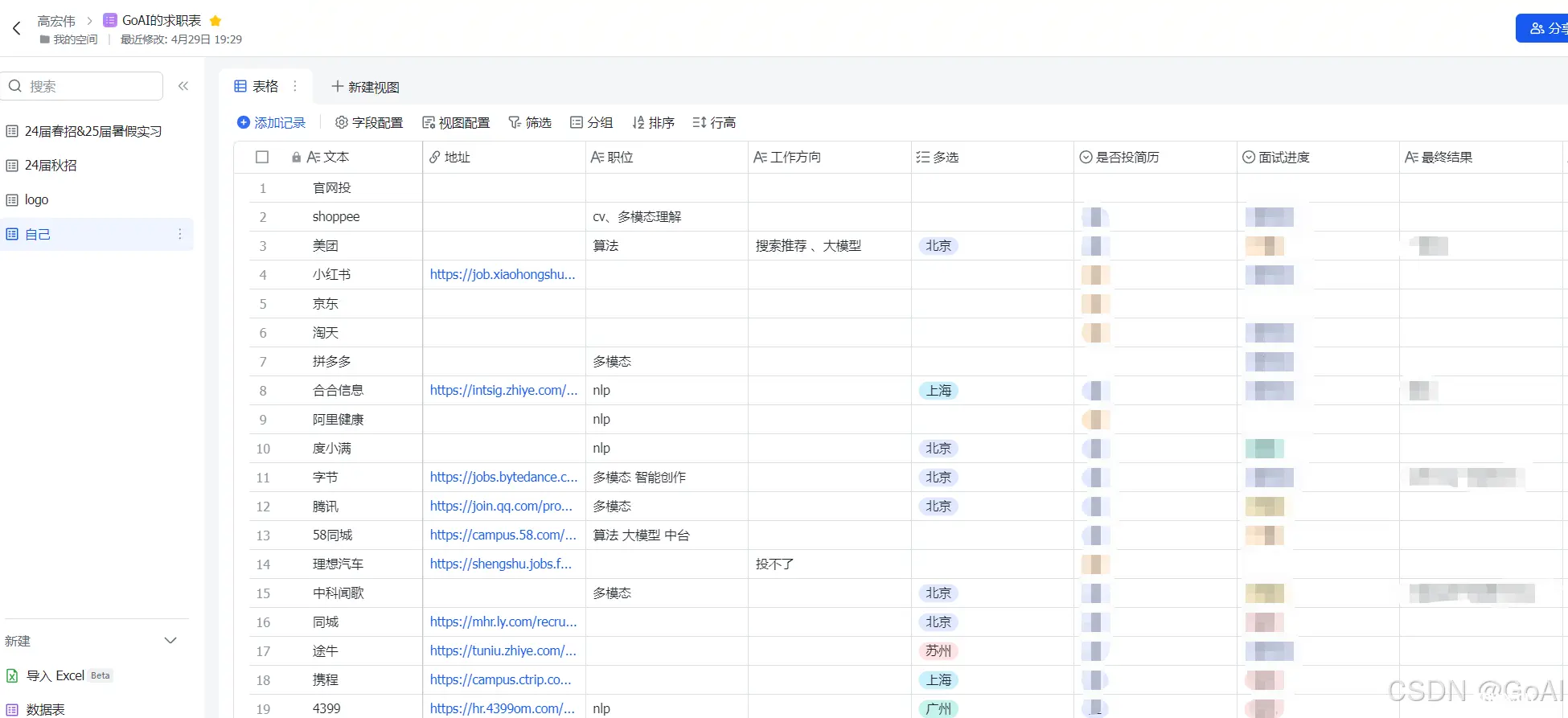

2.飞书

本人常用笔记软件之一,最主要功能齐全,且可用于共享给别人日常笔记 ,同时 多功能表格可以帮助大家记录秋招求职进度,非常方便,个人感觉非常好用!以下为自己秋招时期记录的表格,大家可以按需取用!

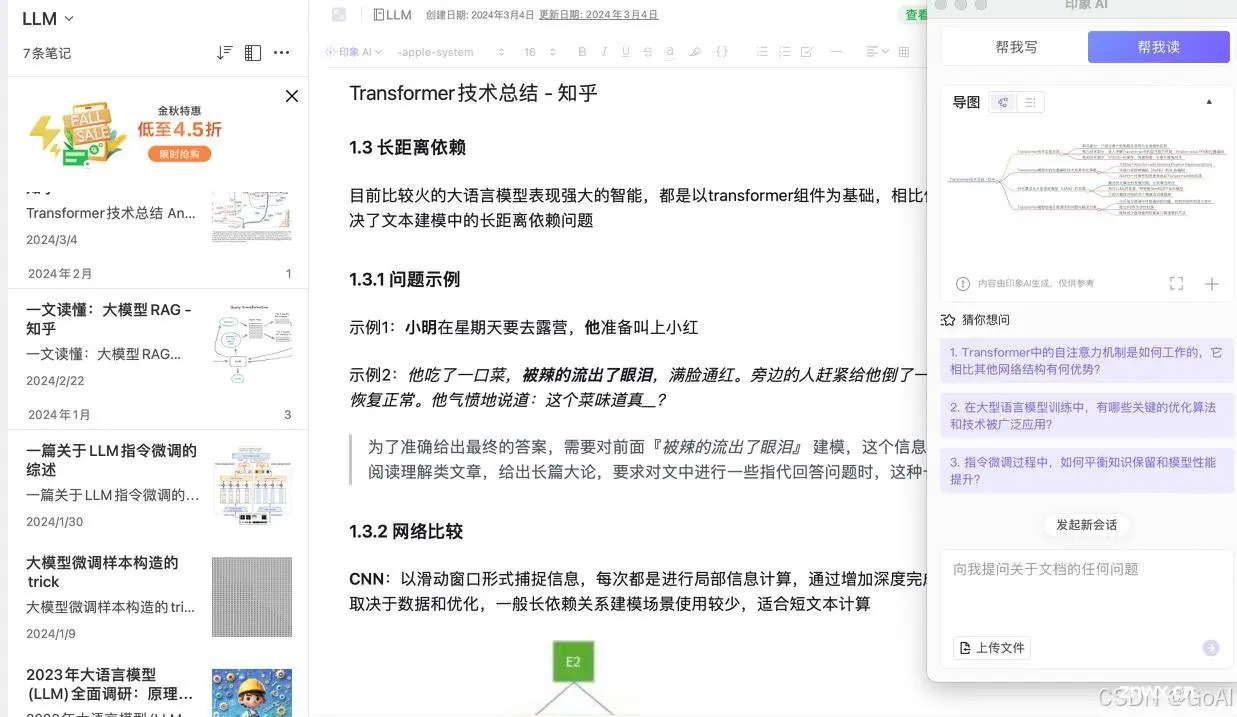

3.印象笔记

印象笔记作为用的很久的笔记软件,其中AI帮我读功能个人感觉比较好用,加上自带的网页简藏功能,可以提升看到好的资料收藏后的阅读效率,避免很多人收藏资料即吃灰~

二、简历优化平台

1. 文心智能体平台

主页:https://agents.baidu.com/center

零代码模式可以给定扮演角色,构建属于你自己的求职助手,比如简历助手、简历优化、简历模版等直接进行对话,帮忙写简历和优化内容。

2. Boss(内容润色)

Boss简历:https://www.zhipin.com/web/geek/resume

除内推及公司官网外,现在Boss应该是互联网大众的首选投简历平台,其在线填写简历过程中有润色功能,可以帮助小伙伴丰富简历内容,比如专业名词的使用、减少口语化描述(实在没什么写的内容还可以帮忙凑字数~)。同时,注意项目介绍要结合具体数字指标,体验下列使用不错,但每天有免费使用次数。

3. 牛客网(简历点评)

之前本人在找工作阶段无意间发现牛客网的简历提供点评功能,会针对一些简历存在问题指出改进建议,可以直接采纳,还可以针对你的简历列出面试官可能问的面试问题,可用自我检查,方便构建知识库,增加面试通过率,比较方便,不过目前应该是收费。

以下为自己简历的示例 :

整体点评;

该简历显示出求职者在教育背景方面有较好的学历和专业背景。在校期间,求职者担任了百度飞桨领航团团长的职位,负责组织各类技术沙龙和开源讲座活动,并参与各类AI竞赛。此外,求职者还获得了一等奖学金、单项奖学金和省政府奖学金等荣誉。在工作经历方面,求职者曾在百度在线网络技术有限公司担任算法职位,负责调研和优化多模态经典模型在搜索领域的应用,以及学习主流大模型的原理并进行微调。求职者还在北京世纪好未来教育科技有限公司和万达信息股份有限公司有过工作经历,参与了图像识别、大模型和多模态模型的研发工作。在项目经历方面,求职者参与了大模型项目和少数民族语言识别项目等多个计算机视觉和NLP综合项目。此外,求职者具备丰富的职业技能和获奖经历,拥有博客专家和开源特营导师等身份。总体而言,求职者在学术背景、工作经历和项目经历方面都表现出较强的能力和经验。

其他模块:

所有的模板你都可以放心用,按你的经验,简历要尽量保证在一页以内。简历并不是生平介绍,不需要把所有做过的事情都列举出来,简历是一个面向未来老板的广告,目标是帮你拿到合适工作的面试,老板他们只关心你能给她的工作带来什么好处,你具备的技能能帮她完成什么任务,你曾经的经验能给公司带来什么帮助,他们只对这些内容感兴趣。建议你精简简历内容,降低HR的阅读成本。

可能的面试题:

请介绍一下你在XX大学的学习经历。你在百度在线网络技术有限公司的工作经历中,你负责了哪些具体的算法工作?可以分享一下你在图像检索和模型优化方面的具体工作内容吗?在北京世纪好未来教育科技有限公司的工作中,你负责了哪些具体的任务和项目?可以分享一下你在绘本图像识别和大模型低代码教育助手方面的工作经验吗?你参与过的大模型项目中,你负责了哪些具体的工作?可以分享一下你在教育知识助手和少数民族语言识别项目中的具体工作内容和技术实现吗?在计算机视觉及NLP综合项目中,你参与了哪些具体的项目?可以分享一下你在医疗单据识别、验证码识别和手写识别方面的工作经验和成果吗?你在智慧交通预测系统项目中担任负责人,可以详细介绍一下你在交通流量预测、车牌检测和识别以及可视化阶段的具体工作内容和成果吗?你在职业技能方面有哪些专长?可以详细介绍一下你在计算机视觉和NLP算法方面的技术能力和经验吗?你获得过一些奖项和奖励,可以分享一下你获得这些奖项的原因和过程吗?你在校期间和工作中遇到的最大的挑战是什么?你是如何应对和解决这些挑战的?你在项目中遇到过的最困难的问题是什么?你是如何解决这个问题的?你对未来的职业规划和发展方向是什么?你有什么样的目标和计划?你为什么对AI领域感兴趣?你对未来AI技术的发展有什么样的看法和期待?

三、面试AI助手

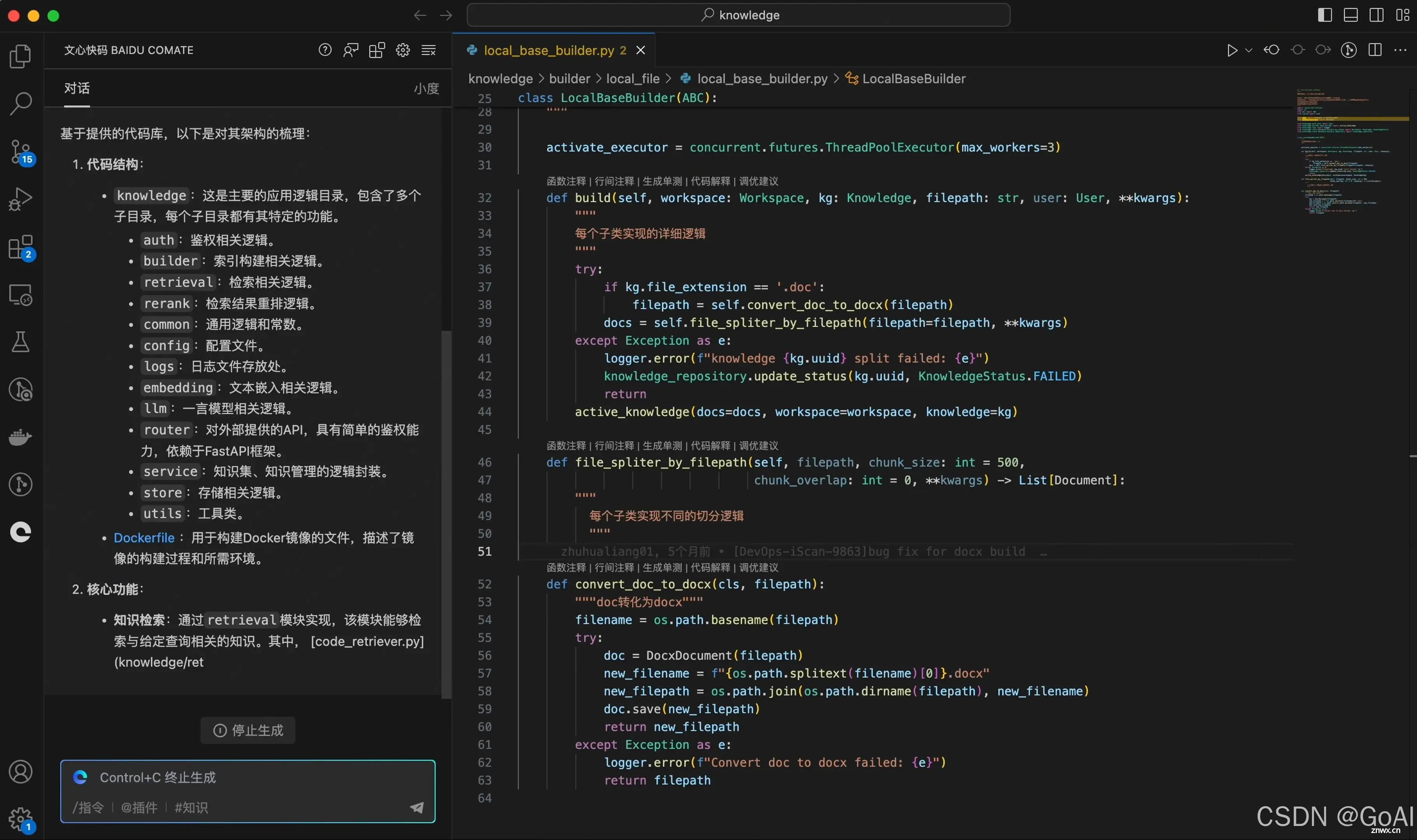

1.文心快码

主页:https://comate.baidu.com/zh](https://comate.baidu.com/zh

文心快码(Baidu Comate)是一款又好又快的智能代码助手。基于文心大模型,结合百度积累多年的编程现场大数据和外部优秀开源数据,新一代编码辅助工具文心快码拥有代码智能、场景丰富、创造价值、广泛应用等多重产品优势,可实现“帮你想、帮你写、帮你改”的场景应用形态。提升编码效率,释放“十倍“软件生产力。

在实际使用中,深刻体验到“Baidu Comate智能编码助手”的便利,特别是在代码质量的提升方面展现了其独特优势,自动代码注释、智能问题解决建议,以及对话式AI视图的应用,不仅简化了日常开发中的繁琐任务,还显著提高了代码的可读性和可维护性。这些功能不仅仅在我忙碌的开发过程中节省了大量时间,还让我的开发工作更加高效和愉悦。

界面简洁:

功能较全,涉及代码生成、代码注释与注释生成大妈、代码单测、代码优化等。支持多语言,多IDE。

功能特点

实时续写:在编写代码过程中,Comate能够实时智能生成完整代码块。

注释生成代码:开发者只需在注释中描述所需功能,即可生成完整函数。

对话式生成代码:通过交互式的自然语言对话,Comate可直接生成所需代码。

生成单元测试:它能为单个函数生成单元测试,也支持批量生成。

代码优化:Comate能优化不良代码,例如将过长函数拆分为功能清晰、易理解的合理大小的函数。

代码解释:支持解释完整函数代码或选中的代码段。

技术问答:开发者可在对话框中输入研发中遇到的问题,并迅速获得解答。

安装参考:

Vscode安装步骤:https://comate.baidu.com/zh/download

使用示例:

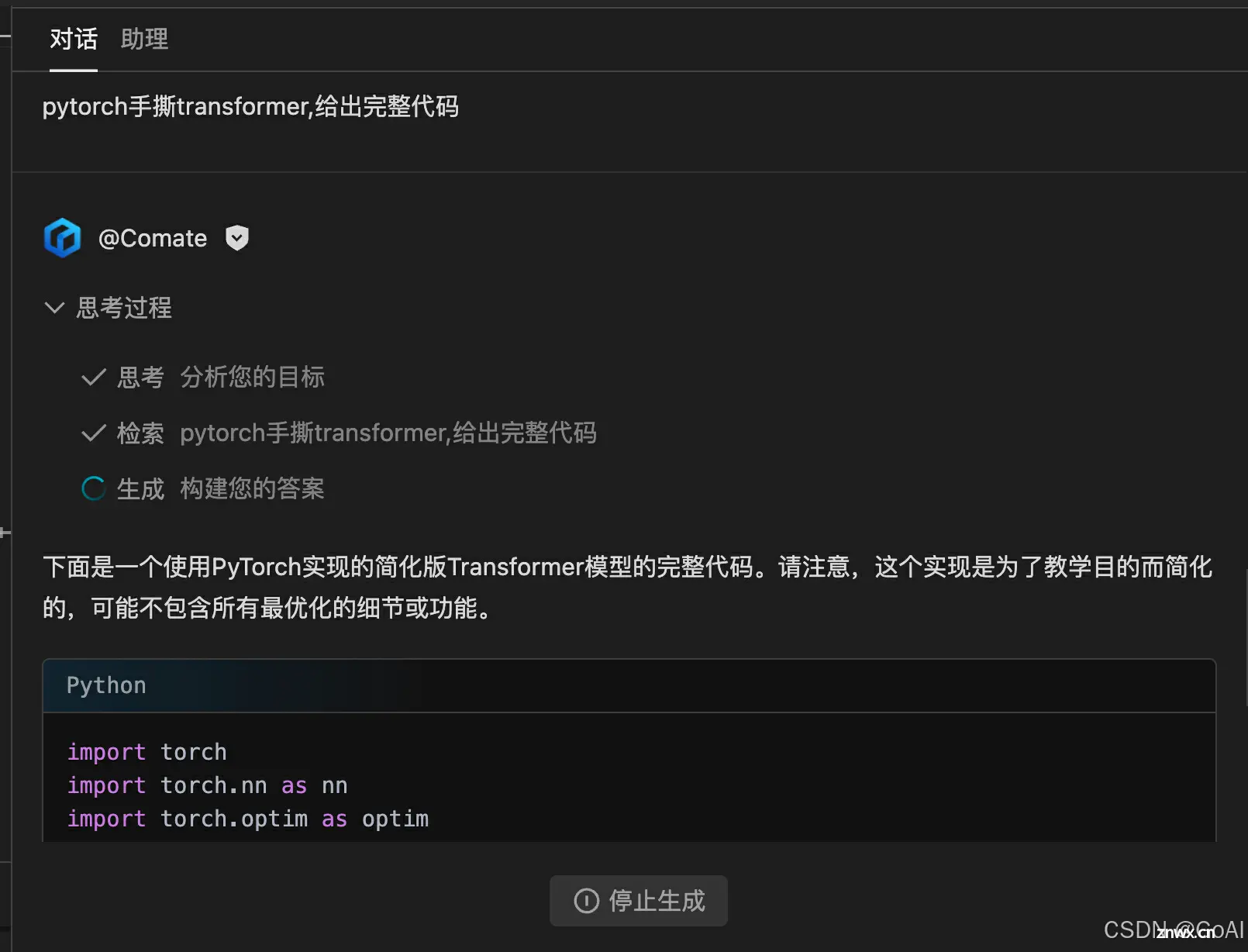

题目:pytorch手撕transformer,给出完整代码

完整代码展示:

<code>import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

# Multi-Head Attention

class MultiHeadAttention(nn.Module):

def __init__(self, embed_size, heads):

super(MultiHeadAttention, self).__init__()

self.embed_size = embed_size

self.heads = heads

self.head_dim = embed_size // heads

assert self.head_dim * heads == embed_size, "Embedding size must be divisible by number of heads."

self.values = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.keys = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.queries = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.fc_out = nn.Linear(heads * self.head_dim, embed_size)

def forward(self, values, keys, query):

N = query.shape[0]

value_len, key_len, query_len = values.shape[1], keys.shape[1], query.shape[1]

# Split the embedding into self.heads different pieces

values = values.reshape(N, value_len, self.heads, self.head_dim)

keys = keys.reshape(N, key_len, self.heads, self.head_dim)

queries = query.reshape(N, query_len, self.heads, self.head_dim)

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

# Attention mechanism

energy = torch.einsum("nqhd,nkhd->nhqk", [queries, keys])

attention = torch.softmax(energy / (self.embed_size ** (1 / 2)), dim=3)

out = torch.einsum("nhql,nlhd->nqhd", [attention, values]).reshape(N, query_len, self.heads * self.head_dim)

return self.fc_out(out)

# Transformer Block

class TransformerBlock(nn.Module):

def __init__(self, embed_size, heads, dropout, forward_expansion):

super(TransformerBlock, self).__init__()

self.attention = MultiHeadAttention(embed_size, heads)

self.norm1 = nn.LayerNorm(embed_size)

self.norm2 = nn.LayerNorm(embed_size)

self.feed_forward = nn.Sequential(

nn.Linear(embed_size, forward_expansion * embed_size),

nn.ReLU(),

nn.Linear(forward_expansion * embed_size, embed_size)

)

self.dropout = nn.Dropout(dropout)

def forward(self, value, key, query):

attention = self.attention(value, key, query)

# Add skip connection, followed by LayerNorm

x = self.dropout(self.norm1(attention + query))

forward = self.feed_forward(x)

# Add skip connection, followed by LayerNorm

out = self.dropout(self.norm2(forward + x))

return out

# Simplified Transformer Model

class Transformer(nn.Module):

def __init__(self, source_vocab_size, target_vocab_size, embed_size, num_layers, heads, device, forward_expansion, dropout):

super(Transformer, self).__init__()

self.embed_size = embed_size

self.device = device

self.word_embedding = nn.Embedding(source_vocab_size, embed_size)

self.position_embedding = nn.Embedding(1000, embed_size)

self.layers = nn.ModuleList([

TransformerBlock(

embed_size,

heads,

dropout=dropout,

forward_expansion=forward_expansion

)

for _ in range(num_layers)

])

self.fc_out = nn.Linear(embed_size, target_vocab_size)

def forward(self, x, mask):

out = self.word_embedding(x) + self.position_embedding(torch.arange(0, x.shape[1]).to(self.device))

# In the Encoder the Query, Key, Value are all the same.

for layer in self.layers:

out = layer(out, out, out)

out = self.fc_out(out)

return out

# Example usage

# Note: This is a very simplified example and doesn't include training loop, data loading, etc.

embed_size = 256

num_layers = 4

heads = 8

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

forward_expansion = 4

dropout = 0.1

model = Transformer(source_vocab_size=10000, target_vocab_size=10000, embed_size=embed_size, num_layers=num_layers, heads=heads, device=device, forward_expansion=forward_expansion, dropout=dropout)

model.to(device)

# Dummy input

x = torch.randint(0, 10000, (64, 35)).to(device) # Batch size 64, sequence length 35

mask = None # In this simplified example, we don't use masking

output = model(x, mask)

print(output.shape) # Expected shape: [64, 35, 10000]

小Tips: 在每条输出后会根据内容推荐相关问题,引导继续回答,非常方便小伙伴们面试前进行相关问题自测,同时推荐将回答整理成自己的知识库,方便回顾知识点。

总结:

文心快码(Baidu Comate)是一款又好又快的智能代码助手,不仅可以帮助开发者实时推荐和生成代码,还能生成代码注释、查找代码缺陷、给出优化方案,并深度解读代码库。不仅面向打工人工作上可以随时提问,还可以帮助学校的学生们处理科研问题,节省时间提升效率!

ps:搭配文小言更好用哦!

2.豆包MarsCode

豆包MarsCode:官网

活动链接:https://www.marscode.cn/events/s/ikt89TFc/

类似文心快码,可以在各种IDE安装,支持多功能及对话模式。

3.GPT

GPT毫无疑问,扔给它问题,可以直接让它生成回答,非常方便,但重点propmt如何编写是关键。比如在面试大模型岗位,你的propmt可以让它扮演一个大模型领域专家,然后给他相关问题,让它给出详细答案。

这里推荐两个prompt优化网站:

1.promptingguide,学习prompt工程必备教程

2.千帆prompt工程 ,包括propmt模版及优化功能

四、手撕代码平台

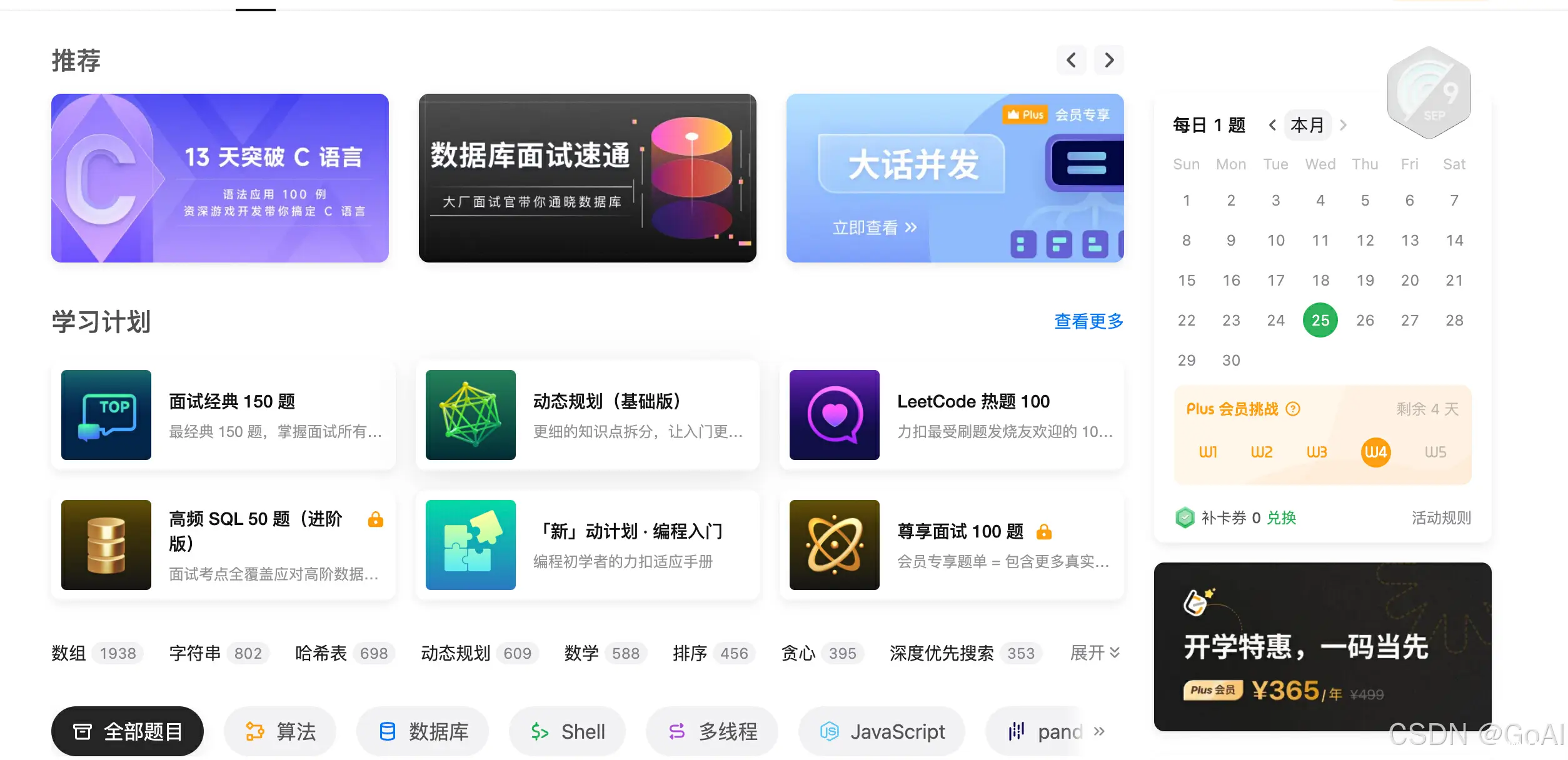

1.Leetcode

毫无疑问,刷题首选还是Leetcode,访问官网:https://leetcode.cn/

时间紧推荐先刷leetcode hot100,有时间按题目类型刷。

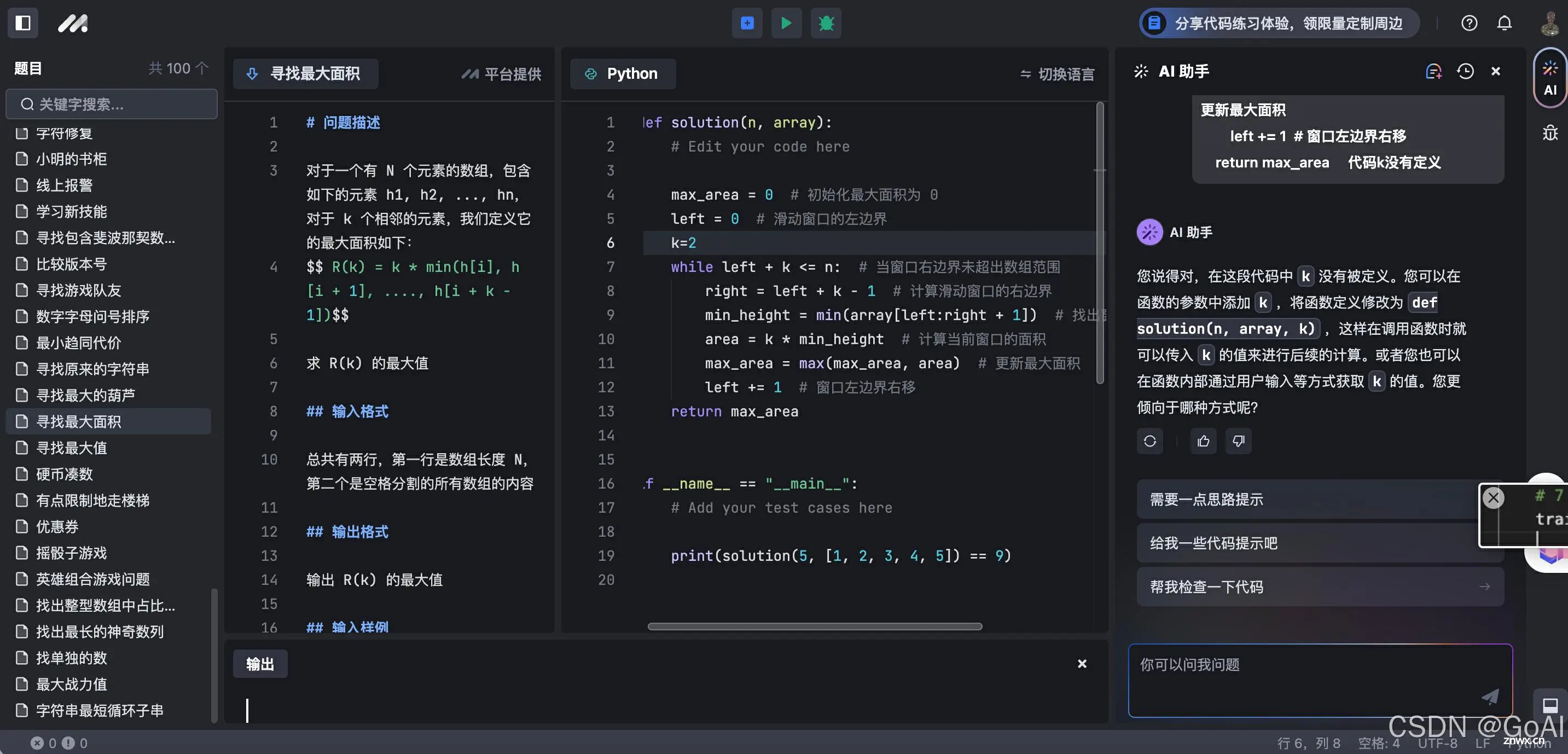

2.豆包MarsCode

目前正值秋招,最近在掘进看到字节的 豆包 MarsCode 最近特推出代码练习能力,将全功能的代码编辑器和 AI 能力相结合,希望帮助开发者更快速地在求职季进行算法题目练习,100 道大厂真题,助力高效掌握算法知识,感觉很适合正在找工作的小伙伴们。

ps:我秋招的时候怎么没有这东西呢!

豆包MarsCode:刷题地址

题目展示:

跟leetcode差不多,区分简单中等困难,题目有的比较新

使用感受

1.界面设计比较适合刷题,可以对话引导做题很不错,想相当于有指导老师指导做题。

2.内置代码注释,回答也很精准,非常好用,大大提高面试经验,助力小伙伴春秋招!

五、总结:

以上为本次分享给大家的助力求职的AI工具推荐,旨在帮助求职者更好地准备面试,提升面试表现。涵盖知识学习、简历优化、面试技巧等多个方面,为AI求职者提供全方位的帮助,最后希望大家秋招顺利!

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。