GPT-SoVITS-WebUI 初体验

CSDN 2024-10-02 16:33:02 阅读 70

一、安装

<code>conda create -n GPTSoVits python=3.9code>

#

# To activate this environment, use

#

# $ conda activate GPTSoVits

#

# To deactivate an active environment, use

#

# $ conda deactivate

二、激活环境

conda activate GPTSoVits

三、补充安装依赖

bash install.sh

四、退出

conda deactivate

五、AutoDL镜像项目启动方法

开启WebUI

echo {}> ~/GPT-SoVITS/i18n/locale/en_US.json && source activate GPTSoVits && cd ~/GPT-SoVITS/ && python webui.py zh_CN

作者:RVC-Boss

链接:https://www.codewithgpu.com/i/RVC-Boss/GPT-SoVITS/GPT-SoVITS-Official

来源:CodeWithGpu

如果把目录移动到了数据盘

echo {}> ~/autodl-tmp/GPT-SoVITS/i18n/locale/en_US.json && source activate GPTSoVits && cd ~/autodl-tmp/GPT-SoVITS/ && python webui.py zh_CN

辨别不同的端口

WebUI 端口 http://localhost:9874/

UVR5 端口 http://localhost:9873/

数据达标 端口 http://localhost:9871/

TTS推理 端口 http://localhost:9872/

这些端口你要主动启动了才会有

UVR5 需要的模型

UVR5 所用到的模型放置路径

GPT-SoVITS/tools/uvr5/uvr5_weights

UVR5 可能用得到的模型

model_bs_roformer_ep_317_sdr_12.9755

数据准备

音频数据清洗和音频切割、音频数据打标是关键

其中音频数据打标最为致命,非常花时间,我一般直接跳过。。。。。。

在打标之前先用UVR5进行音频伴奏分离、混响分离,提取出稍微干净一些的人声

然后就是音频切割,如果是4090,建议每一份切割后的音频都在24秒以下,20秒左右

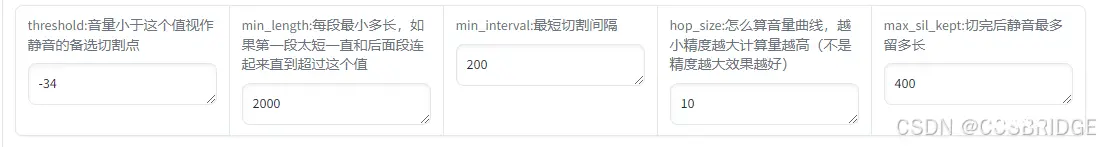

于是我自个儿尝试了以下调整,不一定对啊,参考啊

threshold 不懂 不动

min_length 应该是多长的话语切割一次,不满这个时长则继续等到不少于这个时长为止 单位是毫秒

4090只有24GB显存 我把这个参数调成了 20000 即 20秒

min_interval 应该是说话停顿,说话没有到达停顿 就不要切割

我设置成了 100 , 我怕录音中说话比较密,等讲话者换气的时候 100毫秒是足够了

max_sil_kept 看起来就是静音时间 我从默认的500 改成了100

TTS推理

推理主要是把原先的数据集放回去参考

可能还有更好的方法,但是这个方法是真的简单方便

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。