如何本地部署AI智能体平台,带你手搓一个AI Agent

Cc不爱吃洋葱 2024-10-10 12:31:23 阅读 99

今天分享如何在个人电脑上搭建一个AI智能体平台,可以自定义聊天机器人,设计智能体,编排工作流,知识库,RAG管道等等,还支持本地大模型接入,并对外提供API接口。

如搭建过程有疑问,可查看下方视频号详细讲解视频,也可在公众号主页添加我或进技术群交流。

为什么需要智能体

智能体的必要性源于单一AI模型的局限性。无论是GPT还是其他先进的AI模型,它们在处理复杂问题时总会面临边界。当多个智能体协同工作时,不同模型的优势可以相互补充,形成更具灵活性和智能化的系统。智能体不仅封装了提示词和任务,还能通过多个模型编排突破单个模型的局限,通过分工协作共同解决复杂问题。

多个大模型厂商已经开始推出基于智能体的AI助手,能够集成多个模型的优势来提供更具定制化和深度的服务。最近360与国内15家大模型开发商合作搞出一个”复仇者联盟“,推出的「360 AI助手」也是同样的道理,一个打不过GPT,15个一起上!

重点:Agent真正的价值在于——模型编排(也叫智能体设计Agent Design,现在有一个专业岗位叫Agent Designer)

01

开源LLM应用开发平台

AI Agent–Dify

Dify,源自 Define + Modify,意指定义且持续改进你的 AI 应用,它是为你而做的(Do it for you)。

它融入后端服务, 内置构建 LLM 应用所需的关键技术栈,支持数百个模型、Prompt 编排及流程编排、高质量RAG 引擎、Agent 框架,还提供了一套易用的界面和 API。为开发者节省了许多重复造轮子的时间,使其可以专注在创新和业务需求上。即使你是非技术人员,也可以快速搭建生产级的生成式 AI 应用。

Dify核心功能比较

1. 工作流: 在画布上自由构建和测试功能强大的 AI 工作流程。

2. 全面的模型支持: 与数百种闭源/开源 LLMs 以及数十种推理提供商和自托管解决方案无缝集成,涵盖 GPT、Llama3 以及Ollama平台。

3. Prompt IDE: 用于制作提示、比较模型性能以及向基于聊天的应用程序添加其他功能的直观界面。

4. RAG 管道: 从文档摄入到检索的所有内容,支持从 PDF、PPT 和其他文档格式中提取文本。

5. Agent 智能体: 可基于 LLM 定义 Agent,并为 Agent 添加自定义工具。Dify 为 AI Agent 提供了50多种内置工具,如谷歌搜索、DALL·E、Stable Diffusion。

6. LLMOps: 随时间监视和分析应用程序日志和性能。

7. 后端即服务: Dify功能带有相应的 API,可以将 Dify 集成到自己的业务应用中。

Dify能做什么

1. 创业:可快速将 AI 应用创意变成现实,已有几十个团队通过 Dify 构建 MVP(最小可用产品)获得投资,或通过 POC(概念验证)赢得了客户的订单。

2. 将 LLM 集成至已有业务:引入 LLM 增强现有应用的能力,接入 Dify 的 RESTful API 从而实现 Prompt 与业务代码的解耦,在 Dify 的管理界面是跟踪数据、成本和用量,持续改进应用效果。

3.作为企业级 LLM 基础设施:部分银行和互联网大厂正将 Dify 部署为企业内的 LLM 网关,加速 GenAI 技术在企业内的推广,并实现中心化的监管。

02

如何部署Dify

1.安装Docker

Docker 是一个小白就能轻松上手的开源容器平台,专为开发、部署和运行应用程序而设计。Docker 提供了一种轻量级的虚拟化方式,使得应用程序能够快速部署且易于管理。

1.1 Docker下载:

官网:docker.com/products

支持Mac\Windows\Linux,选择适合的版本。

1.2 Docker安装:

一键安装docker。

安装成功后docker的 UI 界面,如下:

2.部署 Dify

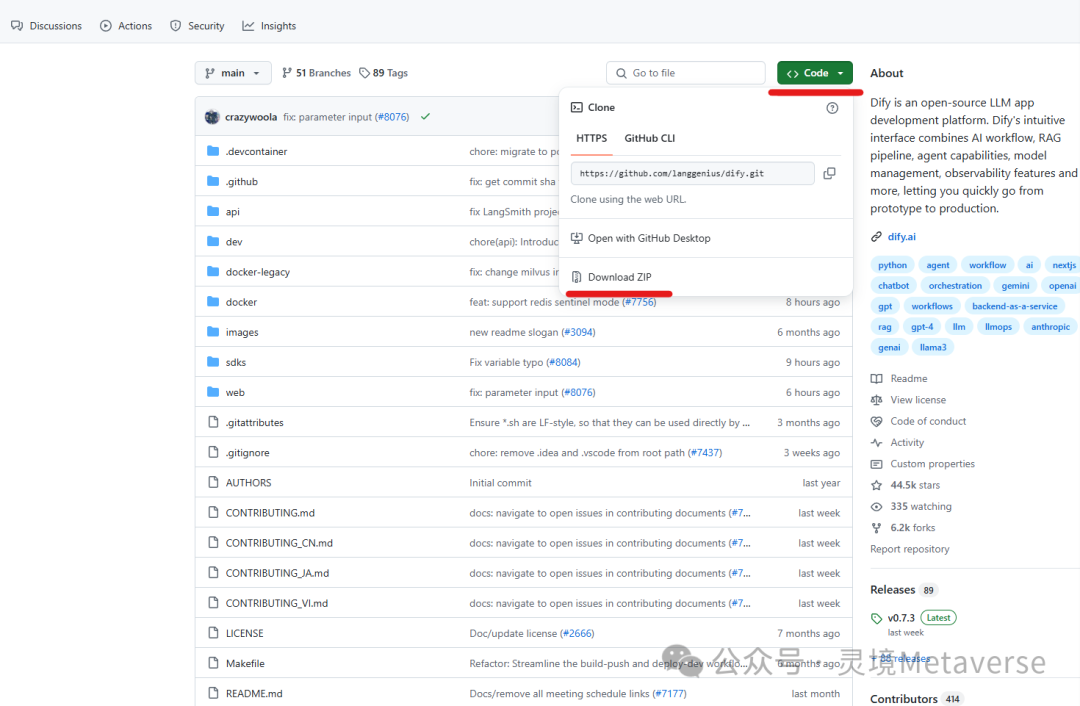

2.1 获取Dify源代码

有两种方式,都很简单。

一是通过Git命令行克隆,只需要一条命令自动拉取。

打开Git bash输入命令:

git clone https://github.com/langgenius/dify

二是在GitHub 下载源码,放到指定文件夹即可。

访问 https://github.com/langgenius/dify点击"Code",选择"Download ZIP"

2.2 解压文件:

2.3 启动Dify

解压后打开docker文件夹,找到这个文件”docker-compose.yaml“,使用Git Bash打开。

同样也是一条简单命令拉取,很快就完成了。

运行命令:docker compose up -d

然后我们就能在Docker界面看到出项一栏Docker,那Dify就部署成功了。

3.打开Dify,配置账户信息

Dify本地部署完成后,需要从本地网址登录。

本地网址:http://127.0.0.1/apps

配置账户信息

然后就可以正式登录了。

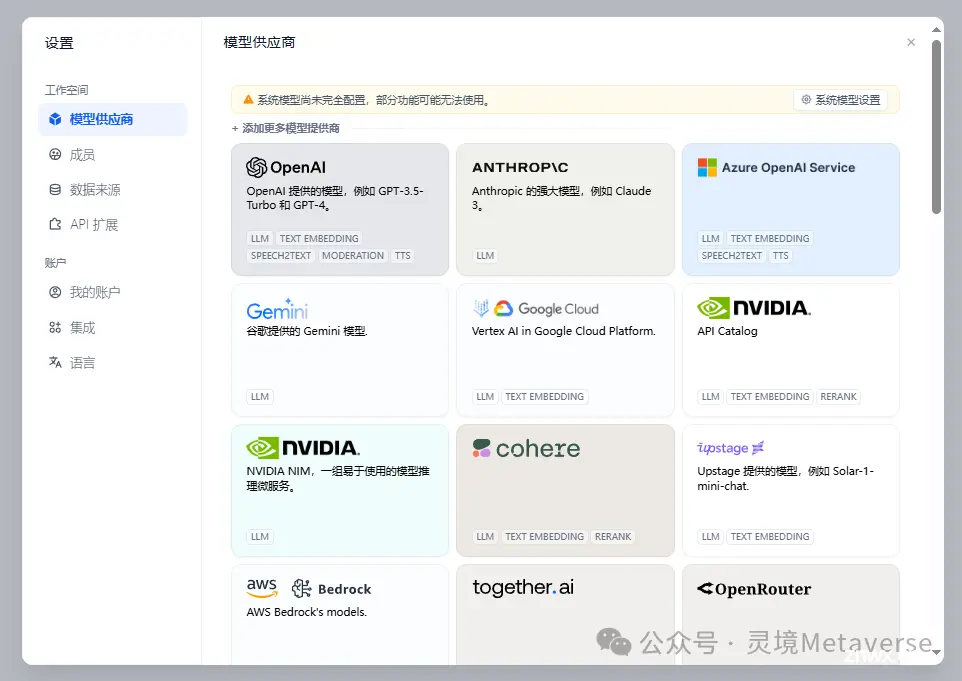

4.Dify界面

主界面介绍

可用大模型管理:

Dify有很多强大的功能等着我们一起探索。

如何学习AI大模型?

?

大模型时代,火爆出圈的LLM大模型让程序员们开始重新评估自己的本领。 “AI会取代那些行业?”“谁的饭碗又将不保了?”等问题热议不断。

不如成为「掌握AI工具的技术人」,毕竟AI时代,谁先尝试,谁就能占得先机!

想正式转到一些新兴的 AI 行业,不仅需要系统的学习AI大模型。同时也要跟已有的技能结合,辅助编程提效,或上手实操应用,增加自己的职场竞争力。

但是LLM相关的内容很多,现在网上的老课程老教材关于LLM又太少。所以现在小白入门就只能靠自学,学习成本和门槛很高

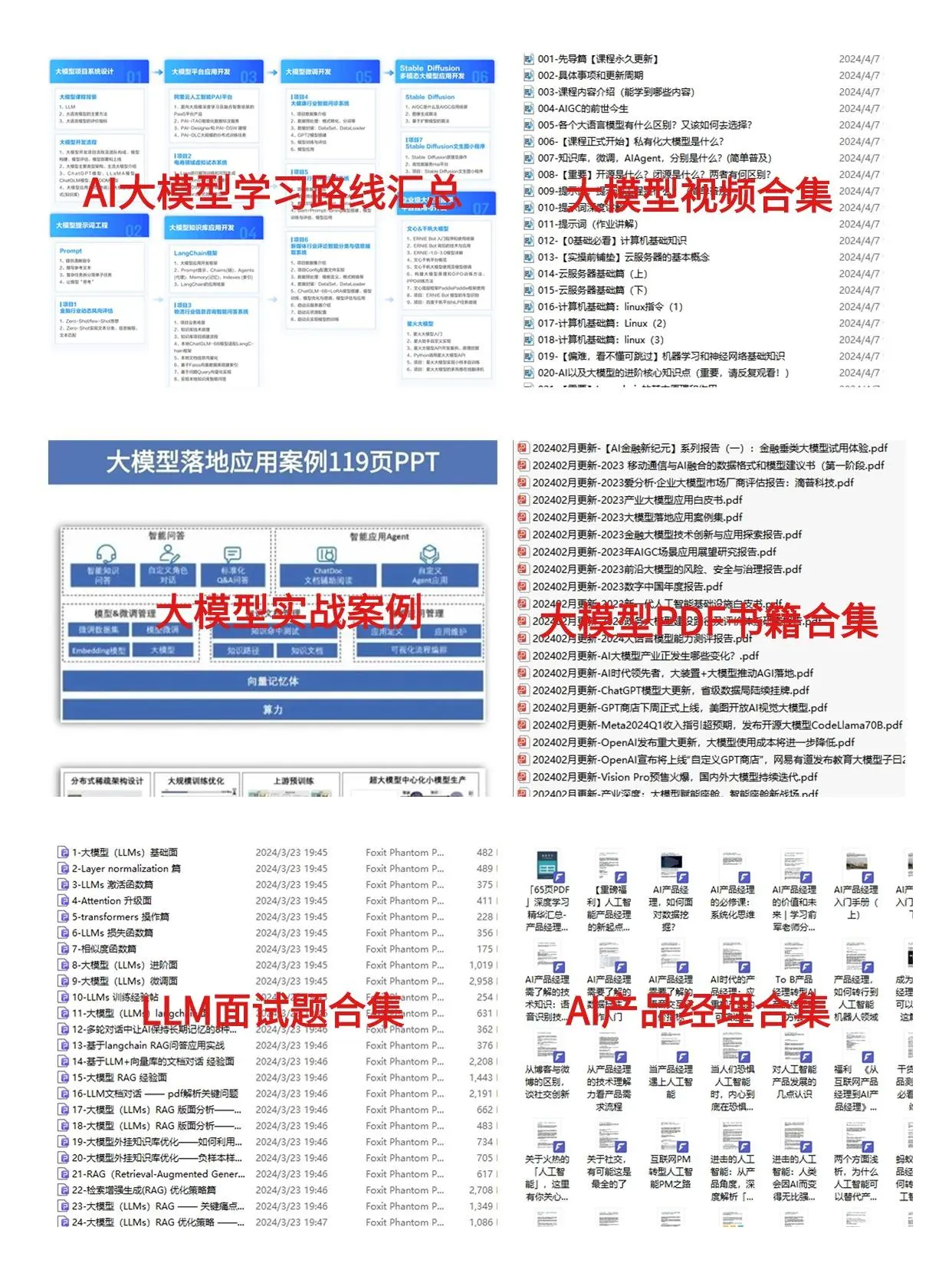

那么针对所有自学遇到困难的同学们,我帮大家系统梳理大模型学习脉络,将这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

👉[CSDN大礼包🎁:全网最全《LLM大模型入门+进阶学习资源包》免费分享(安全链接,放心点击)]()👈

学习路线

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。