AI虚拟人的发展与挑战:表象与背后的技术瓶颈

百锦再@新空间代码工作室 2024-09-20 17:01:01 阅读 65

随着人工智能技术的快速进步,AI虚拟人作为一种新兴技术应用,正在逐渐渗透到影视制作、娱乐、教育、商业等多个领域。通过AI技术生成虚拟角色并使其能够在数字环境中与人类进行互动,这种技术无疑展示了未来虚拟社交和虚拟体验的广阔前景。无论是通过文字描述、图像生成,还是语音模拟,AI虚拟人展现出其卓越的表象能力,给人以"无所不能"的错觉。

然而,尽管AI虚拟人在外观、语言和基本动作的表现上取得了显著的进步,背后依然存在一系列技术瓶颈,导致其在真实应用中仍然面临诸多挑战。本文将从AI虚拟人在动作、表情、环境交互及自由操控等方面存在的问题进行详细分析,并阐述AI虚拟人的互动应用还有很长的路要走。

AI虚拟人动作的局限性

动作的不可拆分性与自由组合的限制

当前的AI虚拟人生成技术大多依赖于预设的动作库。这意味着虚拟人所展示的动作往往是提前设计好的一整套固定动作序列。这种固定动作库虽然能够应对一些简单的情景,例如面部表情的变化、简单的肢体动作等,但在复杂的交互场景中,AI虚拟人动作的组合与变化仍然显得僵硬。正因为如此,用户难以灵活地操控AI虚拟人的每个关节、肢体的微小动作,使得动作的自然度大打折扣。

美女播音

游戏中的虚拟人物通常可以通过编写脚本实现高度自由的动作和行为变化,而AI虚拟人则无法实现这种精确的控制与组合。这种限制极大地影响了AI虚拟人的表现力,使其在真实交互中的应用受到了很大约束。

动作与表情的同步问题

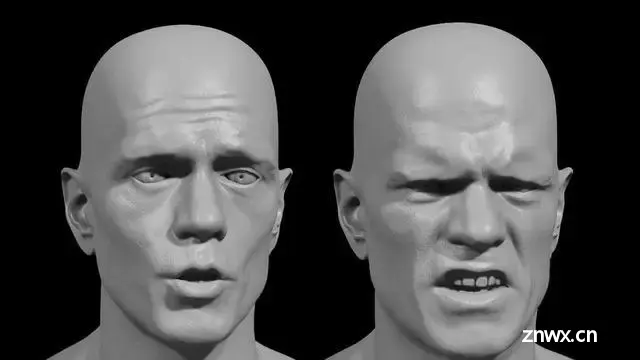

AI虚拟人在处理口型与面部表情时,也面临着诸多问题。例如,在将固定动作序列应用于不同语音场景时,尽管可以通过算法调整虚拟人的口型以适应发音的需求,但面部表情的自然度却难以保持。尤其是在虚拟短视频生成的场景中,当AI虚拟人进行头部转动、角色转身等动作时,容易产生口眼歪斜、面部拉扯等不自然的视觉效果。这种缺乏精确的面部动作同步与协调,使得AI虚拟人表情的细腻程度远远无法达到真实人类的标准。

动作连贯性的不足

在现实场景中,人类动作是高度连贯且无缝衔接的,然而当前的AI虚拟人生成技术仍然难以模拟这种自然的运动流畅性。AI虚拟人的动作通常是分段生成的,每一个动作段落之间可能存在细微的不连续,这种不自然的中断容易被观察者察觉,尤其是在长时间的视频或交互场景中,动作的连贯性问题将更加明显。

虚拟短视频生成中的难题

虚拟短视频中的视觉畸变

生成完全虚拟的短视频是AI虚拟人应用的一大亮点之一,但在这个过程中,虚拟人角色在转动头部或改变视角时,往往会出现画面失真或视觉畸变。特别是在面部动作与头部转动的交互过程中,虚拟人的眼睛、嘴巴等细节部位容易产生拉扯或变形,这种现象称为“面部畸变”问题。

这些畸变的产生主要与当前的3D模型生成和渲染技术的不足有关。当AI虚拟人模型在高动态的动作中(如快速转头、复杂肢体动作等)发生变化时,生成的图像无法实时更新面部的细节调整,导致视觉上的失真。这种不自然的视觉效果不仅破坏了AI虚拟人的沉浸感,也影响了观众的观看体验。

多视角下的渲染不一致性

在生成虚拟短视频的过程中,AI虚拟人常常需要从不同视角展示其动作和表情。然而,当前的渲染技术在不同视角下难以保持一致的细节表现。例如,当一个AI虚拟人从正面转身到侧面时,面部的光影效果、纹理细节以及动作的连贯性可能会出现不一致,导致观众产生出戏的感觉。要解决这一问题,AI虚拟人需要更为精细的多视角渲染技术,并提升虚拟角色模型的动态适应性。

虚拟人的环境交互与行为展示的局限

环境交互的有限性

当前AI虚拟人的应用场景多为预设的虚拟环境,这些环境通常是依照既定脚本和逻辑进行设计,虚拟角色的动作和行为都被严格限制在这个框架之内。AI虚拟人能够执行的行为往往是有限的,且缺乏灵活性。与现实中游戏中的虚拟人物不同,AI虚拟人无法根据环境的变化做出自发的反应和调整。这一局限性意味着,AI虚拟人在复杂的应用场景中难以展现出足够的智能和适应能力。

自由操控的瓶颈

与游戏中的虚拟角色可以通过键盘、鼠标或手柄实现自由操控不同,AI虚拟人目前还无法做到高自由度的操作。大多数AI虚拟人应用仍然依赖于预先设定的脚本来执行行为,无法灵活响应用户的即时输入或环境的动态变化。例如,在教育或商业场景中,用户可能希望AI虚拟人能够实时响应复杂的指令并做出相应的动作或决策,但目前的技术无法完全实现这种自由操控。

这一问题的根源在于AI虚拟人的决策机制仍然较为单一,缺乏深度学习中的行为生成与反馈机制。这也意味着,在复杂的互动场景中,AI虚拟人的行为仍然需要大量的人工干预和脚本编写,难以展现出真实的智能交互能力。

AI虚拟人与人类互动的未来之路

表情与动作的精细化处理

为了使AI虚拟人能够达到更高的自然度,未来的技术发展方向将集中在动作和表情的精细化处理上。通过引入更为复杂的动作捕捉技术和高精度的表情模型,AI虚拟人将能够更加自然地表现出细微的情绪变化和动作衔接。同时,结合计算机视觉技术和深度学习算法,AI虚拟人可以实时监测用户的输入并做出动态调整,从而提高交互的灵活性和实时性。

自适应环境交互与智能行为生成

未来的AI虚拟人不仅要在虚拟环境中执行既定的行为,还需要具备更高的环境适应能力。这意味着AI虚拟人能够通过深度学习和行为建模,感知环境的变化并做出相应的反应。通过增强学习和自然语言处理技术的结合,AI虚拟人将能够在更复杂的场景中,自主学习用户的行为模式,并调整自身的行为策略,以更好地服务于不同的应用场景。

多模态交互与全方位体验

为了实现更加自然的互动体验,未来的AI虚拟人将结合语音、肢体动作、表情等多种感知模式,实现多模态交互。多模态交互的核心在于融合不同的输入信号,例如语音、手势、眼神等,使AI虚拟人能够在与用户交互时,理解多维度的信息并做出准确的反馈。这将使AI虚拟人在各类应用中能够展现出更加真实和智能的互动体验。

总结

尽管AI虚拟人在虚拟世界中的表现令人印象深刻,但要实现完全自然、自由的交互体验,仍然有很长的路要走。当前的技术局限主要集中在动作的不可拆分性、表情与动作的同步问题以及环境交互的不足。未来,随着动作捕捉技术、深度学习算法以及多模态交互技术的进一步发展,AI虚拟人将逐步克服这些瓶颈,走向更为自然和智能的互动应用。但在此过程中,技术的发展还需要经过大量的探索与优化。

//python 因为爱,所以学

print("Hello, Python!")

关注我,不迷路,共学习,同进步

关注我,不迷路,共学习,同进步

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。