【AIGC】AI时代的数据安全:使用ChatGPT时的自查要点

CSDN 2024-10-06 08:01:02 阅读 83

博客主页: [小ᶻZ࿆]

本文专栏: AIGC | ChatGPT

文章目录

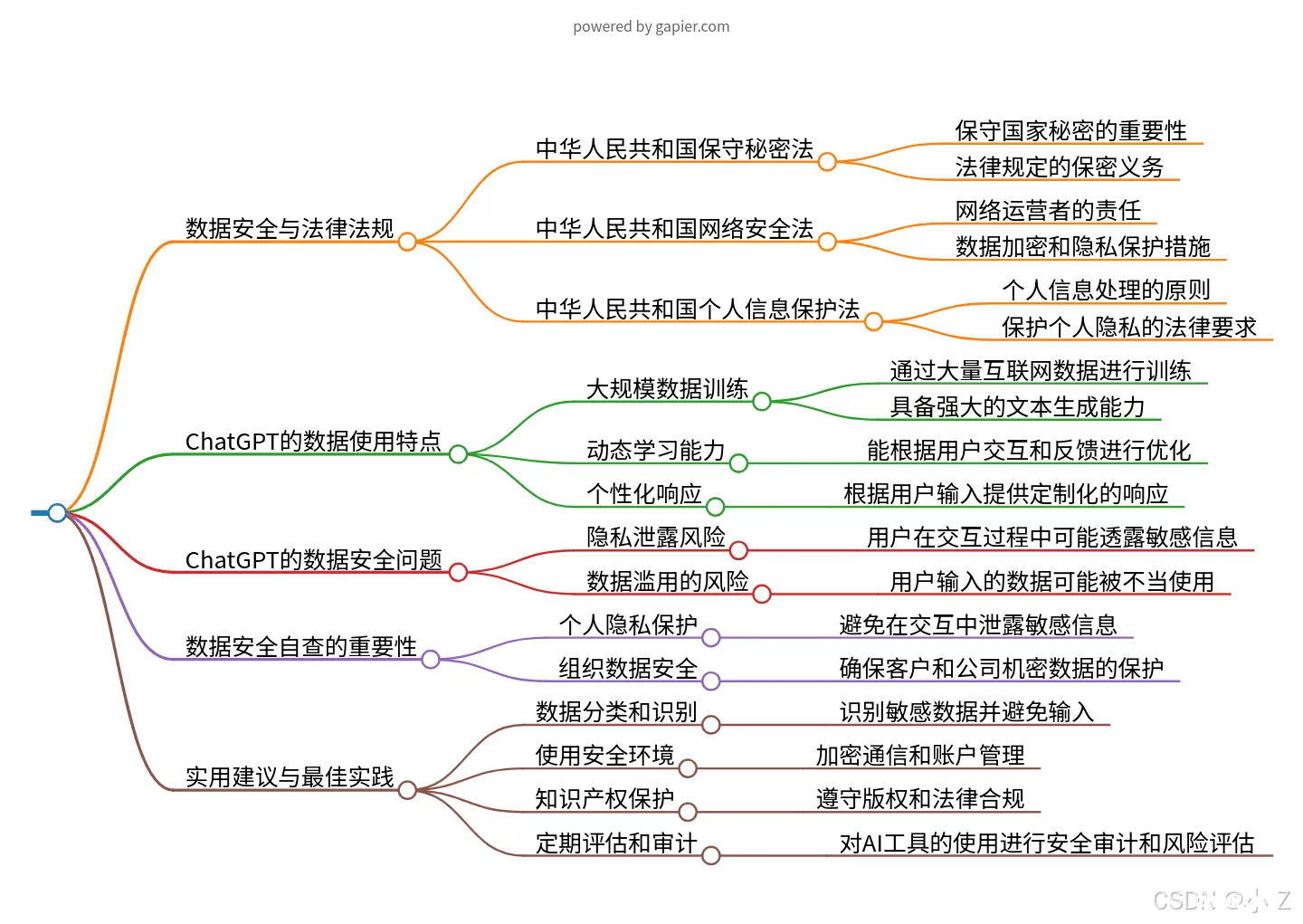

💯前言💯法律法规背景中华人民共和国保守秘密法中华人民共和国网络安全法中华人民共和国个人信息保护法遵守法律法规的重要性

💯ChatGPT的数据使用特点ChatGPT数据安全问题ChatGPT如何处理用户数据用户使用ChatGPT应注意的数据安全风险

💯ChatGPT数据安全自查的重要性💯ChatGPT实用建议与最佳实践💯小结

💯前言

在当今生成式人工智能快速发展的背景下,数据安全问题变得尤为重要。随着AI技术的广泛应用,如何保障数据安全和隐私保护成为了不可回避的课题。尤其是在使用像ChatGPT这样的生成式AI工具时,保护个人和组织的信息安全,避免敏感数据的泄露,已经成为每个用户必须认真思考的关键问题。这不仅关系到用户个人的安全,也对整个社会的数据管理提出了更高的要求。

OpenAI官方文档关于GPT的数据隐私常见问题解答

💯法律法规背景

在处理数据安全问题时,了解相关法律法规的背景是非常关键的。在中国,数据安全和隐私保护法律体系已逐步完善,特别是近年来《网络安全法》、《数据安全法》和《个人信息保护法》的实施,这些法律为数据的采集、存储、处理和使用提供了明确的规范与要求。遵守这些法律不仅是企业和个人的法律义务,更是保障数据安全、预防信息泄露和违规使用的重要措施。

国家法律法规数据库

中华人民共和国保守秘密法

法律定位:

《中华人民共和国保守国家秘密法》是中国保护国家秘密、维护国家安全与利益的基础性法律。它规定了保密义务,适用于所有国家机关、武装力量、政党、社会团体、企事业单位及公民。

主要内容:

该法律明确了国家秘密的定义、分类以及保护措施和法律责任。规定了哪些信息属于国家秘密,以及这些信息在流转和使用过程中应如何处理,以确保安全。

重点条款:

法律强调了保密的重要性,明确规定了违反保密义务的法律后果,尤其是对国家安全构成威胁的行为,将面临严厉处罚。

中华人民共和国保守秘密法

中华人民共和国网络安全法

法律定位:

《中华人民共和国网络安全法》是为了保障网络安全,维护国家安全、社会公共利益以及公民、企业和组织的合法权益而制定的法律。它通过明确网络安全责任,规范网络数据管理,保护个人隐私和数据信息。

主要内容:

该法强调了网络运营者的责任,要求其保护个人数据和隐私,采取必要的技术和其他措施,防止网络数据的泄露、损毁和滥用。此外,法律对涉及国家安全的网络技术和服务提出了网络安全审查要求,以确保其合法使用。

重点条款:

法律明确要求网络运营者对个人信息进行保护,包括加密、匿名化处理,并对违反网络安全义务导致数据泄露或危害国家安全的行为规定了严厉的法律后果。

中华人民共和国网络安全法

中华人民共和国个人信息保护法

法律定位:

《中华人民共和国个人信息保护法》是专门为规范个人信息处理活动、保护个人信息权利而制定的法律,旨在保障个人信息的安全和隐私。

主要内容:

该法律规定了个人信息处理的原则,包括个人信息的收集、存储、使用、处理和传输。它还强调了个人对其信息的控制权,以及在数据处理过程中应尊重的个人隐私。

重点条款:

法律对个人信息的透明处理和合法性进行了明确规定,要求未经授权不得处理个人信息,并对侵犯个人信息的行为设定了法律后果,保障个人有权维护自身的信息权益。

中华人民共和国个人信息保护法

遵守法律法规的重要性

保障国家安全和社会稳定

法律法规的遵守是维护国家安全和社会稳定的关键,特别是在信息技术日新月异的背景下。确保敏感信息不被非法获取和利用,对于国家安全至关重要。遵循国家制定的法律法规,不仅是每个公民和企业的责任,也是对社会稳定的贡献。

在个人信息广泛流通的时代,保护公民的个人数据和隐私问题尤为重要。依法合规处理数据,不仅符合法律要求,也有助于建立公众的信任,同时体现了企业和个人的社会责任感。通过规范数据的采集、处理和存储,可以有效防止信息泄露,保障个人信息的安全。

💯ChatGPT的数据使用特点

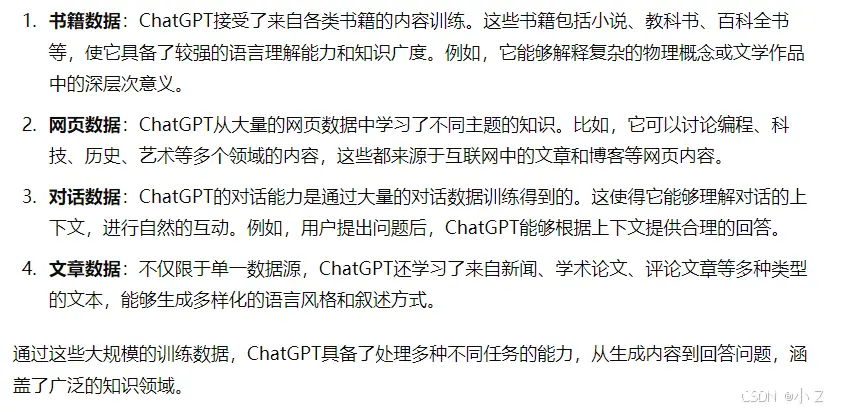

大规模数据训练

ChatGPT是通过大量的数据进行训练而形成的语言模型,其训练数据集涵盖了广泛的互联网内容,包括书籍、网站、文章等。这种海量数据的训练方式使得ChatGPT具备了强大的语言处理能力,能够理解并生成多样化的文本内容。

动态学习能力

ChatGPT不仅在初始训练阶段进行了学习,还能通过用户的持续交互和反馈进行学习和适应。每次用户的查询和反馈都有可能被用来优化和改进模型,使其更好地理解用户需求。

个性化响应

ChatGPT可以根据用户的输入提供定制化的响应。模型会根据用户的查询历史和互动方式,自动调整其回答的风格和内容,从而提供更符合用户需求的回答。这种个性化的能力让它能够更灵活地适应不同的用户群体。

ChatGPT数据安全问题

隐私泄露风险

用户在与ChatGPT交互时,可能会无意中透露个人信息,如姓名、地址或其他敏感数据。尽管OpenAI采取措施保护用户数据,但在数据处理和存储过程中,仍然存在隐私泄露的潜在风险。因此,用户应在使用ChatGPT时保持警惕,避免共享敏感信息。

数据滥用的可能性

用户输入的数据可能会被用于模型的训练和优化。如果这些数据包含敏感或私人信息,可能存在被不当使用的风险。尽管OpenAI声明了其数据使用政策,但用户在共享信息时仍需保持警觉,确保自己的隐私不受侵害。

ChatGPT如何处理用户数据

数据收集和使用

OpenAI会收集用户的查询数据,以改进和训练其模型。这些数据包括用户输入的文本、交互模式和反馈。通过分析这些数据,模型可以不断优化,提升性能和用户体验。

数据保护措施

为了确保数据的安全性,OpenAI实施了多项数据安全和隐私保护措施,如数据加密和访问控制。此外,OpenAI还遵守相关的数据保护法规,例如欧盟的《通用数据保护条例》(GDPR),以确保用户数据的安全性和合规性。

用户使用ChatGPT应注意的数据安全风险

避免泄露敏感信息

用户应避免在与ChatGPT的交互过程中透露个人或敏感信息,包括个人身份信息、地址、银行和金融信息等。这些信息一旦泄露,可能带来潜在的隐私风险。

了解数据使用政策

在使用ChatGPT之前,用户应了解OpenAI的数据使用政策和隐私条款。明确自己提供的数据是如何被收集、使用和保护的,确保对数据的处理有清晰的认识。

合理设置期望

需要认识到ChatGPT仍是基于大量数据训练的AI模型,其回答可能不完全准确或可靠。在使用该平台时,用户应结合其他信息来源和专业建议,合理评估其输出的内容。

💯ChatGPT数据安全自查的重要性

个人和组织的责任:

个人隐私保护

个人用户应确保敏感信息的安全,避免在与AI交互时泄露诸如姓名、地址、金融信息等。

组织在使用生成式AI时,必须严格遵守数据保护法规,确保客户和公司机密数据不被泄露。

法律遵从性:

遵守法规

确保AI技术的使用符合当地数据保护及隐私法律的要求,例如欧洲的GDPR或中国的网络安全法等。

自查自纠的具体指南:

数据加密与保护

加密传输:确保与AI服务交互时,所有数据均通过安全、加密的通道进行。安全存储:如果需要存储从AI服务获得的数据,必须采用加密和安全的存储解决方案。

避免输入敏感信息

敏感信息识别:培训员工识别敏感信息,如个人身份信息、商业机密、财务数据等。限制输入:使用AI服务时,应避免输入任何敏感信息。

使用策略和培训:

制定政策

员工培训

监督与审计:

监督使用

监督员工使用AI服务,确保操作符合内部政策及法律规定。

定期审计

定期对AI使用情况进行审计,包括数据处理和存储的审查。

更新与改进:

持续更新

反馈机制

结论:

对于任何使用生成式AI技术的个人和组织,数据安全自查都是必不可少的一环。通过实施并遵循上述指南,可以显著减少数据泄露和滥用的风险,并确保始终遵守相关法律法规。在信息技术飞速发展的当下,数据安全自查应成为日常工作的重要组成部分。

💯ChatGPT实用建议与最佳实践

明确数据分类

识别敏感数据:

识别和区分敏感数据类型,例如个人身份信息、财务数据或商业秘密等。

限制敏感数据输入:

避免在使用AI工具时输入敏感数据,特别是在公共或共享环境中操作时。

使用安全环境

加密通信:

确保与AI工具的所有数据传输采用加密技术,例如使用HTTPS或其他安全协议。

账户安全管理:

使用强密码,并定期更新密码;启用两步验证(2FA)以增加安全性。

定制AI应用

数据匿名化:

尽量使用匿名化或假数据与AI工具交互,减少数据泄露风险。

定制化应用:

根据具体需求定制AI工具的使用,避免通用解决方案带来的不必要风险。

知识产权保护

版权意识:

在使用AI生成内容时,需尊重原创者的版权与知识产权,确保合法使用。

避免侵权风险:

确保生成的内容不会侵犯他人的知识产权,遵循合法使用原则。

法律合规

遵守当地法律法规:

了解并遵守所在地区关于数据保护的相关法律法规,如GDPR或本地隐私法。

数据处理透明度:

确保数据处理流程的透明度,尤其是在涉及客户数据时,做到合规并可追溯。

定期评估和审计

风险评估:

定期对AI工具的使用实践进行风险评估,及时识别潜在安全隐患。

安全审计:

定期进行安全审计,确保AI工具的使用符合最佳实践,并遵循既定政策。

💯小结

通过本文的探讨,可以清楚地看到,在生成式AI工具迅速普及的今天,数据安全与隐私保护已成为每个用户和组织必须面对的重要课题。无论是个人使用还是企业应用,合理应对数据泄露风险、遵循法律法规、以及定期进行安全审查都是确保信息安全的关键步骤。通过掌握相关的安全实践和最佳使用策略,用户不仅能够在保护隐私的前提下,充分发挥AI工具的价值,还能够为未来的发展打下稳固的基础。这不仅是对个人和组织安全的保障,也是在面对技术飞速发展的挑战中不断进步的必由之路。未来的ChatGPT不仅会更加智能和强大,其对数据的处理能力也会更加精准和多样化。这意味着用户可以通过AI获得更高效、个性化的服务体验,但同时,也要求我们在技术与安全之间找到平衡点。对隐私的保护、对敏感数据的管理,以及对法规的遵守,将在这一过程中扮演至关重要的角色。随着AI技术的普及,数据隐私保护的标准必然会随之提升,只有在确保技术安全性的前提下,AI才能真正实现其广泛应用的潜力。

import torch; from transformers import GPT2Tokenizer, GPT2LMHeadModel, TextDataset, DataCollatorForLanguageModeling, Trainer, TrainingArguments; tokenizer = GPT2Tokenizer.from_pretrained('gpt2'); model = GPT2LMHeadModel.from_pretrained('gpt2'); def load_dataset(file_path, tokenizer, block_size=128): dataset = TextDataset(tokenizer=tokenizer, file_path=file_path, block_size=block_size, overwrite_cache=True); return dataset; def train_model(dataset, model): training_args = TrainingArguments(output_dir="./results", overwrite_output_dir=True, num_train_epochs=3, per_device_train_batch_size=4, save_steps=10_000, save_total_limit=2, logging_dir='./logs'); data_collator = DataCollatorForLanguageModeling(tokenizer=tokenizer, mlm=False); trainer = Trainer(model=model, args=training_args, data_collator=data_collator, train_dataset=dataset); trainer.train(); return model; def generate_text(model, tokenizer, prompt, max_length=100): inputs = tokenizer(prompt, return_tensors="pt"); outputs = model.generate(inputs['input_ids'], max_length=max_length, num_return_sequences=1, no_repeat_ngram_size=2, temperature=0.7, top_k=50, top_p=0.95, do_sample=True); return tokenizer.decode(outputs[0], skip_special_tokens=True); dataset = load_dataset('path_to_your_text_file.txt', tokenizer); model = train_model(dataset, model); prompt = "In the future, AI will"; generated_text = generate_text(model, tokenizer, prompt); print(generated_text)

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。