浅析AI大模型GPU卡

CSDN 2024-06-22 11:01:07 阅读 82

当前国内AI大模型搞得如火如荼,今天给大家介绍一下国内AI大模型主流卡,以及对应的AI基础设施;

什么是GPU?

GPU,全称为图形处理器(Graphics Processing Unit),最初设计目的是加速计算机图形渲染,特别是在视频游戏和专业可视化应用中。然而,随着技术的发展,GPU因其独特的并行处理架构而成为高效数据处理的理想选择,不仅限于图形处理,还在高性能计算、大数据分析、以及人工智能等领域发挥了重要作用。

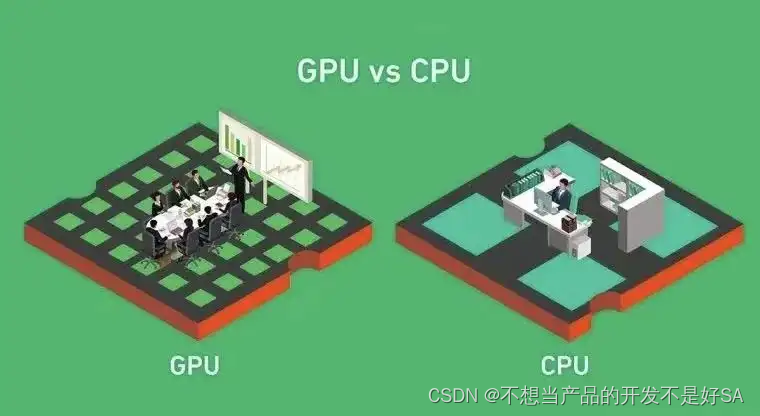

GPU和CPU的区别

设计架构:CPU设计为通用处理器,擅长执行各种复杂的逻辑操作和串行任务,拥有较少的核心数但每个核心的计算能力较强。而GPU专为大规模并行计算设计,拥有成百上千个小核心,适合处理大量相似且可以并行执行的简单任务。

数据处理方式:CPU遵循指令序列执行,每次执行一条指令,适合需要灵活逻辑判断的任务。GPU则采用SIMD(单指令多数据)架构,能在同一时间内对大量数据执行相同的操作,非常适合矩阵运算和向量运算,这些是AI计算中的常见任务。

内存和带宽:GPU通常配备更大带宽的内存(如GDDR显存),能够更快地读取和处理大量数据,这对于AI模型训练中频繁的内存访问至关重要。

为什么AI要用GPU而不是CPU

并行处理能力:AI模型,特别是深度学习模型,涉及到大量的矩阵乘法和向量运算,这些操作高度并行化。GPU的并行架构能同时处理大量此类运算,大大加速了模型训练和推断过程。

浮点运算性能:现代AI模型往往涉及大量浮点运算,GPU在浮点运算方面的能力远超CPU,这对于精度要求高的AI模型尤为重要。

能效比:尽管GPU在处理特定类型任务时消耗的能量也较大,但由于其能大幅缩短计算时间,相对于CPU在完成相同任务时的能效比更高。

生态支持:主流的AI框架和库(如TensorFlow、PyTorch)都针对GPU进行了优化,使得在GPU上运行AI模型变得十分便捷。

GPU卡介绍

NVIDA:

NVIDIA A100 Tensor Core GPU

架构:基于Ampere架构。出厂时间:大约在2020年推出。算力:提供约19.5 TFLOPs的FP32算力,以及更高的Tensor Flops(如TF32)。计算精度:支持FP32、FP64、TF32、BFLOAT16、INT8等多种精度。应用场景:适合大规模AI训练、高性能计算(HPC)、数据分析等,特别适合处理大型数据集和复杂模型。nvlink:支持NVLink 3.0,提供高速GPU间通信。PCie:支持PCIe 4.0 x16。NVIDIA A800 Tensor Core GPU

架构:同样基于Ampere架构。出厂时间:具体时间未直接提及,但属于较新款式,可能在2023年左右。算力与精度:信息未直接给出,但鉴于与A100同架构,推测性能接近,具体数值需查询官方资料。应用场景:与A100类似,适用于AI训练、HPC和大数据处理。nvlink与PCie:预计支持NVLink和PCIe 4.0,具体规格需参照官方发布。NVIDIA H100 Tensor Core GPU

架构:基于Hopper架构。出厂时间:2022年发布。算力:提供惊人的FP32算力,以及更高的Tensor Flops。计算精度:支持FP32、FP64、TF32、BFLOAT16、INT8等,具有更高的精度和混合精度计算能力。应用场景:适用于超大规模AI模型训练、实时推理、超级计算等最前沿的计算密集型应用。nvlink:支持NVLink 4.0,提供更快的GPU间带宽。PCie:支持PCIe 5.0,进一步提升数据传输速度。NVIDA其他卡:

H800、L40s、H200、H20、B20:H800面向原来的中国市场,H200可能面向中高端市场,支持PCIe 4.0,而L40s专注于推理应用,B20是入门级或边缘计算解决方案。它们各自在算力、精度、应用场景上有所差异,且可能支持不同的NVLink版本和PCie标准。

华为:

华为的昇腾系列AI处理器,特别是昇腾910和昇腾310,展示了华为在AI计算领域的强大实力,通过针对性的设计满足了从云端到边缘的不同AI计算需求。不同于传统的GPU卡,昇腾系列更注重AI特定的计算优化,提供更高的能效比和针对AI模型的优化设计。

昇腾910 (Ascend 910)

架构:基于华为自研的达芬奇架构,专为AI计算优化,提供了极致的能效比。出厂时间:2019年正式发布。算力:提供最大256 TFLOPS@FP16的半精度算力,以及64 TFLOPS@FP32的单精度算力,特别适合AI训练和高性能计算。计算精度:支持FP32、FP16、INT8等多种精度,满足不同精度需求的AI模型。应用场景:适用于大规模深度学习模型训练、高性能计算、云服务、边缘计算等场景,尤其适合图像识别、语音识别、自然语言处理等AI应用。内部通信:支持高效的芯片间互联技术,如Hybrid Cube Mesh Fabric,实现多芯片间的高速数据交换。PCie:支持PCIe Gen3/Gen4接口。昇腾310 (Ascend 310)

架构:基于达芬奇架构,但定位为低功耗、高能效的边缘计算场景。发布时间:发布于2018年。算力与计算精度:虽然算力相比昇腾910较低,但仍能提供高效处理能力,支持FP16、INT8等精度,适合推理场景。应用场景:主要应用于物联网边缘设备、智能摄像头、自动驾驶等边缘计算领域。网络适配:由于主要应用于边缘计算,内部通信需求相对较低,同样支持PCIe接口以适应边缘设备的接口需求。其他厂家:

其余主要有AMD、intel、寒武纪、摩尔线程这些。

(有点累了哎,我简单写下,大家如果需要评论区写一下,我可以再开一贴,单独介绍)

AMD

AMD- MI250X: 采用CDNA 2架构,7nm工艺,拥有110个计算单元,最大算力约为47.9TFLOPS(FP16),支持Infinity Fabric互连技术,提供高带宽内存(HBM2e),市场定位为高性能计算和AI领域,兼容ROCm软件栈。

寒武纪

寒武纪-Cambricon MLU290: 面向云端推理和训练,具体参数如工艺节点、算力等公开资料有限,但强调了其在机器学习任务上的优化和高效能比,支持自有的MLU指令集。

燧原科技

燧原科技-云燧T10: 基于邃思DTU架构,针对云端训练和推理设计,具体工艺和参数细节未详尽公布,强调高性能与低功耗平衡,支持自研的SOPA软件栈。

天数智芯

天数智芯-GC200: 7nm工艺,采用自研Mars架构,拥有256个计算单元,峰值算力达256TFLOPS(FP16),具备高带宽内存系统,专注于数据中心的AI训练和高性能计算。

沐曦

沐曦-MX1: 具体参数尚未详细公开,主打高性能GPU芯片,面向AI推理和渲染等应用场景,强调国产自主可控。

摩尔线程

摩尔线程-MTT S2000: 5nm工艺,专为中国市场设计,虽然主要针对图形渲染,但也适用于AI推理,拥有强大算力和高速接口,兼容自研的MUSA软件栈。

壁仞科技

壁仞科技-BR100: 7nm工艺,宣称具有高算力(FP32超1000TFLOPS,INT8超4000TOPS),配备高带宽内存,支持多种AI模型和高性能计算应用,市场推广初期,致力于构建完整的生态体系。

总结:

GPU的发展和硬件能力的进步为AI大模型的训练和应用开辟了新的可能性,极大地推动了人工智能技术的创新和普及。

下一篇: 【腾讯云 HAI域探秘】——即时职场生存指南小游戏以及【自行搭建Stable Diffusion图片AI绘制 | ChatGLM2-6B AI进行智能对话 | Pytorch2.0 AI框架视频处理】

本文标签

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。